爬虫的概念

爬虫是一种自动地获取网页数据并存储到本地的程序。它的主要作用是获取网站上的数据,这些数据可以用于分析、研究、开发等多种目的。爬虫可以帮助我们获取网站上的数据,而不需要人工浏览和抓取。爬虫的分类主要有通用爬虫和聚焦爬虫。通用爬虫是指搜索引擎和大型web服务提供商的爬虫,它们抓取的是一整张页面数据。聚焦爬虫是针对特定网站的爬虫,它们定向的获取某方面数据的爬虫。

爬虫应用场景

爬虫的应用场景非常广泛,主要包括以下几个方面:

-

数据分析和研究:爬虫可以获取网站上的数据,然后进行分析和研究,从而获取有价值的信息。

-

新闻聚合:爬虫可以抓取多个网站上的新闻内容,并将其整合到一个地方,方便用户查看。

-

电子商务:爬虫可以抓取网站上的商品信息,并将其整理成报表,方便商家分析和决策。

-

数据挖掘:爬虫可以抓取网站上的数据,并将其转换成机器可以理解的格式,从而进行数据挖掘和分析。

爬虫的工作原理和流程

-

确定爬虫的目标网站和需要抓取的数据。

-

编写爬虫的代码,包括爬虫的起始地址、结束地址、请求头、爬取的数据类型等。

-

运行爬虫程序,将爬虫代码发送到目标网站。

-

目标网站返回响应数据,爬虫程序将其存储到本地。

-

爬虫程序对存储的数据进行处理和分析,得到需要的数据。

-

爬虫程序重复以上步骤,直到爬虫的目标数据被抓取完毕。

举例来说,我们可以使用Python编写一个爬虫程序,用于抓取一个电子商务网站上的商品信息。我们可以使用requests库发送HTTP请求,使用BeautifulSoup库解析HTML响应,然后将抓取的数据存储到本地。这个爬虫程序可以定期运行,从而获取该网站上的商品信息。这些商品信息可以用于分析和研究,从而帮助商家做出更好的决策。

Python爬虫入门

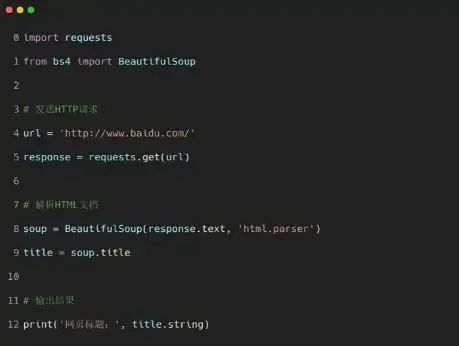

Python是一门非常适合爬虫的编程语言。它具有简单易学、代码可读性高等优点,而且Python爬虫库非常丰富,使用Pvthon进行爬虫开发非常方便。我们先来看一个简单的Pvthon爬虫程序,爬取一个网页的标题:

在这个程序中,我们使用了requests库来发送HTTP请求,并使用BeautifulSoup库来解桥HTML文档。通过这两个库,我们可以轻松地获取网页数据进而进行数据分析和处理。

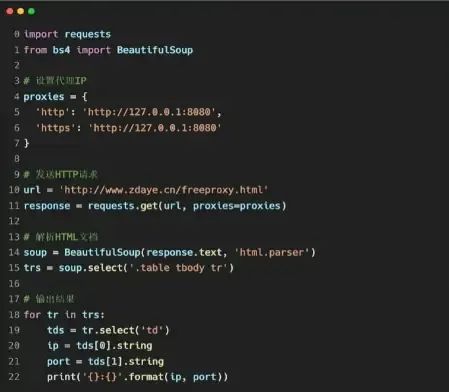

使用代理IP

有些网站可能会封禁某个IP地址,这时我们需要使用代理IP来隐藏真实IP地址。使用代理IP的方法很简单,只需向requests库的get()或post()方法传递proxies参数即可。下面是一个使用代理IP的Python爬虫程序,爬取一个网站的代理IP:

在这个程序中,我们设置了一个代理IP,然后使用requests库发送HTTP请求,传递了proxies参数。接着我们解析HTML文档,使用BeautifulSoup库找到了代理IP,并输出了结果。

反爬虫技术

有些网站为了防止被爬虫抓取,会采取一些反爬虫技术,如设置限流、验证码等。为了绕过这些反爬虫技术,我们需要使用一些技巧。

①间隔时间

我们可以通过设置间隔时间来减小对目标网站的压力,缓解反爬虫措施带来的影响。代码实现如下:

在这段代码中,我们使用了time库来让程序等待5秒钟,然后再继续发送HTTP请求。

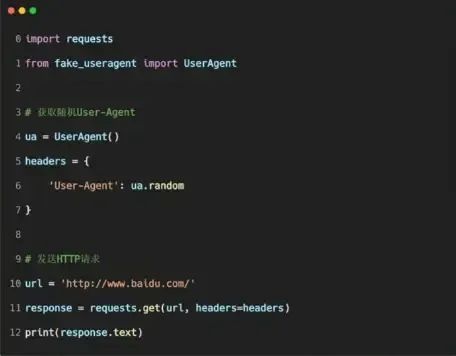

②随机UA

有些网站会根据User-Agent来判断是否是爬虫程序,我们可以通过随机User-Agent的方法,来让我们的爬虫程序更难被发现。代码实现如下:

在这段代码中,我们使用了fake_useragent库来生成随机的User-Agent,然后将其设置到HTTP请求的headers中。

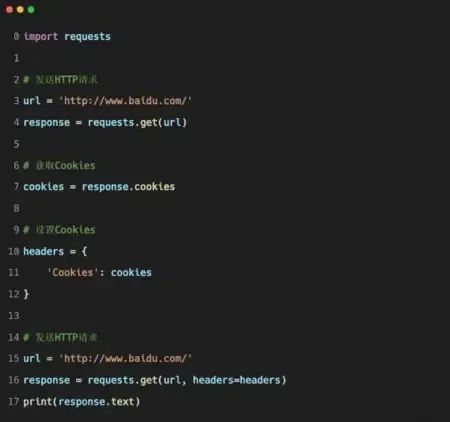

③使用Cookies

有些网站会根据用户的Cookies来判断是否是爬虫程序,我们可以通过获取网站的Cookies,然后将其设置到我们的爬虫程序中,来伪装成正常用户。代码实现如下:

在这段代码中,我们先发送HTTP请求获取了网站的Cookies,然后将其设置到HTTP请求的headers中。

总结

本文简单介绍了爬虫的基础知识以及需要用的库和方法,并做了非常简单的示例。总的来说,爬虫就是模拟网络请求,并解析、提取出我们想要的数据。爬虫可以帮助我们更快地获取网站上的数据,为工作和生活带来诸多便利。当然,也希望在学习 python 爬虫的过程中,大家能够更好地理解和应用 python的语法。

遵守法律法规

爬虫在获取网页数据时,需要遵守以下几点,以确保不违反法律法规:

-

不得侵犯网站的知识产权:爬虫不得未经授权,获取和复制网站的内容,这包括文本、图片、音频、视频等。

-

不得违反网站的使用条款:爬虫在获取网页数据时,需要仔细阅读网站的使用条款和隐私政策,确保不违反其中的规定。

-

不得干扰网站的正常运行:爬虫不得对网站的服务器、网络带宽等资源造成过大的负荷,以免影响网站的正常运行。

-

不得抓取敏感信息:爬虫不得抓取涉及政治、宗教、色情等敏感话题的内容,以免触犯相关法律法规。

-

建立反爬虫机制:网站可以采取反爬虫措施,如设置防爬虫规则、验证码等,爬虫需要根据这些规则进行调整,以确保不被网站封禁。

总之,爬虫需要遵守相关法律法规和网站的使用条款,合理抓取数据,避免侵犯网站的知识产权和干扰网站的正常运行,以确保爬虫的合法性和可持续性。

4453

4453

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?