矢量语义学

这份课件介绍了向量语义学和词嵌入,探讨了单词含义的计算模型。以下是主要内容的概要:

### 单词含义

1. **基本问题**:探讨了传统N-gram或文本分类方法中单词仅作为字符串(或词汇列表中的索引)的不足。

2. **词义理论**:

- **多义词和词义**:一个单词(Lemma)可以有多个含义(Sense)。

- **语义关系**:包括同义词(Synonymy)、相似词(Similarity)、相关词(Word Relatedness)、反义词(Antonymy)等。

3. **情感内涵**:

- 单词具有情感意义,如正面或负面情感。

- 情感可以沿着价值(Valence)、唤醒(Arousal)和支配(Dominance)三个维度变化。

### 向量语义学和词嵌入

1. **语言分布定义含义**:通过单词在语言使用中的分布来定义其含义,即通过它们的语境(周围的词)。

2. **意义作为空间中的点**:

- 每个单词被表示为一个向量。

- 相似的单词在语义空间中彼此靠近。

- 这些空间是通过检查文本中相邻单词自动构建的。

3. **词嵌入(Embedding)**:

- 词嵌入是NLP中表示词义的标准方式。

- 它允许对类似但未见过的单词进行泛化。

4. **词嵌入类型**:

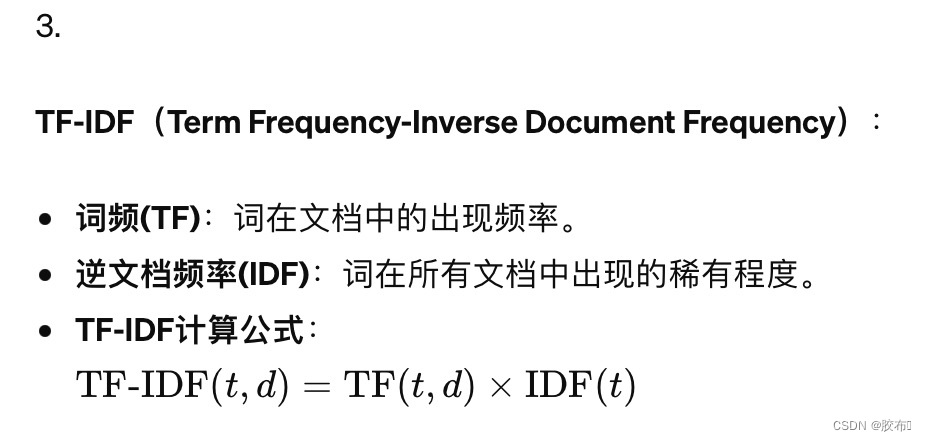

- **tf-idf**:基于附近单词计数的稀疏向量。

- **Word2Vec**:通过训练分类器来预测一个词是否可能出现在附近创建的密集向量。

### 文档向量和词向量

1. **词-文档矩阵**:每个文档由一个单词向量表示。

2. **信息检索**:向量的基础,类似文档的向量相似。

### 向量语义学计算

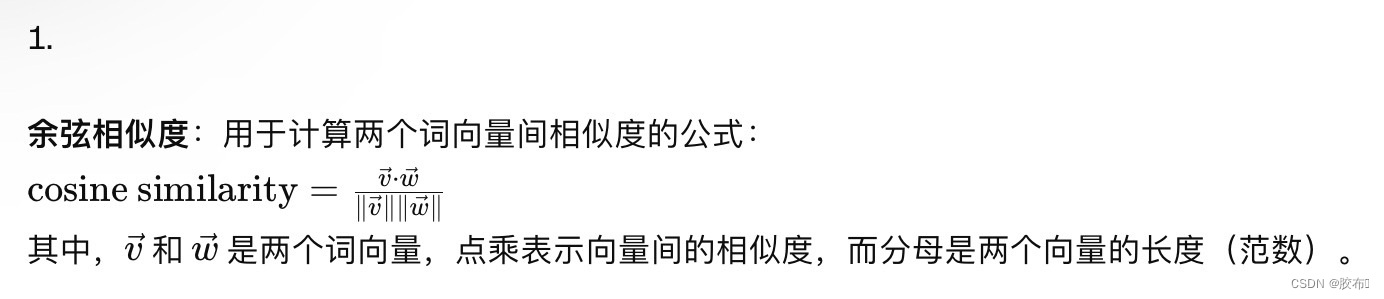

1. **计算词相似度**:使用点积和余弦相似度。

2. **词相似度问题**:原始点积偏向长向量,因此使用余弦进行归一化。

### Word2Vec和词嵌入属性

1. **稀疏与密集向量**:与基于tf-idf的稀疏向量相比,Word2Vec生成短且密集的向量。

2. **Word2Vec训练**:

- 训练分类器,以预测词是否可能出现在附近。

- 使用正面和负面示例来调整词向量。

3. **嵌入的属性**:

- 邻居类型依赖于窗口大小。

- 通过历史文本的嵌入可以观察到意义的变化。

- 嵌入反映文化偏见。

### 结论

这份课件全面地介绍了向量语义学,特别是如何使用Word2Vec和其他词嵌入技术来表示和理解单词的含义。通过这些方法,我们可以捕捉到单词在不同上下文中的复杂含义,并在计算机处理自然语言的过程中应用这些知识。

当然,下面是课件中的一些重要公式和概念:

2. **词-文档矩阵**:每个文档表示为一个词向量,用于信息检索。

4. **Word2Vec**:

- **Skip-Gram模型**:通过预测目标词周围的上下文词来训练词向量。

- **Skip-Gram梯度下降**:使用随机梯度下降来优化词向量。

5. **语义空间中的向量**:词义被定义为在基于分布的空间中的一个点,即每个词被表示为一个向量,相似的词在语义空间中彼此靠近。

6. **嵌入的属性**:

- 不同的窗口大小会影响词向量的邻居类型。

- 通过历史文本的嵌入可以观察到语义的变化。

- 嵌入反映文化偏见。

以上就是课件中提到的关于向量语义学和词嵌入的重要公式和概念,它们帮助理解如何在自然语言处理中量化和使用词义。

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?