cd /opt/apache-hive-2.1.0-bin/conf

touch hive-site.xml

vim hive-site.xml

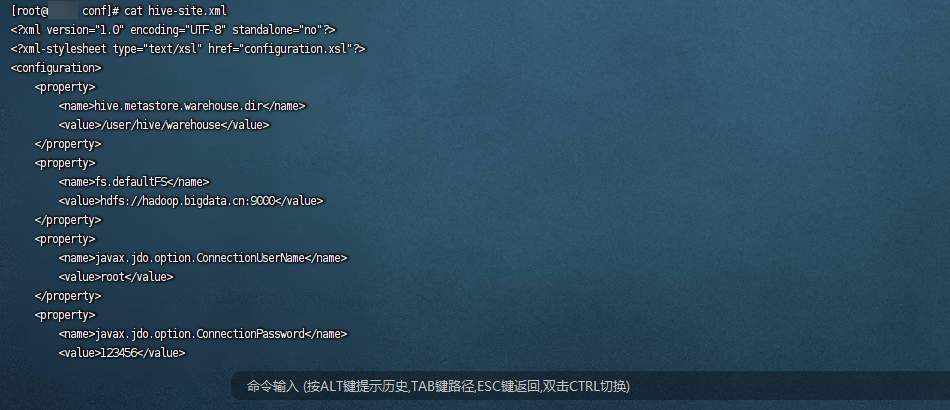

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop.bigdata.cn:9000</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://mysql.bigdata.cn:3306/hive?createDatabaseIfNotExist=true&useSSL=false&characterEncoding=UTF-8</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

<property>

<name>datanucleus.schema.autoCreateAll</name>

<value>true</value>

</property>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>hive.bigdata.cn</value>

</property>

<property>

<name>hive.metastore.uris</name>

<value>thrift://hive.bigdata.cn:9083</value>

</property>

</configuration>

上传配置mysql驱动

-

上传mysql jdbc驱动到宿主机/mnt/docker_share

- mysql-connector-java-5.1.38-bin.jar

-

复制mysql的驱动程序到hive/lib下面

cp /mnt/docker_share/mysql-connector-java-5.1.38-bin.jar /opt/apache-hive-2.1.0-bin/lib

ll /opt/apache-hive-2.1.0-bin/lib | grep mysql

启动mysql和hadoop容器

- 启动mysql容器

docker start mysql

- 启动hadoop容器

docker start hadoop

创建hive容器

- 创建hive容器,指定IP(注意一定要添加 --privileged=true否则无法使用系统服务)

docker run \

--privileged=true \

--net docker-bd0 \

--ip 172.33.0.131 \

-v /mnt/docker_share:/mnt/docker_share \

-v /etc/hosts:/etc/hosts \

-v /opt/hadoop-2.7.0:/opt/hadoop-2.7.0 \

-v /opt/jdk1.8.0_141:/opt/jdk1.8.0_141 \

-v /opt/apache-hive-2.1.0-bin:/opt/apache-hive-2.1.0-bin \

-p 10000:10000 \

--name hive -d hadoop:2.7.0

进入hive容器

docker exec -it hive bash

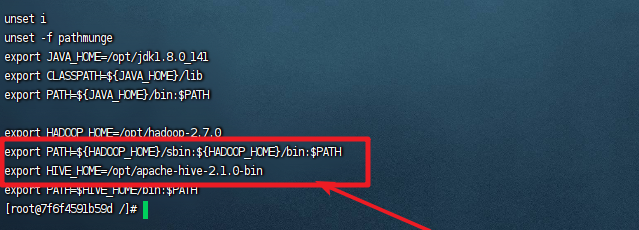

配置hive环境变量

vim /etc/profile

export HIVE\_HOME=/opt/apache-hive-2.1.0-bin

export PATH=$HIVE\_HOME/bin:$PATH

source /etc/profile

初始化mysql元数据

- 初始化mysql元数据命令

schematool -initSchema -dbType mysql

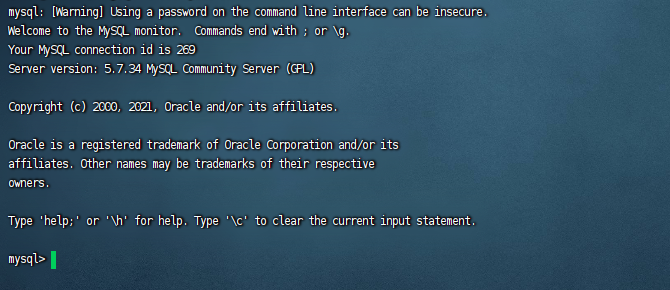

- 进入到mysql容器中,设置hive相关表的编码格式

docker exec -it mysql bash

- 进入到mysql中,执行以下几条语句,修改Hive的默认编码方式

mysql -u root -p

use hive;

-- 修改表字段注解和表注解

alter table COLUMNS_V2 modify column COMMENT varchar(256) character set utf8;

alter table TABLE_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

-- 修改分区字段注解:

alter table PARTITION_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

alter table PARTITION_KEYS modify column PKEY_COMMENT varchar(4000) character set utf8;

-- 修改索引注解:

alter table INDEX_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

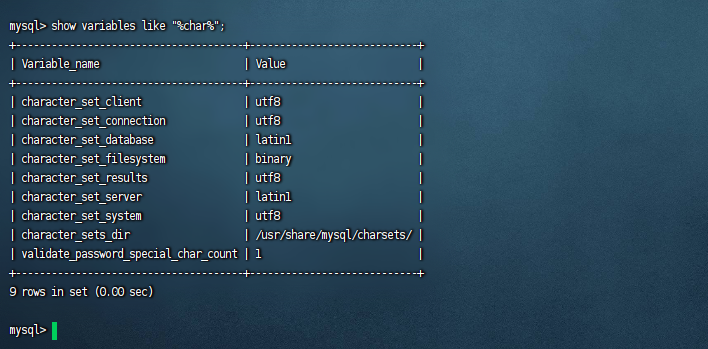

-- 查看编码格式

show variables like "%char%";

三、启动Hive

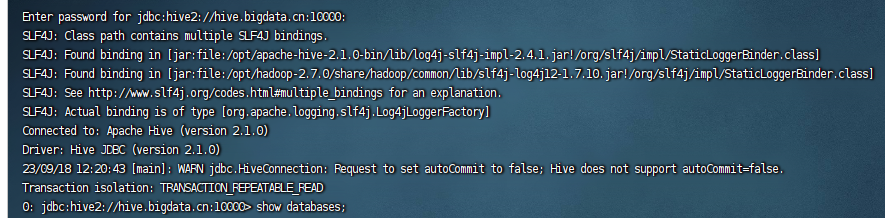

启动hive和使用beeline连接hive

- 启动hive

nohup hive --service metastore &

nohup hive --service hiveserver2 &

- 使用beeline连接hive

beeline

!connect jdbc:hive2://hive.bigdata.cn:10000

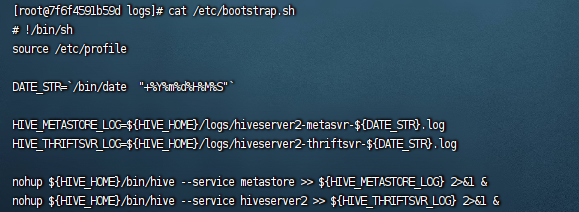

配置hive自动启动

创建日志保存目录

mkdir -p /opt/apache-hive-2.1.0-bin/logs

创建启动脚本

vim /etc/bootstrap.sh

# !/bin/sh

source /etc/profile

DATE\_STR=`/bin/date "+%Y%m%d%H%M%S"`

HIVE\_METASTORE\_LOG=${HIVE\_HOME}/logs/hiveserver2-metasvr-${DATE\_STR}.log

HIVE\_THRIFTSVR\_LOG=${HIVE\_HOME}/logs/hiveserver2-thriftsvr-${DATE\_STR}.log

nohup ${HIVE\_HOME}/bin/hive --service metastore >> ${HIVE\_METASTORE\_LOG} 2>&1 &

nohup ${HIVE\_HOME}/bin/hive --service hiveserver2 >> ${HIVE\_THRIFTSVR\_LOG} 2>&1 &

设置脚本执行权限

chmod a+x /etc/bootstrap.sh

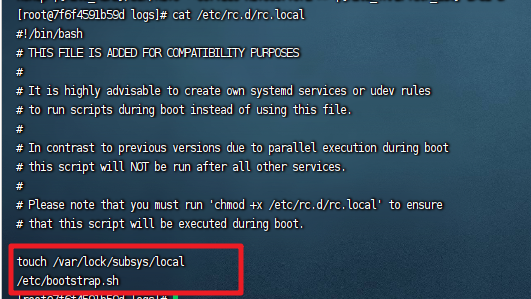

加入自动启动服务

vim /etc/rc.d/rc.local

/etc/bootstrap.sh

chmod 755 /etc/rc.d/rc.local

重启容器

docker restart hive

docker exec -it hive bash

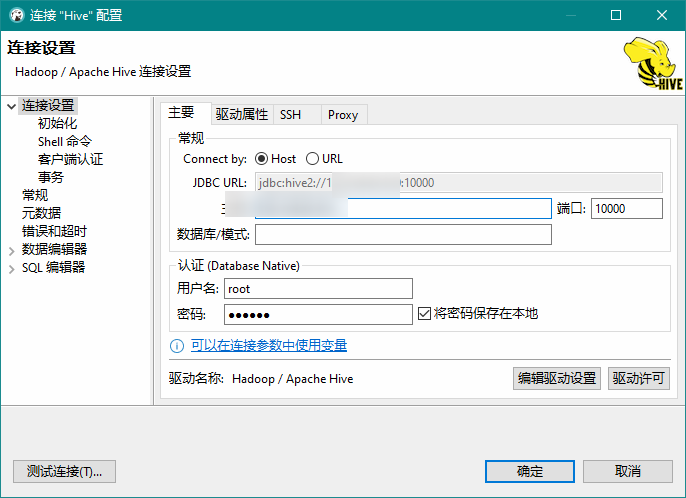

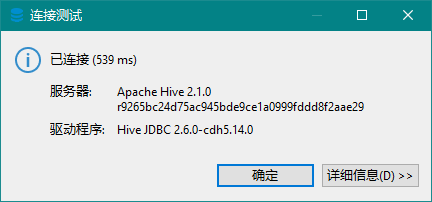

dbserver连接hive

连接成功:

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

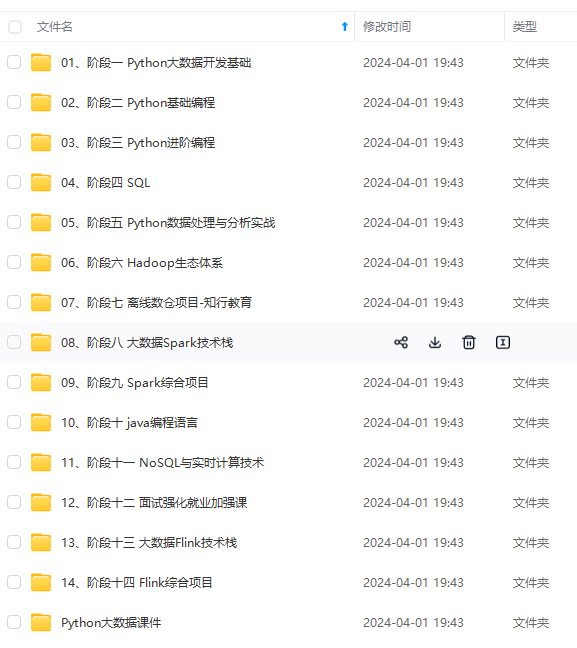

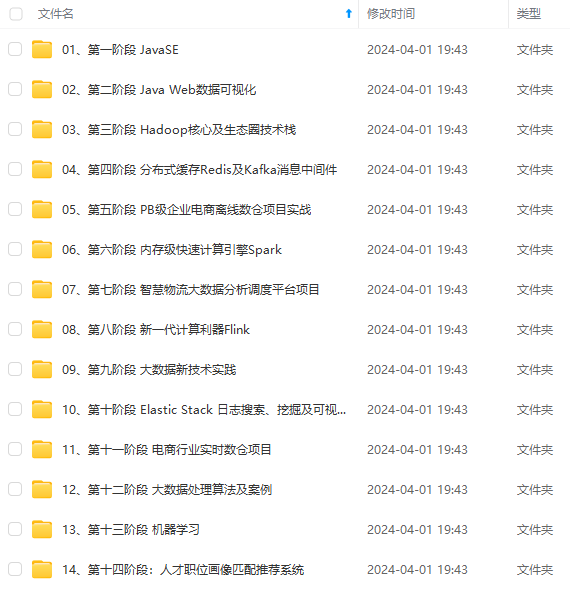

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

-BiO6F0DE-1714755584000)]

[外链图片转存中…(img-KS1CKvUw-1714755584001)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

947

947

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?