一、引言

1.介绍网络爬虫的概念和作用

网络爬虫,又称网络蜘蛛、网络机器人等,是一种用于自动浏览万维网的程序。它通过模拟用户行为,按照指定的规则浏览网络上的信息,并将所需数据保存下来。网络爬虫的作用主要是从网上获取信息,如网页结构、网页内容、链接关系等,然后通过分析和处理这些信息,为搜索引擎提供索引和排序依据。同时,网络爬虫还可以用于数据挖掘、情报分析、网络监测等领域。总之,网络爬虫是互联网信息获取和处理的重要工具之一。

2.强调静态网页数据的重要性

静态网页数据在网络爬虫中的重要性不容忽视。以下是强调其重要性的几个方面:

- 基础数据源:静态网页数据是互联网上最基础、最直接的数据源之一。它包含了大量的文本、图片、链接等信息,是构建搜索引擎索引、进行数据挖掘和分析的基础。

- 结构化信息:静态网页数据通常以HTML、CSS等标记语言呈现,这些标记语言为数据提供了一定的结构。通过解析这些标记语言,网络爬虫可以提取出结构化的信息,如标题、正文、链接等,便于后续的数据处理和分析。

- 易于获取和处理:相比于动态加载的数据,静态网页数据更容易被网络爬虫获取和处理。网络爬虫可以直接发送HTTP请求获取静态网页的HTML代码,然后使用解析器进行解析和提取数据。这种处理方式相对简单且高效。

- 稳定性和可预测性:静态网页数据通常是相对稳定的,其内容和结构在短时间内不太可能发生较大的变化。这意味着网络爬虫在抓取静态网页数据时,可以更加准确地预测和解析网页的结构和内容,提高数据抓取的准确性和效率。

- 历史数据和备份:静态网页数据可以作为历史数据和备份使用。通过保存静态网页数据的快照或备份,我们可以随时回溯和查看过去的数据状态,这对于研究和分析网站的历史变化非常有帮助。

综上所述,静态网页数据在网络爬虫中具有重要的地位和作用。它是互联网信息获取和处理的基础数据源之一,具有结构化、易于获取和处理、稳定性和可预测性等优点。因此,在设计和实现网络爬虫时,充分利用静态网页数据的特性是非常重要的。

二、网络爬虫的工作原理

1.发送请求:爬虫程序向目标网站发送HTTP请求,获取网页的HTML代码

在抓取静态网页数据的过程中,发送请求是第一步。爬虫程序需要向目标网站发送HTTP请求,以获取网页的HTML代码。HTTP请求是客户端与服务器之间进行通信的一种协议,用于获取或提交数据。

在发送HTTP请求时,爬虫程序通常使用HTTP库或框架来发送请求。这些库或框架提供了发送HTTP请求的方法和工具,使得爬虫程序可以轻松地与目标网站进行通信。

在发送HTTP请求时,需要指定目标网站的URL,并设置请求头和其他参数。请求头是HTTP请求的一部分,用于指定请求的类型、内容类型等。其他参数可能包括请求体、超时时间等。

一旦发送了HTTP请求,服务器会响应并返回网页的HTML代码。爬虫程序接收到响应后,可以解析响应内容,提取所需的数据。

需要注意的是,发送HTTP请求时需要遵守目标网站的robots.txt协议和其他使用条款,以避免对目标网站造成过大的访问压力或违反规定。同时,还需要注意处理网络延迟和错误情况,确保爬虫程序的稳定性和可靠性。

2.解析网页:使用解析器(如BeautifulSoup、lxml等)对HTML代码进行解析,提取所需的数据

在获取到网页的HTML代码后,下一步是解析网页。解析网页的目的是从HTML代码中提取出所需的数据。为了实现这一目标,通常会使用解析器对HTML代码进行解析。

常用的解析器包括BeautifulSoup和lxml等。这些解析器提供了方便的API,使得爬虫程序可以轻松地解析HTML代码,并提取所需的数据。

以BeautifulSoup为例,它是一个Python库,专门用于解析HTML和XML文档。BeautifulSoup提供了多种方法来解析HTML代码,如查找标签、获取属性、提取文本等。通过使用BeautifulSoup,爬虫程序可以方便地提取出所需的数据。

下面是一个使用BeautifulSoup解析HTML代码并提取数据的示例:

在这个示例中,我们首先创建了一个BeautifulSoup对象,并将HTML代码作为参数传递给它。然后,我们使用find方法查找标签<h1>,并提取其文本内容。最后,我们打印提取结果。

除了BeautifulSoup,还有其他的解析器可供选择,如lxml、lxml-html等。这些解析器都提供了类似的功能,可以根据具体需求选择适合的解析器。

三、抓取静态网页数据的技巧

1.使用合适的爬虫框架:如Scrapy、BeautifulSoup等,提高爬虫效率和准确性

在抓取静态网页数据时,选择合适的爬虫框架对于提高效率和准确性至关重要。常见的爬虫框架包括Scrapy、BeautifulSoup等。

下面是一个使用Scrapy和BeautifulSoup的示例:

在这个示例中,我们创建了一个名为MySpider的爬虫类,并指定了起始URL。在parse方法中,我们使用BeautifulSoup解析响应内容,提取出标题并打印出来。

2.设定合理的爬取策略:遵循robots.txt协议,避免对目标网站造成过大的访问压力

在抓取静态网页数据时,设定合理的爬取策略是非常重要的。这不仅可以确保爬虫程序的正常运行,还可以避免对目标网站造成过大的访问压力。

3.处理JavaScript和动态加载内容:使用浏览器模拟器(如Selenium)或使用其他技术(如Ajax)获取动态加载的内容

在抓取静态网页数据时,处理JavaScript和动态加载内容是一个常见的挑战。由于JavaScript的执行和动态加载内容的机制,传统的网络爬虫技术往往无法获取到这些内容的完整数据。

为了解决这个问题,可以使用浏览器模拟器如Selenium来模拟用户浏览器的行为,从而获取动态加载的内容。Selenium是一个流行的自动化测试工具,它提供了与各种浏览器的兼容性,并能够模拟用户操作如点击、滚动等。通过使用Selenium,爬虫程序可以执行JavaScript代码并等待动态加载内容加载完成,从而获取所需的数据。

除了Selenium,还可以使用其他技术如Ajax来获取动态加载的内容。Ajax是一种通过异步请求获取数据的技术,它可以在不刷新页面的情况下更新部分网页内容。通过分析目标网站的Ajax请求,可以找到动态加载数据的URL和参数,并使用爬虫程序模拟这些请求来获取数据。

四、实际应用案例

案例:

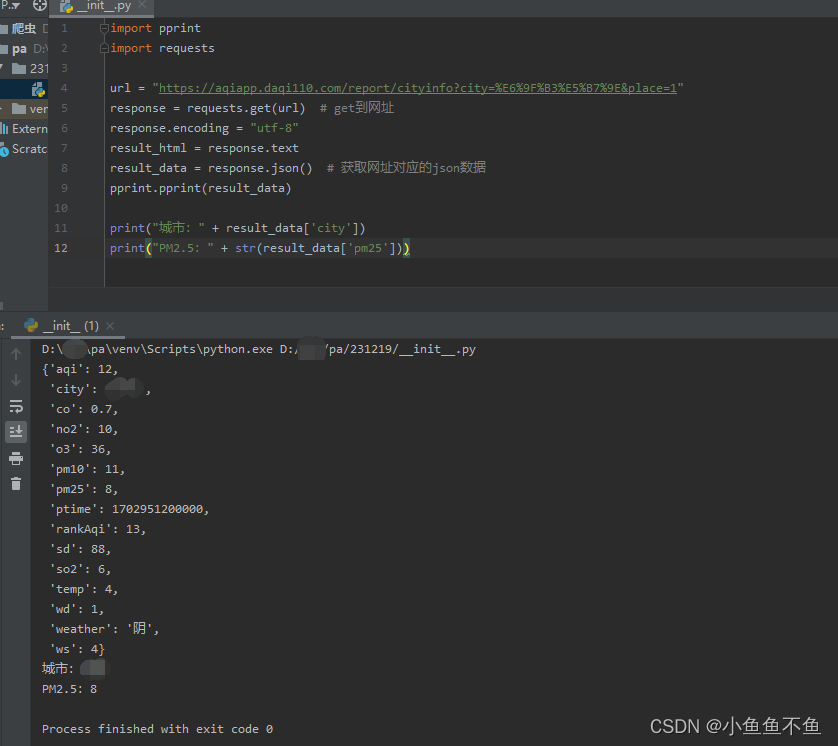

简便的requests库--以中国气象局天气预报为例

以下是一个简单的网络爬虫示例,用于抓取静态网页数据:

以下是爬取的静态网页界面:

在这个示例中,我们使用requests库发送HTTP请求获取网页的HTML代码,并使用BeautifulSoup库解析HTML代码。然后,我们查找标题标签、段落文本和链接,并打印提取到的数据。你可以根据实际需求修改代码,以适应不同的网页结构和数据提取需求。

五、总结

网络爬虫在抓取静态网页数据中具有重要的作用。通过选择合适的爬虫框架、设定合理的爬取策略、处理JavaScript和动态加载内容以及进行数据清洗和处理,可以有效地提高爬虫程序的效率和准确性,获取高质量的网页数据,为后续的数据分析和应用提供准确可靠的数据基础。

今日的文章就分享完了。

本文介绍了网络爬虫的概念、静态网页数据的重要性、工作原理,包括发送请求、解析HTML、爬虫框架选择、合理策略及处理动态内容。通过实际案例展示了如何使用requests和BeautifulSoup抓取数据,以及如何在实际项目中应用网络爬虫技术。

本文介绍了网络爬虫的概念、静态网页数据的重要性、工作原理,包括发送请求、解析HTML、爬虫框架选择、合理策略及处理动态内容。通过实际案例展示了如何使用requests和BeautifulSoup抓取数据,以及如何在实际项目中应用网络爬虫技术。

627

627

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?