“ AI技术火热的当下,不管是作为技术人还是管理者,亦或是各行各业的从业人员,都应快速学会利用AI,而不应被AI时代抛弃”

本文将详细描述Windows系统如何利用开源大语言模型做本地部署,只需要一台个人电脑,但对于硬件有一定要求,各位量力而行,根据自己机器及行业需要选择不同大小的模型进行部署,若部署过程有任何问题可评论区留言

01 部署前环境准备

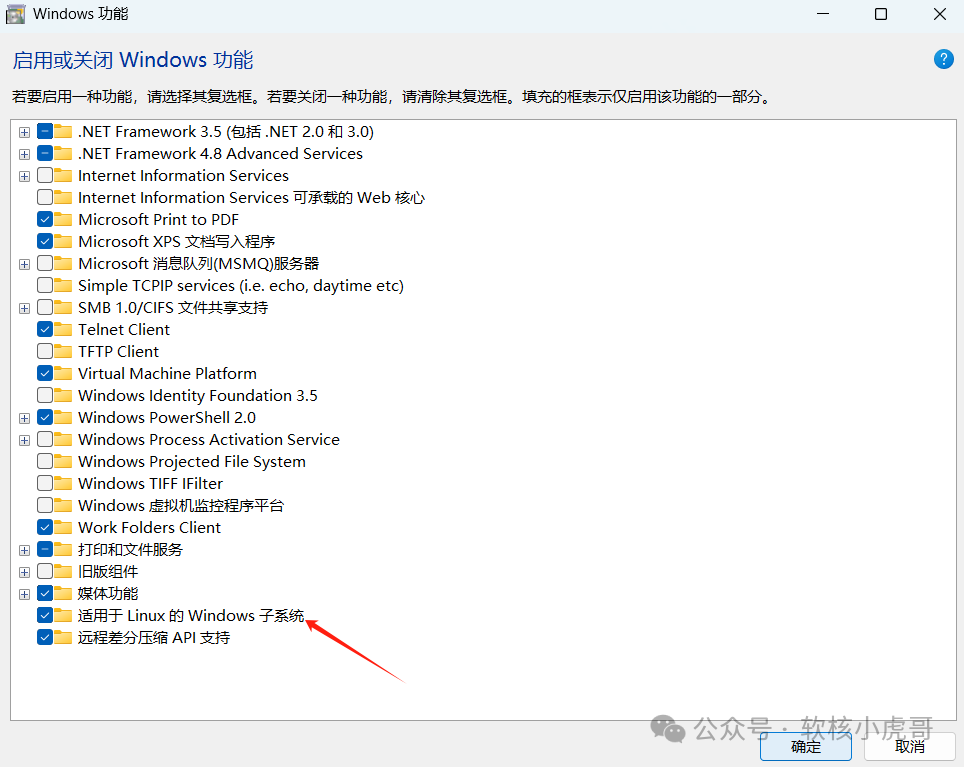

1.开启Windows虚拟化

打开控制面板->程序和功能->启用或关闭Windows功能

勾选“Hyper-V”选项及“适用于Linux的Windows子系统”

点击确定后需重启电脑

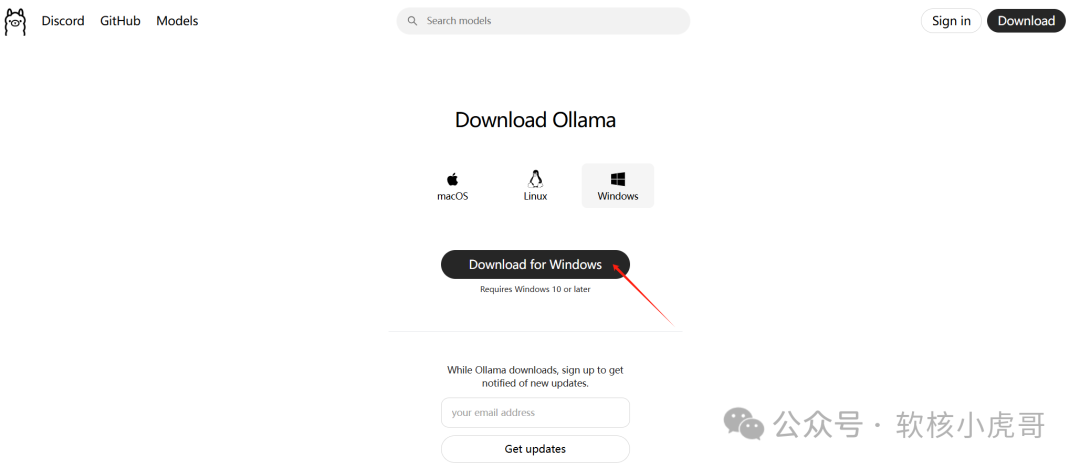

02安装Ollama

1.访问ollama官网下载客户端并安装

官网:https://ollama.com/

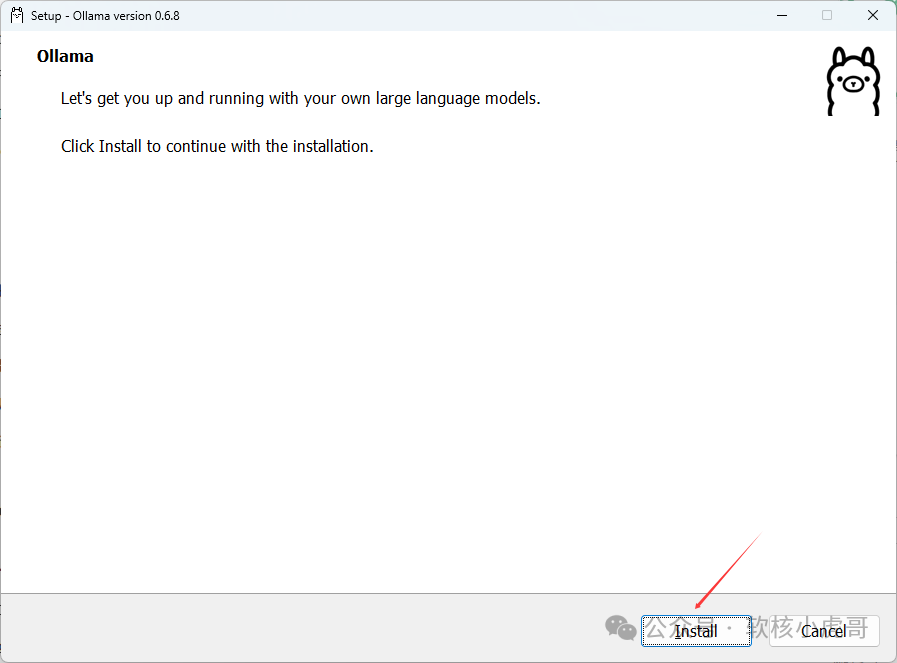

安装完成后不会有任何提示,可继续往下

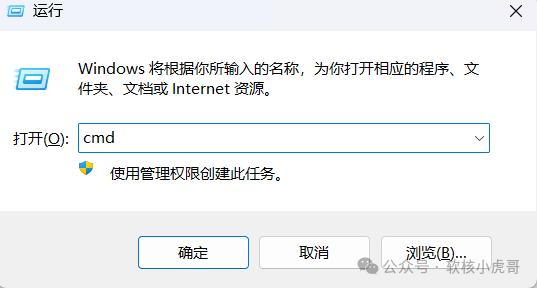

2.安装大语言模型

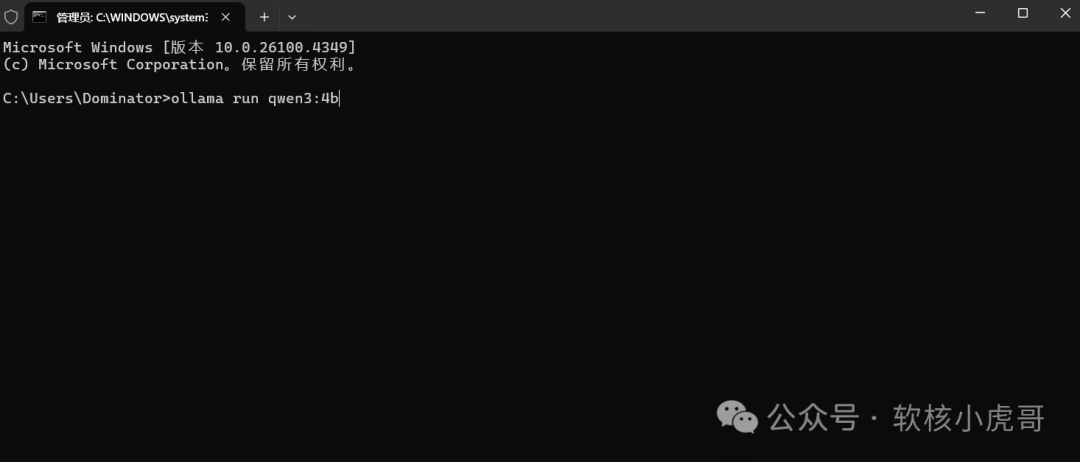

1.快捷键win+R运行cmd窗口

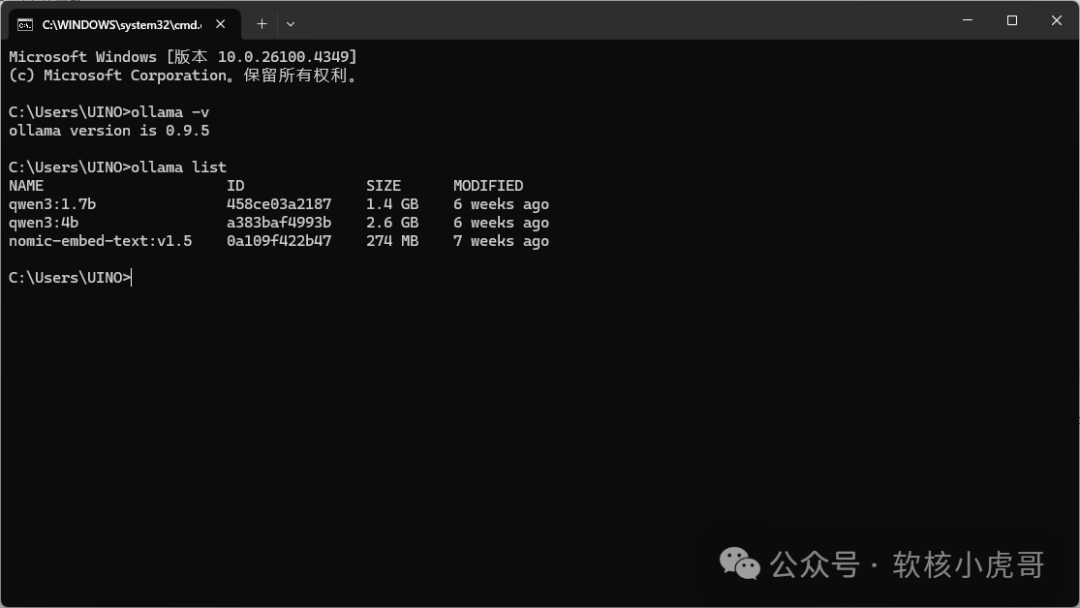

2.运行ollama -v命令可查看是否安装成功及安装版本

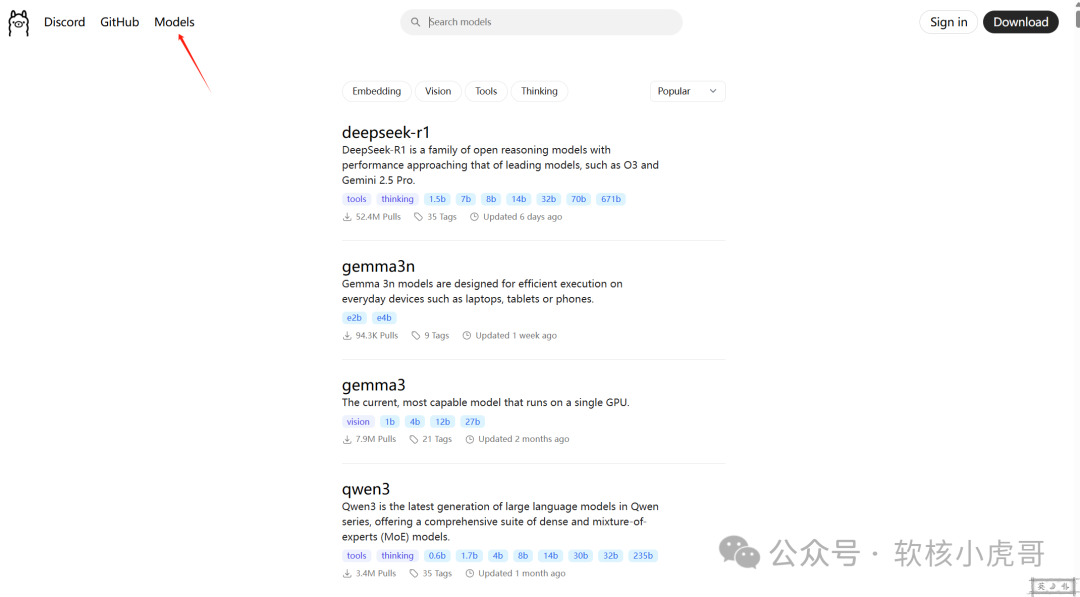

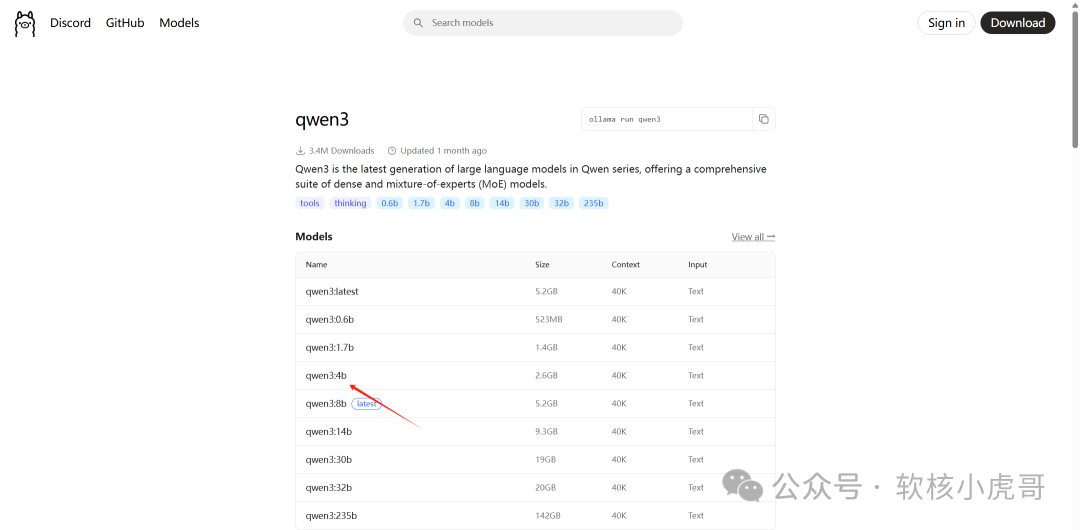

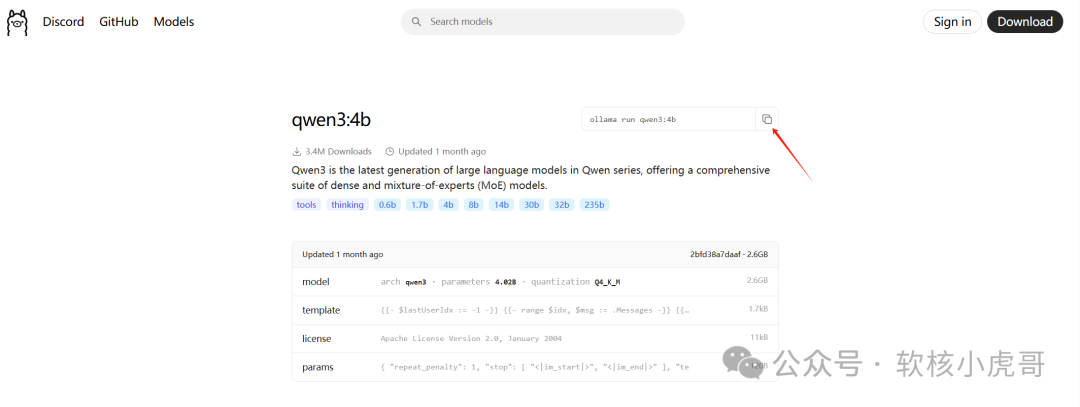

3.进入ollama官网选择需要的模型,本次以Qwen模型为例,复制模型拉取命令,并在cmd窗口执行

恭喜!到这一步安装完成,已经可以在cmd窗口与大模型对话了

可以使用ollama list查看本地已部署模型

03安装OpenWebUI可视化窗口

到这一步还没完,我们需要安装一个可视化页面方便与大模型交互,此处选择OpenWebUI插件

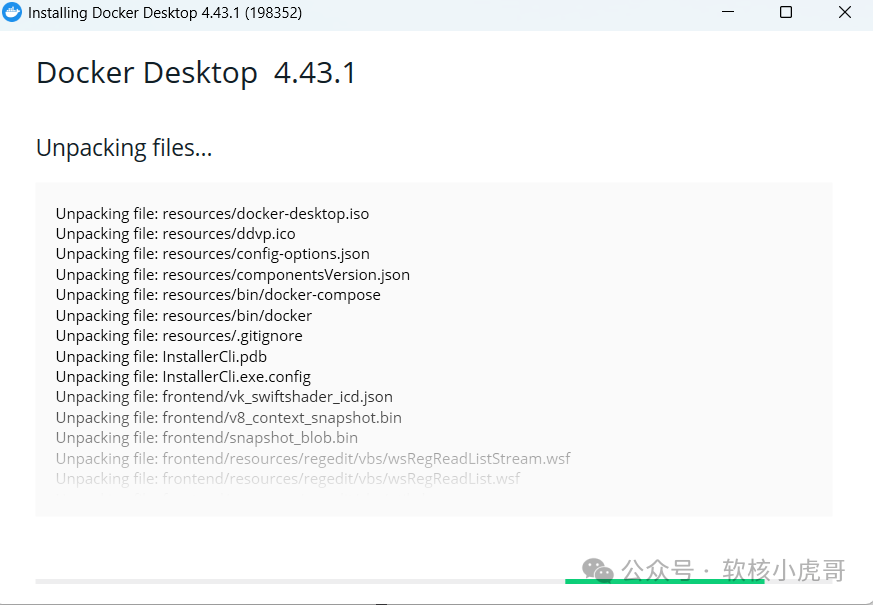

1.下载并安装Docker Desktop

访问Docker网站并下载:https://docker.github.net.cn/desktop/install/windows-install/

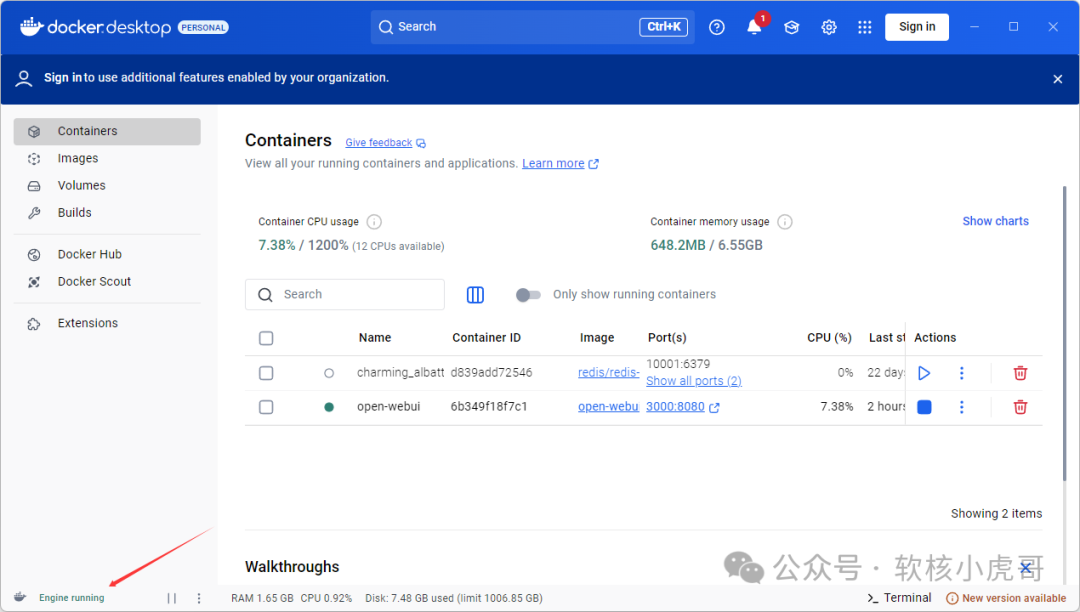

2.进入DockerDesktop应用并安装组件

左下角显示Engine running即为运行成功

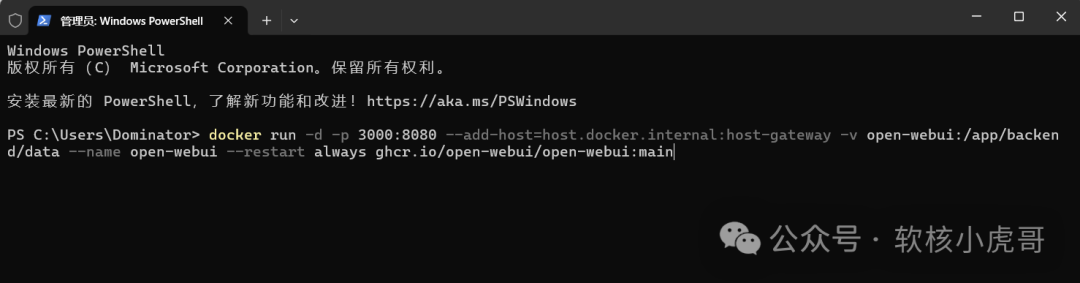

进入PowerShell运行命令安装OpenWebUI

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

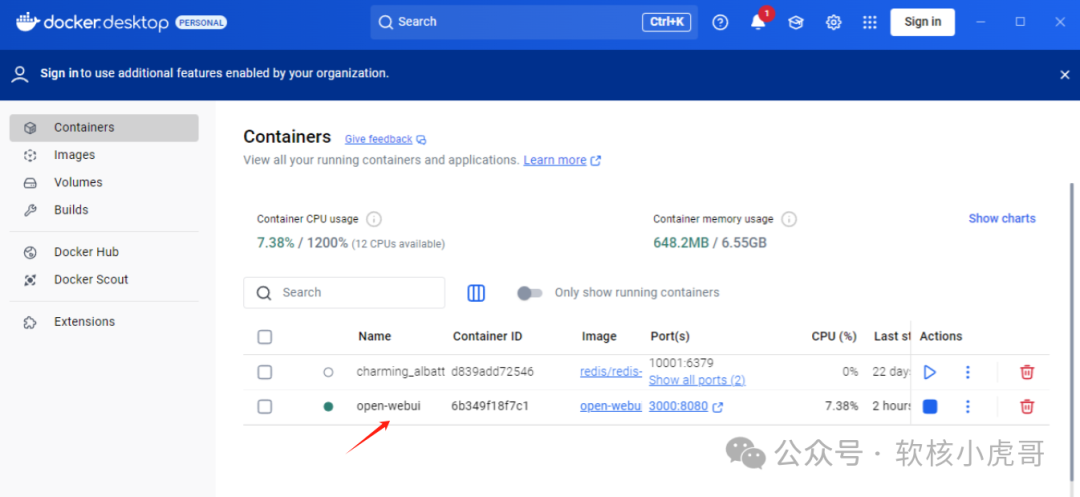

安装完成在DockerDesktop会有以下信息

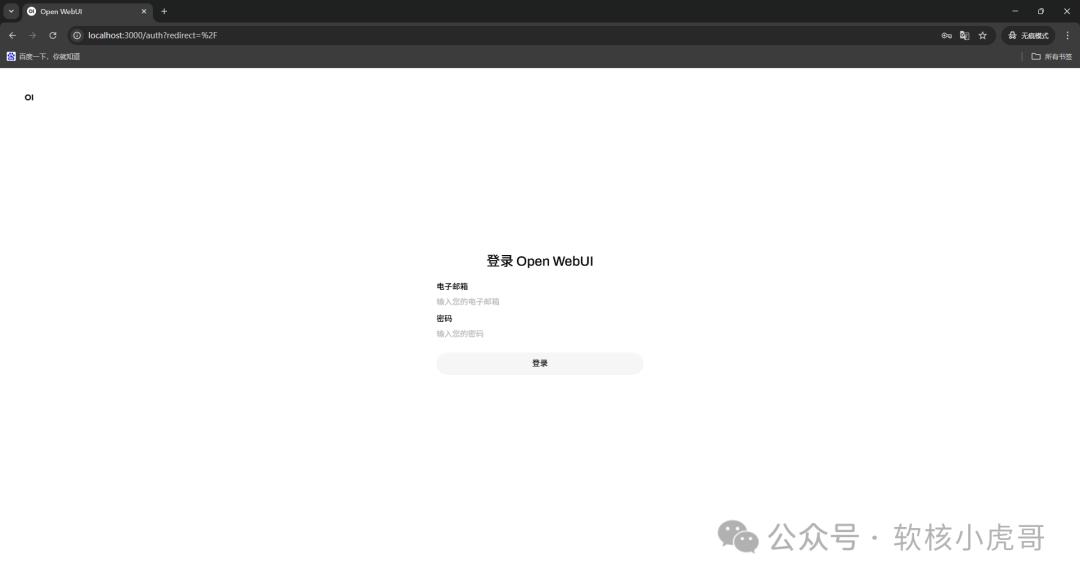

浏览器访问localhost:3000,注册一个账号,登入后即可开始与大模型对话了

04配置局域网访问

第三步完成的小伙伴,已经可以在本地正常使用大模型了,但如果想要在本地局域网任意一台机器访问大模型,还需要继续往下看

首先我们需要配置Ollama的环境变量

ollama环境变量说明:

|

环境变量 | 功能说明 |

默认值/示例 |

|

OLLAMA_HOST |

设置API服务监听地址与端口,0.0.0.0表示允许所有IP访问 |

0.0.0.0:11434 |

|

OLLAMA_ORIGINS |

允许跨域请求的域名列表,*为通配符 |

* |

|

OLLAMA_MODELS |

自定义模型存储路径,避免占用系统盘空间 |

D:\ollama\models |

|

OLLAMA_KEEP_ALIVE |

控制模型在内存中的保留时间,减少重复加载开销 |

24h |

|

OLLAMA_NUM_PARALLEL |

并行处理请求数,提升高并发场景下的吞吐量 |

2 |

|

OLLAMA_DEBUG |

启用调试日志,排查服务异常 |

1 |

|

OLLAMA_GPU_OVERHEAD |

扩展显存不足时,利用RAM/VRAM混合加载大模型(需手动计算显存值) |

81920000000(80GB) |

开始配置>>>>>>>>

-

右键“此电脑” → 属性 → 高级系统设置 → 环境变量 → 用户变量 → 新建变量

-

添加环境变量

OLLAMA_HOST=0.0.0.0:11434

OLLAMA_ORIGINS=* -

重启Ollama

至此Windows部署本地大语言模型已全部完成

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

在这个版本当中:

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包,现在将这份 LLM大模型资料 分享出来: 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?