很多零基础想学习Python的人,都被Python的爬虫功能深深吸引。什么是爬虫呢?

用简单明了的一句话来解释,爬虫,就是一段自动抓取互联网信息的程序,从互联网上抓取对于我们有价值的信息。

那么利用Python爬虫功能又能帮我们实现什么呢?

1.收集数据

Python爬虫程序可用于收集数据,这也是最直接和最常用的方法。由于爬虫程序是一个程序,运行得非常快,并且不会因为重复的事情而感到疲倦,因此使用爬虫程序获取大量数据变得非常简单和快速。比如可以做到抓取网页云音乐评论做自然语言处理得到人们对不同歌手的评价、抓取豆瓣电影按评分挑出自己喜欢看、找到合适的房源及价格等等。

由于99%以上的网站是基于模板开发的,使用模板可以快速生成大量布局相同、内容不同的页面。因此,只要为一个页面开发了爬虫程序,爬虫程序也可以对基于同一模板生成的不同页面进行爬取内容。

2.市场调研

运用Python爬虫汇总整理垂直市场的需求关键字,进行数据对比、商业分析、运行投资策略,做好市场规划。比如抓取某网站数据分析该网站用户并做出图谱以及SEO。再比如要调研一家电商公司,想知道他们的商品销售情况。这家公司声称每月销售额达数亿元。如果你使用爬虫来抓取公司网站上所有产品的销售情况,那么你就可以计算出公司的实际总销售额。

此外,如果你抓取所有的评论并对其进行分析,你还可以发现网站是否出现了刷单的情况。数据是不会说谎的,特别是海量的数据,人工造假总是会与自然产生的不同。过去,用大量的数据来收集数据是非常困难的,但是现在在爬虫的帮助下,许多欺骗行为会赤裸裸地暴露在阳光下。

3.刷流量和秒杀

刷流量是python爬虫的自带的功能。当一个爬虫访问一个网站时,如果爬虫隐藏得很好,网站无法识别访问来自爬虫,那么它将被视为正常访问。所以可以通过收集大量的代理服务器,来获得不同的IP进行刷流量或刷票。

除了刷流量外,还可以参与各种秒杀活动,包括但不限于在各种电商网站上抢商品优惠券,抢最低折扣机票和火车票。目前,网络上很多人专门使用爬虫来参与各种活动并从中赚钱。这种行为一般称为“薅羊毛”,这种人被称为“羊毛党”。不过使用爬虫来“薅羊毛”进行盈利的行为实际上游走在法律的灰色地带,希望大家不要尝试。

Python爬虫功能可以说是异常强大,很多Python程序员也曾开玩笑说,“万物皆可爬”,作为Python语言中实用性最强,且新手学习回报率最高,最容易获得成就感的一大模块,深受广大入门新手所喜爱。

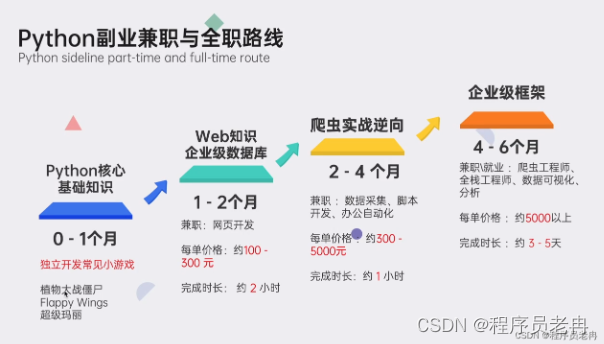

▍学习资源推荐

零基础Python学习资源介绍

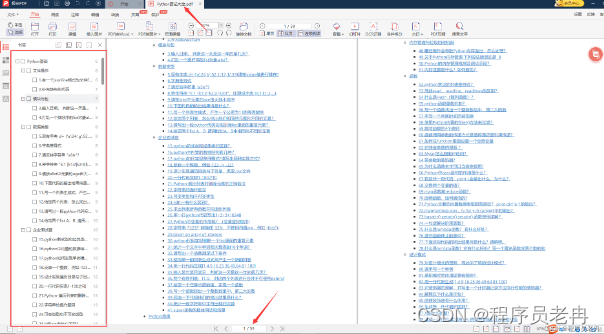

👉Python学习路线汇总👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。(学习教程文末领取哈)

👉Python必备开发工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉Python学习视频600合集👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉实战案例👈

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

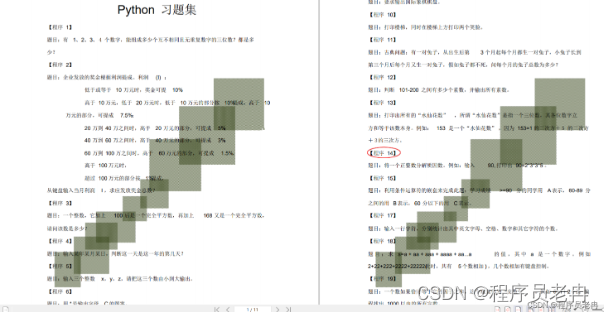

👉100道Python练习题👈

检查学习结果。

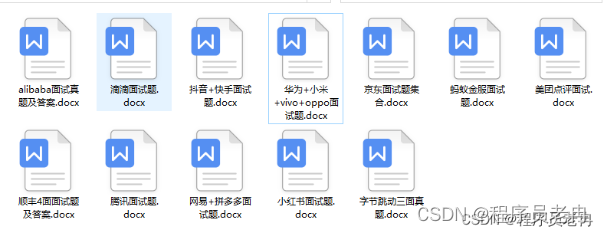

👉面试刷题👈

资料领取

上述这份完整版的Python全套学习资料已经上传CSDN官方,朋友们如果需要可以微信扫描下方CSDN官方认证二维码输入“领取资料” 即可领取。

3091

3091

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?