1.1 环境搭建

- 具体的安装方法如下连接所示,主要部署基于Pytorch(1.8.0+cu111)的虚拟环境用于模型的搭建和训练。Ubuntu22.04上安装Anaconda3-CSDN博客

- 同时,需要安装一下自己常用的库,因为做模型的训练,我这里为了方便起见,还需要安装一下timm库。

pip install timm

1.2 数据集准备

- 使用ImageFolder对数据进行加载

train_dataset = datasets.ImageFolder(root=args.TrainFolder, transform=data_train_transform)

test_dataset = datasets.ImageFolder(root=args.TestFolder, transform=data_test_transform)

print(train_dataset.class_to_idx)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64, shuffle=True,num_workers=4,drop_last=True,pin_memory=True)

test_loader = torch.utils.data.DataLoader(test_dataset, batch_size=64, shuffle=False,num_workers=4,pin_memory=True)

- data_train_transform与data_test_transform数据预处理方法为,此处不写正则化,是想着简化后面在C#中的预处理步骤(统一除以255即可)

data_train_transform = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.GaussianBlur(kernel_size=(5,5),sigma=(0.1,0.3)),

transforms.RandomResizedCrop((224,224)),

# transforms.Resize((224,224)),

#Cutout(),

transforms.ToTensor(),

# transforms.Normalize(mean=[0.49404827, 0.49592876, 0.4070973],

# std=[0.2071776, 0.2007362, 0.21388549])

])

data_test_transform = transforms.Compose([

transforms.Resize((224,224)),

transforms.ToTensor(),

# transforms.Normalize(mean=[0.5006999, 0.50564367, 0.40601832],

# std=[0.21505603, 0.2077407, 0.2244142])

])

1.3 训练过程搭建

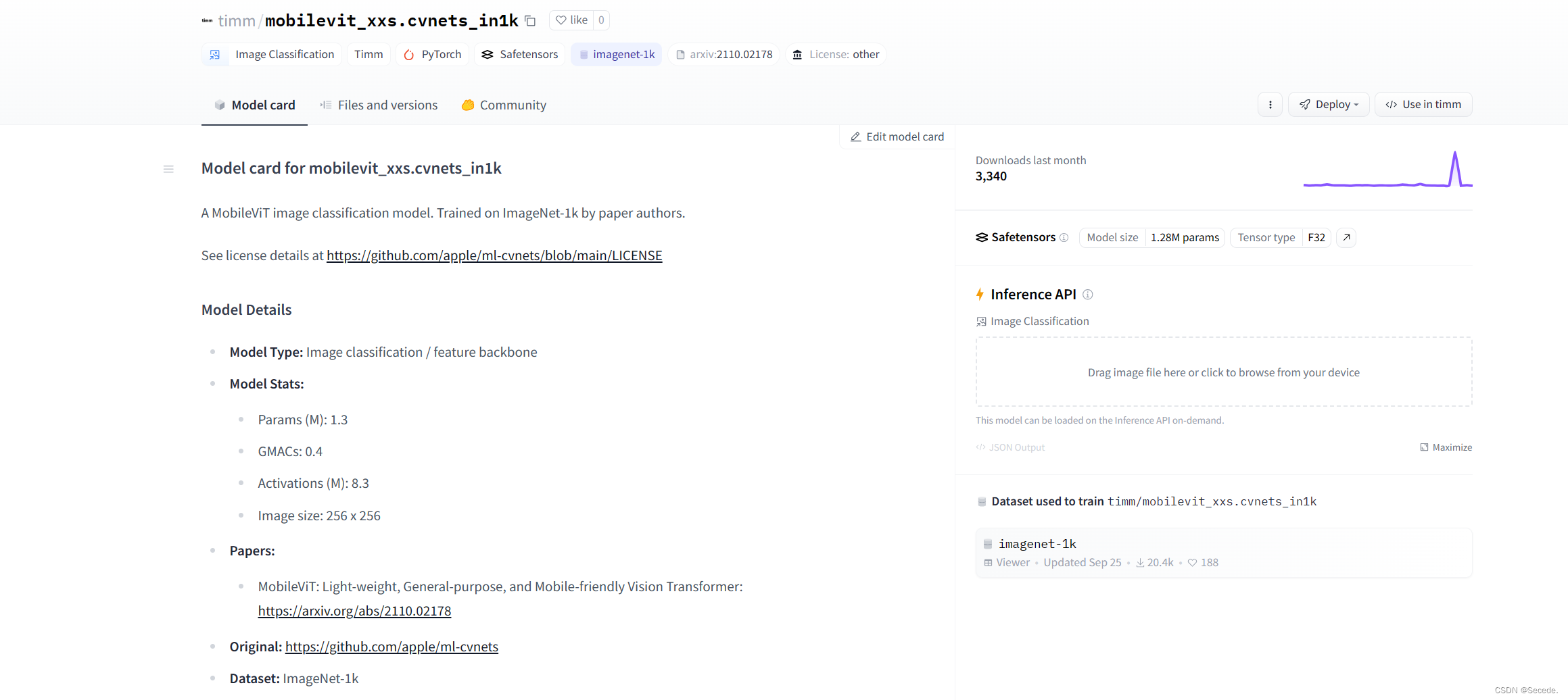

- 我们直接使用timm库选择模型结构,因为后面C#选择CPU对模型进行推理,所以选择参数量和计算复杂度低的模型,这块我选择的是mobilevit。

model = timm.create_model('timm/mobilevit_xxs.cvnets_in1k',num_classes=args.num_classes,pretrained=True ,pretrained_cfg_overlay=dict(file='./pytorch_model.bin'))

现在timm的模型预训练权重下载基本都得在huggingface[huggingface.co]上下载了。

- 模型训练与评估

for epoch in range(args.Epoch):

model.train()

for i, (images, labels) in enumerate(train_loader):

images = images.to(device) / 255.0

labels = labels.to(device)

# 前向传播

optimizer.zero_grad()

outputs = model(images)

loss = criterion(outputs, labels)

# 反向传播和优化

loss.backward()

optimizer.step()

if (i + 1) % 10 == 0:

print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}'

.format(epoch + 1, args.Epoch, i + 1, total_step, loss.item()))

model.eval()

TP = 0

Total = 0

with torch.no_grad():

for step, (images, labels) in enumerate(tqdm(test_loader)):

images = images.to(device) / 255.0

labels = labels.to(device)

# 前向传播

outputs = torch.argmax(model(images),dim=1)

TP += outputs.eq(labels).sum().item()

Total += images.shape[0]

print("Acc is : {:.3f}".format(TP / Total))

1.4 TorchScript模型推理

- 模型转换为TorchScript

model.eval()

model.to(torch.device("cpu"))

x = torch.randn(size=(1,3,224,224), requires_grad=True)

net_trace = torch.jit.trace(model,x)

torch.jit.save(net_trace,args.Weight_Saved_Path + 'BCT.bin')

1.5完整代码

import os

import torch

import shutil

import argparse

import torch.nn as nn

import torch.optim as optim

import torchvision.transforms as transforms

import torchvision.datasets as datasets

import torchvision.models as models

import timm

from torchtoolbox.transform import Cutout

from tqdm import tqdm

# 定义数据转换

data_train_transform = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.GaussianBlur(kernel_size=(5,5),sigma=(0.1,0.3)),

transforms.RandomResizedCrop((224,224)),

transforms.ToTensor(),

])

data_test_transform = transforms.Compose([

transforms.Resize((224,224)),

transforms.ToTensor(),

])

parser = argparse.ArgumentParser()

parser.add_argument("--Epoch",default=10,required=False)

parser.add_argument("--lr",default=1e-4,required=False)

parser.add_argument("--num_classes",default=2,required=False)

parser.add_argument("--Weight_Saved_Path",default=r'./Weight/',required=False)

parser.add_argument("--TrainFolder",default=r'/home/lenovo/deeplearning/forge/train/',required=False)

parser.add_argument("--TestFolder",default=r'/home/lenovo/deeplearning/forge/test/',required=False)

args = parser.parse_args()

if(not os.path.exists(args.Weight_Saved_Path)):

os.mkdir(args.Weight_Saved_Path)

if(not (os.path.exists(args.TrainFolder) or os.path.exists(args.TestFolder))):

raise "dataset folder not exists"

train_dataset = datasets.ImageFolder(root=args.TrainFolder, transform=data_train_transform)

test_dataset = datasets.ImageFolder(root=args.TestFolder, transform=data_test_transform)

print(train_dataset.class_to_idx)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64, shuffle=True,num_workers=4,drop_last=True,pin_memory=True)

test_loader = torch.utils.data.DataLoader(test_dataset, batch_size=64, shuffle=False,num_workers=4,pin_memory=True)

# 加载预训练的 ResNet-18 模型并修改最后一个全连接层

model = timm.create_model('timm/mobilevit_xxs.cvnets_in1k',num_classes=args.num_classes,pretrained=True ,pretrained_cfg_overlay=dict(file='./pytorch_model.bin'))

print(model.default_cfg)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss() # 修改为交叉熵损失函数

optimizer = optim.AdamW(model.parameters(), lr=args.lr)

device = torch.device('cuda')

print(device)

model.to(device)

total_step = len(train_loader)

for epoch in range(args.Epoch):

model.train()

for i, (images, labels) in enumerate(train_loader):

images = images.to(device) / 255.0

labels = labels.to(device)

# 前向传播

optimizer.zero_grad()

outputs = model(images)

loss = criterion(outputs, labels)

# 反向传播和优化

loss.backward()

optimizer.step()

if (i + 1) % 10 == 0:

print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}'

.format(epoch + 1, args.Epoch, i + 1, total_step, loss.item()))

model.eval()

TP = 0

Total = 0

with torch.no_grad():

for step, (images, labels) in enumerate(tqdm(test_loader)):

images = images.to(device) / 255.0

labels = labels.to(device)

# 前向传播

outputs = torch.argmax(model(images),dim=1)

TP += outputs.eq(labels).sum().item()

Total += images.shape[0]

print("Acc is : {:.3f}".format(TP / Total))

# 保存模型

model.eval()

model.to(torch.device("cpu"))

x = torch.randn(size=(1,3,224,224), requires_grad=True)

net_trace = torch.jit.trace(model,x)

torch.jit.save(net_trace,args.Weight_Saved_Path + 'Forge_Classification_Transformer.bin')

2.模型训练和推理

模型本地化推理

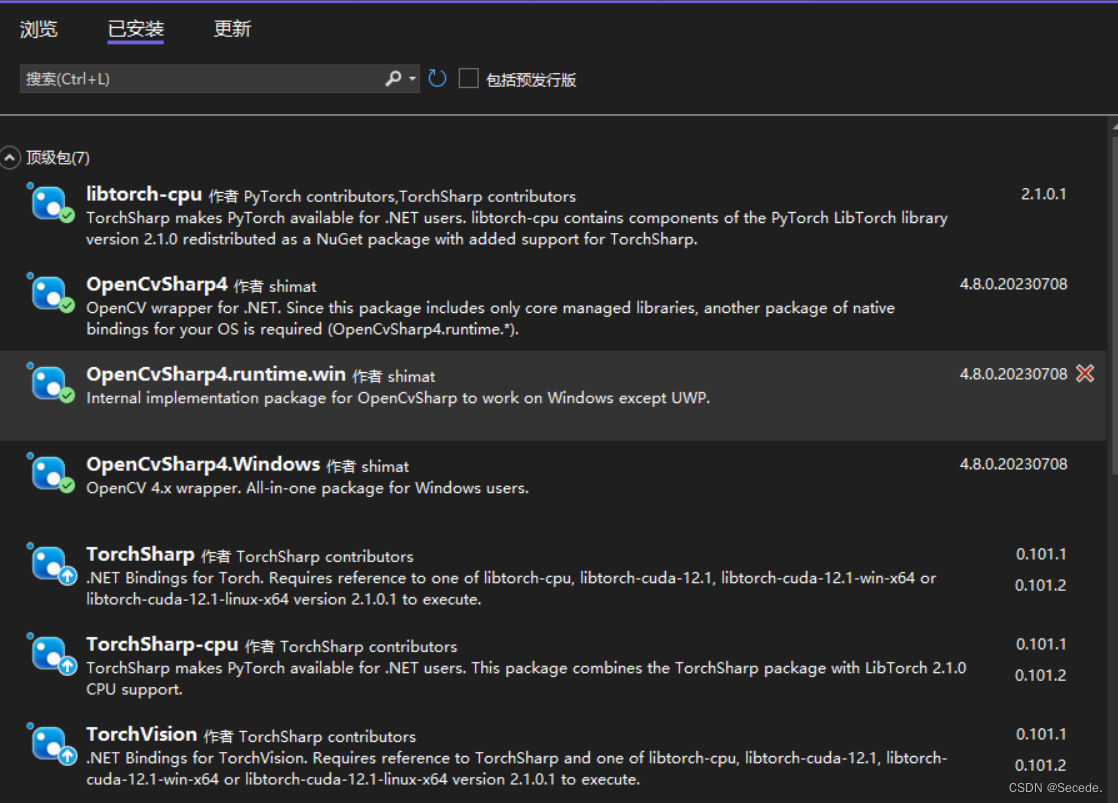

2.1 基础库选择

主要就是得有OpenCvSharp、TorchSharp、libtorch三个主要的库

2.2 模型推理程序

- 数据预处理

using OpenCvSharp;

using TorchSharp;

using static TorchSharp.torch;

Mat img = Cv2.ImRead(this.TargetPath).Resize(new OpenCvSharp.Size(224, 224));

img.ConvertTo(img, MatType.CV_8UC3);

var data = img.ToBytes();

torchvision.io.SkiaImager x = new torchvision.io.SkiaImager();

var image_tensor = x.DecodeImage(data, torchvision.io.ImageReadMode.RGB);

return image_tensor.unsqueeze(0).to(torch.float32) / 255.0f;

- 模型加载

using OpenCvSharp;

using TorchSharp;

using static TorchSharp.torch;

try

{

net = jit.load(Weight,DeviceType.CPU);

}

catch (Exception ex)

{

MessageBox.Show(ex.ToString());

}

- 模型推理和结果输出

using OpenCvSharp;

using TorchSharp;

using static TorchSharp.torch;

net.eval();

var outputs = torch.softmax((torch.Tensor)net.forward(temp_tensor),1);

var results = torch.argmax(outputs, 1);

/*

## 最后

**自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。**

**深知大多数Java工程师,想要提升技能,往往是自己摸索成长,自己不成体系的自学效果低效漫长且无助。**

**因此收集整理了一份《2024年嵌入式&物联网开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。**

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上嵌入式&物联网开发知识点,真正体系化!**

[**如果你觉得这些内容对你有帮助,需要这份全套学习资料的朋友可以戳我获取!!**](https://bbs.csdn.net/topics/618654289)

**由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新**!!

片转存中...(img-5pBosfq4-1715541188893)]

[外链图片转存中...(img-M2S0Z2Ja-1715541188893)]

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上嵌入式&物联网开发知识点,真正体系化!**

[**如果你觉得这些内容对你有帮助,需要这份全套学习资料的朋友可以戳我获取!!**](https://bbs.csdn.net/topics/618654289)

**由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新**!!

5029

5029

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?