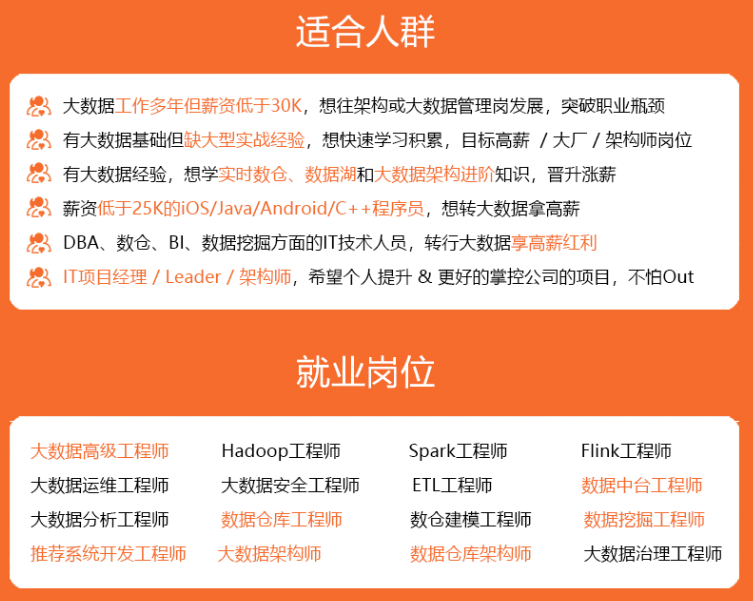

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

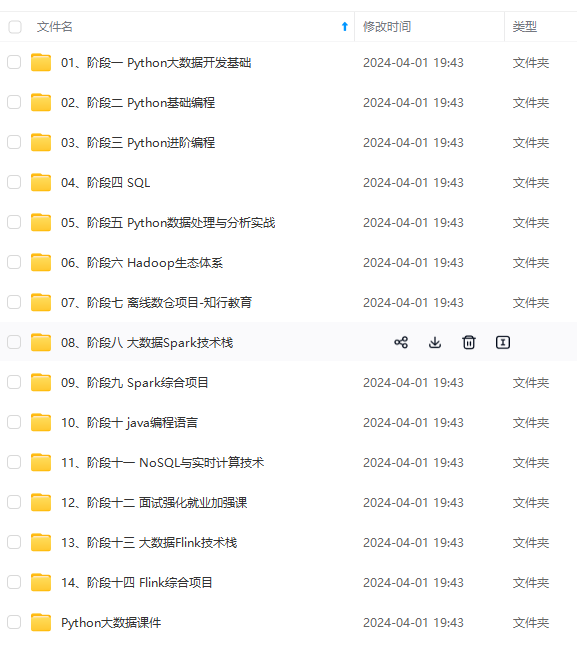

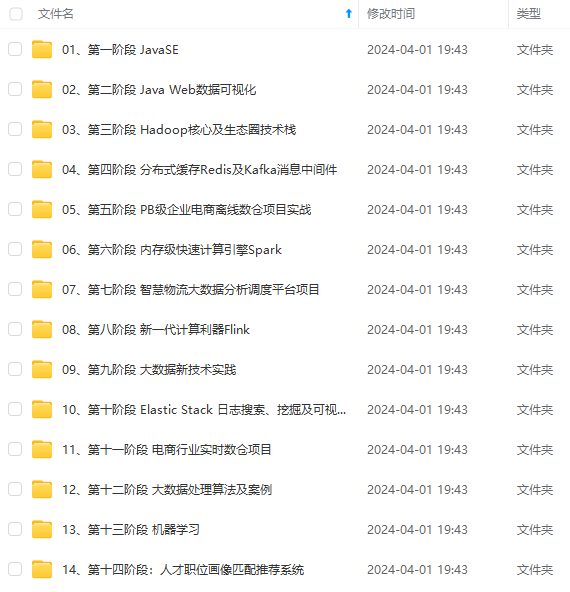

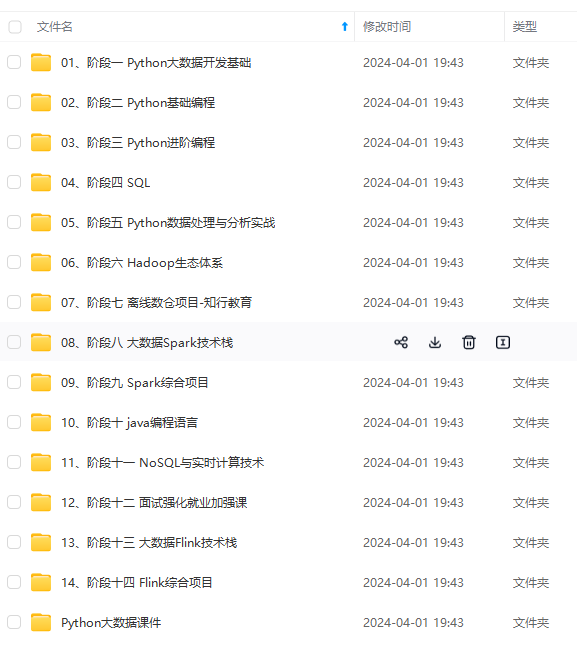

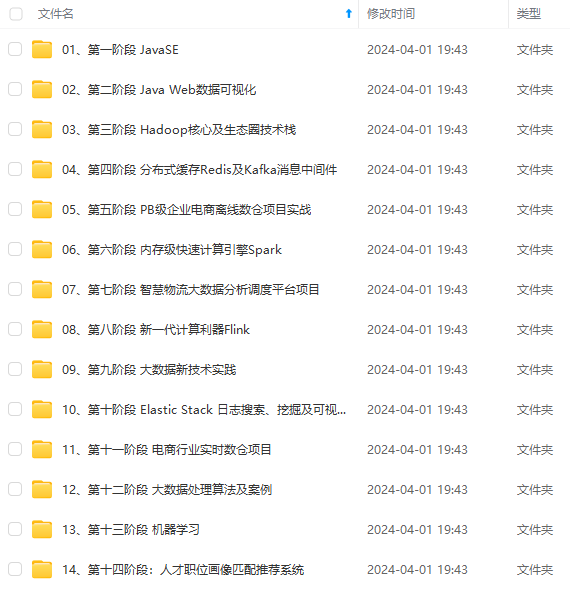

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

sleep(1000);

}

producer.send(new ProducerRecord<String, String>(topic, k, json));

}

producer.close();

}

}

/**

* kafka连接

* @return

*/

private Properties config() {

Properties props = new Properties();

props.put("bootstrap.servers",broker_list);

props.put("acks", "1");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

return props;

}

}

#### 2.2 创建flink程序

Flink.class

public class Flink {

private static final String topic = “test”;

public static final String broker_list = “ip(换成自己的):9092”;

public static void main(String[] args) {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.enableCheckpointing(1000);

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);

//读取Kafka数据,主题topic:

DataStream<String> transction = env.addSource(new FlinkKafkaConsumer<String>(topic, new SimpleStringSchema(), props()).setStartFromEarliest());

transction.rebalance().map(new MapFunction<String, Object>() {

private static final long serialVersionUID = 1L;

@Override

public String map(String value) {

System.out.println("ok了");

return value;

}

}).print();

try {

env.execute();

} catch (Exception ex) {

ex.printStackTrace();

}

}

public static Properties props() {

Properties props = new Properties();

props.put("bootstrap.servers", broker_list);

props.put("zookeeper.connect", "192.168.47.130:2182");

props.put("group.id", "kv\_flink");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

return props;

}

}

### 3、把项目打包放入hdfs中

hdfs dfs -put xxx.jar /root/xxx.jar

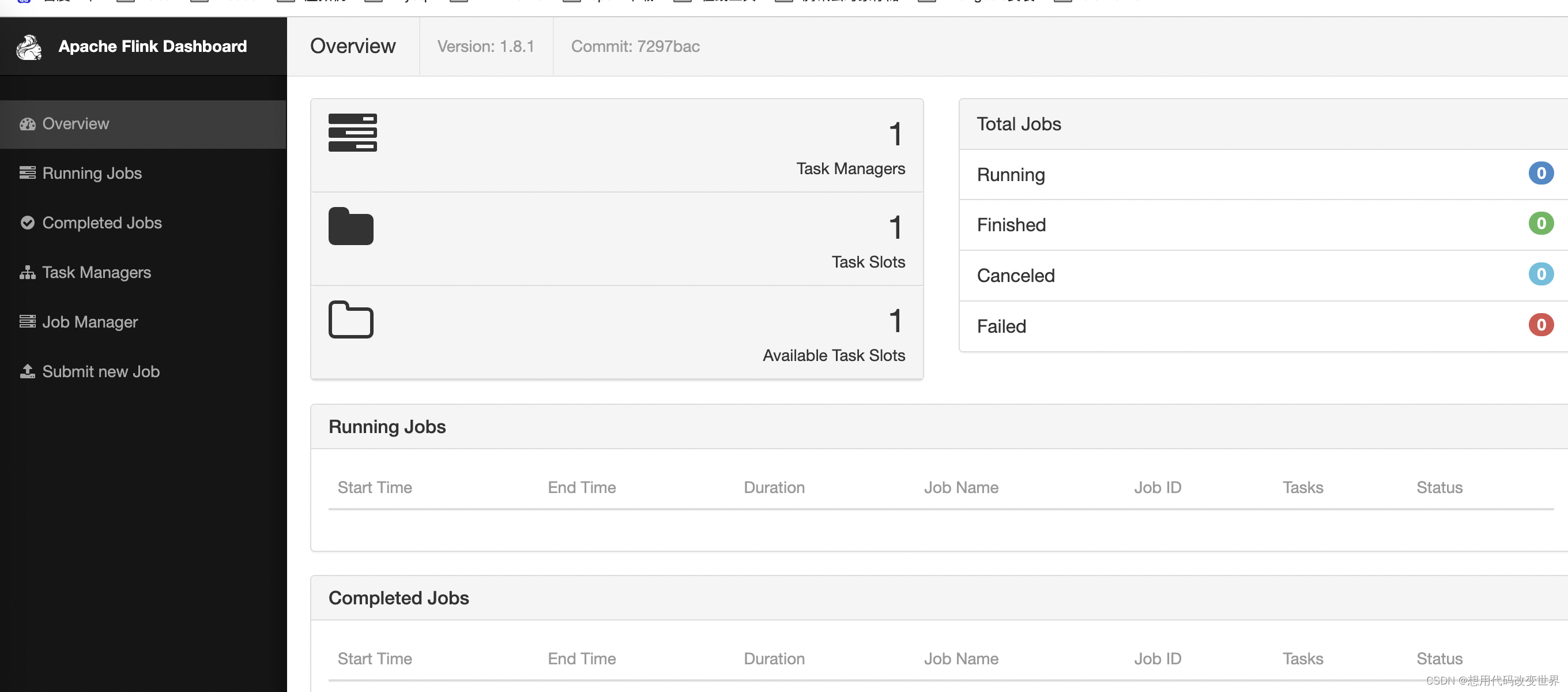

### 4、执行flink程序

进入flink的bin目录

./flink run --class com.xxx.xxx.MyWordCount1 /root/jar

### 5、打开web页面

### 6、额外扩展点

主要是配置一些属性字段,可以参考flink的的配置文件

到flink/conf/flink-conf.yaml中

//一旦开启是耗性能的 这是创建一次 300ms创建一次

env.enableCheckpointing(300);

env.getCheckpointConfig().setCheckpointingMode(CheckpointingMode.EXACTLY_ONCE);

env.getCheckpointConfig().setMaxConcurrentCheckpoints(2);

//2、设置重启策略,重启三次,没10秒执行一次 failureRateRestart 失败率重启

env.setRestartStrategy(RestartStrategies.fixedDelayRestart(3,10000L));

//3、并行度setParallelism()

env.setParallelism(1);

//4、时间特性 参数 TimeCharacteristic 有三种类型: ProcessingTime, IngestionTime, EventTime;

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);

//5、并行任务调度策略

//1、EagerSchedulingStrategy:适用于流计算,同时调度所有的task

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

297

297

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?