目录

3掌握rdd转换dataframe的方式及sparksql操作数据源

2DataFrame通过“as[ElementType]”方法转换得到Dataset

1理解sparksql 基本概念

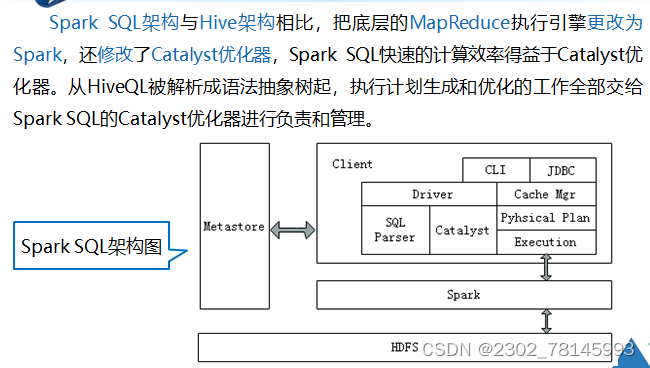

1.1sparksql概念

Spark SQL是Spark用来处理结构化数据的一个模块,它提供了一个编程抽象结构叫做DataFrame的数据模型(即带有Schema信息的RDD),Spark SQL作为分布式SQL查询引擎,让用户可以通过SQL、DataFrames API和Datasets API三种方式实现对结构化数据的处理。

2掌握dataframedataset基本方式

Datdaframe简介

- Spark SQL使用的数据抽象并非是RDD,而是DataFrame。

- 在Spark 1.3.0版本之前,DataFrame被称为SchemaRDD。

- DataFrame使Spark具备处理大规模结构化数据的能力。

- 在Spark中,DataFrame是一种以RDD为基础的分布式数据集。

DataFrame的结构类似传统数据库的二维表格,可以从很多数据源中创建,如结构化文件、外部数据库、Hive表等数据源。

dataframe创建步骤

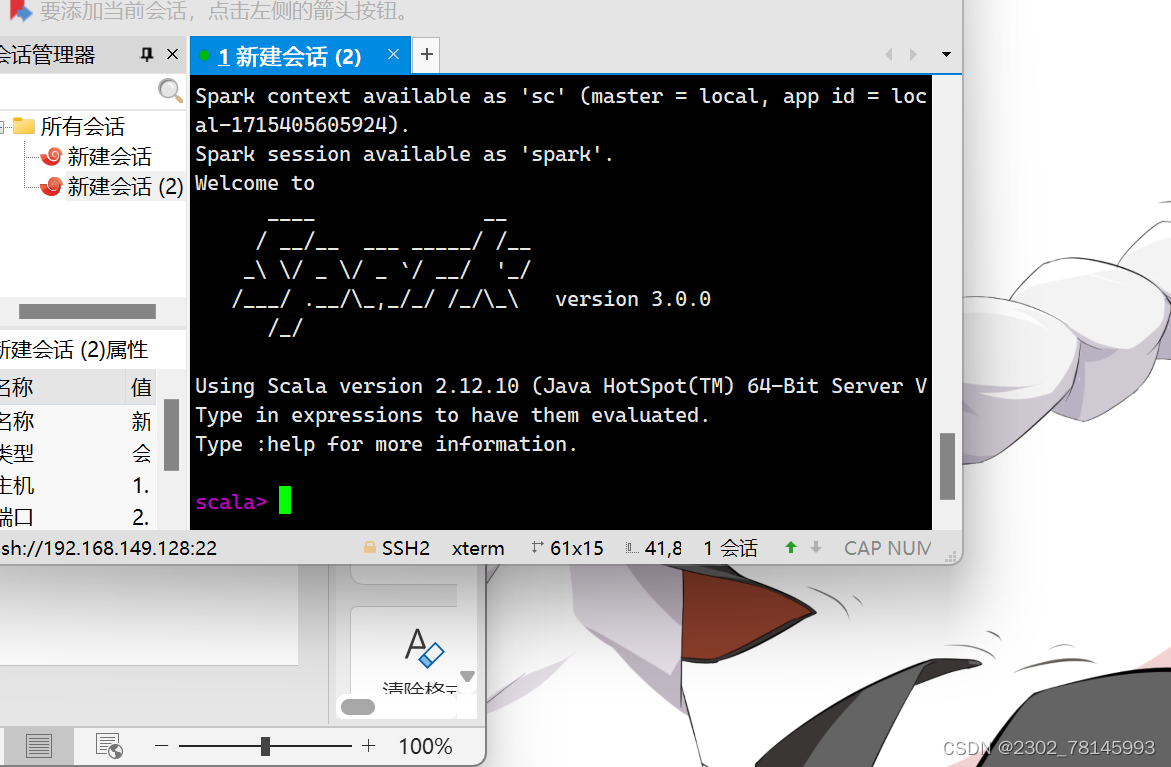

打开scala

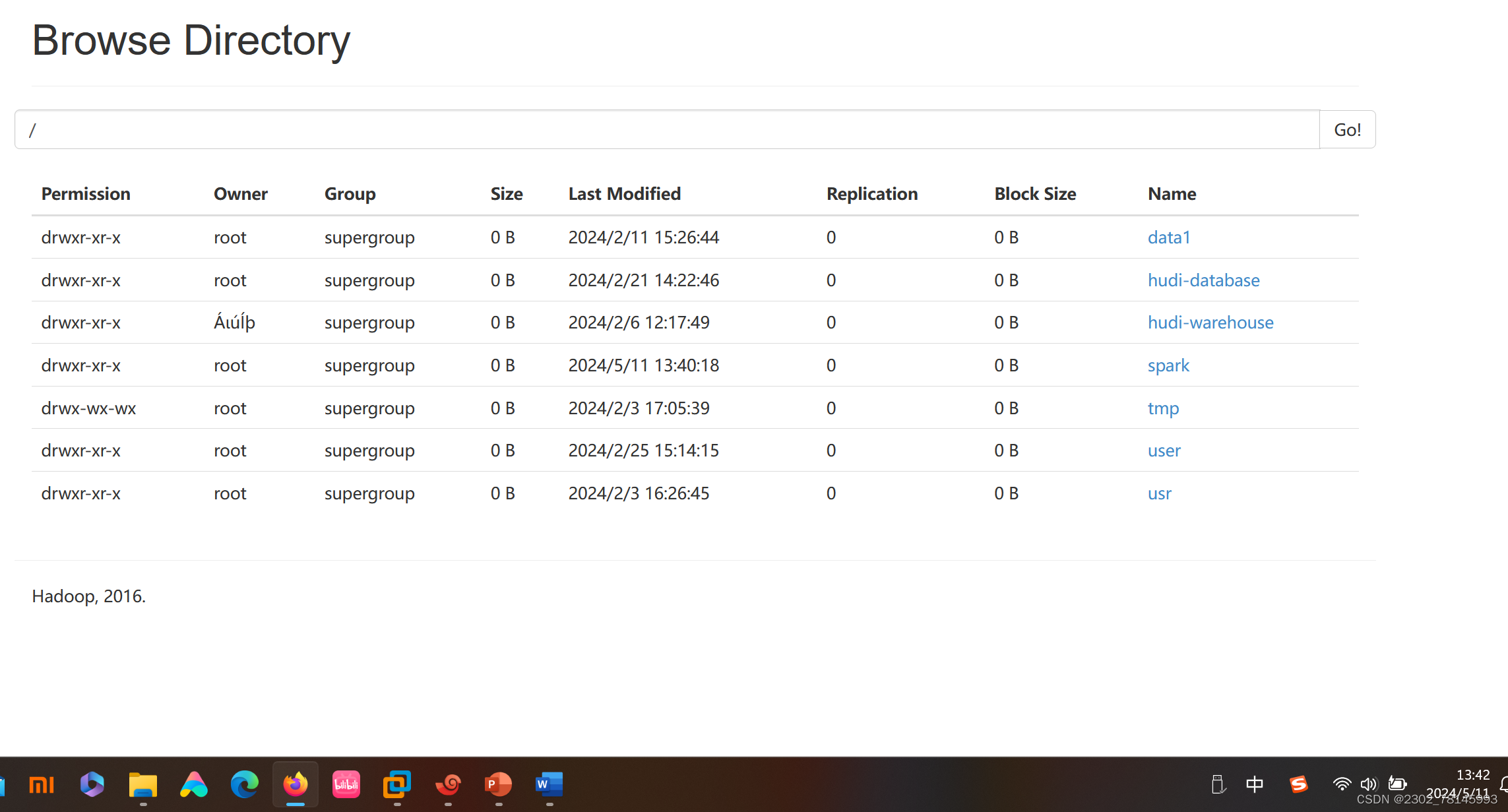

新建spark目录网站上查看

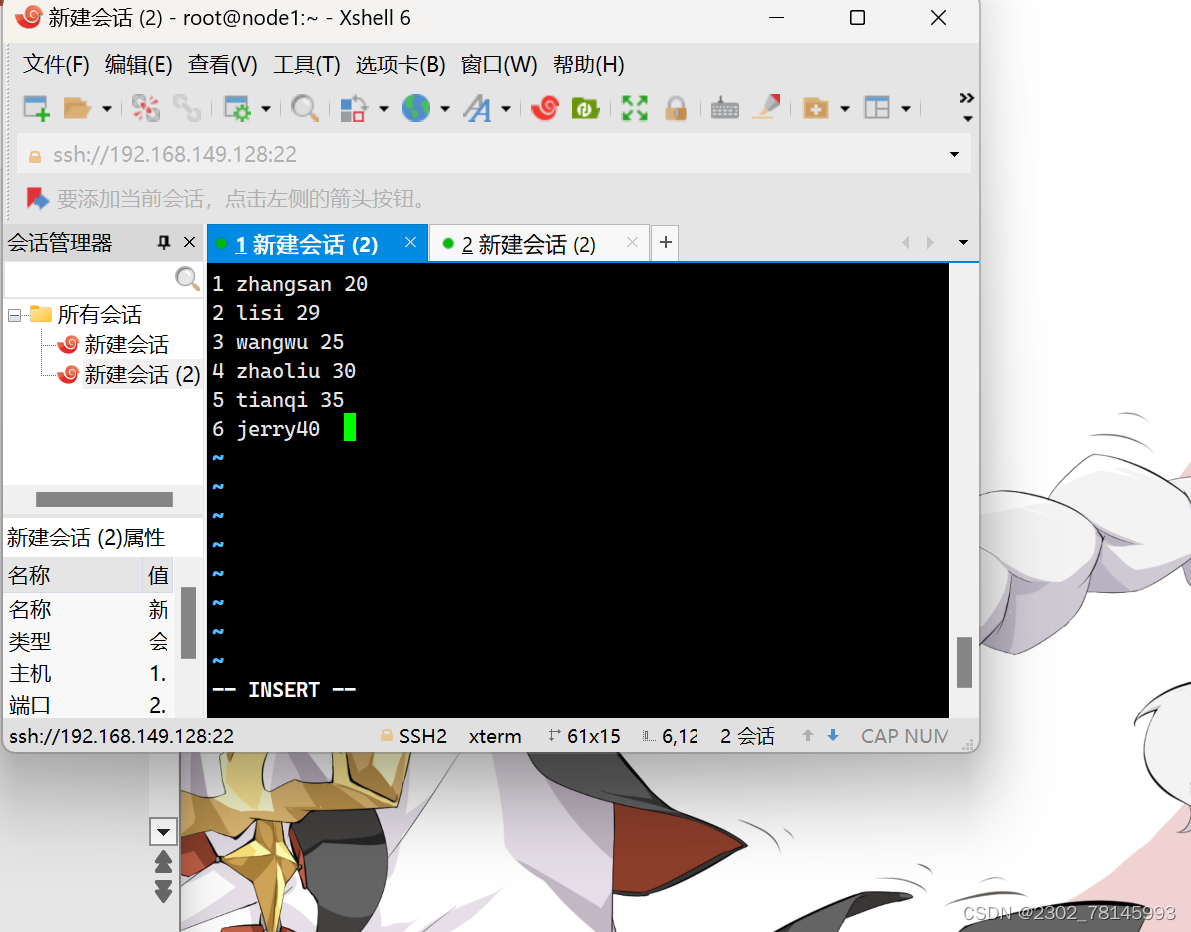

新建person文件

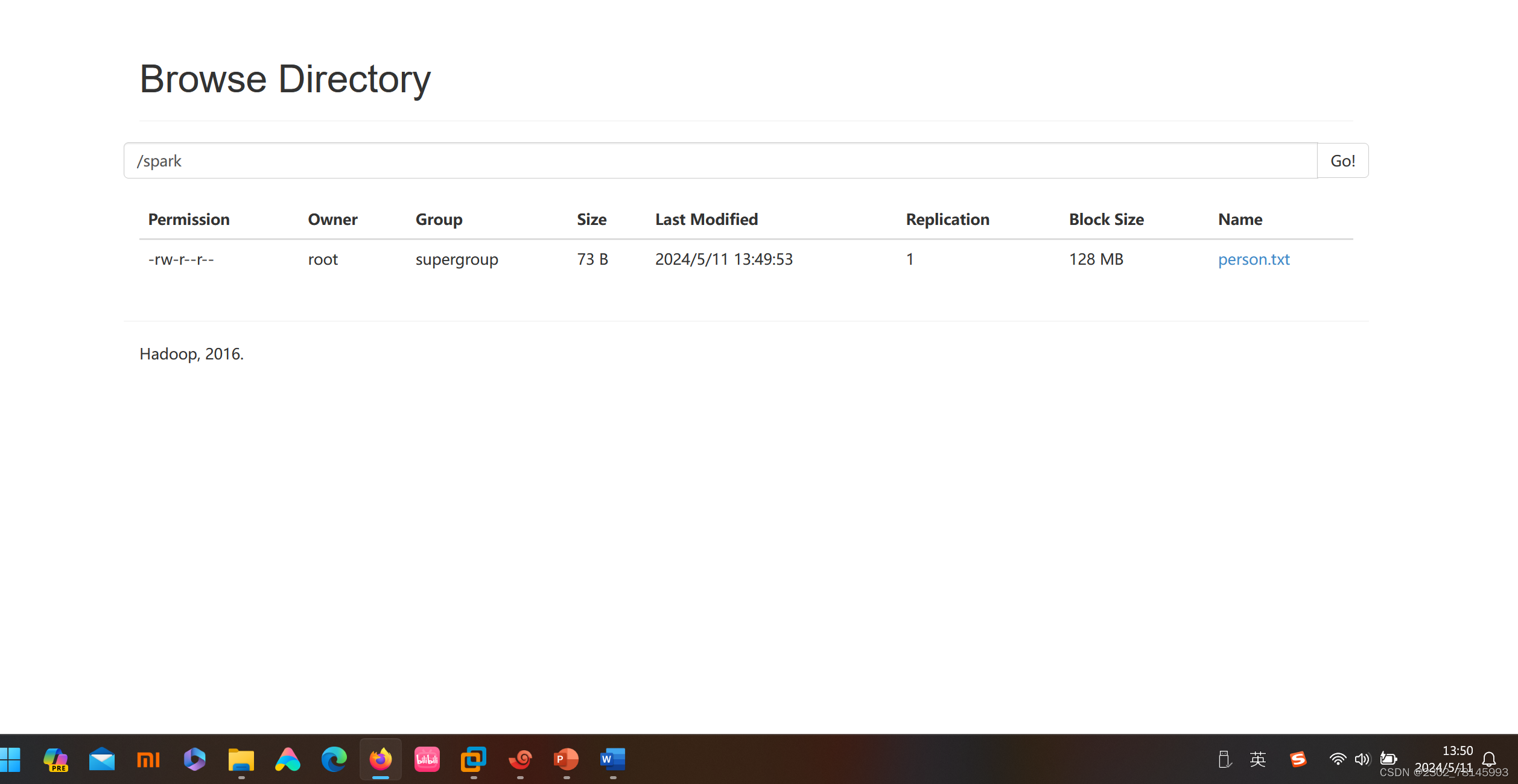

在/spark目录下查看文件是否上传

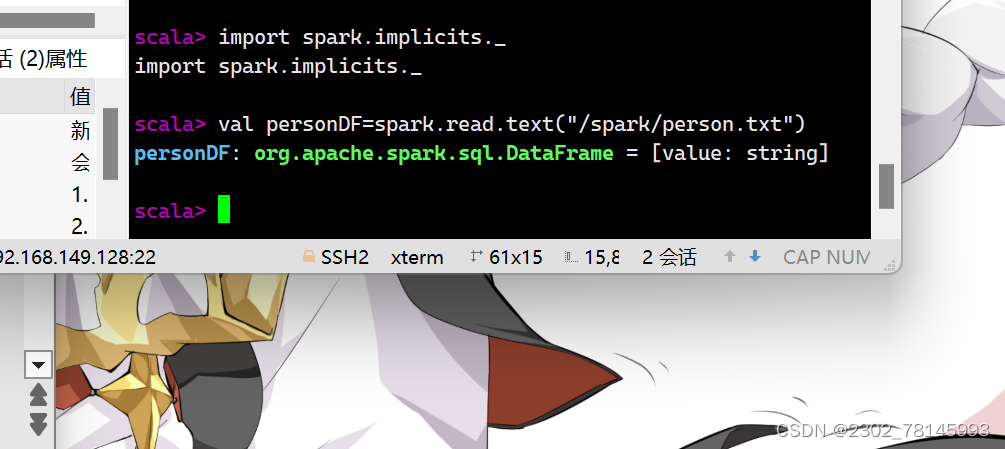

进入scala

2.通过文件直接创建DataFrame

Dataframe的查询

一.DSL风格操作

DataFrame提供了一个领域特定语言(DSL)以方便操作结构化数据,下面将针对DSL操作风格,讲解DataFrame

常用操作示例,

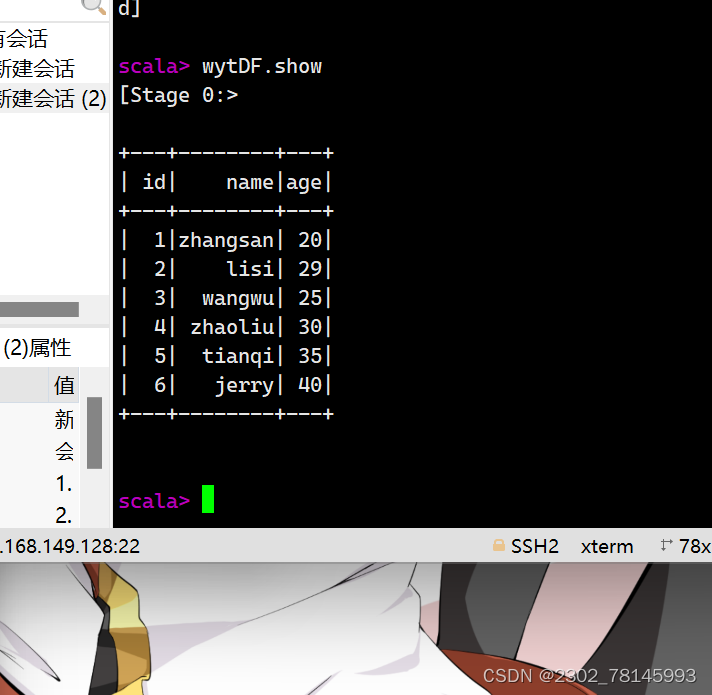

1.show():查看DataFrame中的具体内容信息

2.pritSchema0:查看0staFrame的Schema信息

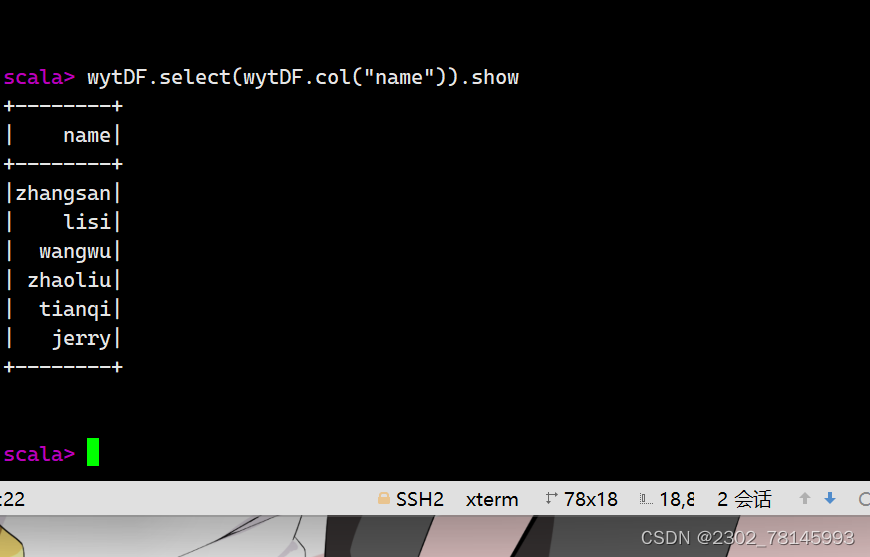

3.select():查看DataFrame中造取部分列的数据,

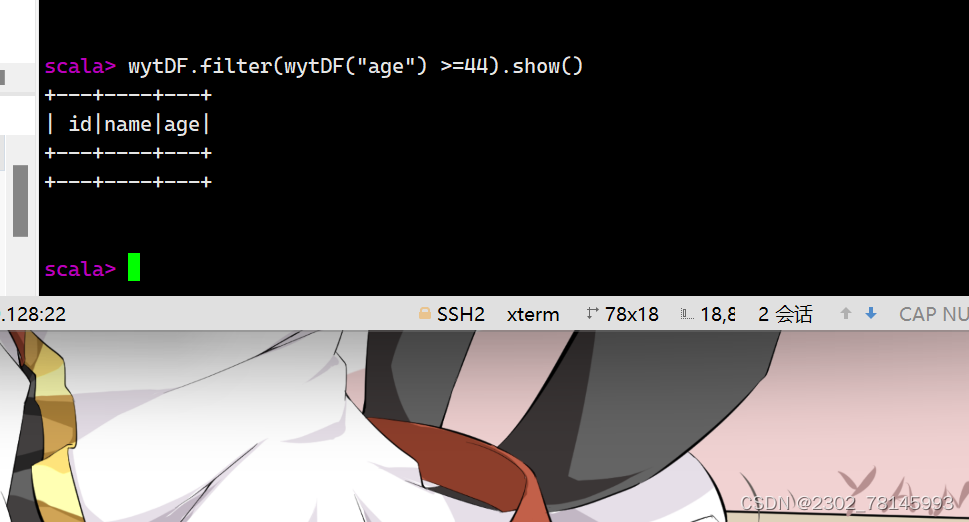

dataframe数据实操

- 要求过滤age 大于44等于44的数据

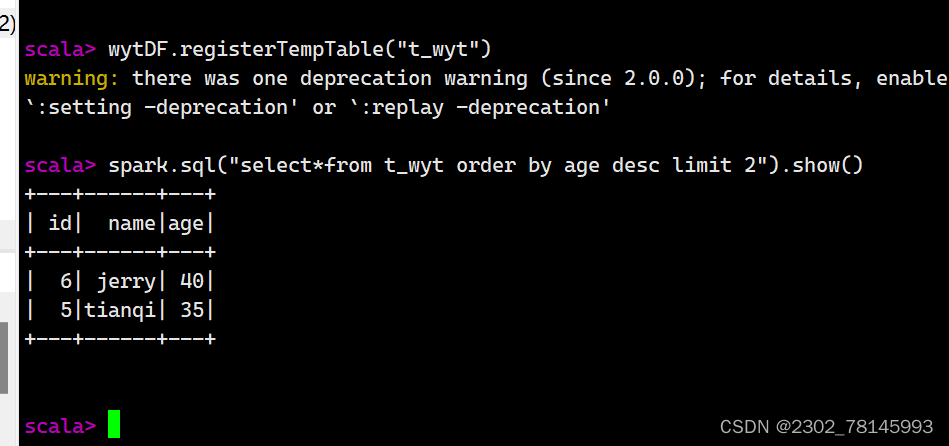

2. 查询年龄最大的前两名人的信息

RDD、DataFrame及Dataset的区别

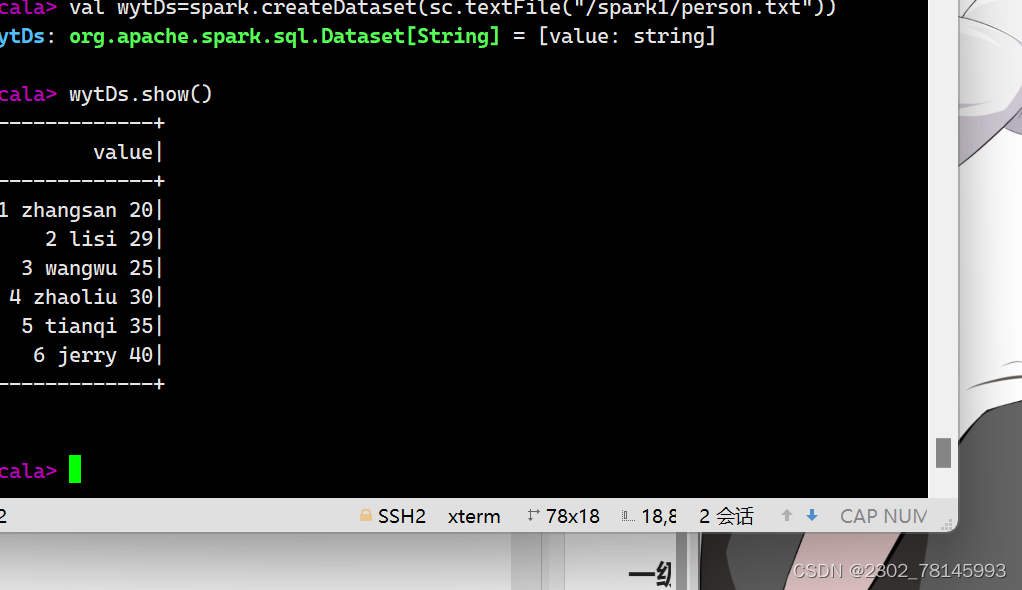

Dataset数据的表现形式,序号(3)和(4),其中序号(3)是在RDD每行数据的基础之上,添加一个数据类型(value:String)作为Schema元数据信息。而序号(4)每行数据添加People强数据类型,在Dataset[Person]中里存放了3个字段和属性,Dataset每行数据类型可自定义,一旦定义后,就具有错误检查机制。

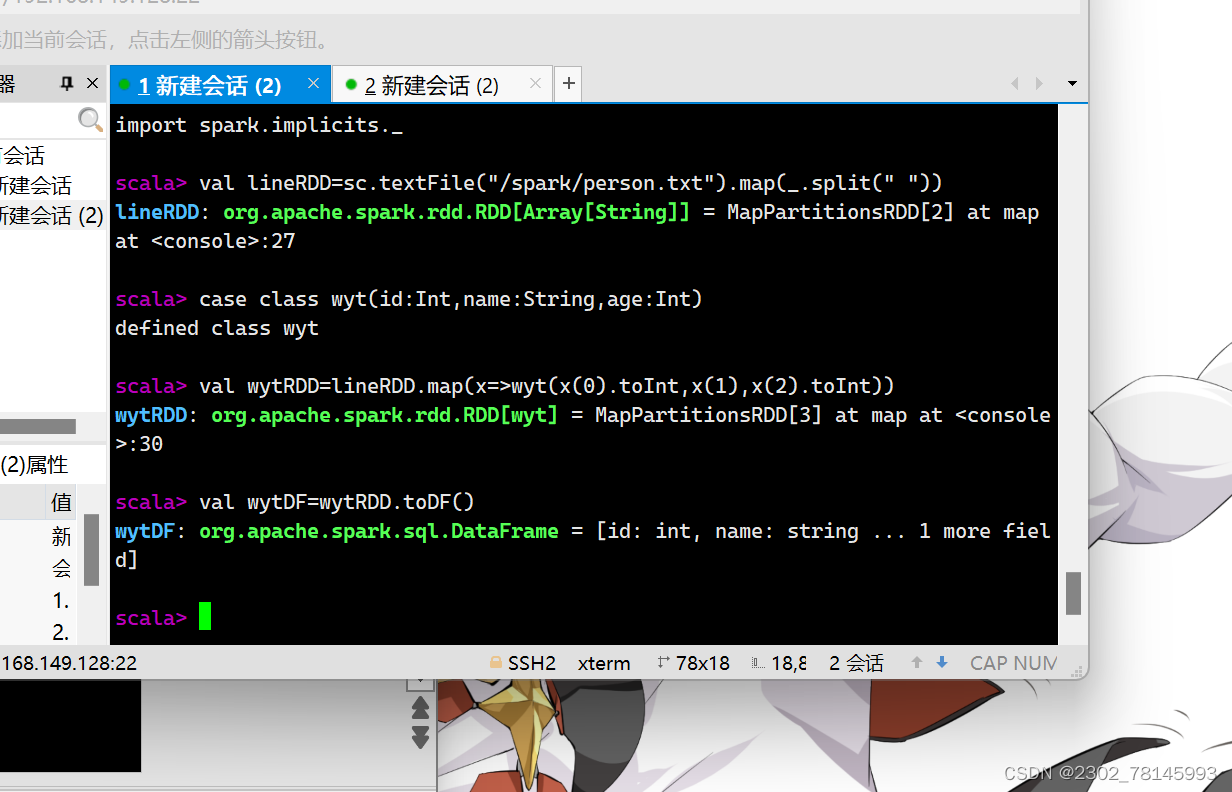

3掌握rdd转换dataframe的方式及sparksql操作数据源

创建dataset的方式

1、通过SparkSession中的createDataset来创建Dataset

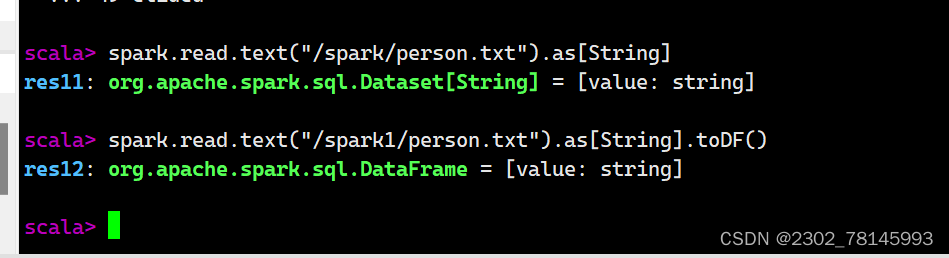

2DataFrame通过“as[ElementType]”方法转换得到Dataset

690

690

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?