对比学习全新突破!连发多篇Nature和Science!其中模型CLEF更是在蛋白质预测任务中,预测准确率达100%!

实际上,对比学习一直是“水”论文和高效涨点的利器,在CVPR、NerIPS等顶会也都是热门!主要在于:一方面,相比注意力机制、卷积等泛滥的涨点模块,其还处在能让审稿人有新鲜感的阶段,效果也拔群!更特别的是,其思想相对简单,容易上手,就看如何构造正、负样本!另一方面,其应用非常广泛,各种CV、NLP任务中,都有它的身影。且其能和多种技术结合,像是图神经网络、多模态、强化学习、聚类……这边给我们论文创新提供了广阔的空间。

为让大家能够紧跟领域前沿,早点发出自己的顶会,我给大家准备了18种创新思路,原文和源码都有。一起来看!

论文原文+开源代码需要的同学看文末

Hallucination Augmented Contrastive Learning for Multimodal Large Language Model

内容:本文提出了一种名为“幻觉增强对比学习”的方法,旨在解决多模态大语言模型(MLLMs)中的幻觉问题。研究发现,MLLMs中视觉和文本表示之间存在显著的模态差距,且包含幻觉和不包含幻觉的文本表示相互交织,难以区分。HACL通过引入对比学习,使用带有幻觉的文本作为难负样本,拉近非幻觉文本和视觉样本的表示,同时推远非幻觉和幻觉文本的表示。实验表明,HACL能够有效减少幻觉现象,并在多个基准测试中提升模型性能。

Contextrast:Contextual Contrastive Learning for Semantic Segmentation

内容:本文提出了一种名为Contextrast的语义分割方法,通过对比学习框架结合上下文对比学习和边界感知负采样来提升语义分割网络的性能。CCL通过多尺度特征聚合和特征间的关系来获取局部和全局上下文信息,增强模型对不同尺度特征之间关系的理解。BANE则专注于边界区域,选择错误预测区域边界附近的特征作为更难的负样本,利用细粒度细节解决边界分割问题。

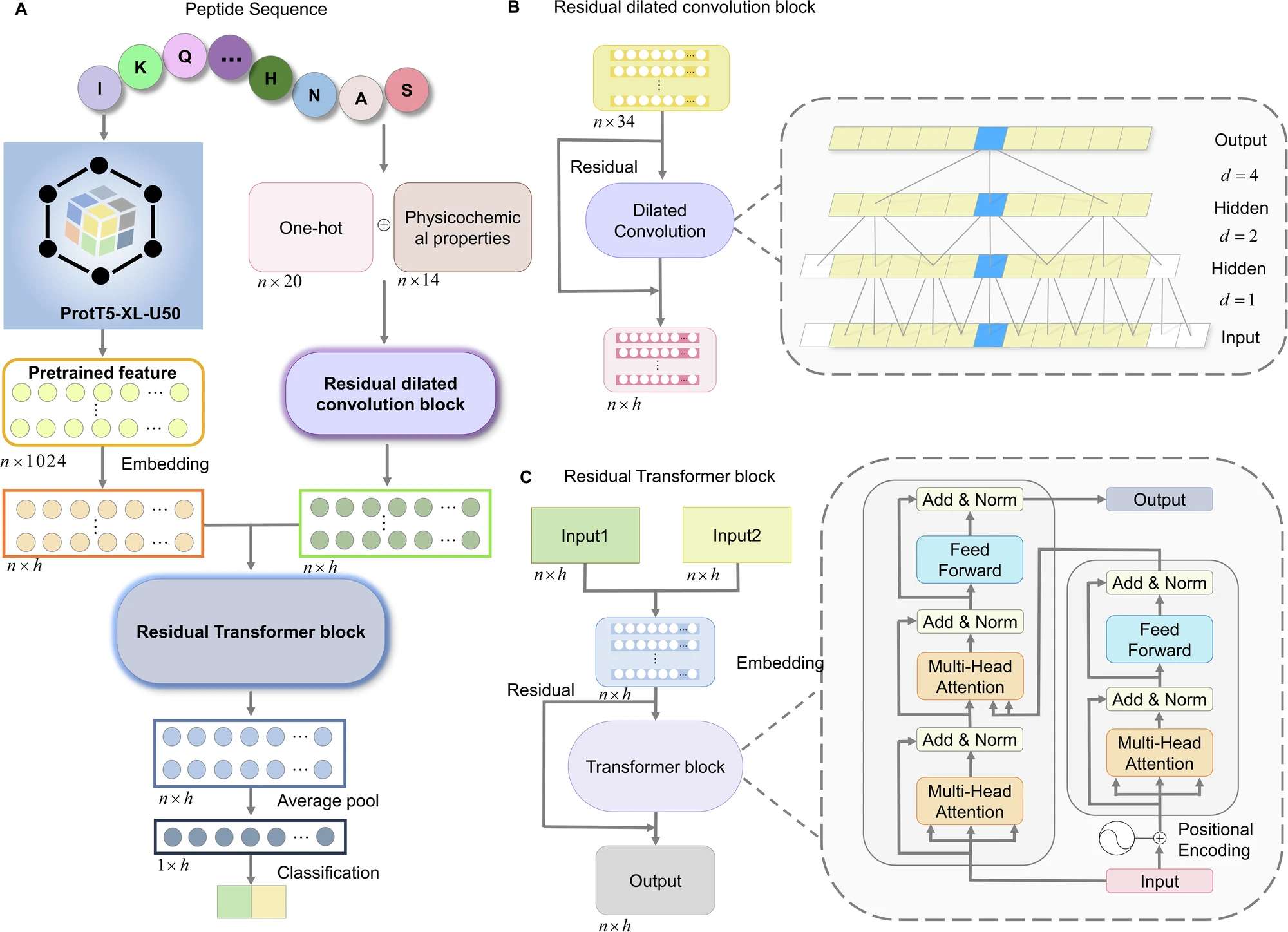

Contrastive-learning of language embedding and biological features for cross modality encoding and effector prediction

内容:本文提出了一种名为CLEF的模型,通过对比学习框架整合蛋白质语言模型(PLM)表示和生物特征,用于跨模态编码和效应子预测。该模型通过对比学习将不同模态的特征(如蛋白质结构、功能注释和实验数据)与PLM生成的蛋白质表示相结合,生成更具信息量和区分性的跨模态表示。在T3SE、T4SE和T6SE效应子预测任务中,CLEF表现优于现有的先进预测器,并通过实验验证了其预测的效应子。此外,CLEF还被应用于预测效应子之间的相互作用以及体内定殖关键基因,为理解细菌致病机制和开发新疗法提供了新的工具。

Improving Medical Multi-modal Contrastive Learning with Expert Annotations

内容:本文介绍了一种名为eCLIP的改进型CLIP模型,通过整合放射科医生的眼动热图(专家注释)来解决医学多模态对比学习中的数据稀缺和模态差异问题。eCLIP通过引入热图处理器和Mixup数据增强技术,有效利用有限的专家注释数据,提升模型的学习效果。实验表明,eCLIP在零样本分类、线性探测、跨模态检索以及基于检索增强的放射学报告生成等任务中均展现出更高质量的嵌入表示,能够更好地捕捉医学数据中的细微差异,并提高模型在医学图像分析中的性能。

码字不易,欢迎大家点赞评论收藏!

关注下方《AI科研技术派》

回复【18对比】获取完整论文

👇

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?