既要性能,又要效率;既要创新,又要普及

©作者|wy

来源|神州问学

引言

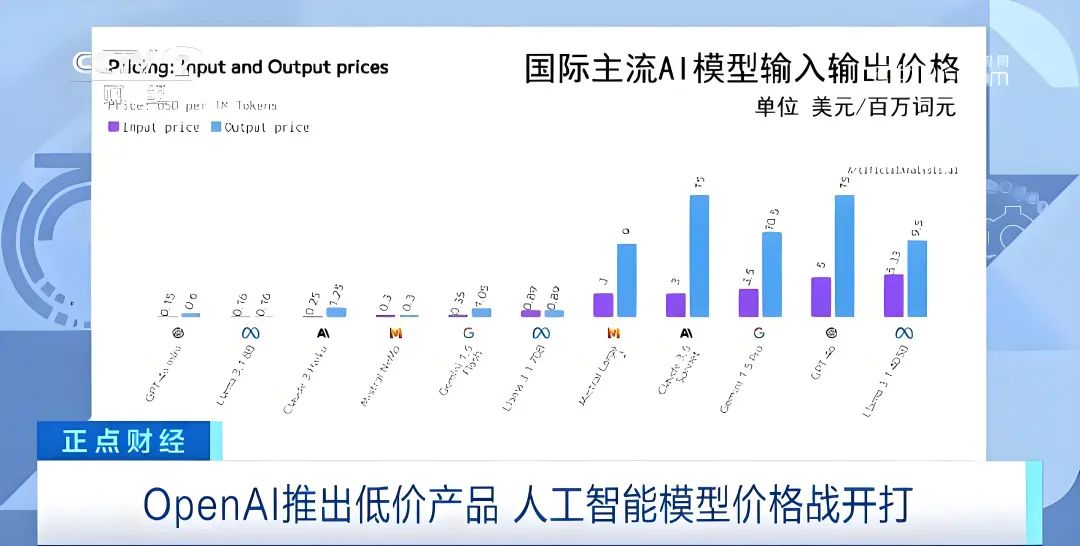

在人工智能(AI)领域,随着技术的不断突破和应用的日益广泛,各大科技公司纷纷推出自己的AI模型,以期在激烈的市场竞争中占据一席之地。然而,随着大模型训练成本的持续攀升,一场关于“模型开卷价格战”的较量悄然拉开帷幕。今年以来,国内外大模型赛道的价格战愈演愈烈。自去年以来,OpenAI已经进行了4次降价,国内方面,5月,字节跳动把定价降低了一个数量级,从以分计价进入以厘计价时代。根据火山引擎公布的价格计算,1元就能买到豆包主力模型的125万Tokens,大约是200万个汉字。7月5日,2024世界人工智能大会(WAIC 2024)期间,百度宣布文心旗舰款模型ERNIE 4.0和ERNIE 3.5大幅降价,ERNIE Speed、ERNIE Lite两款主力模型持续免费。而在这场战役中,小模型以其极致的性价比成为了新的杀手锏。近期,OpenAI推出的GPT-4o mini无疑成为了业界关注的焦点。这款成本效益极高的小型智能模型,不仅在多模态推理和文本智能方面展现出了卓越的能力,还以极低的价格优势,为智能技术的广泛应用开辟了新的道路。

大模型成本攀升,小模型应运而生

随着ChatGPT的空前热潮,2023年无可争议地成为了“大模型时代的璀璨元年”。在这一浪潮的引领下,众多行业巨头与知名企业纷纷下场,竞相推出自家的AI大模型产品,力求在这场技术盛宴中占据一席之地。然而,大模型的训练成本却如滚雪球般越滚越大,使得许多企业和机构望而却步。

训练大模型的训练和运行都要消耗大量能源,并且产生的巨大体量的碳排放。根据 Digital Information World 发布的报告显示,OpenAI 训练 GPT-3 耗电为 1.287 吉瓦时,大约相当于 120 个美国家庭 1 年的用电量。而这仅仅是训练 AI 模型的前期电力,仅占模型实际使用时所消耗电力的 40%。2023 年 1 月,OpenAI 仅一个月已耗用可能等同 17.5 万个丹麦家庭的全年用电量。谷歌 AI 每年耗电量达 2.3 太瓦时,相当于亚特兰大所有家庭 1 年用电量。这种高昂的成本不仅限制了AI技术的普及,也促使科技巨头们开始寻找新的突破口。

在这样的背景下,小模型以其低成本、高效益的特点应运而生。与大模型相比,小模型在保持一定性能的同时,大幅降低了训练和使用成本,成为了AI模型公司卷价格战的“利器”。

小模型大作为:Snorkel AI试验揭示AI效率新视角

Snorkel AI进行了一项实验,利用GPT-3进行微调与自建小模型训练法律领域的垂直模型,来比较在成本、效率及准确性上的差异。结果显示,尽管GPT-3以其庞大的参数量(达到小模型的1400倍)著称,但在训练一个针对法律领域的垂直模型时,其微调成本高达7418美元,而10000次推理还需额外支付173美元。相比之下,自行搭建的小模型不仅成本显著降低,仅为1915美元,10000次的推理成本更是微乎其微,仅0.26美元。

在准确性方面,两者表现相当接近,GPT-3微调模型的正确率为71.4%,而小模型达到了71.3%。这一发现挑战了“参数量即正义”的传统观念,提示我们在特定应用场景下,庞大的模型参数可能并非必要,甚至可能构成资源浪费。

当然,我们也不能说“参数量没用”,就如同我们使用GPT-4这类高级AI来执行诸如总结电子邮件这样的基础任务,无异于“杀鸡使用牛刀”——大材小用,既浪费资源也显得不切实际。在许多日常或专业领域的需求中,用户往往并不需要如此高规格的解决方案,小型、高效、成本友好的模型完全能够满足需求,甚至在某些方面表现更为出色。这一发现为AI技术的实际应用提供了新的思路,强调了“合适即为最好”的原则。

GPT-4o mini:小模型中的佼佼者

7月18日,OpenAI宣布推出GPT-4o mini,一个极具成本效益的小型模型。OpenAI把GPT-4o mini描述为,一个具有卓越文本智能和多模态推理能力的小模型。

GPT-4o mini 在 MMLU 上的得分为 82%,目前在LMSYS 排行榜上的聊天偏好方面优于 GPT-4 ,它的定价为每百万输入代币 15 美分,每百万输出代币 60 美分,比之前的 Frontier 型号便宜一个数量级,比 GPT-3.5 Turbo 便宜 60% 以上

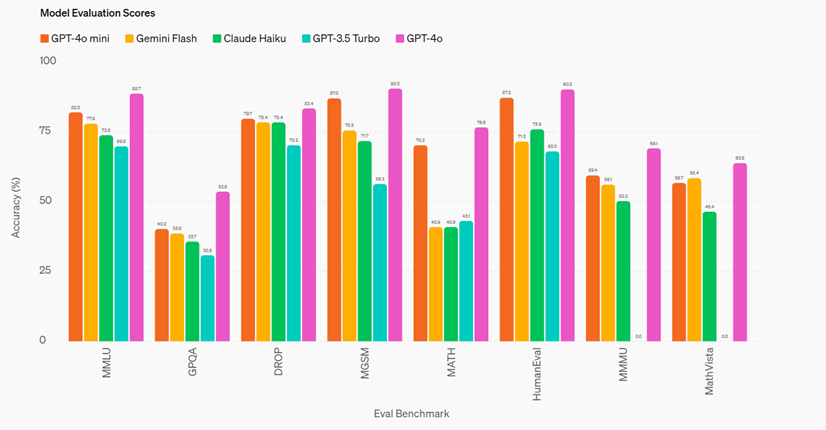

GPT-4o mini 已经在几个关键基准上进行了评估。

推理任务: GPT-4o mini 在涉及文本和视觉的推理任务上优于其他小型模型,在文本智能和推理基准 MMLU 上的得分为 82.0%,而 Gemini Flash 为 77.9%,Claude Haiku 为 73.8%。

数学和编码能力:GPT-4o mini 在数学推理和编码任务中表现出色,优于市场上之前的小型模型。在测量数学推理的 MGSM 上,GPT-4o mini 得分为 87.0%,而 Gemini Flash 得分为 75.5%,Claude Haiku 得分为 71.7%。在测量编码性能的 HumanEval 上,GPT-4o mini 得分为 87.2%,而 Gemini Flash 得分为 71.5%,Claude Haiku 得分为 75.9%。

多模态推理: GPT-4o mini 在多模态推理评估 MMMU 上也表现出色,得分为 59.4%,而 Gemini Flash 为 56.1%,Claude Haiku 为 50.2%。

小模型“战争”愈演愈烈

继GPT-4o mini、Mistral NeMo发布之后,苹果也入局了。苹果不久前发布了小模型DCLM,性能碾压Mistral-7B。DCLM模型包含两种参数规模——70亿和14亿,发布即开源,性能接近Llama 3、Gemma。

根据苹果ML小组研究科学家Vaishaal Shankar(也是DCLM研发人员)的说法,这是迄今为止性能最好的「真正开源」的模型,不仅有权重和训练代码,而且是基于开放数据集DCLM-Baseline。相比起模型性能,DCLM做出的「真正开源」的典范更加引人关注。

相较于众多科技巨头倾向于保持模型闭源,或采取部分开放策略,如仅发布模型代码或权重,苹果的这一做法显得尤为慷慨与开放。这种毫无保留的分享态度,赢得了广大网友的赞誉与好评,被视为在促进机器学习领域知识共享与技术创新方面树立了新的标杆。

小模型的发展前景

小模型作为人工智能领域的一股新兴力量,其发展前景极为广阔且充满潜力。随着技术的不断进步和算法的优化,为其在边缘计算、物联网设备、移动设备等多种场景下的广泛应用奠定了坚实基础:

市场潜力巨大:随着物联网、智能家居、移动设备等领域的快速发展,对轻量级、高效率的AI模型需求日益增长。小模型以其灵活性和低成本优势,将在这些领域发挥重要作用。

实时响应能力强:小模型具有较快的训练和推理速度,能够满足实时预测、实时控制等场景的需求。在自动驾驶、智能安防等领域,这一优势尤为明显。

隐私保护性好:小模型通常可以在本地运行,减少了数据上传至云端的风险,有助于保护用户隐私。

结语

小模型作为AI技术发展的新趋势,以其轻量级、高效率、易于部署等优势,在多个领域展现出巨大的潜力和价值。虽然小模型在精度和处理复杂任务方面和大模型存在差异,但其与大模型的互补关系为AI技术的发展提供了新的思路和方向。随着技术的不断进步和应用场景的拓展,小模型有望在AI领域发挥更加重要的作用,推动整个行业向更加高效、智能的方向发展。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?