为了做好运维面试路上的助攻手,特整理了上百道 【运维技术栈面试题集锦】 ,让你面试不慌心不跳,高薪offer怀里抱!

这次整理的面试题,小到shell、MySQL,大到K8s等云原生技术栈,不仅适合运维新人入行面试需要,还适用于想提升进阶跳槽加薪的运维朋友。

本份面试集锦涵盖了

- 174 道运维工程师面试题

- 128道k8s面试题

- 108道shell脚本面试题

- 200道Linux面试题

- 51道docker面试题

- 35道Jenkis面试题

- 78道MongoDB面试题

- 17道ansible面试题

- 60道dubbo面试题

- 53道kafka面试

- 18道mysql面试题

- 40道nginx面试题

- 77道redis面试题

- 28道zookeeper

总计 1000+ 道面试题, 内容 又全含金量又高

- 174道运维工程师面试题

1、什么是运维?

2、在工作中,运维人员经常需要跟运营人员打交道,请问运营人员是做什么工作的?

3、现在给你三百台服务器,你怎么对他们进行管理?

4、简述raid0 raid1raid5二种工作模式的工作原理及特点

5、LVS、Nginx、HAproxy有什么区别?工作中你怎么选择?

6、Squid、Varinsh和Nginx有什么区别,工作中你怎么选择?

7、Tomcat和Resin有什么区别,工作中你怎么选择?

8、什么是中间件?什么是jdk?

9、讲述一下Tomcat8005、8009、8080三个端口的含义?

10、什么叫CDN?

11、什么叫网站灰度发布?

12、简述DNS进行域名解析的过程?

13、RabbitMQ是什么东西?

14、讲一下Keepalived的工作原理?

15、讲述一下LVS三种模式的工作过程?

16、mysql的innodb如何定位锁问题,mysql如何减少主从复制延迟?

17、如何重置mysql root密码?

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

PersistentVolume(PV)是集群中已由管理员配置的一段网络存储。 集群中的资源就像一个节点是一个集群资源。 PV是诸如卷之类的卷插件,但是具有独立于使用PV的任何单个pod的生命周期。 该API对象包含存储的实现细节,即NFS,iSCSI或云提供商特定的存储系统。

PersistentVolumeClaim(PVC)是用户存储的请求。 它类似于pod。Pod消耗节点资源,PVC消耗存储资源。 pod可以请求特定级别的资源(CPU和内存)。 权限要求可以请求特定的大小和访问模式。

虽然PersistentVolumeClaims允许用户使用抽象存储资源,但是常见的是,用户需要具有不同属性(如性能)的PersistentVolumes,用于不同的问题。 管理员需要能够提供多种不同于PersistentVolumes,而不仅仅是大小和访问模式,而不会使用户了解这些卷的实现细节。 对于这些需求,存在StorageClass资源。

StorageClass为集群提供了一种描述他们提供的存储的“类”的方法。 不同的类可能映射到服务质量级别,或备份策略,或者由群集管理员确定的任意策略。 Kubernetes本身对于什么类别代表是不言而喻的。 这个概念有时在其他存储系统中称为“配置文件”

二、POD动态供给

动态供给主要是能够自动帮你创建pv,需要多大的空间就创建多大的pv。k8s帮助创建pv,创建pvc就直接api调用存储类来寻找pv。

如果是存储静态供给的话,会需要我们手动去创建pv,如果没有足够的资源,找不到合适的pv,那么pod就会处于pending等待的状态。而动态供给主要的一个实现就是StorageClass存储对象,其实它就是声明你使用哪个存储,然后帮你去连接,再帮你去自动创建pv。

三、POD使用RBD做为持久数据卷

安装与配置

RBD支持ReadWriteOnce,ReadOnlyMany两种模式

1、配置rbd-provisioner

cat >external-storage-rbd-provisioner.yaml<<EOF

apiVersion: v1

kind: ServiceAccount

metadata:

name: rbd-provisioner

namespace: kube-system

---

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: rbd-provisioner

rules:

- apiGroups: [""]

resources: ["persistentvolumes"]

verbs: ["get", "list", "watch", "create", "delete"]

- apiGroups: [""]

resources: ["persistentvolumeclaims"]

verbs: ["get", "list", "watch", "update"]

- apiGroups: ["storage.k8s.io"]

resources: ["storageclasses"]

verbs: ["get", "list", "watch"]

- apiGroups: [""]

resources: ["events"]

verbs: ["create", "update", "patch"]

- apiGroups: [""]

resources: ["endpoints"]

verbs: ["get", "list", "watch", "create", "update", "patch"]

- apiGroups: [""]

resources: ["services"]

resourceNames: ["kube-dns"]

verbs: ["list", "get"]

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: rbd-provisioner

subjects:

- kind: ServiceAccount

name: rbd-provisioner

namespace: kube-system

roleRef:

kind: ClusterRole

name: rbd-provisioner

apiGroup: rbac.authorization.k8s.io

---

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

name: rbd-provisioner

namespace: kube-system

rules:

- apiGroups: [""]

resources: ["secrets"]

verbs: ["get"]

---

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: rbd-provisioner

namespace: kube-system

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: rbd-provisioner

subjects:

- kind: ServiceAccount

name: rbd-provisioner

namespace: kube-system

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: rbd-provisioner

namespace: kube-system

spec:

selector:

matchLabels:

app: rbd-provisioner

replicas: 1

strategy:

type: Recreate

template:

metadata:

labels:

app: rbd-provisioner

spec:

containers:

- name: rbd-provisioner

image: quay.io/external_storage/rbd-provisioner:latest

env:

- name: PROVISIONER_NAME

value: ceph.com/rbd

serviceAccount: rbd-provisioner

EOF

kubectl apply -f external-storage-rbd-provisioner.yaml

2、配置storageclass

#1、创建pod时,kubelet需要使用rbd命令去检测和挂载pv对应的ceph image,所以要在所有的worker节点安装ceph客户端ceph-common。将ceph的ceph.client.admin.keyring和ceph.conf文件拷贝到master的/etc/ceph目录下

## 推送文件到master节点:

scp -rp ceph.client.admin.keyring ceph.conf root@192.168.0.10:/etc/ceph/

## 在k8s集群每个节点安装(下载ceph的源)

yum -y install ceph-common

#2、创建 osd pool 在ceph的mon或者admin节点

ceph osd pool create kube 16 16

[root@k8s-master ceph]# ceph osd lspools

1 .rgw.root

2 default.rgw.control

3 default.rgw.meta

4 default.rgw.log

5 rbd

6 kube

7 cephfs-data

8 cephfs-metadata

#3、创建k8s访问ceph的用户 在ceph的mon或者admin节点

ceph auth get-or-create client.kube mon 'allow r' osd 'allow class-read object\_prefix rbd\_children, allow rwx pool=kube' -o ceph.client.kube.keyring

#4、查看key 在ceph的mon或者admin节点和kube用户

ceph auth get-key client.admin

AQBQhrJeRHJmLxAATSxU4vjf79KgJpVkNb+VsQ==

ceph auth get-key client.kube

AQCQqztfSQNWFxAAdBmLqhJ/thboY0vGcZ7ixQ==

#5、创建 admin secret(使用admin的key)

kubectl create secret generic ceph-secret --type="kubernetes.io/rbd" \

--from-literal=key=AQBQhrJeRHJmLxAATSxU4vjf79KgJpVkNb+VsQ== \

--namespace=kube-system

#6、在 default 命名空间创建pvc用于访问ceph的 secret(使用kube用户的key)

kubectl create secret generic ceph-user-secret --type="kubernetes.io/rbd" \

--from-literal=key=AQCQqztfSQNWFxAAdBmLqhJ/thboY0vGcZ7ixQ== \

--namespace=default

[root@k8s-master ceph]# kubectl get secret

NAME TYPE DATA AGE

ceph-user-secret kubernetes.io/rbd 1 30s

3、配置StorageClass

cat >storageclass-ceph-rdb.yaml<<EOF

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: dynamic-ceph-rdb

provisioner: ceph.com/rbd

parameters:

monitors: 192.168.0.6:6789,192.168.0.7:6789,192.168.0.8:6789

adminId: admin

adminSecretName: ceph-secret

adminSecretNamespace: kube-system

pool: kube

userId: kube

userSecretName: ceph-user-secret

fsType: ext4

imageFormat: "2"

imageFeatures: "layering"

EOF

4、创建yaml

kubectl apply -f storageclass-ceph-rdb.yaml

5、查看sc

[root@k8s-master ceph]# kubectl get sc

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE

dynamic-ceph-rdb ceph.com/rbd Delete Immediate false 11s

测试使用

1、创建pvc测试

cat >ceph-rdb-pvc-test.yaml<<EOF

kind: PersistentVolumeClaim

apiVersion: v1

metadata:

name: ceph-rdb-claim

spec:

accessModes:

- ReadWriteOnce

storageClassName: dynamic-ceph-rdb

resources:

requests:

storage: 2Gi

EOF

kubectl apply -f ceph-rdb-pvc-test.yaml

2、查看

[root@k8s-master ceph]# kubectl get pvc

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

ceph-rdb-claim Bound pvc-214e462d-8da7-4234-ac68-3222900dd176 2Gi RWO dynamic-ceph-rdb 40s

[root@k8s-master ceph]# kubectl get pv

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

pvc-214e462d-8da7-4234-ac68-3222900dd176 2Gi RWO Delete Bound default/ceph-rdb-claim dynamic-ceph-rdb 10s

3、创建 nginx pod 挂载测试

cat >nginx-pod.yaml<<EOF

apiVersion: v1

kind: Pod

metadata:

name: nginx-pod1

labels:

name: nginx-pod1

spec:

containers:

- name: nginx-pod1

image: nginx

ports:

- name: web

containerPort: 80

volumeMounts:

- name: ceph-rdb

mountPath: /usr/share/nginx/html

volumes:

- name: ceph-rdb

persistentVolumeClaim:

claimName: ceph-rdb-claim

EOF

4、查看

[root@k8s-master ceph]# kubectl get pod

NAME READY STATUS RESTARTS AGE

nginx-pod1 1/1 Running 0 39s

#pod的IP为10.244.58.252

5、修改文件内容

kubectl exec -it nginx-pod1 -- /bin/sh -c 'echo this is from Ceph RBD!!! > /usr/share/nginx/html/index.html'

6、访问测试

[root@k8s-master ceph]# curl http://10.244.58.252

this is from Ceph RBD!!!

#查看rbd块设备的数据

[root@k8s-master ceph]# rados -p kube ls --all

rbd_data.67b206b8b4567.0000000000000102

rbd_data.67b206b8b4567.00000000000000a0

rbd_data.67b206b8b4567.000000000000010b

rbd_data.67b206b8b4567.0000000000000100

rbd_id.image02_clone01

rbd_id.kubernetes-dynamic-pvc-5fd1042a-e13e-11ea-9abe-1edcc60c1557

...

7、清理

kubectl delete -f nginx-pod.yaml

kubectl delete -f ceph-rdb-pvc-test.yaml

#rbd块中已经清除了

[root@k8s-master ceph]# rados -p kube ls --all

rbd_id.image02_clone01

rbd_header.2828baf9d30c7

rbd_directory

rbd_children

rbd_info

rbd_object_map.2828baf9d30c7

四、POD使用CephFS做为持久数据卷

CephFS方式支持k8s的pv的3种访问模式ReadWriteOnce,ReadOnlyMany ,ReadWriteMany

Ceph端创建CephFS pool

1、如下操作在ceph的mon或者admin节点

CephFS需要使用两个Pool来分别存储数据和元数据

ceph osd pool create fs_data 128

ceph osd pool create fs_metadata 128

ceph osd lspools

2、创建一个CephFS

ceph fs new cephfs fs_metadata fs_data

3、查看

ceph fs ls

部署 cephfs-provisioner

1、使用社区提供的cephfs-provisioner

cat >external-storage-cephfs-provisioner.yaml<<EOF

apiVersion: v1

kind: ServiceAccount

metadata:

name: cephfs-provisioner

namespace: kube-system

---

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: cephfs-provisioner

rules:

- apiGroups: [""]

resources: ["persistentvolumes"]

verbs: ["get", "list", "watch", "create", "delete"]

- apiGroups: [""]

resources: ["persistentvolumeclaims"]

verbs: ["get", "list", "watch", "update"]

- apiGroups: ["storage.k8s.io"]

resources: ["storageclasses"]

verbs: ["get", "list", "watch"]

- apiGroups: [""]

resources: ["events"]

verbs: ["create", "update", "patch"]

- apiGroups: [""]

resources: ["endpoints"]

verbs: ["get", "list", "watch", "create", "update", "patch"]

- apiGroups: [""]

resources: ["secrets"]

verbs: ["create", "get", "delete"]

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: cephfs-provisioner

subjects:

- kind: ServiceAccount

name: cephfs-provisioner

namespace: kube-system

roleRef:

**先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前在阿里**

**深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!**

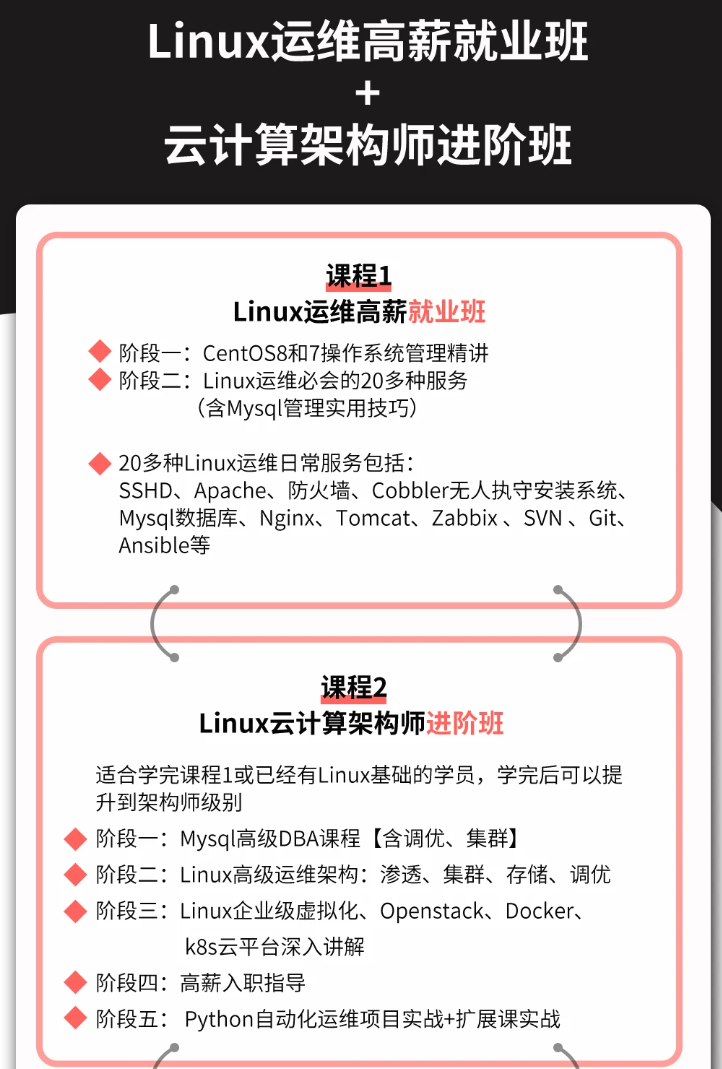

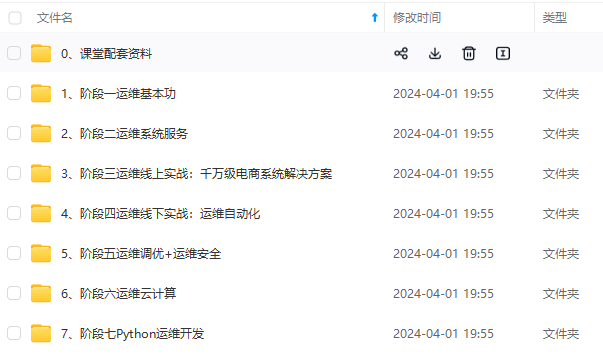

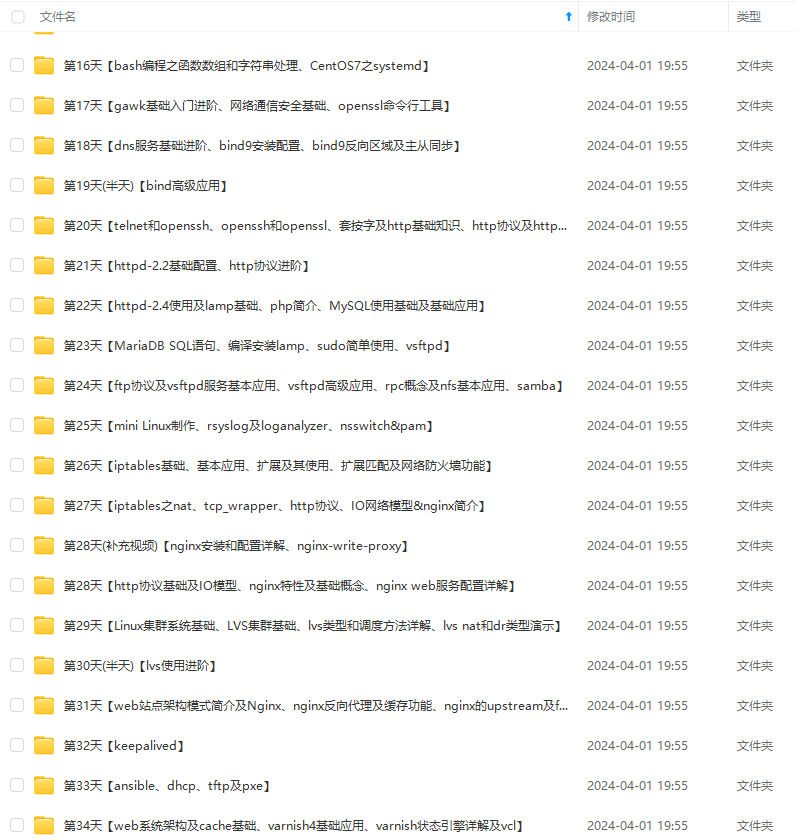

**因此收集整理了一份《2024年最新Linux运维全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。**

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上运维知识点,真正体系化!**

**由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[需要这份系统化的资料的朋友,可以点击这里获取!](https://bbs.csdn.net/forums/4f45ff00ff254613a03fab5e56a57acb)**

成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!**

**因此收集整理了一份《2024年最新Linux运维全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。**

[外链图片转存中...(img-oMiGUFqL-1715444302370)]

[外链图片转存中...(img-86Jw881k-1715444302371)]

[外链图片转存中...(img-90YgY4fe-1715444302371)]

[外链图片转存中...(img-IQgoL30Z-1715444302372)]

[外链图片转存中...(img-78pm0p0W-1715444302373)]

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上运维知识点,真正体系化!**

**由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[需要这份系统化的资料的朋友,可以点击这里获取!](https://bbs.csdn.net/forums/4f45ff00ff254613a03fab5e56a57acb)**

770

770

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?