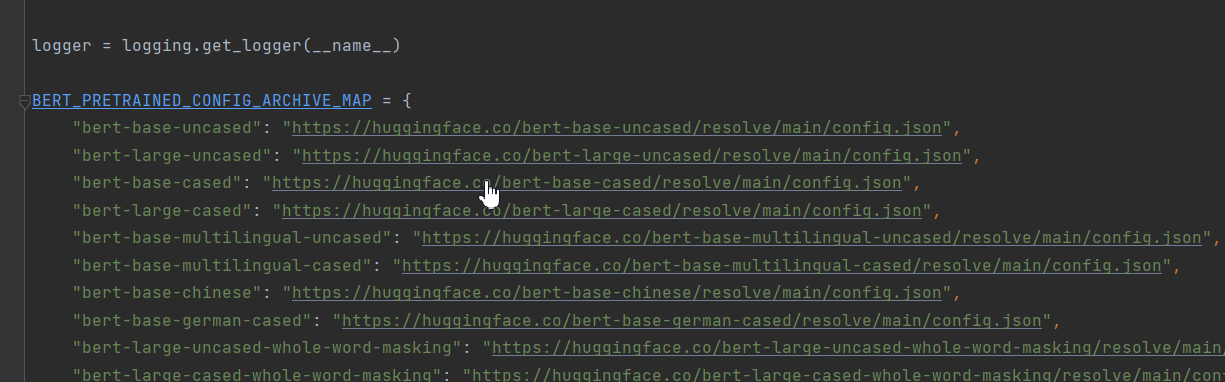

对68行的代码做修改。原始代码如下:

ALL_MODELS = sum((tuple(conf.pretrained_config_archive_map.keys()) for conf in (BertConfig, XLNetConfig, XLMConfig,

RobertaConfig, DistilBertConfig)), ())

修改为:

ALL_MODELS=tuple(BERT_PRETRAINED_CONFIG_ARCHIVE_MAP)

作者想把BertConfig、XLNetConfig、XLMConfig、RobertaConfig, DistilBertConfig等都导进来。可能是版本的升级pretrained_config_archive_map这个字段做了修改,以Bert为例,这个字段改为了‘BERT_PRETRAINED_CONFIG_ARCHIVE_MAP’。本次案例只是对Bert的讲解,所以我只保留了Bert的字段。

5、修改main()方法中的参数。

data_dir:数据集的路径,改为“./cnews”。

parser.add_argument(“–data_dir”, default=‘./cnews’, type=str, required=False,

help=“The input data dir. Should contain the .tsv files (or other data files) for the task.”)

model_type:模型的类型,MODEL_CLASSES的参数,本次使用bert。

parser.add_argument(“–model_type”, default=‘bert’, type=str, required=False,

help="Model type selected in the list: " + ", ".join(MODEL_CLASSES.keys()))

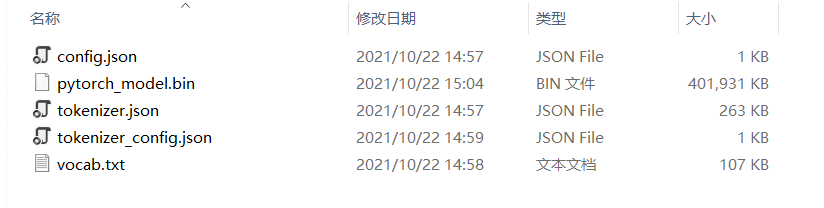

model_name_or_path:预训练模型的存放路径,设置为‘chinese_wwm_pytorch’。

parser.add_argument(“–model_name_or_path”, default=‘chinese_wwm_pytorch’, type=str, required=False,

help="Path to pre-trained model or shortcut name selected in the list: " + ", ".join(

ALL_MODELS))

这个文件下面的文件详见下图:

task_name:任务名称。我写的cnews

parser.add_argument(“–task_name”, default=‘cnews’, type=str, required=False,

help="The name of the task to train selected in the list: " + ", ".join(processors.keys()))

do_train:是否训练。需要训练则设置为true。

parser.add_argument(“–do_train”, default=True,action=‘store_true’,

help=“Whether to run training.”)

do_eval:是否验证,如果设置为true,则将outs的模型一一验证。和do_train可以同时配置为true,这样训练完成后就开始验证。

parser.add_argument(“–do_eval”,default=True, action=‘store_true’,

help=“Whether to run eval on the dev set.”)

evaluate_during_training:是否在训练期间验证。默认没有配置。如果需要配置,则将其设置为true。

parser.add_argument(“–evaluate_during_training”, action=‘store_true’,

help=“Rul evaluation during training at each logging step.”)

do_lower_case:是否转小写。使用uncased模型时需要设置。

parser.add_argument(“–do_lower_case”,action=‘store_true’,

help=“Set this flag if you are using an uncased model.”)

per_gpu_train_batch_size和per_gpu_eval_batch_size:batch_size大小,根据显卡合理设置。

parser.add_argument(“–per_gpu_train_batch_size”, default=4, type=int,

help=“Batch size per GPU/CPU for training.”)

parser.add_argument(“–per_gpu_eval_batch_size”, default=4, type=int,

help=“Batch size per GPU/CPU for evaluation.”)

learning_rate:学习率,默认设置即可。

parser.add_argument(“–learning_rate”, default=2e-5, type=float,

help=“The initial learning rate for Adam.”)

parser.add_argument(“–weight_decay”, default=0.0, type=float,

num_train_epochs:epochs大小。

parser.add_argument(“–num_train_epochs”, default=50.0, type=float,

help=“Total number of training epochs to perform.”)

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

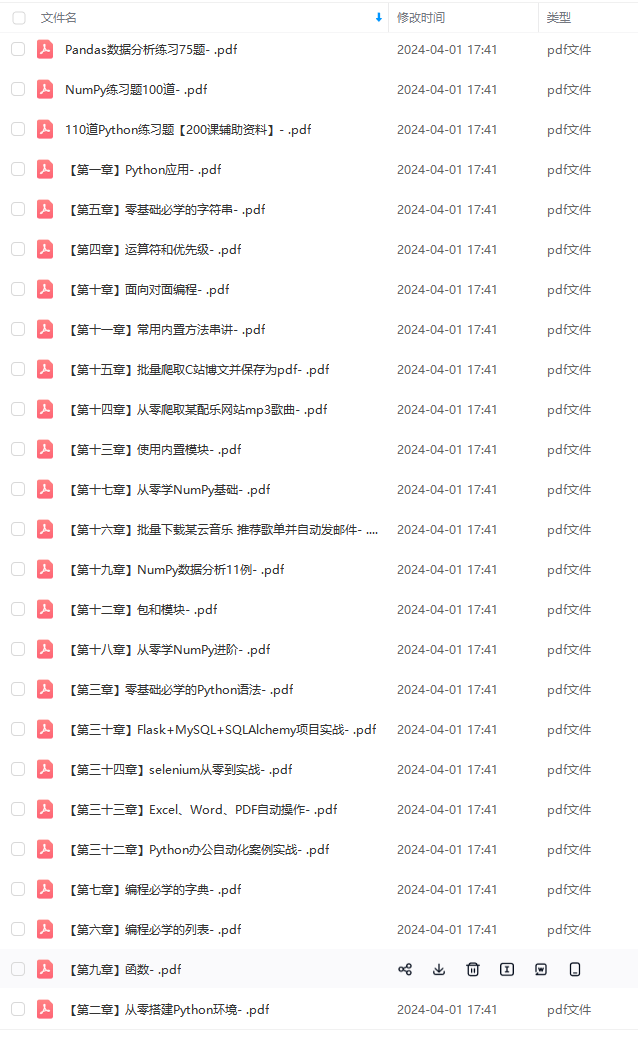

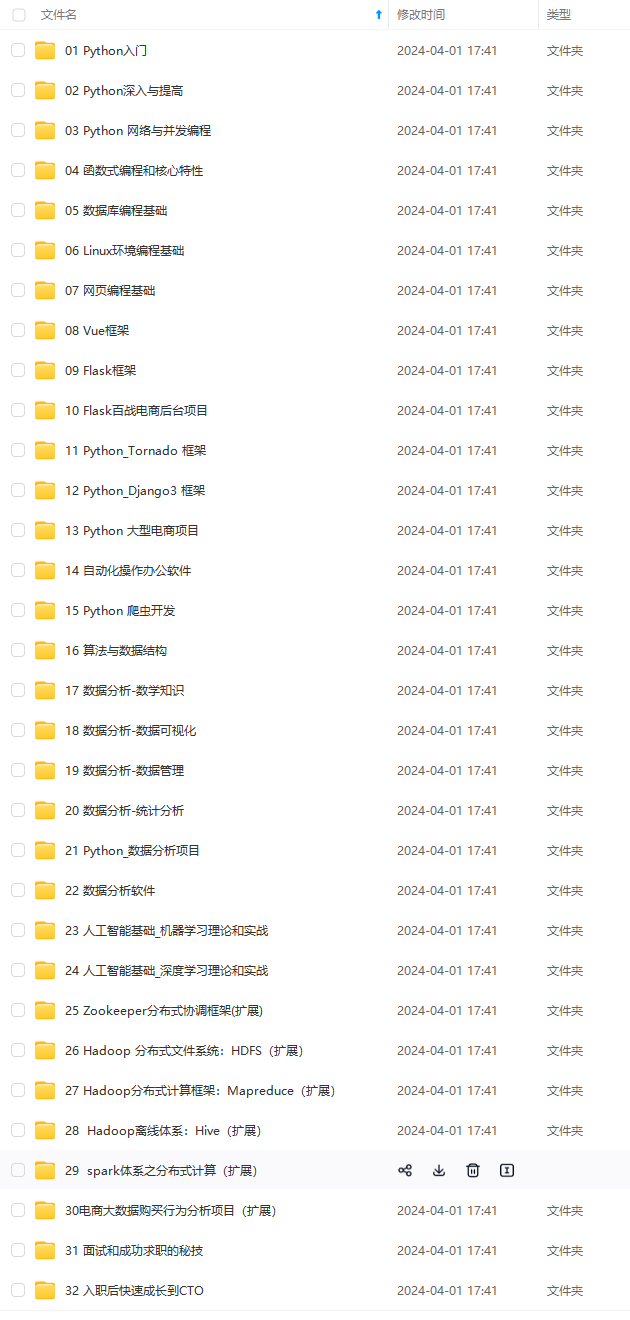

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

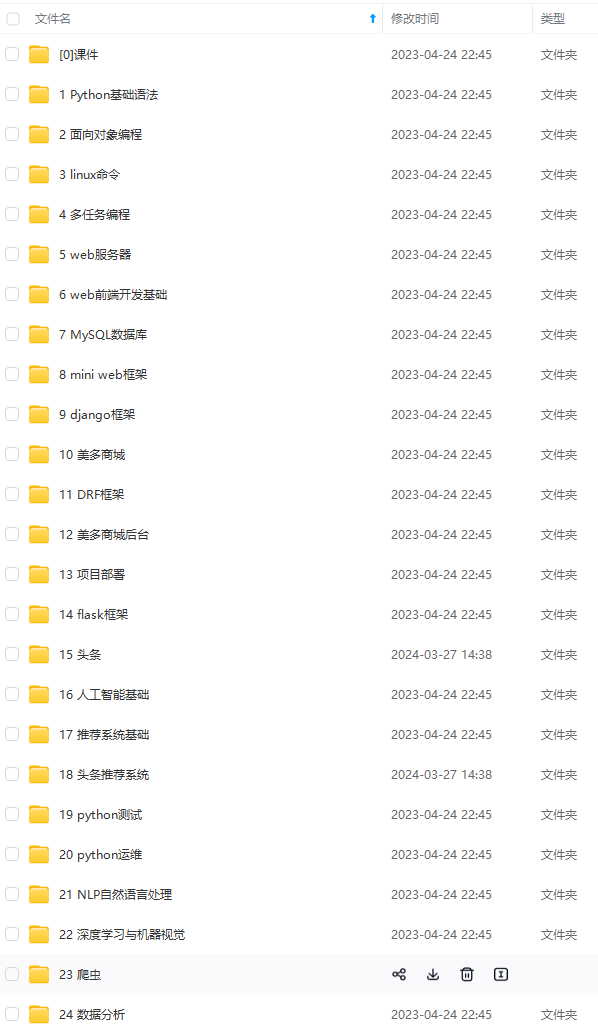

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注:Python)

blog.csdnimg.cn/img_convert/9f49b566129f47b8a67243c1008edf79.png)

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注:Python)

469

469

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?