print(self.detail_url, self.title)

self.get_detail()

self.chrome.find_element(By.CLASS_NAME,'u\_icon\_enArrowforward').click()

time.sleep(1)

self.page += 1

if self.page == 120:

break

#### 3.3.3获取景点的详细信息

>

> * 景点的详细信息有:景点名称、景点等级(1-5A)、景点地址、开放时间(有两种,我们采用下面的)、联系电话、景点介绍、景点图片等内容

> * 通过正则表达式获取,详细代码如下:

> * 并每次获取详细信息之后,将信息保存到mysql数据库中

>

>

>

def get\_detail(self):

detail_con = requests.get(self.detail_url, verify=False, headers=self.headers).text

# time.sleep(2)

'''使用正则获取信息'''

self.title = ''.join(re.findall(r'<div class="title"><h1>(.\*?)<', detail_con, re.DOTALL))

print('景点名称:'+self.title)

#self.rank = ''.join(re.findall(r'rankText">(.\*?)<', detail\_con, re.DOTALL))

self.address = ''.join(re.findall(r'地址</p><p class="baseInfoText">(.\*?)<', detail_con, re.DOTALL))

self.mobile = ''.join(re.findall(r'官方电话</p><p class="baseInfoText">(.\*?)<', detail_con, re.DOTALL))

self.quality_grade= ''.join(re.findall(r'<div class="titleTips"><span>(.\*?)<!--', detail_con, re.DOTALL))

#self.openTime = ''.join(re.findall(r'开放时间</div><div class="moduleContent">(.\*?)<', detail\_con, re.DOTALL))

first_three_characters = self.address[:3]

print('所在省份城市:'+'广东省'+first_three_characters)

print('详细地址:'+self.address)

#print('开放时间:'+self.openTime)

print('电话:'+self.mobile)

print('等级:'+self.quality_grade)

if self.quality_grade=='':

self.quality_grade=0

'''使用xpath获取信息'''

ret = etree.HTML(detail_con)

desc_cons = ret.xpath('//div[@class="detailModule normalModule"]//div[@class="moduleContent"]')

desc_titles = ret.xpath('//div[@class="detailModule normalModule"]//div[@class="moduleTitle"]')

desc_list = []

desc_title_list = []

for d in desc_cons:

des = ''.join(d.xpath('.//text()'))

desc_list.append(des)

for d in desc_titles:

des = ''.join(d.xpath('.//text()'))

desc_title_list.append(des)

desc_dict = dict(zip(desc_title_list, desc_list))

#print(desc\_dict)

first_value = list(desc_dict.values())[:2] # 获取前两个值

if len(first_value) >= 1:

introduction = first_value[0]

else:

introduction = ''

if len(first_value) >= 2:

opening_hours = first_value[1]

else:

opening_hours = ''

print('介绍:'+introduction)

print('开放时间:'+ opening_hours)

'''获取图片链接'''

img_list = []

imgs = re.findall(r'background-image:url\((.\*?)\)', detail_con, re.DOTALL)

for img in imgs:

'''匹配到的同一张图片会有两种尺寸,我们只要大图,所以把尺寸为521\*391的匹配出来即可'''

image = re.search(r'521\_391', img)

if image:

img_list.append(img)

print(",".join(img_list))

conn = pymysql.connect(host='localhost', user='root', password='root',

database='travel\_ams', charset='utf8mb4')

cursor = conn.cursor()

sql = "INSERT INTO ams\_attraction (attraction\_name, quality\_grade, province\_city, location, open\_hour, phone, introduction, images, add\_time) VALUES (%s, %s, %s, %s, %s, %s, %s, %s, %s)"

values = (self.title, self.quality_grade, '广东省'+first_three_characters, self.address, opening_hours, self.mobile, introduction,",".join(img_list) ,datetime.datetime.now().strftime("%Y-%m-%d %H:%M:%S"))

cursor.execute(sql, values)

conn.commit()

conn.close()

#self.get\_ticket()

### 3.4数据库设计

>

> travel\_ams数据库的ams\_attraction表

>

>

>

| 字段名 | 字段类型 | 是否为主键 | 是否有唯一约束 | 是否有非空约束 | 注释 |

| --- | --- | --- | --- | --- | --- |

| attraction\_id | int | 是 | | | 景点id,自增 |

| attraction\_name | varchar(20) | | | | 景点名称 |

| resource\_type\_id | int | | | | 景点资源类型id |

| quality\_grade | int | | | | 景点等级 |

| province\_city | varchar(20) | | | | 景点所在省份城市 |

| location | varchar(1000) | | | | 详细位置 |

| open\_hour | varchar(1000) | | | | 开放时间 |

| phone | varchar(1000) | | | | 电话 |

| introduction | varchar(10000) | | | | 景点介绍 |

| images | varchar(1000) | | | | 景点图片列表 |

| staus | int | | | | 状态【1为显示,0为不显示】 |

| add\_time | datetime | | | | 添加时间 |

| update\_time | datetime | | | | 修改时间 |

>

> 创建表语句如下:

>

>

>

CREATE TABLE ams_attraction (

attraction_id INT PRIMARY KEY AUTO_INCREMENT COMMENT ‘景点id,自增’,

attraction_name VARCHAR(20) COMMENT ‘景点名称’,

resource_type_id INT COMMENT ‘景点资源类型id’,

province_city VARCHAR(20) COMMENT ‘景点所在省份城市’,

location VARCHAR(1000) COMMENT ‘详细位置’,

open_hour VARCHAR(1000) COMMENT ‘开放时间’,

phone VARCHAR(1000) COMMENT ‘电话’,

introduction VARCHAR(10000) COMMENT ‘景点介绍’,

images VARCHAR(1000) COMMENT ‘景点图片列表’,

status INT COMMENT ‘状态【1为显示,0为不显示】’,

add_time DATETIME COMMENT ‘添加时间’,

update_time DATETIME COMMENT ‘修改时间’

);

### 3.5全部代码

>

> * 执行该main方法,即可完成导入指定访问路径的景点数据

> * 可以在控制台查询是否导入成功

>

>

>

import pandas

import re

import time

import requests

import urllib3

from lxml import etree

from selenium.webdriver import Chrome

from selenium.webdriver.chrome.options import Options

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.common.by import By

import pymysql

import datetime

urllib3.disable_warnings(urllib3.exceptions.InsecureRequestWarning)

class Jy_jd(object):

def __init__(self):

options = Options()

options.add_argument(‘–headless’)

service = Service()

self.chrome = Chrome(service=service)

self.chrome.get(

‘https://huodong.ctrip.com/things-to-do/list?pagetype=city&citytype=dt&keyword=%E6%A2%85%E5%B7%9E&id=523&name=%E6%A2%85%E5%B7%9E&pshowcode=Ticket2&kwdfrom=srch&bookingtransactionid=1711160613361_6064’)

time.sleep(3)

self.page = 1

self.headers = {

‘cookie’: ‘suid=lh/P1+4RKuhAYg684ErS+g==; suid=lh/P1+4RKuhAYg684ErS+g==’,

‘user-agent’: ‘Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.116 Safari/537.36’,

}

#获取景点请求路径

def get\_url(self):

while True:

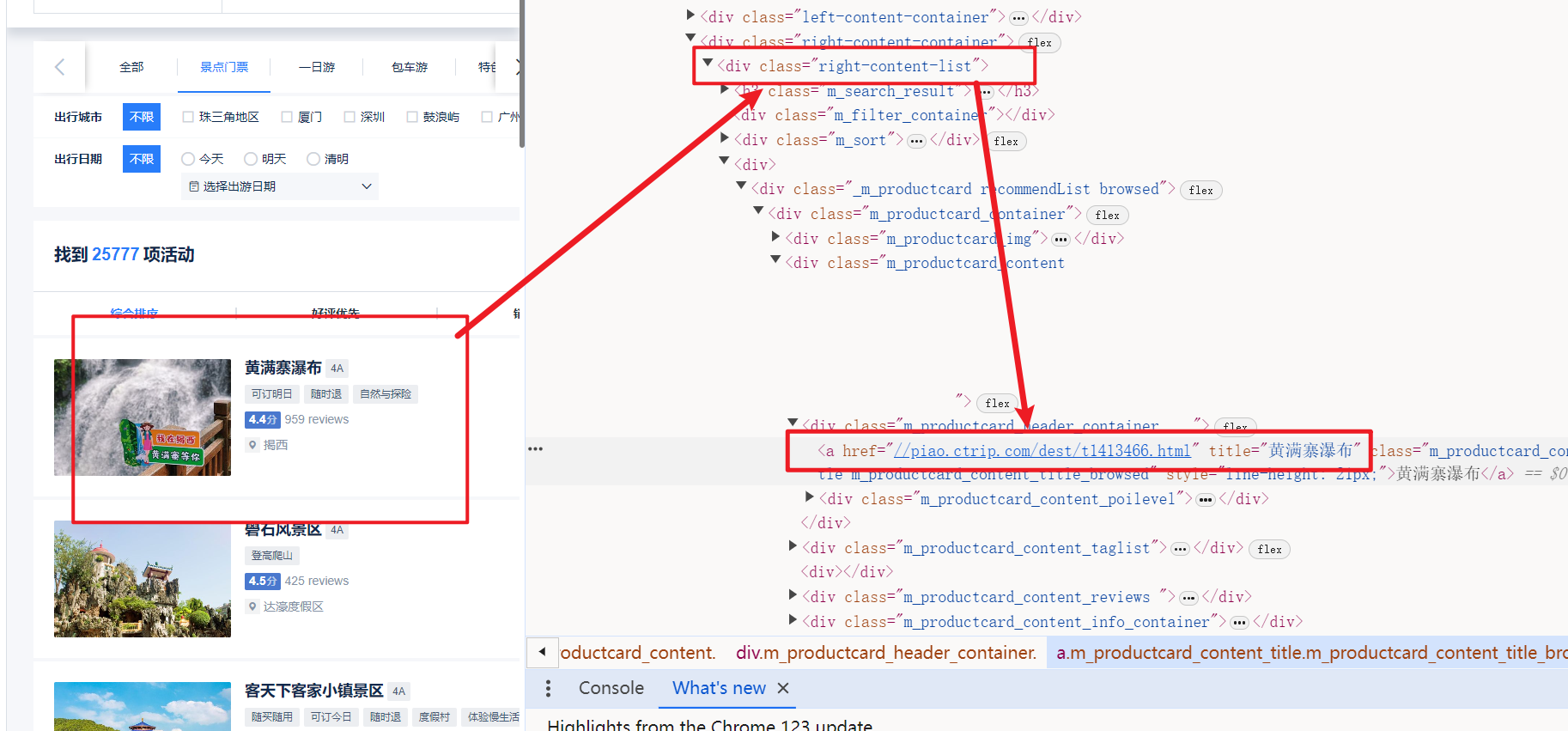

content = self.chrome.find_element(By.CLASS_NAME, "right-content-list").get_attribute('innerHTML')

cons = re.findall(r'href="(.\*?)" title="(.\*?)"', content)

for con in cons:

self.detail_url = 'https:' + con[0]

self.title = con[1]

print(self.detail_url, self.title)

self.get_detail()

self.chrome.find_element(By.CLASS_NAME,'u\_icon\_enArrowforward').click()

time.sleep(1)

self.page += 1

if self.page == 120:

break

def get\_detail(self):

detail_con = requests.get(self.detail_url, verify=False, headers=self.headers).text

# time.sleep(2)

'''使用正则获取信息'''

self.title = ''.join(re.findall(r'<div class="title"><h1>(.\*?)<', detail_con, re.DOTALL))

print('景点名称:'+self.title)

#self.rank = ''.join(re.findall(r'rankText">(.\*?)<', detail\_con, re.DOTALL))

self.address = ''.join(re.findall(r'地址</p><p class="baseInfoText">(.\*?)<', detail_con, re.DOTALL))

self.mobile = ''.join(re.findall(r'官方电话</p><p class="baseInfoText">(.\*?)<', detail_con, re.DOTALL))

self.quality_grade= ''.join(re.findall(r'<div class="titleTips"><span>(.\*?)<!--', detail_con, re.DOTALL))

#self.openTime = ''.join(re.findall(r'开放时间</div><div class="moduleContent">(.\*?)<', detail\_con, re.DOTALL))

first_three_characters = self.address[:3]

print('所在省份城市:'+'广东省'+first_three_characters)

print('详细地址:'+self.address)

#print('开放时间:'+self.openTime)

print('电话:'+self.mobile)

print('等级:'+self.quality_grade)

if self.quality_grade=='':

self.quality_grade=0

'''使用xpath获取信息'''

ret = etree.HTML(detail_con)

desc_cons = ret.xpath('//div[@class="detailModule normalModule"]//div[@class="moduleContent"]')

desc_titles = ret.xpath('//div[@class="detailModule normalModule"]//div[@class="moduleTitle"]')

desc_list = []

desc_title_list = []

for d in desc_cons:

des = ''.join(d.xpath('.//text()'))

desc_list.append(des)

for d in desc_titles:

des = ''.join(d.xpath('.//text()'))

desc_title_list.append(des)

desc_dict = dict(zip(desc_title_list, desc_list))

#print(desc\_dict)

first_value = list(desc_dict.values())[:2] # 获取前两个值

if len(first_value) >= 1:

introduction = first_value[0]

else:

introduction = ''

if len(first_value) >= 2:

opening_hours = first_value[1]

else:

opening_hours = ''

print('介绍:'+introduction)

print('开放时间:'+ opening_hours)

'''获取图片链接'''

img_list = []

imgs = re.findall(r'background-image:url\((.\*?)\)', detail_con, re.DOTALL)

for img in imgs:

'''匹配到的同一张图片会有两种尺寸,我们只要大图,所以把尺寸为521\*391的匹配出来即可'''

image = re.search(r'521\_391', img)

if image:

img_list.append(img)

print(",".join(img_list))

conn = pymysql.connect(host='localhost', user='root', password='root',

database='travel\_ams', charset='utf8mb4')

cursor = conn.cursor()

sql = "INSERT INTO ams\_attraction (attraction\_name, quality\_grade, province\_city, location, open\_hour, phone, introduction, images, add\_time) VALUES (%s, %s, %s, %s, %s, %s, %s, %s, %s)"

values = (self.title, self.quality_grade, '广东省'+first_three_characters, self.address, opening_hours, self.mobile, introduction,",".join(img_list) ,datetime.datetime.now().strftime("%Y-%m-%d %H:%M:%S"))

cursor.execute(sql, values)

conn.commit()

conn.close()

#self.get\_ticket()

#获取门票

def get\_ticket(self):

id = self.detail_url.split('/')[-1]

print(id)

ticket_url = f'https://piao.ctrip.com/ticket/dest/{id}?onlyContent=true&onlyShelf=true'

ticket_res = requests.get(ticket_url, verify=False, headers=self.headers).text

# time.sleep(1)

ticket_ret = etree.HTML(ticket_res)

ticket = ticket_ret.xpath('//table[@class="ticket-table"]//div[@class="ttd-fs-18"]/text()')

price = ticket_ret.xpath(

'//table[@class="ticket-table"]//td[@class="td-price"]//strong[@class="ttd-fs-24"]/text()')

print(ticket)

print(price)

'''拿到的列表里可能存在不确定数量的空值,所以这里用while True把空值全部删除,这样才可以确保门票种类与价格正确对应上'''

while True:

try:

ticket.remove(' ')

except:

break

while True:

try:

price.remove(' ')

except:

break

'''

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注Python)

/img-blog.csdnimg.cn/img_convert/6c361282296f86381401c05e862fe4e9.png)

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注Python)

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?