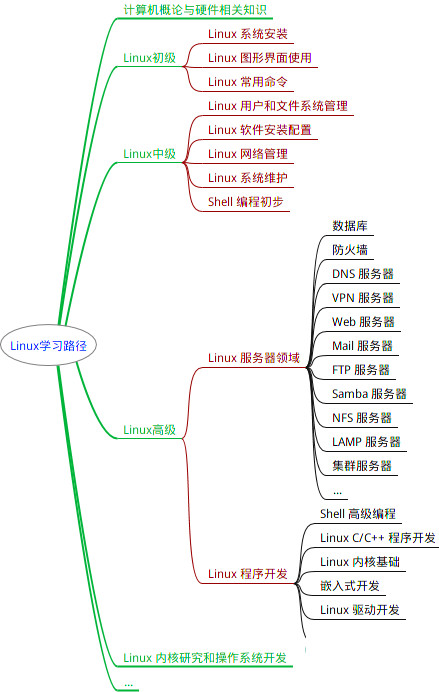

最全的Linux教程,Linux从入门到精通

======================

-

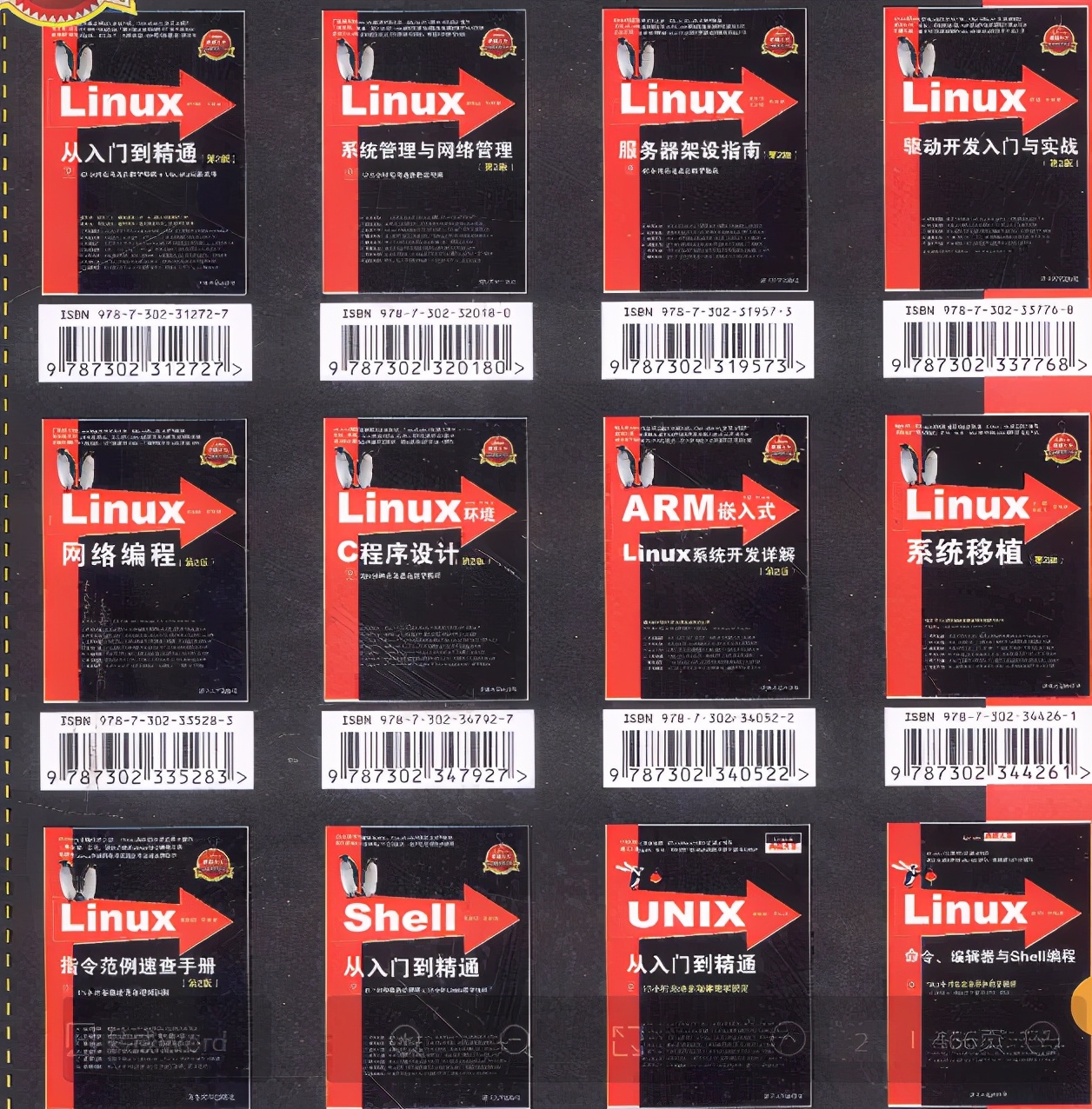

linux从入门到精通(第2版)

-

Linux系统移植

-

Linux驱动开发入门与实战

-

LINUX 系统移植 第2版

-

Linux开源网络全栈详解 从DPDK到OpenFlow

第一份《Linux从入门到精通》466页

====================

内容简介

====

本书是获得了很多读者好评的Linux经典畅销书**《Linux从入门到精通》的第2版**。本书第1版出版后曾经多次印刷,并被51CTO读书频道评为“最受读者喜爱的原创IT技术图书奖”。本书第﹖版以最新的Ubuntu 12.04为版本,循序渐进地向读者介绍了Linux 的基础应用、系统管理、网络应用、娱乐和办公、程序开发、服务器配置、系统安全等。本书附带1张光盘,内容为本书配套多媒体教学视频。另外,本书还为读者提供了大量的Linux学习资料和Ubuntu安装镜像文件,供读者免费下载。

本书适合广大Linux初中级用户、开源软件爱好者和大专院校的学生阅读,同时也非常适合准备从事Linux平台开发的各类人员。

需要《Linux入门到精通》、《linux系统移植》、《Linux驱动开发入门实战》、《Linux开源网络全栈》电子书籍及教程的工程师朋友们劳烦您转发+评论

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

目的:我要在我的三台虚拟机(Server01、Server02、Server03)上进行Linux环境下JDK安装。

前提:先登录打开虚拟机,通过XShell进行连接,下载好Xftp工具来操作。(如果下载不了也可以试试360软件管家进行下载)

XShell:与我们VMware Workstation Pro的虚拟机连接后,可以实现复制粘贴,而且界面更加好看。

Xftp:可以将我们自己电脑上面的压缩包,通过它添加到我们的虚拟机中,起到一个桥梁的作用。

(一)Linux环境下JDK安装

1.在Xftp新建一个会话

2.将压缩包传入虚拟机(资料如下)

百度网盘:

链接:https://pan.baidu.com/s/1ceN110N6mMk4eNR5Tk4xwA?pwd=aj93

提取码:aj93

3.验证

传输完成后,我们回到XShell的Server01界面,到/opt/目录下看看我的的压缩包是否传输成功

4.解压文件:

输入tar -zxvf jdk…(按Tab建自动补全)

5.编辑系统环境变量配置文件

输入命令vi /etc/profile,通过方向键光标移到最底下,按o进入编辑模式复制下面代码到里面。

export JAVA_HOME=/opt/jdk1.8.0_311

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

粘贴后,按esc键,“:”+“wq”,保存并退出。

6.生效环境变量

需要在所有服务器执行

source /etc/profile

7.查看是否安装配置成功,查看java版本:

java -version

(二)Hadoop集群部署

前提:已利用Xftp工具将压缩包传至虚拟机的/opt/中。

(先在Server01的XShell界面上进行安装Hadooop环境,Hadoop集群配置,将这些操作步骤完成后,通过已经配置好的ssh免密,使Server02和Server03快速地完成Hadoop集群部署)

##安装Hadooop环境

(当前在Server01的XShell界面)

1.解压文件

tar -zxvf hadoop版本.tar.gz

2.编辑系统环境变量配置文件

vi /etc/profile

export HADOOP_HOME=/opt/hadoop-3.1.3

export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:$PATH

3.生效环境变量

需要在所有服务器执行

source /etc/profile

4.查看是否安装配置成功,查看Hadoop版本

hadoop version

##Hadoop集群配置

(当前在Server01的XShell界面)

1. 配置Hadoop集群主节点

① 进入Hadoop配置文件文档

cd /opt/hadoop-3.1.3/etc/hadoop/

② 修改hadoop-env.sh文件

vi hadoop-env.sh

随便找一个前面没有#的地方,按i,黏贴下面内容:

export JAVA_HOME=/opt/jdk1.8.0_311

esc键,冒号加wq退出

③ 修改core-site.xml文件

vi core-site.xml

按i进入编辑模式粘贴下面代码:

<!-- 用于设置Hadoop的文件系统,由URI指定 -->

<configuration>

<!-- 用于设置Hadoop的文件系统,由URI指定 -->

<property>

<!-- 用于指定namenode地址在主节点机器上 -->

<name>fs.defaultFS</name>

<value>hdfs://Server01:9000</value>

</property>

<!-- 配置Hadoop的临时目录,默认/tmp/hadoop-${user.name} -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop-3.1.3/tmp</value>

</property>

</configuration>

esc+:+wq保存退出

④ 修改hdfs-site.xml文件

vi hdfs-site.xml

在编辑前删除最后两行,按o后粘贴,按esc+:+wq

<configuration>

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!-- secondary namenodes所在主机的IP和端口 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>Server02:50090</value>

</property>

</configuration>

⑤ 修改mapred-site.xml文件

vi mapred-site.xml

在编辑前删除最后两行,按o后粘贴,按esc+:+wq

<configuration>

<!-- 指定MapReduce运行时框架,这里指定在YARN上,默认时local -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

⑥ 修改yarn-site.xml文件

vi yarn-site.xml

在编辑前删除最后三行,按o后粘贴,按esc+:+wq

<configuration>

<!-- 指定YARN集群的管理者(ResourceManager)的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>Server01</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

⑦ 修改slaves文件

vi workers

删除localhost,如果没有他就直接添加以下内容:

下面的这个不是固定的,这三个是我三个虚拟机的名字,按照需要设置。

Server01

Server02

Server03

因为我们是用root登录的,所以我们需要进行以下操作:

cd /opt/hadoop-3.1.3/sbin/

①

vi start-dfs.sh

找一行没有#的,按o把下面的代码粘贴进去,按esc键+:+wq

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

②

vi stop-dfs.sh

找一行没有#的,按o把下面的代码粘贴进去,按esc键+:+wq

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

③

vi start-yarn.sh

找一行没有#的,按o把下面的代码粘贴进去,按esc键+:+wq

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

④

vi stop-yarn.sh

找一行没有#的,按o把下面的代码粘贴进去,按esc键+:+wq

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

**2.**分发文件

将集群主节点的配置文件分发到其他子节点

基于ssh免密已经设置好的情况下,我们在Server01的界面执行:

scp /etc/profile Server02:/etc/profile

scp /etc/profile Server03:/etc/profile

scp -r /opt/jdk1.8.0_311 Server02:/opt/

scp -r /opt/jdk1.8.0_311 Server03:/opt/

scp -r /opt/hadoop-3.1.3 Server02:/opt

scp -r /opt/hadoop-3.1.3 Server03:/opt/

文件下发到Server02、Server03后,我们可以cd /opt/后ls

看看文件是否存在

生效环境变量,在三台虚拟机上执行命令

source /etc/profile

##Hadoop集群测试

(当前在Server01的XShell界面)

cd /opt/

1.格式化文件系统

首次使用需要格式化文件系统

hadoop namenode -format

2.启动和关闭Hadoop集群

start-all.sh

3.查看是否启动,在三台虚拟机上执行命令,进行观察

jps

到此我们的Hadoop的配置已全部完成。

(三)Zookeeper部署

1. 上传并解压HBase安装包

cd /opt/

tar -zxvf apache-zookeeper-3.5.9-bin.tar.gz

2.修改Zookeeper的配置文件

cd /opt/apache-zookeeper-3.5.9-bin/conf/

cp zoo_sample.cfg zoo.cfg

vi zoo.cfg

3.修改环境变量

vi /etc/profile

4.分发文件

为了做好运维面试路上的助攻手,特整理了上百道 【运维技术栈面试题集锦】 ,让你面试不慌心不跳,高薪offer怀里抱!

这次整理的面试题,小到shell、MySQL,大到K8s等云原生技术栈,不仅适合运维新人入行面试需要,还适用于想提升进阶跳槽加薪的运维朋友。

本份面试集锦涵盖了

- 174 道运维工程师面试题

- 128道k8s面试题

- 108道shell脚本面试题

- 200道Linux面试题

- 51道docker面试题

- 35道Jenkis面试题

- 78道MongoDB面试题

- 17道ansible面试题

- 60道dubbo面试题

- 53道kafka面试

- 18道mysql面试题

- 40道nginx面试题

- 77道redis面试题

- 28道zookeeper

总计 1000+ 道面试题, 内容 又全含金量又高

- 174道运维工程师面试题

1、什么是运维?

2、在工作中,运维人员经常需要跟运营人员打交道,请问运营人员是做什么工作的?

3、现在给你三百台服务器,你怎么对他们进行管理?

4、简述raid0 raid1raid5二种工作模式的工作原理及特点

5、LVS、Nginx、HAproxy有什么区别?工作中你怎么选择?

6、Squid、Varinsh和Nginx有什么区别,工作中你怎么选择?

7、Tomcat和Resin有什么区别,工作中你怎么选择?

8、什么是中间件?什么是jdk?

9、讲述一下Tomcat8005、8009、8080三个端口的含义?

10、什么叫CDN?

11、什么叫网站灰度发布?

12、简述DNS进行域名解析的过程?

13、RabbitMQ是什么东西?

14、讲一下Keepalived的工作原理?

15、讲述一下LVS三种模式的工作过程?

16、mysql的innodb如何定位锁问题,mysql如何减少主从复制延迟?

17、如何重置mysql root密码?

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

么工作的?

3、现在给你三百台服务器,你怎么对他们进行管理?

4、简述raid0 raid1raid5二种工作模式的工作原理及特点

5、LVS、Nginx、HAproxy有什么区别?工作中你怎么选择?

6、Squid、Varinsh和Nginx有什么区别,工作中你怎么选择?

7、Tomcat和Resin有什么区别,工作中你怎么选择?

8、什么是中间件?什么是jdk?

9、讲述一下Tomcat8005、8009、8080三个端口的含义?

10、什么叫CDN?

11、什么叫网站灰度发布?

12、简述DNS进行域名解析的过程?

13、RabbitMQ是什么东西?

14、讲一下Keepalived的工作原理?

15、讲述一下LVS三种模式的工作过程?

16、mysql的innodb如何定位锁问题,mysql如何减少主从复制延迟?

17、如何重置mysql root密码?

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

851

851

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?