先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年最新Python全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Python知识点,真正体系化!

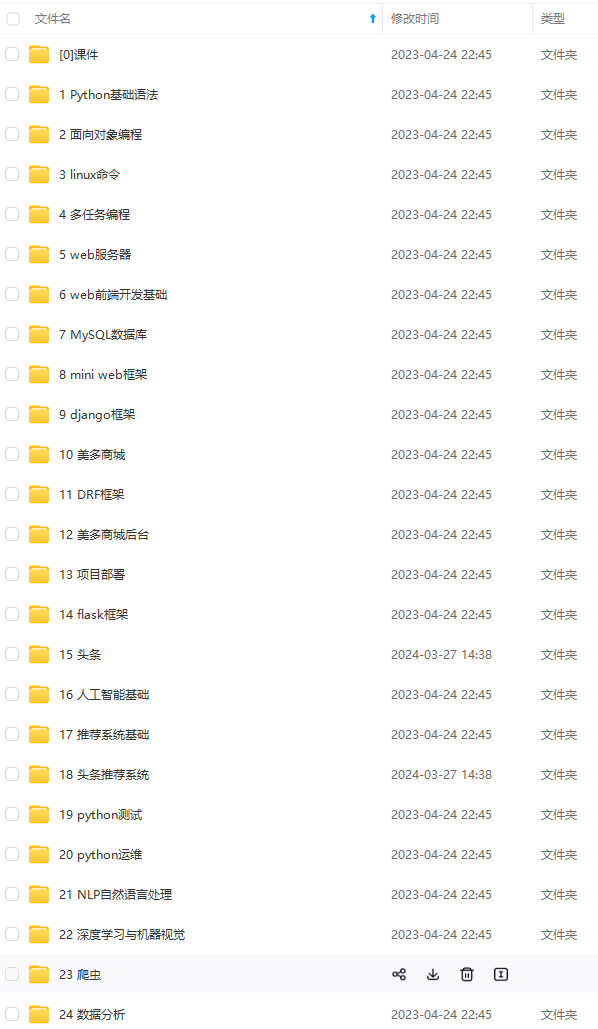

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip1024c (备注Python)

正文

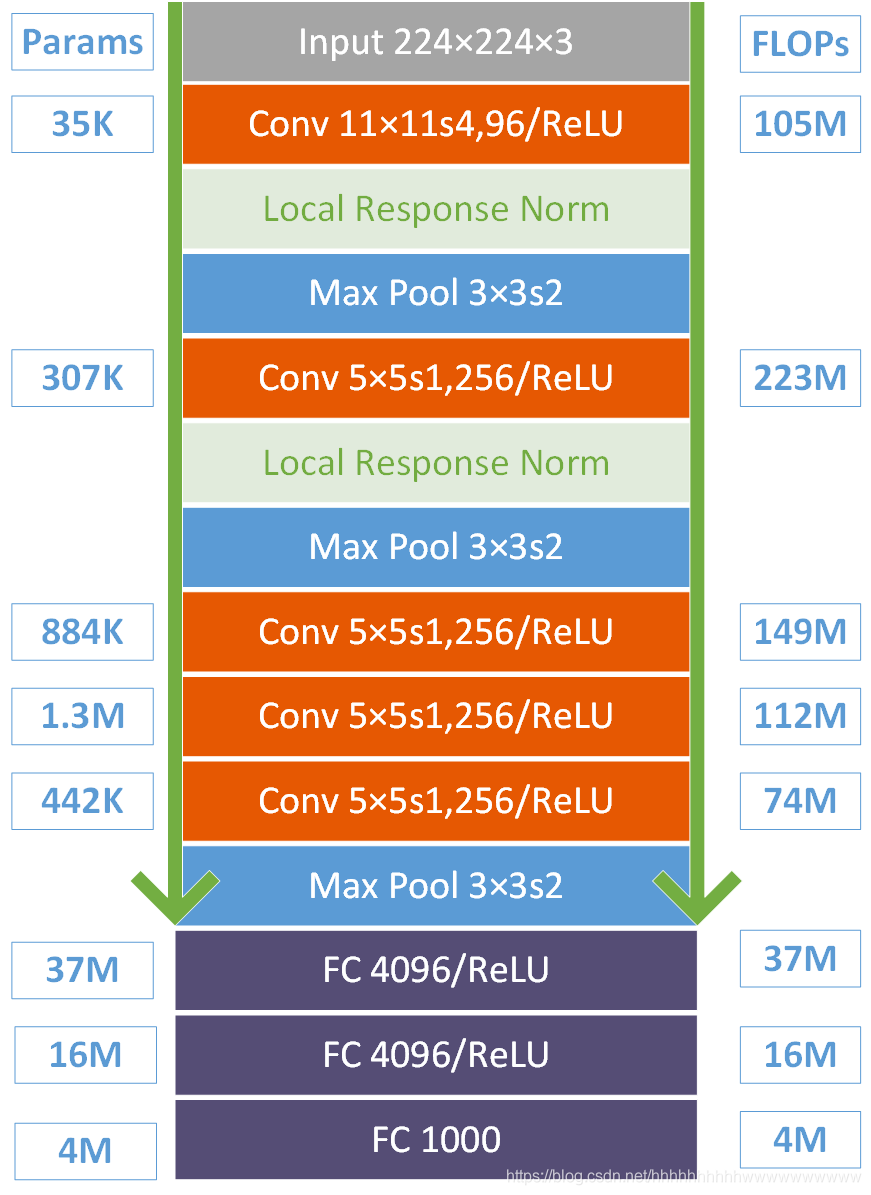

然后进行 (Local Response Normalized), 后面跟着池化pool_size = (3, 3), stride = 2, pad = 0 最终获得第一层卷积的feature map

最终第一层卷积的输出为96×55×55

第二层:卷积层2, 输入为上一层卷积的feature map, 卷积的个数为256个,论文中的两个GPU分别有128个卷积核。卷积核的大小为:5 × 5 × 48, padding = 2, stride = 1; 然后做 LRN, 最后 max_pooling, pool_size = (3, 3), stride = 2;

第三层:卷积3, 输入为第二层的输出,卷积核个数为384, kernel_size = (3 × 3 × 256 ), padding = 1, 第三层没有做LRN和Pool

第四层:卷积4, 输入为第三层的输出,卷积核个数为384, kernel_size = (3 × 3 ), padding = 1, 和第三层一样,没有LRN和Pool

第五层:卷积5, 输入为第四层的输出,卷积核个数为256, kernel_size = (3 × 3 ), padding = 1。然后直接进行max_pooling, pool_size = (3, 3), stride = 2;

第6,7,8层是全连接层,每一层的神经元的个数为4096,最终输出softmax为1000,因为上面介绍过,ImageNet这个比赛的分类个数为1000。全连接层中使用了RELU和Dropout。

下图是对上面参数的总结。

3、 模型特性

=======

-

所有卷积层都使用ReLU作为非线性映射函数,使模型收敛速度更快

-

在多个GPU上进行模型的训练,不但可以提高模型的训练速度,还能提升数据的使用规模

-

使用LRN对局部的特征进行归一化,结果作为ReLU激活函数的输入能有效降低错误率

-

重叠最大池化(overlapping max pooling),即池化范围z与步长s存在关系z>s(如

)中核尺度为3×3/2),避免平均池化(average pooling)的平均效应

)中核尺度为3×3/2),避免平均池化(average pooling)的平均效应 -

使用随机丢弃技术(dropout)选择性地忽略训练中的单个神经元,避免模型的过拟合

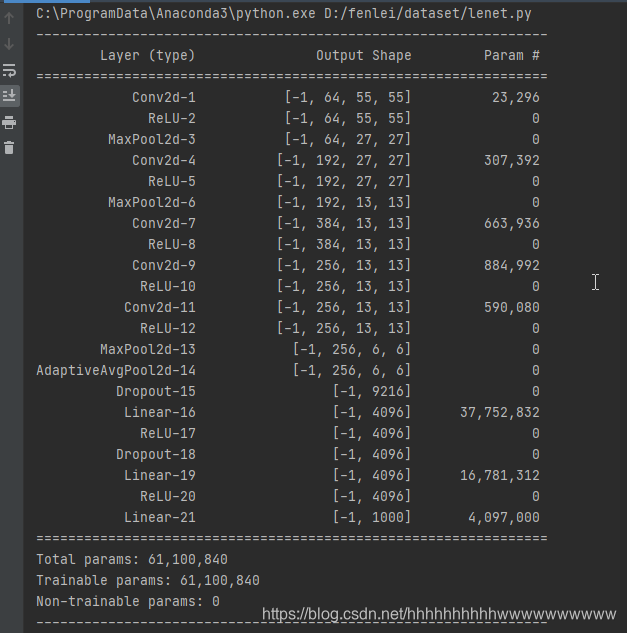

4、Pytorch官方实现

=============

pytorch的官方并没有严格按照AlexNet论文的实现,第一个卷积是64个卷积核,官方是96个。

class AlexNet(nn.Module):

def init(self, num_classes=1000):

super(AlexNet, self).init()

self.features = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=11, stride=4, padding=2),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=3, stride=2),

nn.Conv2d(64, 192, kernel_size=5, padding=2),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=3, stride=2),

nn.Conv2d(192, 384, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(384, 256, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(256, 256, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=3, stride=2),

)

self.avgpool = nn.AdaptiveAvgPool2d((6, 6))

self.classifier = nn.Sequential(

nn.Dropout(),

nn.Linear(256 * 6 * 6, 4096),

nn.ReLU(inplace=True),

nn.Dropout(),

nn.Linear(4096, 4096),

nn.ReLU(inplace=True),

nn.Linear(4096, num_classes),

)

def forward(self, x):

x = self.features(x)

x = self.avgpool(x)

x = torch.flatten(x, 1)

x = self.classifier(x)

return x

5、keras实现

=========

import os

import pandas as pd

import numpy as np

from keras.callbacks import EarlyStopping, ModelCheckpoint

from matplotlib import pyplot as plt

from skimage.io import imread, imshow

from skimage import transform

import warnings

from tqdm import tqdm

from keras.layers import Input, Lambda, Conv2D, MaxPool2D, BatchNormalization, Dense, Flatten, Dropout

from keras.models import Model

from keras.utils import to_categorical

def AlexNet(input_shape, num_classes):

inputs = Input(input_shape, name=“Input”)

x = ZeroPadding2D(((3, 0), (3, 0)))(inputs)

x = Conv2D(96,

(11, 11),

4,

kernel_initializer=initializers.RandomNormal(stddev=0.01),

name=“Conv_1”)(x)

x = Lambda(tf.nn.local_response_normalization, name=“Lrn_1”)(x)

x = Activation(activation=“relu”)(x)

x = MaxPool2D(name=“Maxpool_1”)(x)

x = Conv2D(256,

(5, 5),

kernel_initializer=initializers.RandomNormal(stddev=0.01),

padding=“SAME”,

name=“Conv_2”)(x)

x = Lambda(tf.nn.local_response_normalization, name=“Lrn_2”)(x)

x = Activation(activation=“relu”)(x)

x = MaxPool2D(name=“Maxpool_2”)(x)

x = Conv2D(384,

(3, 3),

一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、Python必备开发工具

工具都帮大家整理好了,安装就可直接上手!

三、最新Python学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、Python视频合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试宝典

简历模板

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

00c049bb72fbd.png#pic_center)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

[外链图片转存中…(img-zzJWTpIH-1713216146567)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?