1.1 历史元数据处理

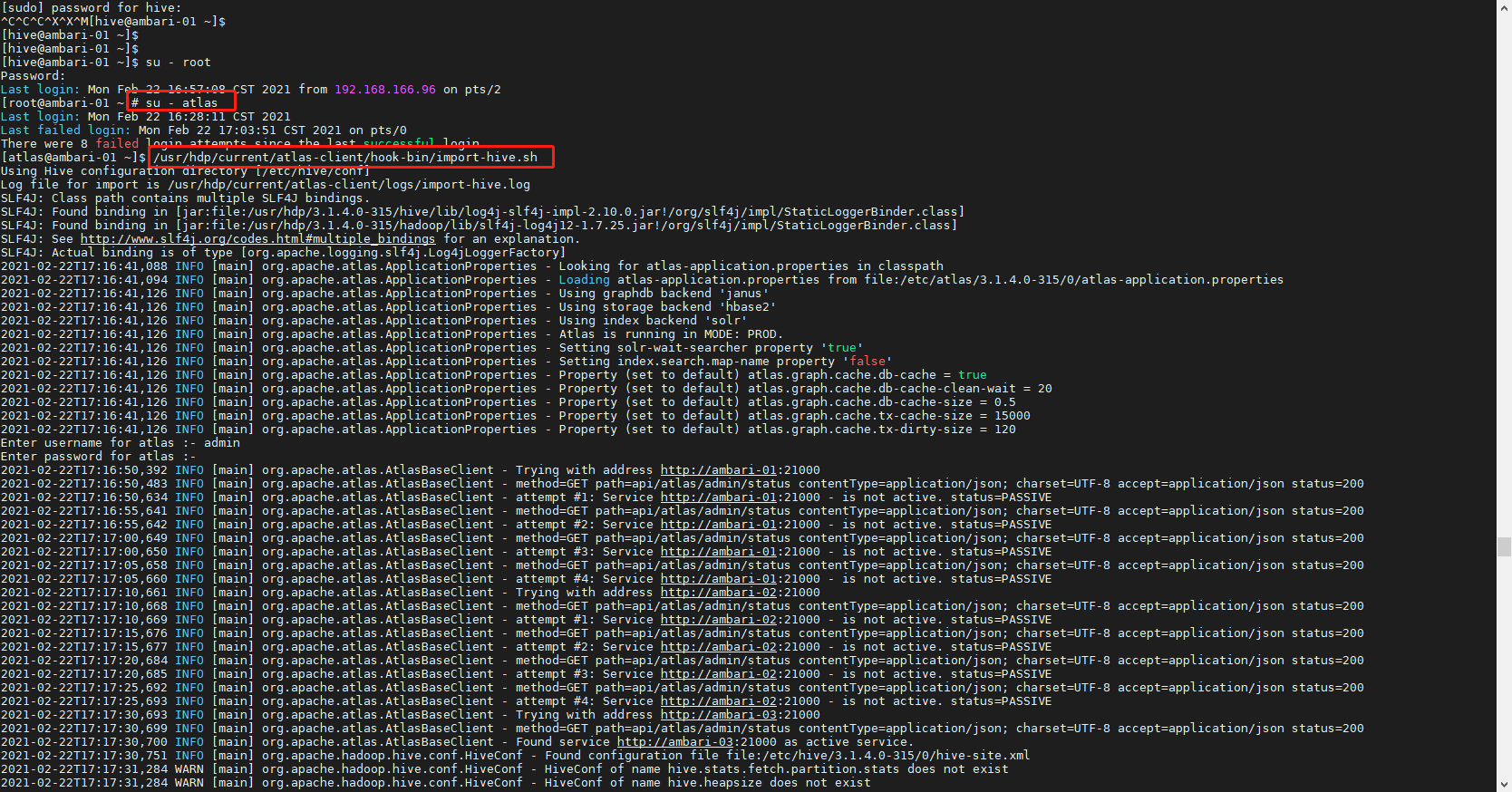

在上线Atlas之前Hive可能运行很久了,所以历史上的元数据无法触发hook,因此需要一个工具来做初始化导入。Apache Atlas提供了一个命令行脚本 import-hive.sh ,用于将Apache Hive数据库和表的元数据导入Apache Atlas。该脚本可用于使用Apache Hive中的数据库/表初始化Apache Atlas。此脚本支持导入特定表的元数据,特定数据库中的表或所有数据库和表。

1# 切换到 atlas 用户

2su - atlas

3# 执行导入脚本

4/usr/hdp/current/atlas-client/hook-bin/import-hive.sh

5

6# 账户密码 admin admin123

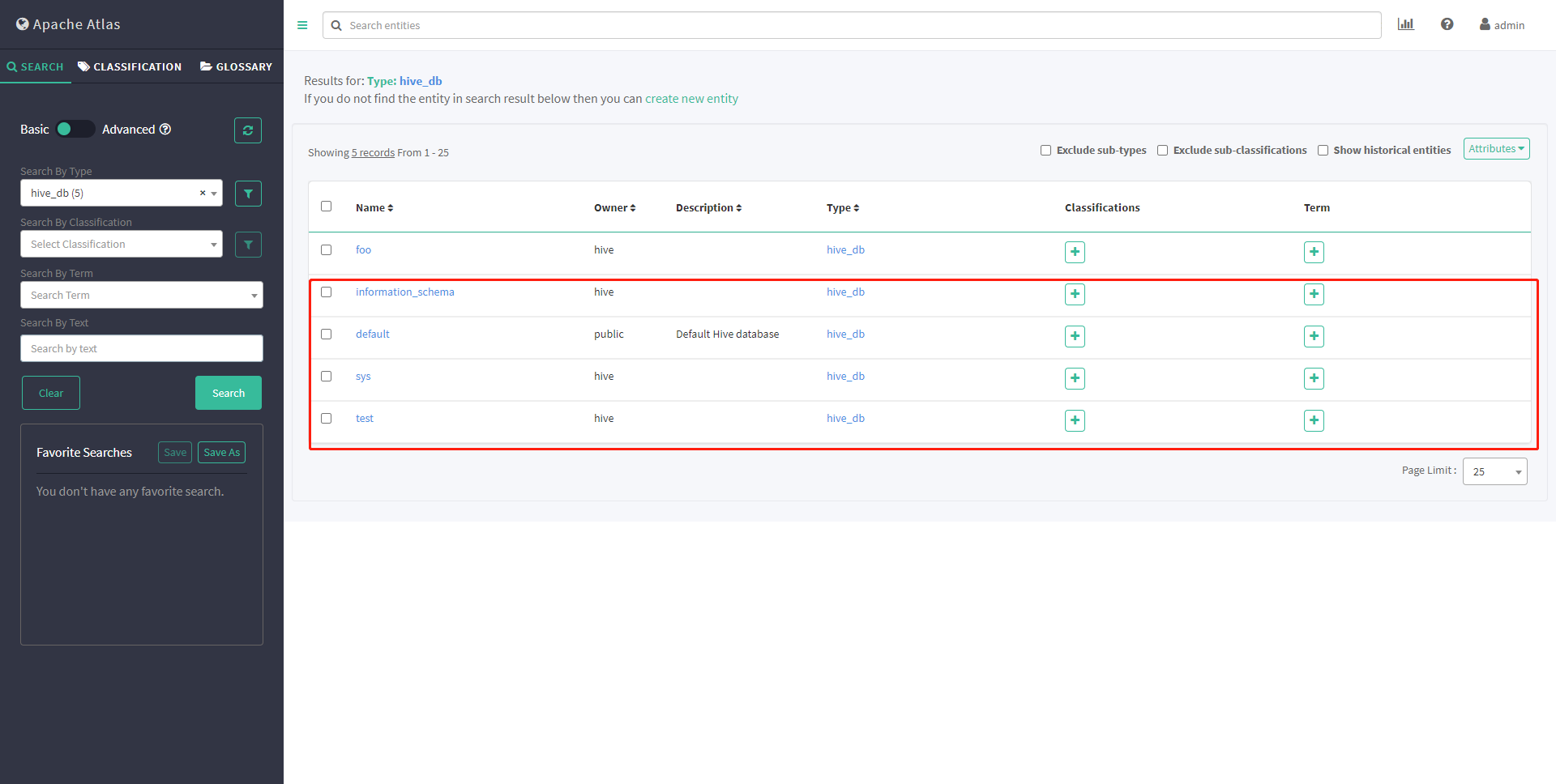

看到新导入的database 则证明历史元数据导入成功

2、集成HBase

=========

Atlas HBase hook与HBase master注册为协处理器。在检测到对HBase名称空间/表/列族的更改时,Atlas Hook过Kafka通知更新Atlas中的元数据。按照以下说明在HBase中设置Atlas Hook:

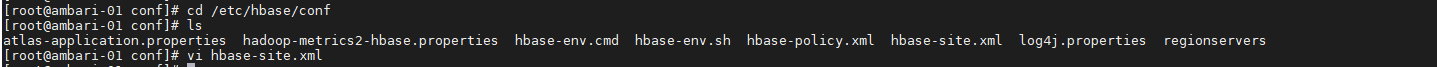

1# 编辑 hbase-site.xml

2cd /etc/hbase/conf

3vi hbase-site.xml

4

5# add for hbase regist atlas hook

6# design by liziba 2021/02/22

7

8 hbase.coprocessor.master.classes

9 org.apache.atlas.hbase.hook.HBaseAtlasCoprocessor

10

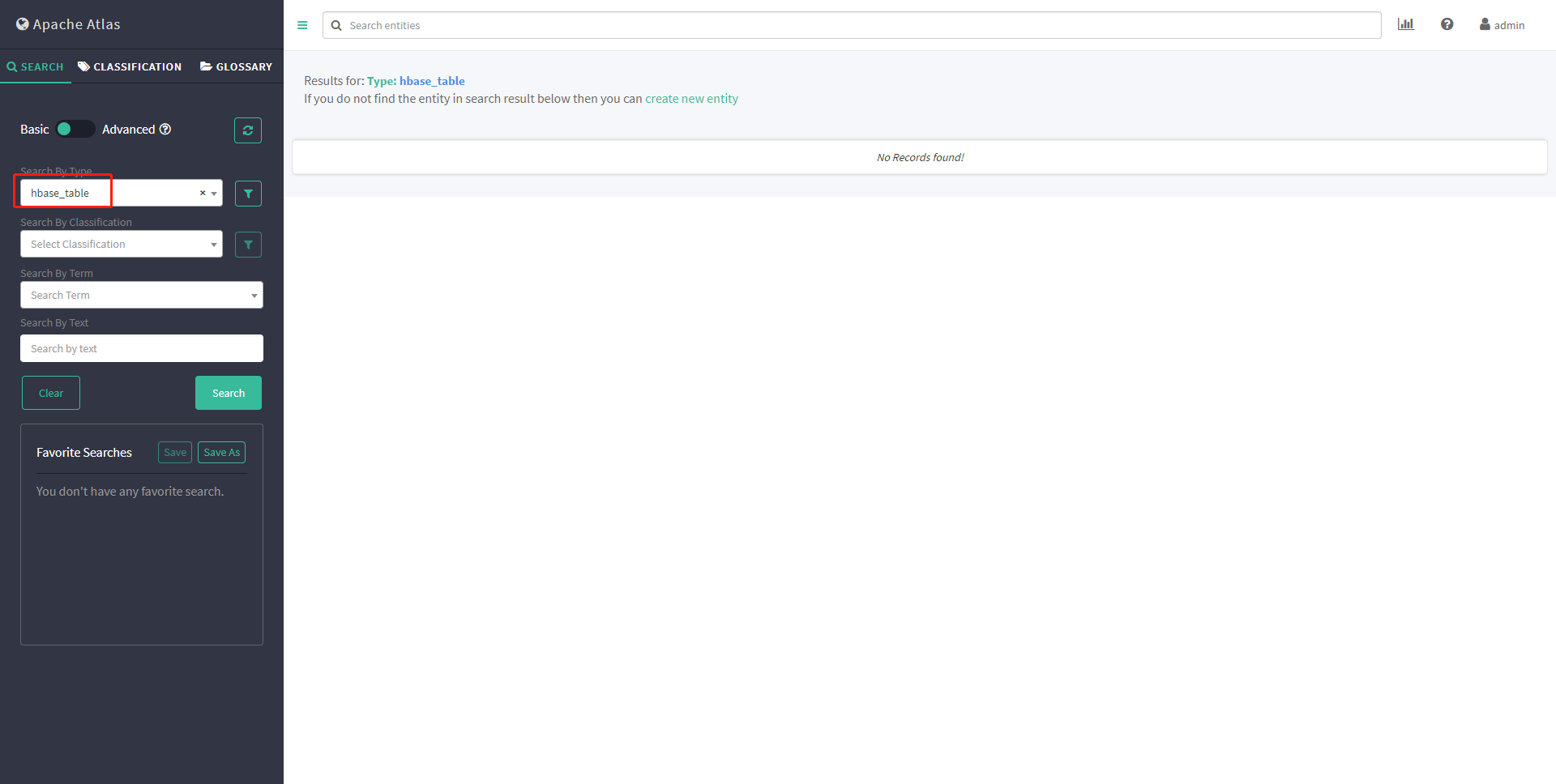

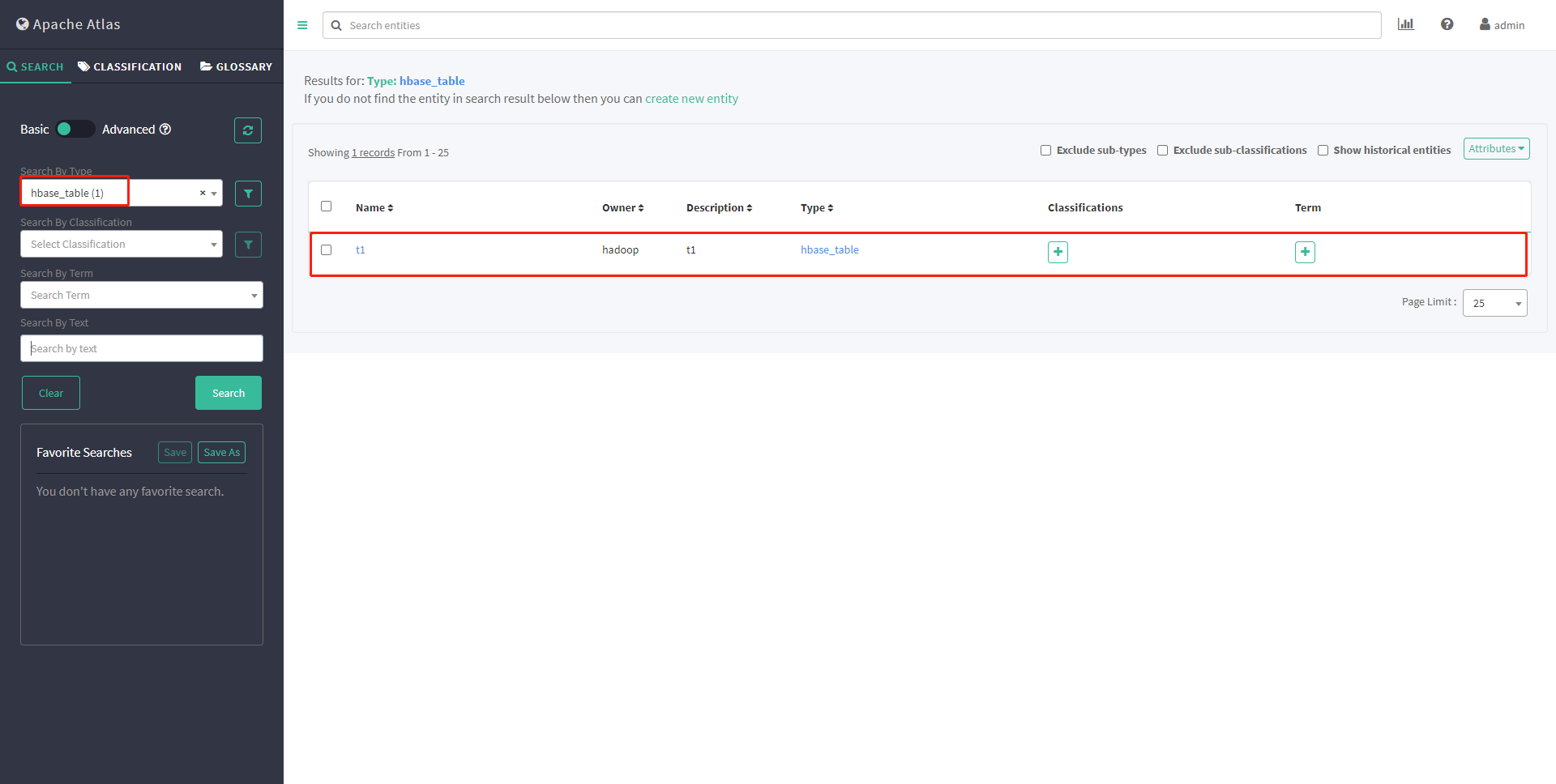

查看元数据

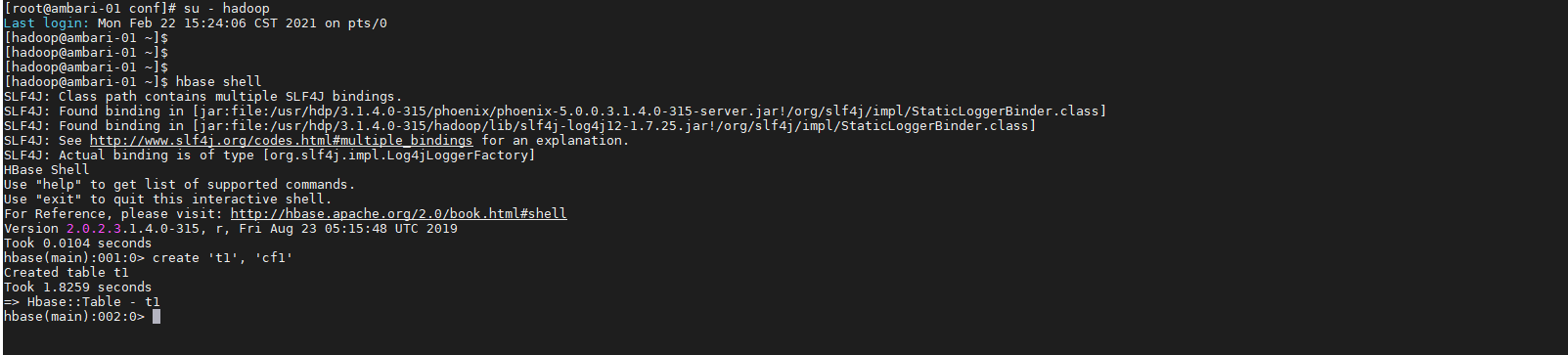

1# 切换到hadoop

2su - hadoop

3# 创建hbase table

4hbase shell

5

6create ‘t1’, ‘cf1’

再次查看元数据

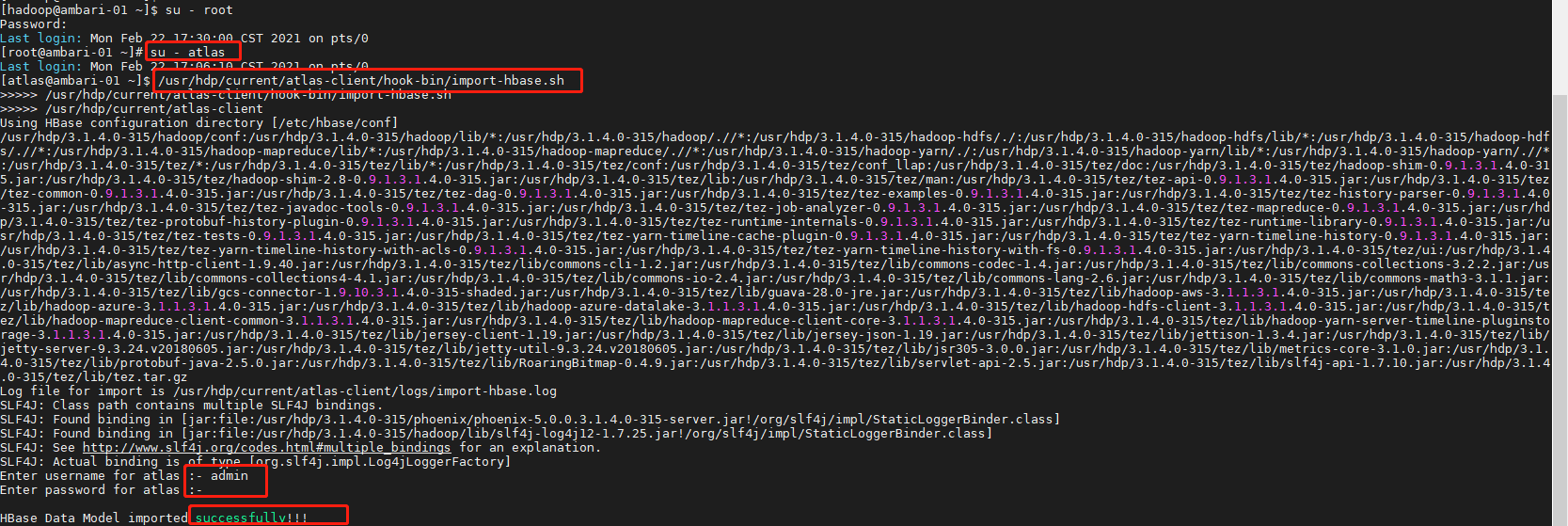

2.1历史元数据导入

同样,HBase也会在Atlas上线之前早就上线了,所以需要同步历史上的元数据。

注意:一定要进入atlas用户,因为Atlas的Linux管理账户是atlas,其他账户下可能会报没有权限的错误。

1sudo su - atlas

2/usr/hdp/current/atlas-client/hook-bin/import-hbase.sh

3# 密码 admin admin123

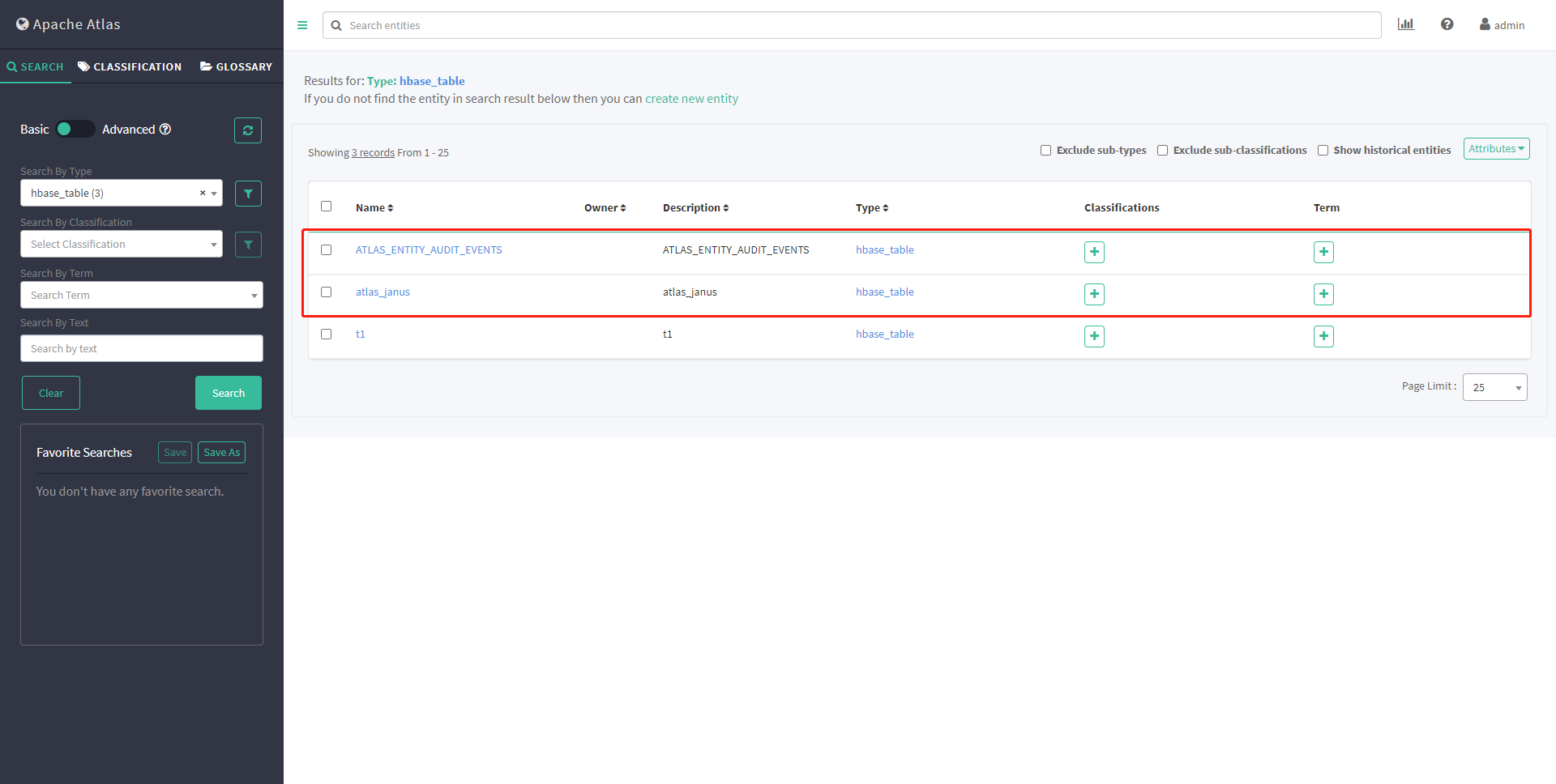

再次查看元数据

3、集成Kafka

=========

3.1Bug规避

HDP3.1有一个Bug,安装Atlas时不会自动安装atlas-kafka-hook。

3.1.1 发现bug

1# 进入hook-bin目录

2cd /usr/hdp/current/atlas-client/hook-bin

可以看到并没有Kafka的import脚本。

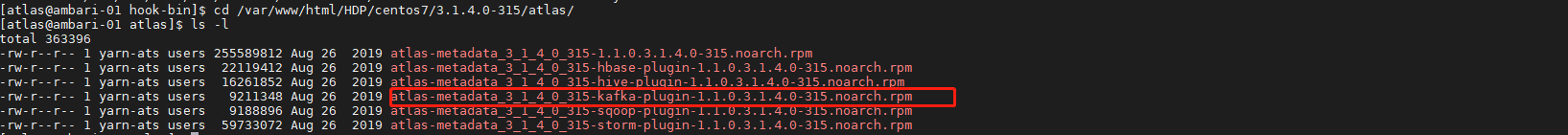

然后再登录HDP yum源所在节点(安装Ambari时使用的Httpd)

1cd /var/www/html/HDP/centos7/3.1.4.0-315/atlas

2ls -l

上图中我们可以看到atlas-kafka插件包是提供了的,接下来可以看看该插件在Kakfa节点上是否安装。

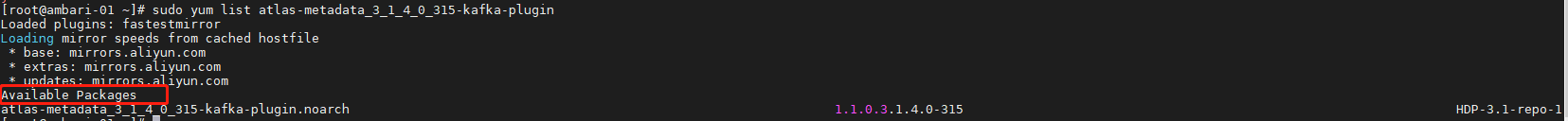

登录任意Kafka节点:

1yum list atlas-metadata_3_1_4_0_315-kafka-plugin

并未安装atlas-metadata_3_1_4_0_315-kafka-plugin

结论 HDP-3.1.4.0中,Ambari安装Atlas时没有自动安装atlas-metadata_3_1_4_0_315-kafka-plugin,这是一个bug

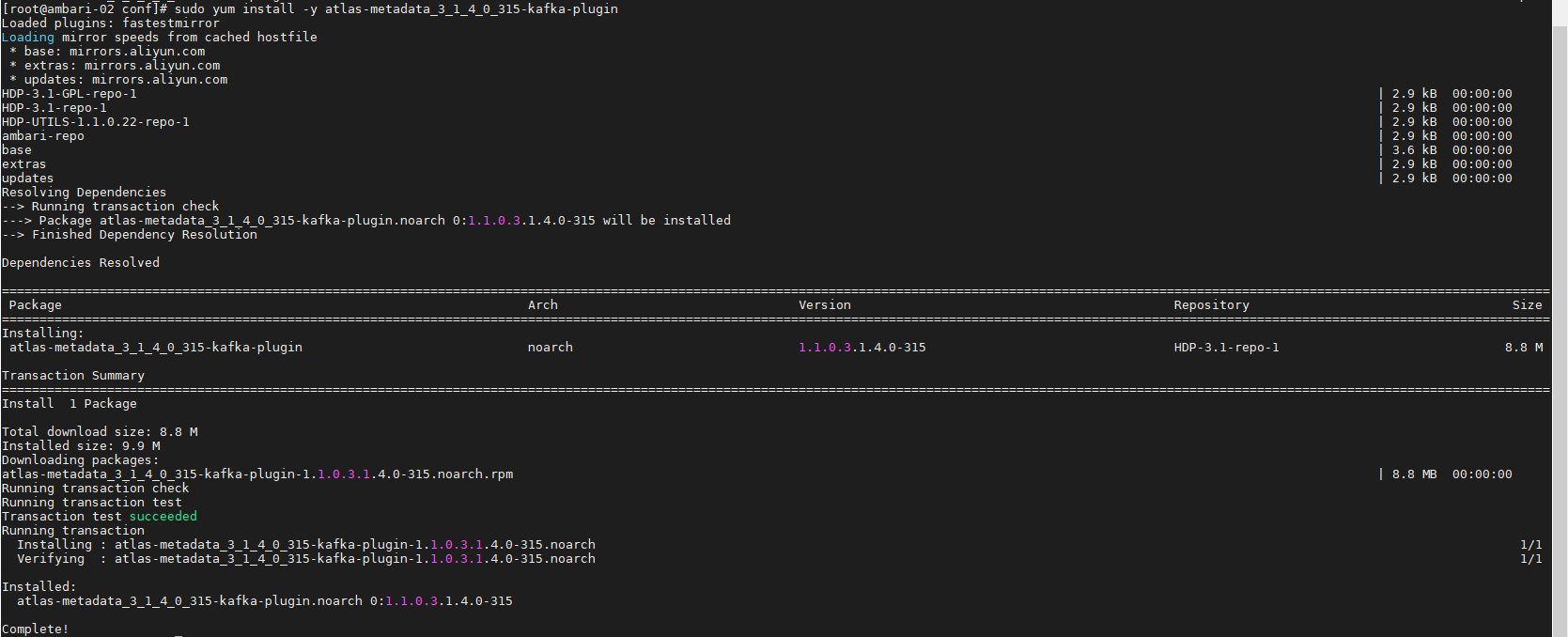

3.1.2 规避bug

在 Kafka的任意Clien节点安装atlas-metadata_3_1_4_0_315-kafka-plugin: ambari-02 167

1sudo yum install -y atlas-metadata_3_1_4_0_315-kafka-plugin

安装完修改下执行权限

1sudo chown atlas:hadoop /usr/hdp/current/atlas-client/hook-bin/import-kafka.sh

2sudo chown atlas:hadoop /usr/hdp/current/atlas-client/logs/

3.1.2 集成原理与局限性

Atlas只提供一个批量导入元数据到Atlas的工具,原理是通过kafka.utils.ZkUtils获取Topic的元数据信息并写入Atlas。

Atlas没有提供Kafka Hook,所以不能实时采集Kafka的元数据,需要定期调度批量导入元数据的脚本。

3.1.3 历史元数据导入

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数初中级Android工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则近万的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

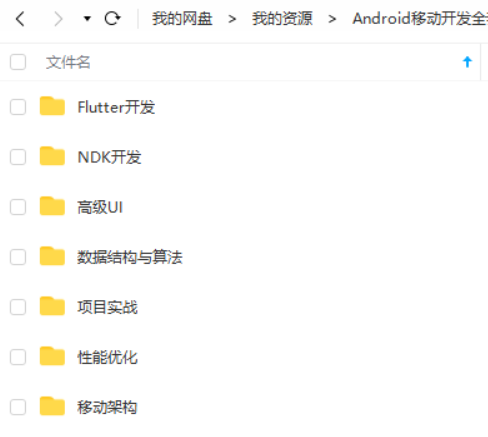

因此收集整理了一份《2024年Android移动开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Android开发知识点,真正体系化!

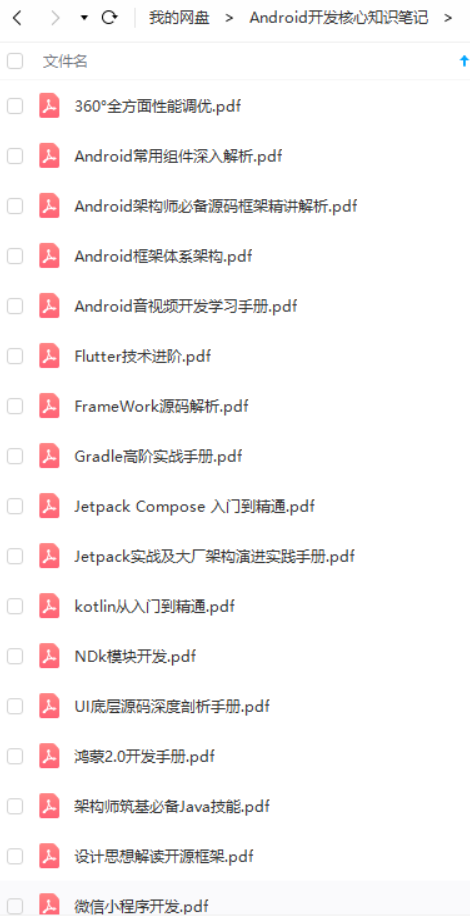

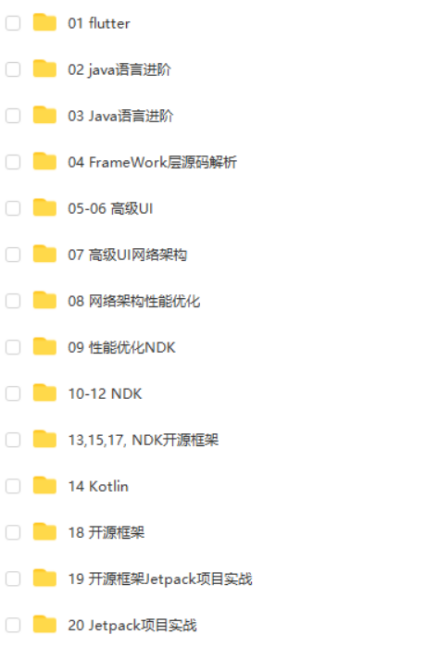

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注:Android)

总结

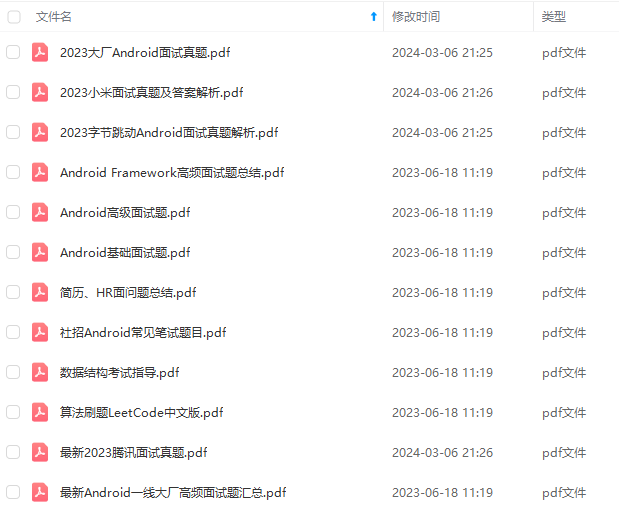

首先是感觉自己的基础还是不够吧,大厂好像都喜欢问这些底层原理。

另外一部分原因在于资料也还没有看完,一面时凭借那份资料考前突击恶补个几天居然也能轻松应对(在这里还是要感谢那份资料,真的牛),于是自我感觉良好,资料就没有怎么深究下去了。

之前的准备只涉及了Java、Android、计网、数据结构与算法这些方面,面对面试官对其他基础课程的考察显得捉襟见肘。

下一步还是要查漏补缺,进行针对性复习。

最后的最后,那套资料这次一定要全部看完,是真的太全面了,各个知识点都涵盖了,几乎我面试遇到的所有问题的知识点这里面都有!希望大家不要犯和我一样的错误呀!!!一定要看完!

《互联网大厂面试真题解析、进阶开发核心学习笔记、全套讲解视频、实战项目源码讲义》点击传送门即可获取!

要查漏补缺,进行针对性复习。

最后的最后,那套资料这次一定要全部看完,是真的太全面了,各个知识点都涵盖了,几乎我面试遇到的所有问题的知识点这里面都有!希望大家不要犯和我一样的错误呀!!!一定要看完!

[外链图片转存中…(img-9gEmCcZV-1712453000702)]

[外链图片转存中…(img-KBwZxHjn-1712453000702)]

[外链图片转存中…(img-kMXLEq8F-1712453000702)]

《互联网大厂面试真题解析、进阶开发核心学习笔记、全套讲解视频、实战项目源码讲义》点击传送门即可获取!

425

425

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?