网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

Your identification has been saved in /root/.ssh/id_rsa.

Your public key has been saved in /root/.ssh/id_rsa.pub.

The key fingerprint is:

SHA256:AtZHQcFd10Qth+HXMib4saDzZhtYJBkS5VEyH04RiNM root@d23abd7ce7a9

The key’s randomart image is: //密钥

±–[RSA 2048]----+

| oB@**+. o*+|

| .o+EX.o oo =|

| o …= * o =oo|

| . . . + o = + |

| . S . o |

| . = |

| . = |

| o o |

| . |

±—[SHA256]-----+

//再输入以下命令

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

将PermitRootLogin yes、PubkeyAuthentication yes的注释去掉,就是把前面的#删掉

sh-4.2# vim /etc/ssh/sshd_config

sh-4.2# systemctl enable sshd.service

sh-4.2# systemctl start sshd.service

再输入以下命令,做就完了

cd $HOME/.ssh/

chmod 600 authorized_keys

ssh localhost

scp -r ~/.ssh root@node1:~/ //这的node1是我的克隆虚拟机的主机名,换成自己的

免密登录验证

ssh node1

成功!

配置Hadoop

——此代码在我的机器上是可以成功,但是也有他人按照此代码失败的情况,如果失败可以寻找其他的代码来尝试配置

将hadoop的安装包上传到服务器

tar解压安装包

[root@master tools]# tar -xvf hadoop-3.2.3.tar.gz //hadoop文件名按照自己的来

[root@master tools]# mv hadoop-3.2.3 /usr/local/hadoop3 //移动解压后的Hadoop文件到/usr/local/hadoop3目录下

修改master节点上的hadoop配置文件,修改配置文件/etc/profile,文末加入以下配置

export HADOOP_HOME=/usr/local/hadoop3 //路径为上一步转移的目录

export PATH= P A T H : PATH: PATH:HADOOP_HOME/bin:$HADOOP_HOME/sbin

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_PREFIX=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_YARN_HOME=$HADOOP_HOME

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_CONF_DIR=$HADOOP_HOME

export HADOOP_LIBEXEC_DIR=$HADOOP_HOME/libexec

export JAVA_LIBRARY_PATH= H A D O O P _ H O M E / l i b / n a t i v e : HADOOP\_HOME/lib/native: HADOOP_HOME/lib/native:JAVA_LIBRARY_PATH

export HADOOP_CONF_DIR=$HADOOP_PREFIX/etc/hadoop

export HDFS_DATANODE_USER=root

export HDFS_DATANODE_SECURE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HDFS_NAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

通过source命令将配置生效

source /etc/profile

查看是否设定好了环境变量

echo $HADOOP_HOME

显示为/etc/profile文件中的HADOOP_HOME位置

修改hadoop-env.sh等文件

[root@d422409c8ce5 hadoop]# vim $HADOOP_HOME/etc/hadoop/hadoop-env.sh

[root@d422409c8ce5 hadoop]# vim $HADOOP_HOME/etc/hadoop/yarn-env.sh

[root@d422409c8ce5 hadoop]# vim $HADOOP_HOME/etc/hadoop/mapred-env.sh

文末添加jdk的安装路径

增加node1的信息(自己克隆的虚拟机名称)

vi $HADOOP_HOME/etc/hadoop/workers

添加内容:node1

把以下文件的configuration修改为如下内容:

vim $HADOOP_HOME/etc/hadoop/core-site.xml

fs.defaultFS

hdfs://master:9000

hadoop.tmp.dir

/home/hadoop/tmp

io.file.buffer.size

131702

hadoop.http.staticuser.user

root

vim $HADOOP_HOME/etc/hadoop/hdfs-site.xml

dfs.namenode.name.dir

file:/home/hadoop/tmp/dfs/name

dfs.datanode.data.dir

file:/home/hadoop/tmp/dfs/data

dfs.replication

3

dfs.namenode.http-address

master:50070

NameNode address and port

dfs.namenode.secondary.http-address

master:50090

Secondary NameNode address and port

dfs.webhdfs.enabled

true

dfs.stream-buffer-size

131072

dfs.namenode.checkpoint.dir

file:/home/hadoop/tmp/dfs/namesecondary

vim $HADOOP_HOME/etc/hadoop/mapred-site.xml

mapreduce.framework.name

yarn

mapreduce.jobhistory.address

master:10020

mapreduce.jobtracker.address

master:9001

mapreduce.jobhistory.webapp.address

master:19888

mapreduce.application.classpath

/usr/local/hadoop3/etc/hadoop,

/usr/local/hadoop3/share/hadoop/common/*,

/usr/local/hadoop3/share/hadoop/common/lib/*,

/usr/local/hadoop3/share/hadoop/hdfs/*,

/usr/local/hadoop3/share/hadoop/hdfs/lib/*,

/usr/local/hadoop3/share/hadoop/mapreduce/*,

/usr/local/hadoop3/share/hadoop/mapreduce/lib/*,

/usr/local/hadoop3/share/hadoop/yarn/*,

/usr/local/hadoop3/share/hadoop/yarn/lib/*

vim $HADOOP_HOME/etc/hadoop/yarn-site.xml中

yarn.resourcemanager.hostname

master

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.auxservices.mapreduce.shuffle.class

org.apache.hadoop.mapred.ShuffleHandler

yarn.resourcemanager.address

master:8032

yarn.resourcemanager.scheduler.address

master:8030

yarn.resourcemanager.resource-tracker.address

master:8031

yarn.resourcemanager.admin.address

${yarn.resourcemanager.hostname}:8033

yarn.resourcemanager.webapp.address

master:8088

将配置好的hadoop拷贝到node1上,也就是自己克隆的虚拟机上

scp -r /usr/local/hadoop3 root@node1:/usr/local/

创建数据目录 — 与$HADOOP_HOME/etc/hadoop/core-site.xml中hadoop.tmp.dir的值一致

mkdir -p /home/hadoop/tmp

启动Hadoop集群

格式化文件系统 – 只在master上操作

hdfs namenode -format

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

erty>

将配置好的hadoop拷贝到node1上,也就是自己克隆的虚拟机上

scp -r /usr/local/hadoop3 root@node1:/usr/local/

创建数据目录 — 与$HADOOP_HOME/etc/hadoop/core-site.xml中hadoop.tmp.dir的值一致

mkdir -p /home/hadoop/tmp

启动Hadoop集群

格式化文件系统 – 只在master上操作

hdfs namenode -format

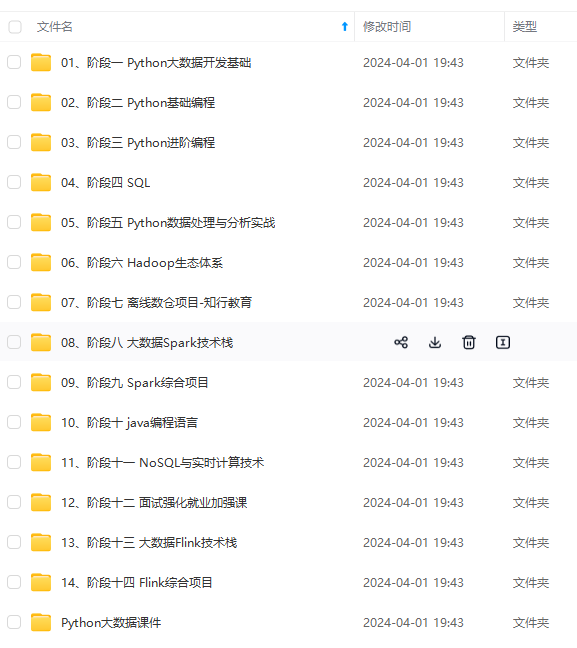

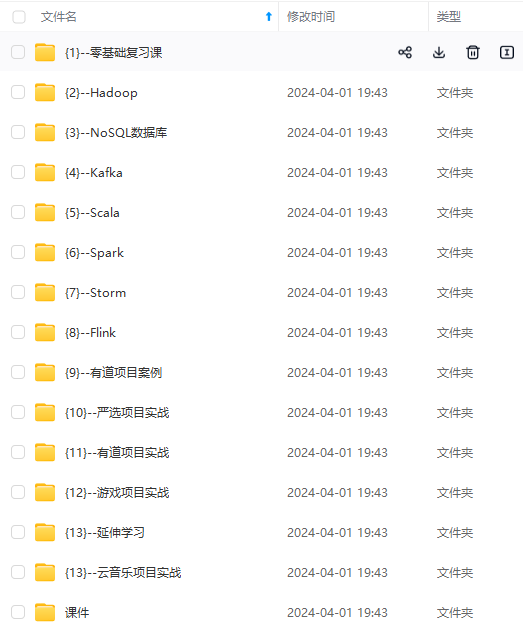

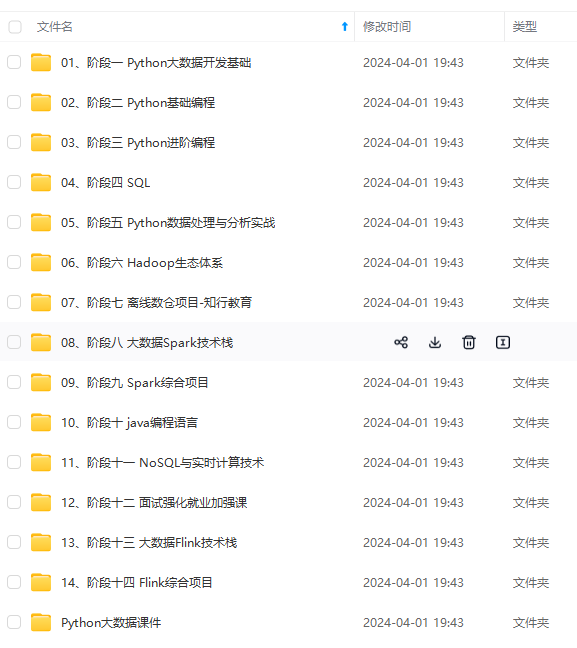

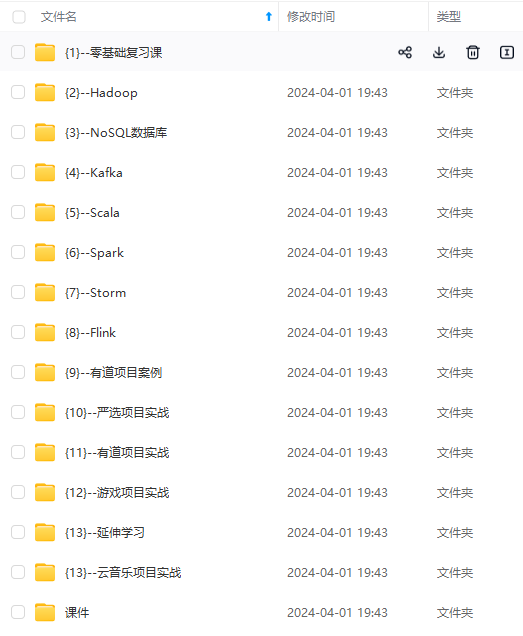

[外链图片转存中…(img-gEqLX96B-1715592523049)]

[外链图片转存中…(img-nxQ99ytx-1715592523050)]

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?