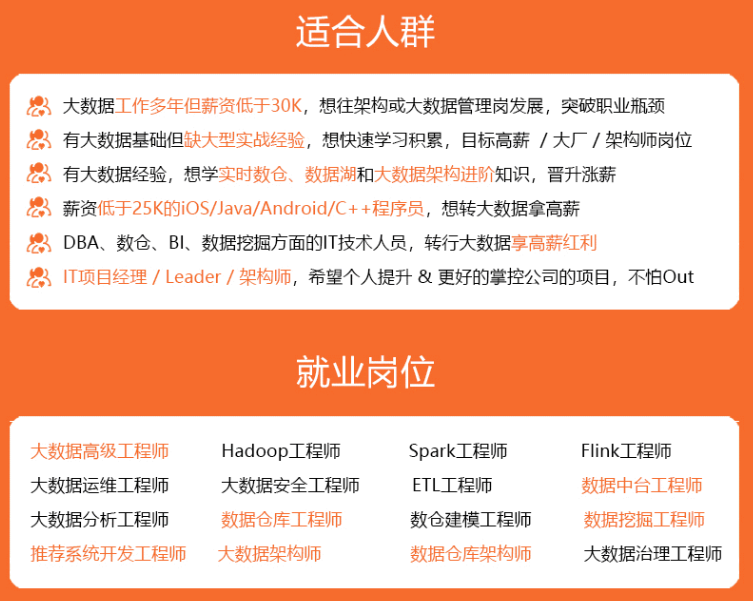

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

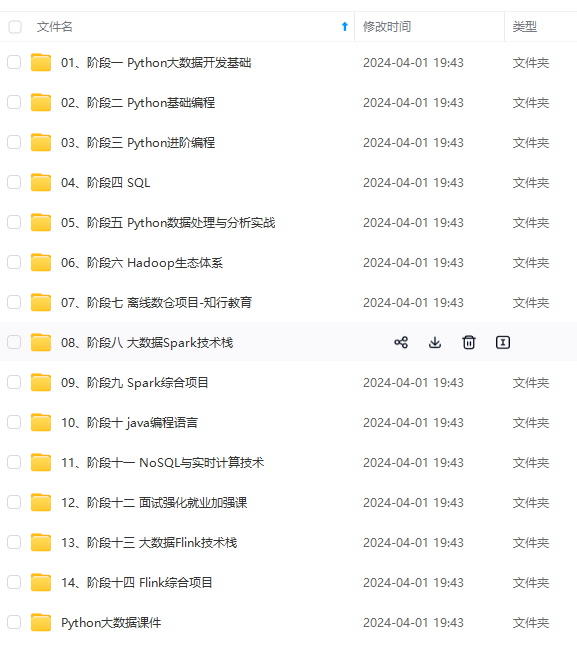

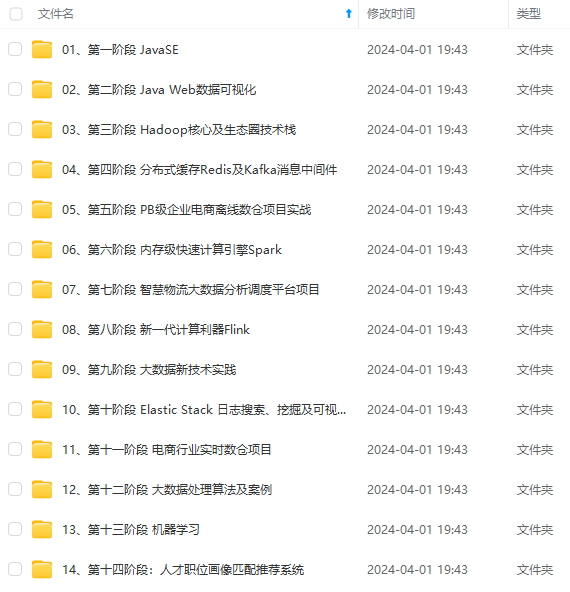

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

GET _analyze

{

"analyzer": "ik\_smart",

"text": ["好好学习"]

}

// 分词结果

{

"tokens" : [

{

"token" : "好好学习",

"start\_offset" : 0,

"end\_offset" : 4,

"type" : "CN\_WORD",

"position" : 0

}

]

}

最细粒度划分

GET _analyze

{

"analyzer": "ik\_max\_word",

"text": ["好好学习"]

}

// 分词结果

{

"tokens" : [

{

"token" : "好好学习",

"start\_offset" : 0,

"end\_offset" : 4,

"type" : "CN\_WORD",

"position" : 0

},

{

"token" : "好好学",

"start\_offset" : 0,

"end\_offset" : 3,

"type" : "CN\_WORD",

"position" : 1

},

{

"token" : "好好",

"start\_offset" : 0,

"end\_offset" : 2,

"type" : "CN\_WORD",

"position" : 2

},

{

"token" : "好学",

"start\_offset" : 1,

"end\_offset" : 3,

"type" : "CN\_WORD",

"position" : 3

},

{

"token" : "学习",

"start\_offset" : 2,

"end\_offset" : 4,

"type" : "CN\_WORD",

"position" : 4

}

]

}

自定义配置分词字典

elasticsearch-7.6.2\plugins\elasticsearch-analysis-ik-7.6.2\config\IKAnalyzer.cfg.xml

<!--新建 dic文件录入分词,在IKAnalyzer.cfg.xml中配置-->

<entry key="ext\_dict">春眠不觉晓.dic</entry>

GET _analyze

{

"analyzer": "ik\_max\_word",

"text": ["春眠不觉晓"]

}

// 自定义分词前

{

"tokens" : [

{

"token" : "春",

"start\_offset" : 0,

"end\_offset" : 1,

"type" : "CN\_CHAR",

"position" : 0

},

{

"token" : "眠",

"start\_offset" : 1,

"end\_offset" : 2,

"type" : "CN\_CHAR",

"position" : 1

},

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!**

**由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/forums/4f45ff00ff254613a03fab5e56a57acb)**

厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/forums/4f45ff00ff254613a03fab5e56a57acb)**

323

323

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?