一、概念

====

Hive是基于Hadoop的一个数据仓库工具,用来进行数据抽取,转化,加载,这是一种可以存储,查询和分析存储在Hadoop中的大规模数据的机制。Hive数据仓库工具能将结构化的数据文件映射成一张表,并提供SQL查询功能,能将SQL语句转化成为MapReduce来执行。Hive的优点是学习成本低,可以通过类SQL语句实现快速MapReduce统计,使MapReduce变得更加简单,而不必开发专门的MapReduce任务。Hive十分适合对数据仓库进行分析。

二、架构

====

三、表分类

=====

内部表:未被External修饰的是内部表(Managed Table),数据由自身管理,数据存储的位置是hive.metastore.warehouse.dir,(默认:/user/hive/warehouse)删除内部表会直接删除元数据(Metadata)及存储数据;对内部表的修改会将修改直接同步给元数据。

外部表:被External修饰的是外部表(External Table),数据由HDFS管理,部表数据的存储位置由自己制定(如果没有LOCATION,Hive将在HDFS上的/user/hive/warehouse文件夹下以外部表的表名创建一个文件夹,并将属于这个表的数据存放在这里),删除外部表仅仅会删除元数据,HDFS上的文件并不会被删除,而对外部表的表结构和分区进行修改,则需要修复(MSCK REPAIR TABLE table_name)。

四、Hive常用语句

==========

1.Hive建表语句

create table t1( id int,

name string ,

hobby array ,

add map<String,

string> )

row format delimited

fields terminated by ‘,’

collection items terminated by ‘-’

map keys terminated by ‘:’ ;

2.Hive新增列

alter table test.t1 add columns(a string);

3.Hive删除列

alter table test.t1 replace columns(id int,name string,hobby array,add map<string,string>);

4.Hive修改列

alter table test.t1 change a b int;

5.Hive清空表

truncate table test.t1;

6.Hive加载数据

load data local inpath ‘/home/hadoopap/desktop/data’ overwrite into table t1;

7.HDFS删除文件操作

sudo -u hdfs hadoop fs -rm -r -f /user/hive/warehouse/db名/表名/分区名

五、存储格式

======

1.Textfile

Hive数据表的默认格式,数据不做压缩,磁盘开销大,数据解析开销大。存储方式:行存储。

可以使用Gzip压缩算法,但压缩后的文件不支持split。

在反序列化过程中,必须逐个字符判断是不是分隔符和行结束符,因此反序列化开销会比SequenceFile高几十倍。

2.RCFile

存储方式:数据按行分块,每块按列存储。结合了行存储和列存储的优点:

首先,RCFile 保证同一行的数据位于同一节点,因此元组重构的开销很低。其次,像列存储一样,RCFile 能够利用列维度的数据压缩,并且能跳过不必要的列读取。

数据追加:RCFile不支持任意方式的数据写操作,仅提供一种追加接口,这是因为底层的 HDFS当前仅仅支持数据追加写文件尾部。

行组大小:行组变大有助于提高数据压缩的效率,但是可能会损害数据的读取性能,因为这样增加了 Lazy 解压性能的消耗。而且行组变大会占用更多的内存,这会影响并发执行的其他MR作业。 考虑到存储空间和查询效率两个方面,Facebook 选择 4MB 作为默认的行组大小,当然也允许用户自行选择参数进行配置。

3.ORCFile

存储方式:数据按行分块,每块按照列存储。

压缩快,可切分,快速列存取。效率比Rcfile高,是Rcfile的改良版本。

支持各种复杂的数据类型,比如datetime,decimal,以及复杂的struct。

4.Parquet

Parquet能够很好的压缩,有很好的查询性能,支持有限的模式演进。但是写速度通常比较慢。这中文件格式主要是用在Cloudera Impala上面的。

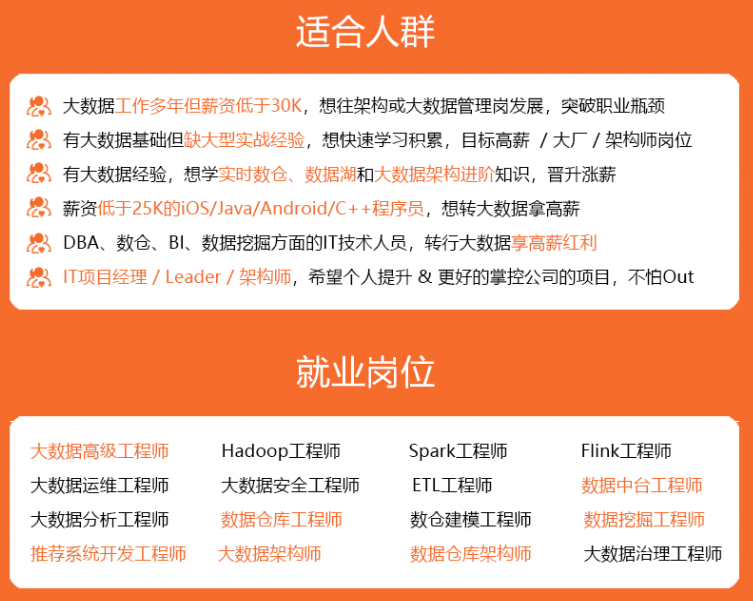

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

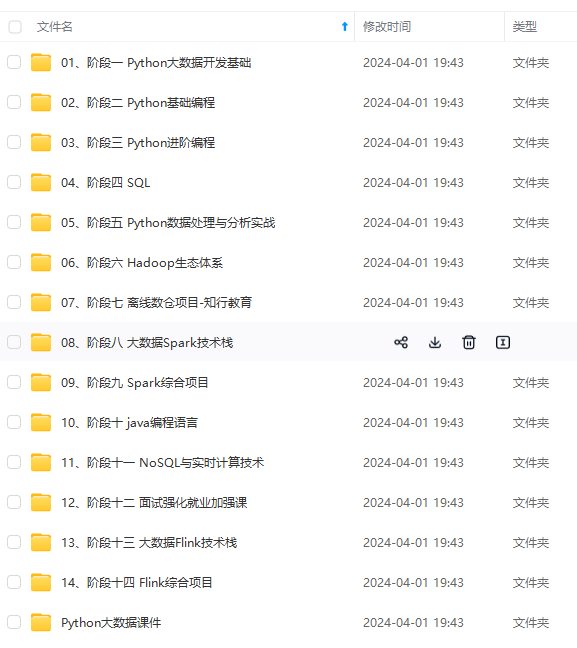

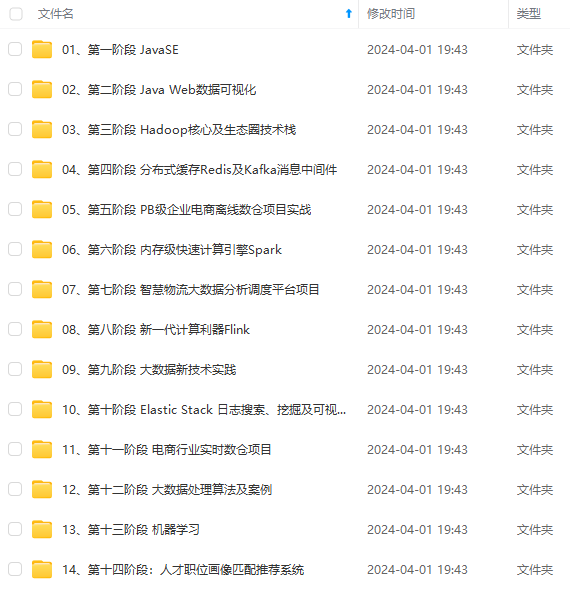

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

VWjvrqU-1714294860493)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

本文介绍了大数据入门中的Hive技术,包括其概念、架构、表分类(内部表和外部表)、常用语句(如建表、增删改列等),以及不同存储格式(Textfile、RCFile、ORCFile和Parquet)的特点。适合大数据初学者和进阶者系统学习Hive知识点。

本文介绍了大数据入门中的Hive技术,包括其概念、架构、表分类(内部表和外部表)、常用语句(如建表、增删改列等),以及不同存储格式(Textfile、RCFile、ORCFile和Parquet)的特点。适合大数据初学者和进阶者系统学习Hive知识点。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?