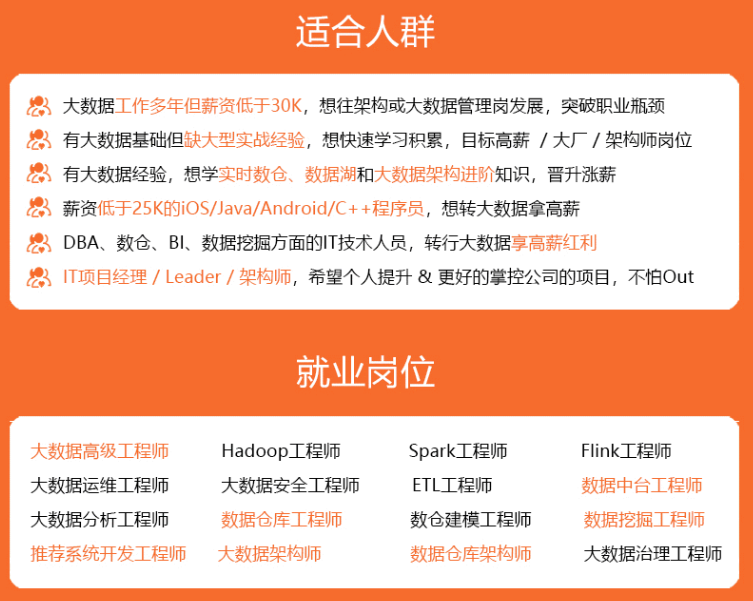

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

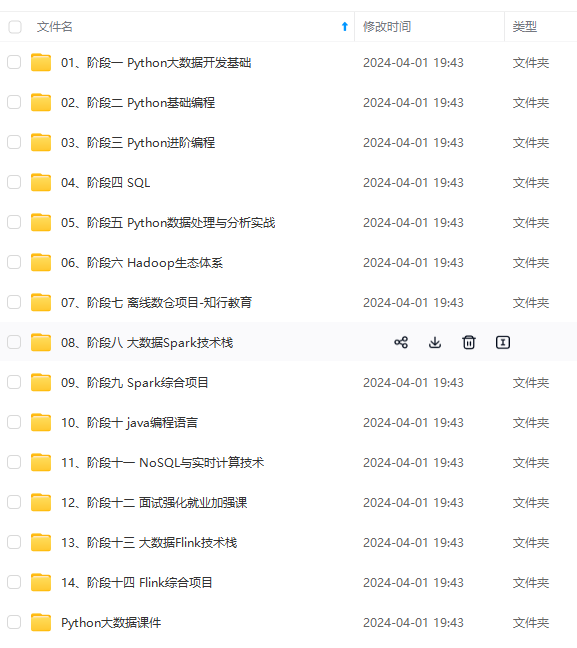

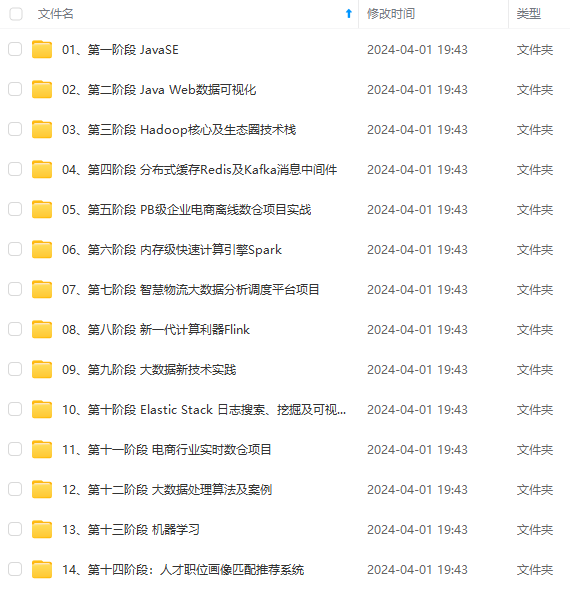

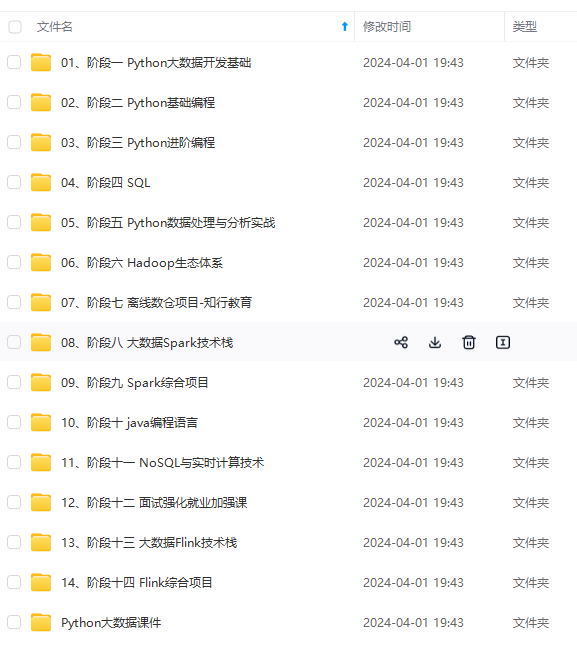

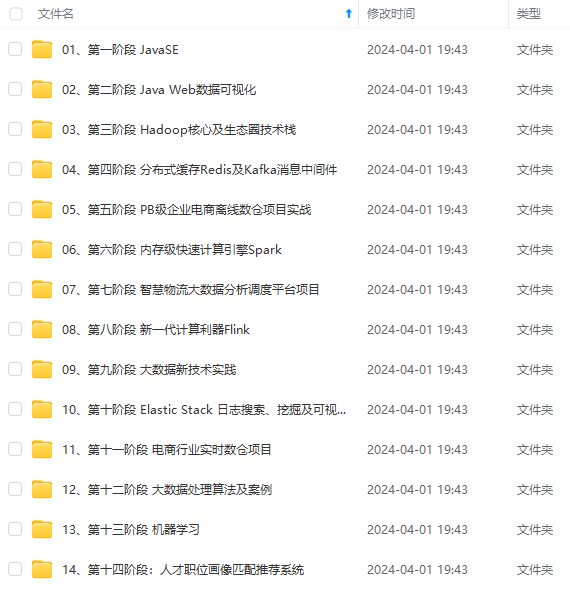

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

#### 2.4 Node Properties 配置

在 `/export/servers/presto-server-315/etc` 路径下,配置 node 属性(注意:**集群中每台 presto 的 node.id 必须不一样**,后面需要修改集群中其它节点的 node.id 值)

[root@node01 etc]# vim node.properties

#环境名称,自己任取.集群中的所有 Presto 节点必须具有相同的环境名称.

node.environment=develop

#支持字母,数字.对于每个节点,这必须是唯一的.这个标识符应该在重新启动或升级 Presto 时保持一致

node.id=1

#指定 presto 的日志和其它数据的存储目录,自己创建前面创建好的数据目录

node.data-dir=/file/data/presto

#### 2.5 JVM Config 配置

在`/exports/servers/presto-server-315/etc` 目录下添加 **jvm.config** 配置文件,并填入如下内容

#参考官方给的配置,根据自身机器实际内存进行配置

-server

#最大 jvm 内存

-Xmx16G

#指定 GC 的策略

-XX:+UseG1GC

-XX:G1HeapRegionSize=32M

-XX:+UseGCOverheadLimit

-XX:+ExplicitGCInvokesConcurrent

-XX:+HeapDumpOnOutOfMemoryError

-XX:+ExitOnOutOfMemoryError

-XX:ReservedCodeCacheSize=256M

#### 2.6 Config Properties 配置

Presto 是由一个 `coordinator` 节点和多个 `worker` 节点组成。由于在单独一台服务器上配置 coordinator ,有利于提高性能,所以在 node01上配置成 coordinator,在 node02,node03 上配 置为 worker(如果实际机器数量不多的话可以将在协调器上部署 worker.)在 `/export/servers/presto-server-315/etc`目录下添加 **config.properties** 配置文件

该节点是否作为 coordinator,如果是 true 就允许该 Presto 实例充当协调器

coordinator=true

允许在协调器上调度工作(即配置 worker 节点).为 false 就是不允许.对于较大的集群,协调器上的处理工作可能会影响查询性能,因为机器的资源无法用于调度,管理和监视查询执行的关键任务

如果需要在协调器所在节点配置 worker 节点改为 true 即可

node-scheduler.include-coordinator=false

指定 HTTP 服务器的端口.Presto 使用 HTTP 进行所有内部和外部通信

http-server.http.port=8080

每个查询可以使用的最大分布式内存量

query.max-memory=50GB

#查询可在任何一台计算机上使用的最大用户内存量

query.max-memory-per-node=1GB

查询可在任何一台计算机上使用的最大用户和系统内存量,其中系统内存是读取器,写入器和网络缓冲区等在执行期间使用的内存

query.max-total-memory-per-node=2GB

discover-server 是 coordinator 内置的服务,负责监听 worker

discovery-server.enabled=true

发现服务器的 URI.因为已经在 Presto 协调器中启用了 discovery,所以这应该是 Presto 协调器的 URI

discovery.uri=http://node01:8080

#### 2.7 Log Properties 配置

日志配置文件:`etc/log.properties`。类似Java的日志级别,包括 `INFO`、`DEBUG`、`ERROR`。

com.facebook.presto=INFO

#### 2.8 Catalog Properties 配置

Presto 可以支持多个数据源,在 Presto 里面叫 catalog,这里以配置支持 Hive 的数据源为例,配置一个 Hive 的 catalog :

#在 etc 目录下创建 catalog 目录

[root@node01 etc]# mkdir catalog

**Hive 的 catalog:**

[root@node01 catalog]# vim hive.properties

#代表 hadoop2 代版本,并不是单单指 hadoop2.x 的版本,而是 hadoop 第二代.固定写法

connector.name=node02

#指定 hive 的 metastore 的地址(hive 必须启用 metastore)

hive.metastore.uri=thrift://node01:9083

#如果 hdfs 是高可用必须增加这个配置.如果不是高可用,可省略.如果 Presto 所在的节点>没 有安装 Hadoop,需要从其它 hadoop 节点复制这些文件到 Presto 的节点

hive.config.resources=/export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/core-site.xml, /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/hdfs-site.xml

hive.allow-drop-table=true

hive.storage-format=ORC

hive.metastore-cache-ttl=1s

hive.metastore-refresh-interval=1s

hive.metastore-timeout=35m

hive.max-partitions-per-writers=1000

#### 2.9 分发安装目录到集群中其它节点上

将 node01 上配置好的 presto 安装包分发到集群中的其它节点(这里使用的是自己写的分发脚本)

[root@node01 servers]# xsync script /export/servers/presto-server-315/

#### 2.10 修改 node.id

修改 node02 和 node03 机器上 **node.properties** 配置文件中的 **node.id** (因为每台机器 node.id 必须要不一样)

[root@node02 etc]# vim node.properties

node.id=2

[root@node03 etc]# vim node.properties

node.id=3

#### 2.11 修改 work 节点的配置信息

修改 worker 节点(即 linux122 和 linux123 机器)上的 **config.properties** 配置文件里面的配置内容与 **coordinator** 所在的节点是不一样的

#该节点是否作为 coordinator,因为是 worker 节点,这里是 false

coordinator=false

#访问端口,可以自己指定

http-server.http.port=8080

#每个查询可以使用的最大分布式内存量

query.max-memory=50GB

#查询可在任何一台计算机上使用的最大用户内存量

query.max-memory-per-node=1GB

#查询可在任何一台计算机上使用的最大用户和系统内存量,其中系统内存是读取器,写 入器和网络缓冲区等在执行期间使用的内存

query.max-total-memory-per-node=2GB

#指定 discovery-server 的地址,这样 worker 才能找到它.与上面的端口须一致

discovery.uri=http://node01:8080

#### 2.12 启动服务

启动脚本在安装目录的`bin/launcher`目录下,我们可以使用如下命令作为一个后台进程启动:

bin/launcher start

另外,也可以用在前台启动的方式运行,日志和目录输出将会写入到 `stdout/stderr`(可以使用类似`daemontools`的工具捕捉这两个数据流)

bin/launcher run

启动完之后,日志将会写在`var/log`目录下,该目录下有如下文件:

* `launcher.log`:这个日志文件由 **launcher** 创建,并且server的stdout和stderr都被重定向到了这个日志文件中。这份日志文件中只会有很少的信息,包括:

在server日志系统初始化的时候产生的日志和JVM产生的诊断和测试信息。

`server.log`:这个是 Presto 使用的主要日志文件。一般情况下,该文件中将会包括**server初始化失败时产生的相关信息**。

`http-request.log`: 这是**HTTP请求的日志文件**,包括server收到的每个HTTP请求信息。

启动成功之后,我们可以通过`jps`查看到多了一个 PrestoServer 的进程。

[root@node01 etc]# jps

6051 PrestoServer

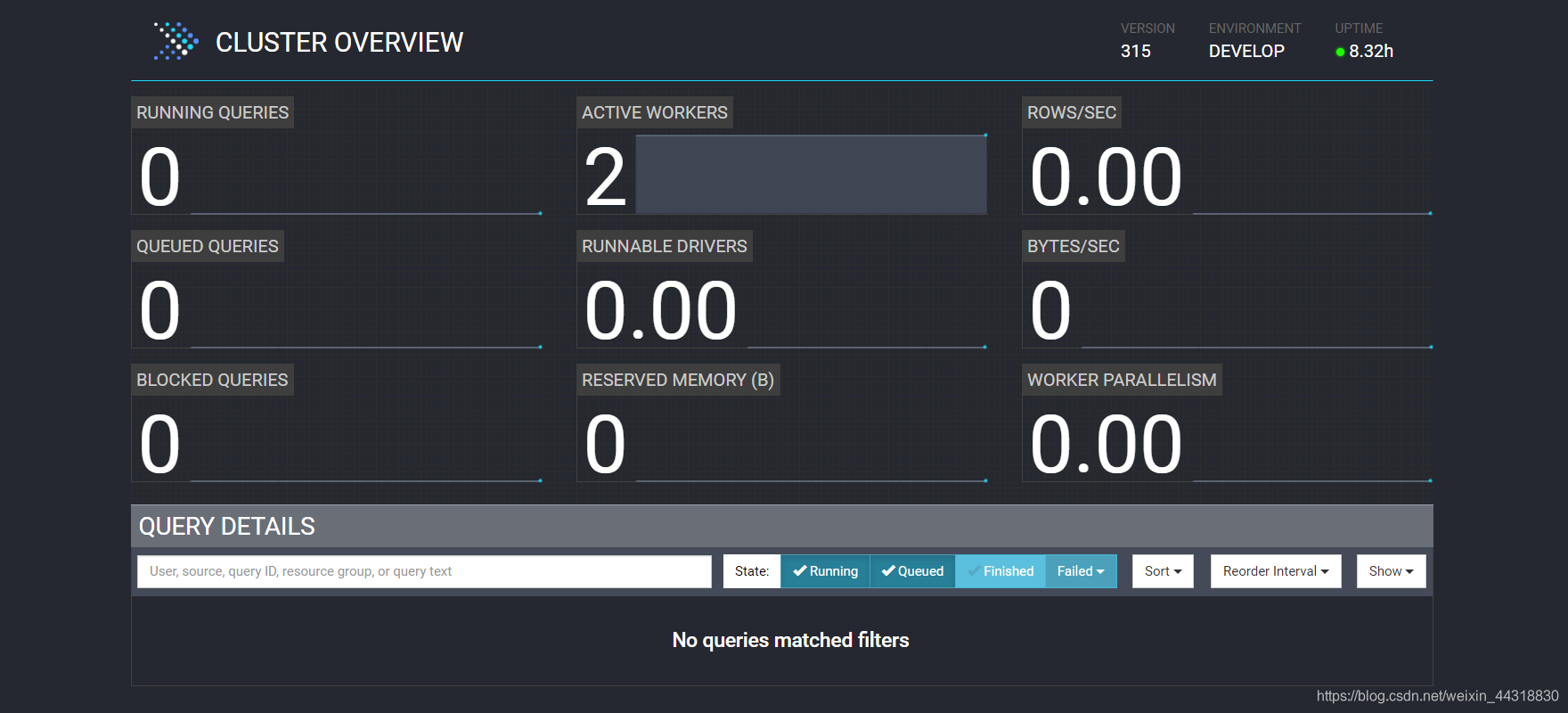

此时我们就可以通过`ip:端口`的方式访问到 presto 的 **webui** 界面。

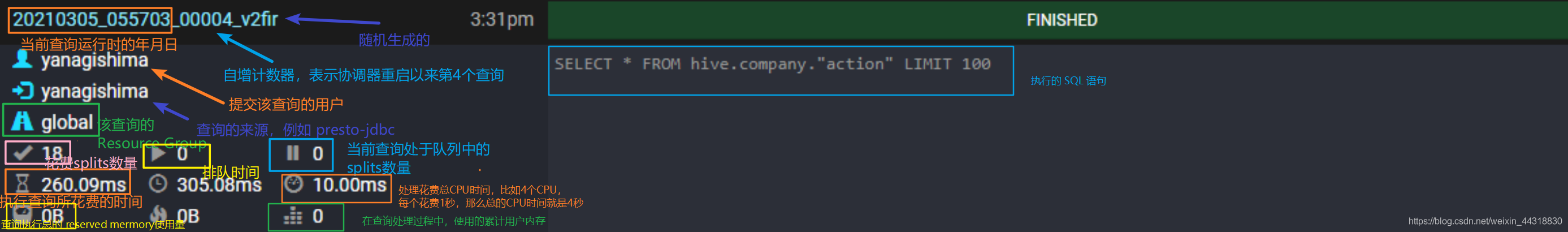

关于 `webui` 中**各项指标的含义**,我整理了2张图,大家可以借鉴一下

另外,关于 Stage,Task 阶段的各参数指标含义,就不细讲了,更多内容详情见官网…

### 3、Presto 命令行 Client 的安装

Presto 的 命令行 Client 下载步骤也很简单:

1、下载 Presto 的客户端(下载 presto 对应的版本)👉<https://repo1.maven.org/maven2/io/prestosql/presto-cli/315/presto-cli-315-executable.jar>

2、将 `presto-cli-315-executable.jar` 上传至服务器,放在 node01 的 `/export/servers/presto-server- 315/bin` 目录下

3、为方便使用,修改 jar 包名称为 presto

[root@node01 bin]$ mv presto-cli-315-executable.jar presto

4. 给文件增加执行权限

[root@node01 bin]# chmod +x presto

### 4、Presto 的基本使用

1、 启动 presto 客户端并选择连接的数据源(这里以 hive 为例)

[root@node01 bin]$ ./presto \

–server node01:8080 \

–catalog hive (可选)

–schema test (可选)

–user xiaobai (可选)

**说明**:

– server 指定的是 `coordinator` 的地址

– catalog 指定的是**连接的数据源**.(跟配置文件里面的名称一致)

– schema 指定的是**连接哪个数据库**,这里是 test 数据库

– user 指定的是**连接使用哪个用户**,这里是xiaobai

2、Presto 命令行操作

#查看所有的数据库

presto:test> show schemas;

#查看某个库下的所有表

presto:test> show tables;

#查看一条 sql 查询(6 亿多条数据比 hive 快很多)

presto:test> select count(1) from test.test_hive;

_col0

620756992

### 5、Presto可视化客户端的安装

Presto 可视化客户端有多种,这里我们选择使用 `yanagishima-20.0` 版本

>

> 本篇文章中谈到的**所有**安装包资源,在公众号【大数据梦想家】后台回复 “presto”即可获得!

>

>

>

* 1、将 yanagishima-20.0.zip 安装包上传至 linux121 服务器上

* 2、解压 yanagishima-20.0.zip 安装包

[root@node01 software]# unzip yanagishima-20.0.zip -d /export/servers/

* 3、.进入到 `/opt/servers/yanagishima-20.0/conf/`目录下,修改 **yanagishima.properties** 配置文件

#指定 jetty 的端口,类似 tomcat 的 web 容器的一个组件

jetty.port=7788

#指定数据源

presto.datasources=presto_test

presto.coordinator.server.presto_test=http://node01:8080

catalog.presto_test=hive

schema.presto_test=ods

sql.query.engines=presto

* 4、启动 yanagishima

[root@node01 yanagishima-20.0]# nohup bin/yanagishima-start.sh 1>/dev/null 2>&1 &

* 5、webUI访问界面

通过`http://node01:7788/`,即可查询到相关信息

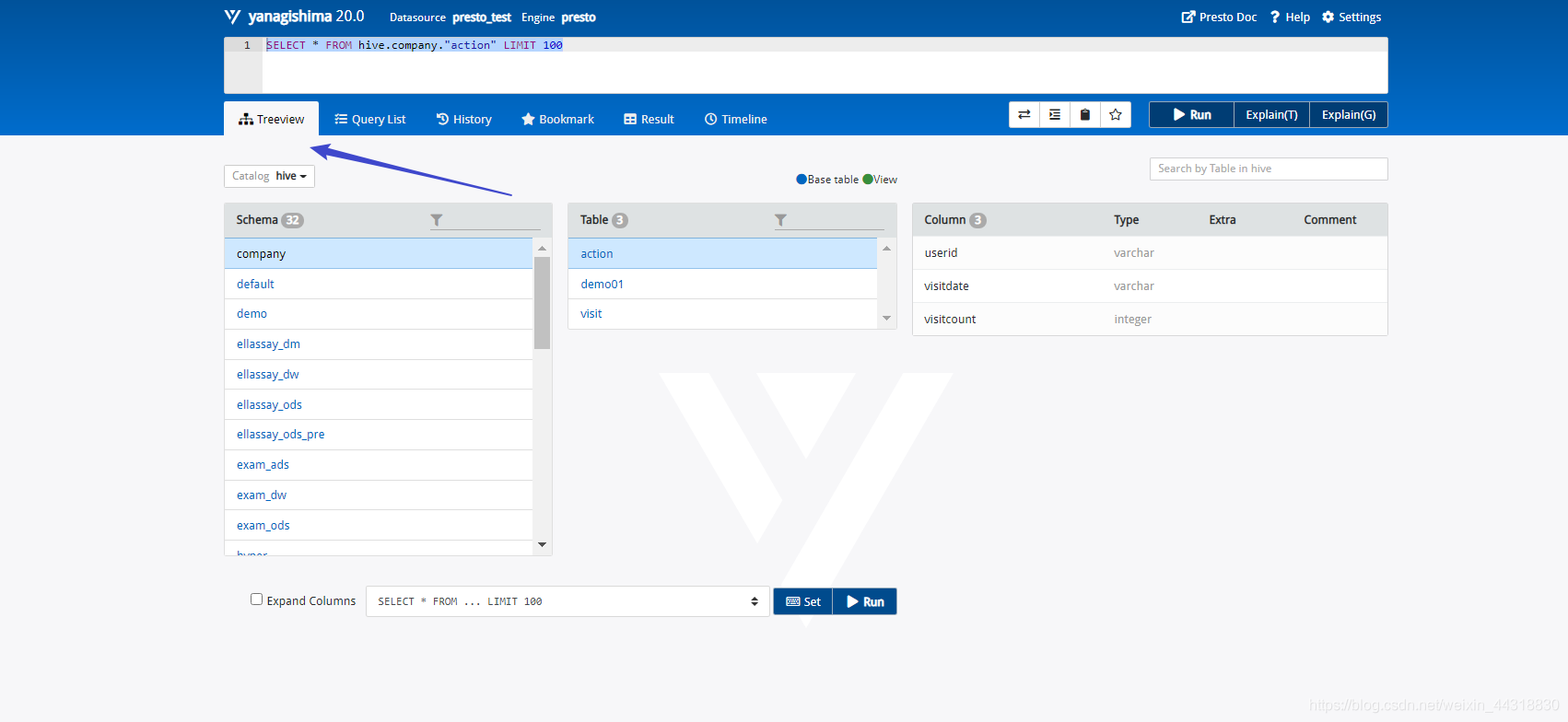

* 6、查看 Presto 表结构,如下图所示:

在“Treeview”页面下可以查看所有表的结构,包括`Schema`,`Table`,`Column`等。

比如,执行`SELECT * FROM hive.company."action" LIMIT 100`

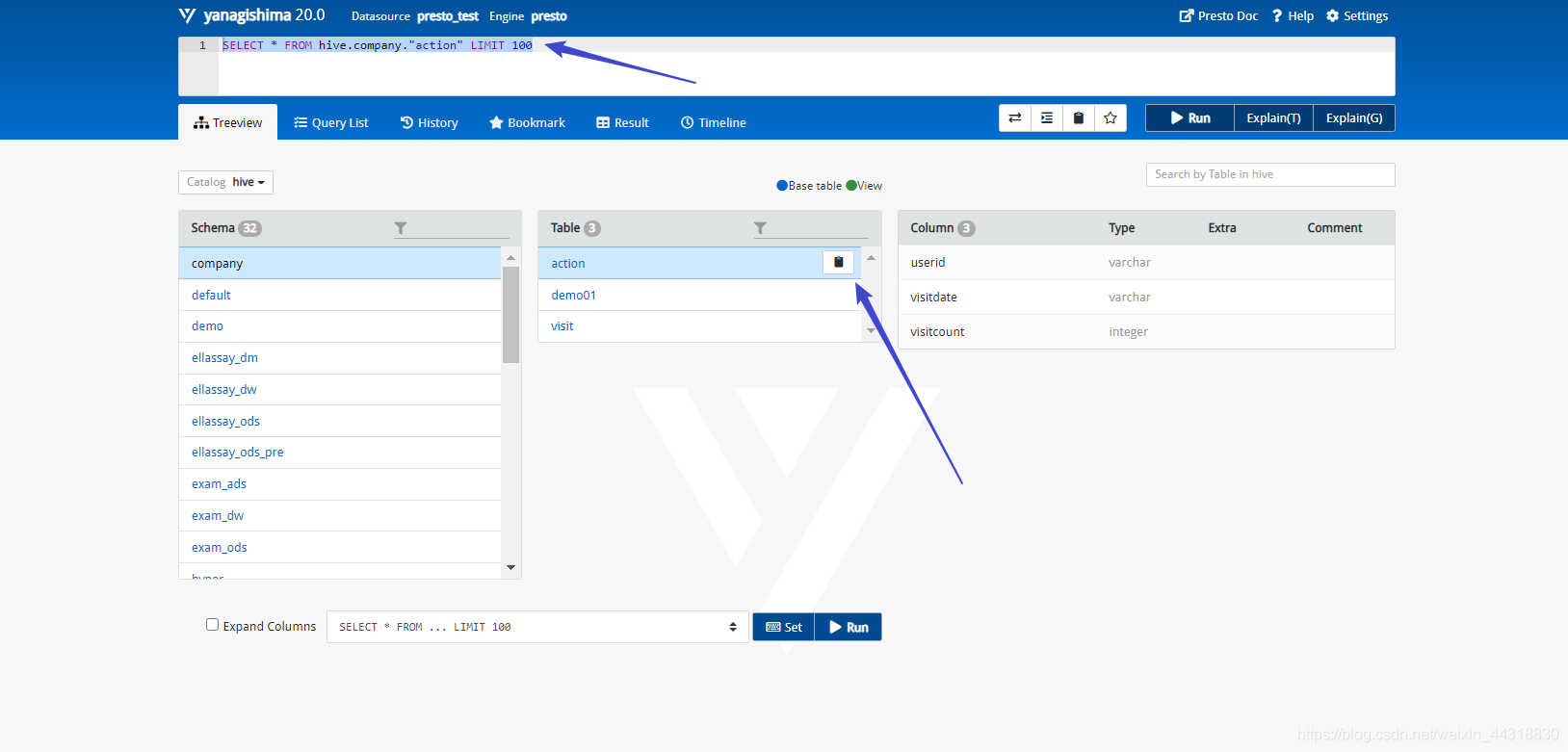

每张表后面都有一个复制图标,单击此图标可以复制完整的表名,然后在上面的文本框中输入 SQL 语句 即可,如图所示:

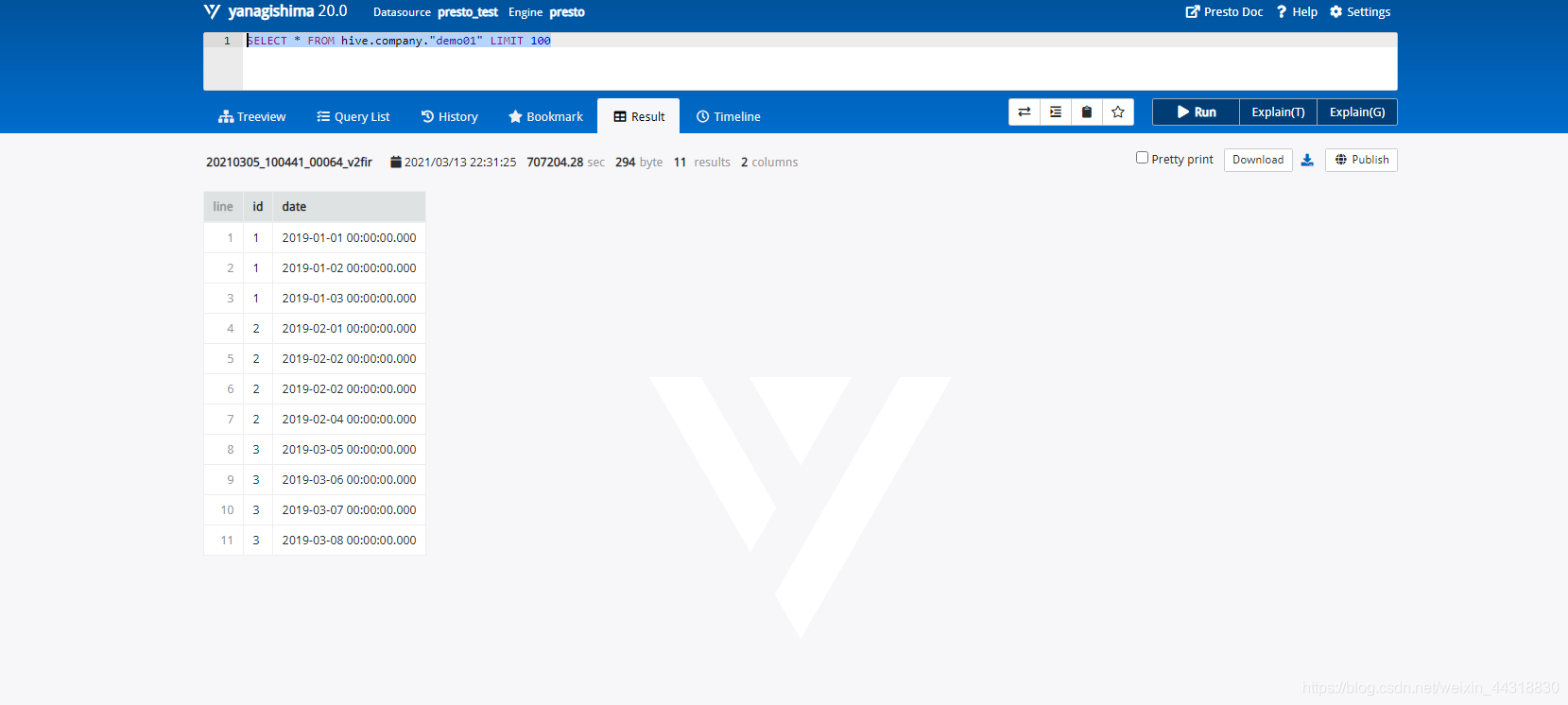

还可以查询列表中其他的表格,比如,想要执行现在已经写好了的SQL语句,`SELECT * FROM hive.company."demo01" LIMIT 100`,按`Ctrl + Enter`组合键显示**查询结果**,如图所示:

当然,我们也可以通过`Query List`模块查询我们执行过的SQL详细信息,包括`State`,`query ID`,`Elapsed`,`Query`,`Source`,`User`…

更多使用,就不一一剧透介绍,小伙伴们可以自行去研究~

### 6、Presto的优化

Presto 的优化是一个非常有水平的问题,大致总结下,分如下几个类别:

#### 6.1 数据存储

想要使用 Presto 更高效地查询数据,需要在数据存储方面利用一些优化手段。

##### 6.1.1 合理设置分区

与 Hive 类似,Presto 会根据元数据信息读取分区数据,**合理地设置分区**能减少 Presto 数据读取量,提升查询性能。

##### 6.1.2 使用 ORC 格式存储

Presto 对 ORC文件 读取进行了特定优化,因此,**在 Hive 中创建 Presto 使用的表时,建议采用 ORC 格式存储**。相对于 Parquet 格式,Presto 对 ORC 格式支持得更好。

##### 6.1.3 使用压缩

**数据压缩可以减少节点间数据传输对 IO 带宽的压力**,对于即席查询需要快速解压,建议采用 `Snappy`压缩。

##### 6.1.4 预先排序

对于已经排序的数据,在查询的数据过滤阶段,ORC格式支持跳过读取不必要的数据。比如对于经常需要过滤的字段可以预先排序。

INSERT INTO table nation_orc partition§ SELECT * FROM nation SORT BY n_name;

如果需要过滤 n\_name 字段,则性能将提升。

SELECT count(*) FROM nation_orc WHERE n_name=’AUSTRALIA’;

#### 6.2 SQL查询

想要使用 `Presto`更高效地查询数据,需要在编写查询SQL语句方面利用一些优化手段。

##### 6.2.1 只选择需要的字段

由于采用列式存储,所以**只选择需要的字段可加快字段的读取速度,减少数据量**。避免采用 \* 读取所有字段。

[GOOD]: SELECT time,user,host FROM tbl

[BAD]: SELECT * FROM tbl

##### 6.2.2 过滤条件必须加上分区字段

**对于有分区的表,where语句中优先使用分区字段进行过滤**。acct\_day 是分区字段,visit\_time 是具体访问时间。

[GOOD]: SELECT time,user,host FROM tbl where acct_day=20171101

[BAD]: SELECT * FROM tbl where visit_time=20171101

##### 6.2.3 Group By语句优化

合理安排 `Group by`语句中**字段顺序对性能有一定提升**。将 Group By 语句中字段按照每个字段 distinct 数据多少进行降序排列。

[GOOD]: SELECT GROUP BY uid, gender

[BAD]: SELECT GROUP BY gender, uid

##### 6.2.4 Order by时使用Limit

Order by 需要扫描数据到单个 worker 节点进行排序,导致单个worker需要大量内存。**如果是查询 Top N 或者 Bottom N,使用 limit 可减少排序计算和内存压力**。

[GOOD]: SELECT * FROM tbl ORDER BY time LIMIT 100

[BAD]: SELECT * FROM tbl ORDER BY time

##### 6.2.5 使用近似聚合函数

Presto有一些近似聚合函数,对于**允许有少量误差**的查询场景,使用这些函数**对查询性能有大幅提升**。比如使用`approx_distinct()`函数比`Count(distinct x)`有大概2.3%的误差。

SELECT approx_distinct(user_id) FROM access

##### 6.2.6 用regexp\_like代替多个like语句

Presto查询优化器没有对多个 `like` 语句进行优化,使用`regexp_like`对性能有较大提升。

[GOOD]

SELECT

…

FROM

access

WHERE

regexp_like(method, ‘GET|POST|PUT|DELETE’)

[BAD]

SELECT

…

FROM

access

WHERE

method LIKE ‘%GET%’ OR

method LIKE ‘%POST%’ OR

method LIKE ‘%PUT%’ OR

method LIKE ‘%DELETE%’

##### 6.2.7 使用Join语句时将大表放在左边

Presto中 join 的默认算法是`broadcast join`,即将 join 左边的表分割到多个 worker ,然后将join 右边的表数据整个复制一份发送到每个worker进行计算。如果右边的表数据量太大,则可能会报内存溢出错误。

[GOOD] SELECT … FROM large_table l join small_table s on l.id = s.id

[BAD] SELECT … FROM small_table s join large_table l on l.id = s.id

##### 6.2.8 使用Rank函数代替row\_number函数来获取Top N

在进行一些分组排序场景时,使用rank函数性能更好

[GOOD]

SELECT checksum(rnk)

FROM (

SELECT rank() OVER (PARTITION BY l_orderkey, l_partkey ORDER BY l_shipdate DESC) AS rnk

FROM lineitem

) t

WHERE rnk = 1

[BAD]

SELECT checksum(rnk)

FROM (

SELECT row_number() OVER (PARTITION BY l_orderkey, l_partkey ORDER BY l_shipdate DESC) AS rnk

FROM lineitem

) t

WHERE rnk = 1

#### 6.3 注意事项

`ORC`和`Parquet` 都支持**列式存储**,但是**ORC对Presto支持更好**(Parquet对Impala支持更好)

对于列式存储而言,存储文件为二进制的,对于经常增删字段的表,建议不要使用列式存储(修改文件元数据代价大)。对比数据仓库,**dwd层建议不要使用ORC,而dm层则建议使用**。

#### 6.4 可能会踩的坑

使用 Presto 需要注意如下几点:

>

> 引用:https://segmentfault.com/a/1190000013120454?utm\_source=tag-newest

>

>

>

##### 6.4.1 如何加快在Presto上的数据统计

很多的时候,在Presto上对数据库跨库查询,例如Mysql数据库。这个时候Presto的做法是从MySQL数据库端拉取最基本的数据,然后再去做进一步的处理,例如统计等聚合操作。

举个例子:

SELECT count(id) FROM table_1 WHERE condition=1;

上面的SQL语句会分为3个步骤进行:

(1)Presto发起到Mysql数据库进行查询

SELECT id FROM table_1 WHERE condition=1;

(2)对结果进行count计算

(3)返回结果

所以说,对于Presto来说,其跨库查询的瓶颈是在数据拉取这个步骤。若要提高数据统计的速度,可考虑**把 Mysql 中相关的数据表定期转移到HDFS中,并转存为高效的列式存储格式ORC**。

所以定时归档是一个很好的选择,这里还要注意,在归档的时候我们要选择一个归档字段,如果是按日归档,我们可以用日期作为这个字段的值,采用`yyyyMMdd`的形式,例如`20180123`.

一般创建归档数据库的SQL语句如下:

CREATE TABLE IF NOT EXISTS table_1 (

id INTEGER,

…

partition_date INTEGER

)WITH ( format = ‘ORC’, partitioned_by = ARRAY[‘partition_date’] );

查看创建的库结构:

SHOW CREATE TABLE table_1; /Only Presto/

带有分区的表创建完成之后,每天只要更新分区字段`partition_date`就可以了,聪明的Presto 就能将数据放置到规划好的分区了。

如果要查看一个数据表的分区字段是什么,可以下面的语句:

SHOW PARTITIONS FROM table_1 /*Only Presto*/

##### 6.4.2 查询条件中尽量带上分区字段进行过滤

如果数据被规当到 HDFS 中,并带有分区字段。在每次查询归档表的时候,要带上分区字段作为过滤条件,这样可以加快查询速度。因为**有了分区字段作为查询条件,就能帮助Presto避免全区扫描,减少Presto需要扫描的HDFS的文件数**。

##### 6.4.3 多多使用 WITH 语句

使用 Presto 分析统计数据时,可考虑把多次查询合并为一次查询,用 Presto 提供的子查询完成。

这点和我们熟知的MySQL的使用不是很一样。

例如:

WITH subquery_1 AS (

SELECT a1, a2, a3

FROM Table_1

WHERE a3 between 20180101 and 20180131

), /*子查询subquery_1,注意:多个子查询需要用逗号分隔*/

subquery_2 AS (

SELECT b1, b2, b3

FROM Table_2

WHERE b3 between 20180101 and 20180131

) /*最后一个子查询后不要带逗号,不然会报错。*/

SELECT

subquery_1.a1, subquery_1.a2,

subquery_2.b1, subquery_2.b2

FROM subquery_1

JOIN subquery_2

ON subquery_1.a3 = subquery_2.b3;

##### 6.4.4 利用子查询,减少读表的次数,尤其是大数据量的表

具体做法是,将使用频繁的表作为一个子查询抽离出来,避免多次 read。

##### 6.4.5 只查询需要的字段

一定要避免在查询中使用 SELECT \* 这样的语句,就像只有告诉我们需要查询数据越具体,工作效率越高。

对于我们的数据库而言也是这样,任务越明确,工作效率越高。

对于要查询全部字段的需求也是这样,没有偷懒的捷径,把它们都写出来。

##### 6.4.6 Join查询优化

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!**

**由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

b1, subquery_2.b2

FROM subquery_1

JOIN subquery_2

ON subquery_1.a3 = subquery_2.b3;

6.4.4 利用子查询,减少读表的次数,尤其是大数据量的表

具体做法是,将使用频繁的表作为一个子查询抽离出来,避免多次 read。

6.4.5 只查询需要的字段

一定要避免在查询中使用 SELECT * 这样的语句,就像只有告诉我们需要查询数据越具体,工作效率越高。

对于我们的数据库而言也是这样,任务越明确,工作效率越高。

对于要查询全部字段的需求也是这样,没有偷懒的捷径,把它们都写出来。

6.4.6 Join查询优化

[外链图片转存中…(img-W1hfmeI4-1714857661736)]

[外链图片转存中…(img-EzA2E6RV-1714857661736)]

[外链图片转存中…(img-VddrFZwx-1714857661737)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

461

461

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?