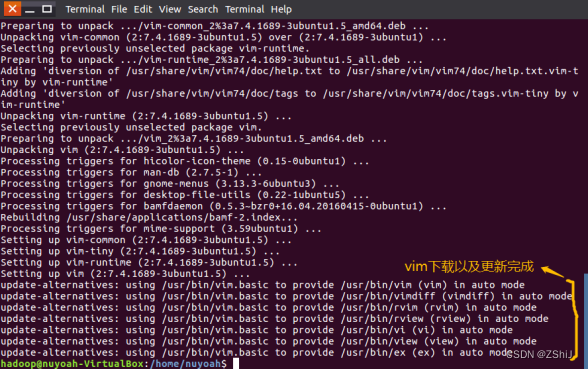

图7:vim编译器安装完成

三、安装 SSH 和配置 SSH 无密码登录

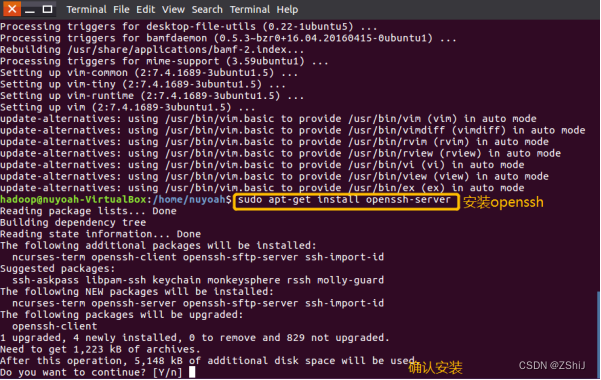

1、安装 SSH 服务端

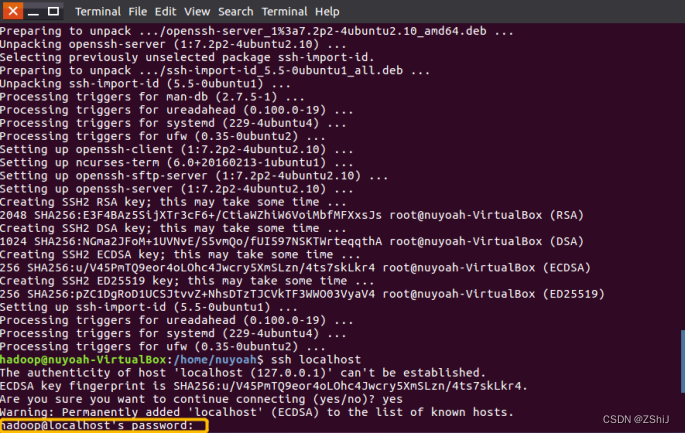

图8:安装 SSH 服务端

在终端输入sudo apt-get install openssh-server安装openssh。(OpenSSH 是 SSH (Secure SHell) 协议的免费开源实现OpenSSH提供了服务端后台程序和客户端工具,用来加密远程控制和文件传输过程中的数据,并由此来代替原来的类似服务。)

当出现Do you want to continue?的时候需要我们输入y进行确认。(这里大小写都可以。)

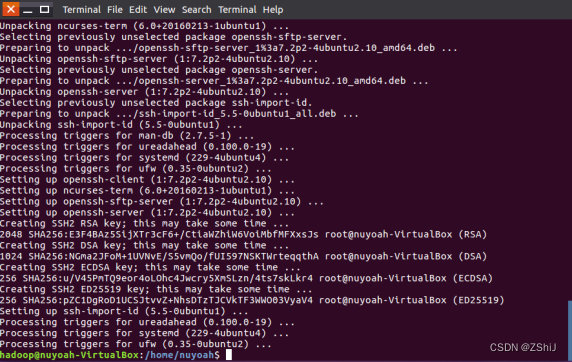

图9: SSH 服务端安装完成

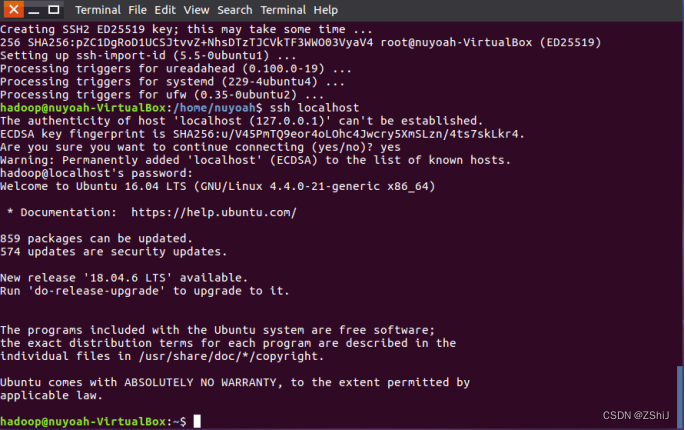

2、登录本机

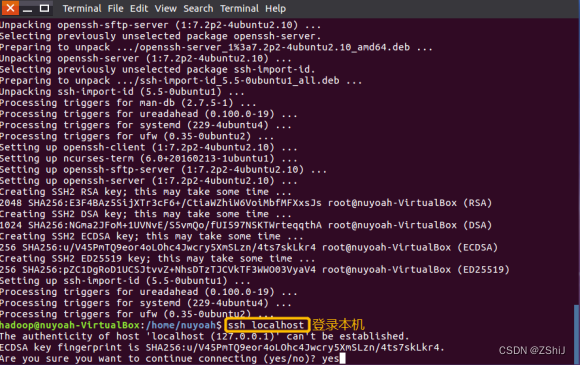

图10:登录本机

在终端输入ssh localhost请求登录本机。注意这里的确认要填的是yes。

图11:输入hadoop用户密码

图12:成功登录本机

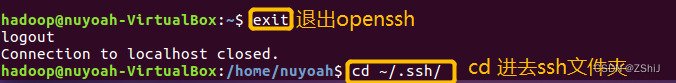

3、配置无密码登录

图13:退出openssh并进去ssh文件夹

在终端输入exit退出openssh,当出现Connection to localhost closed.表示成功退出openssh。接着在终端输入cd ~/.ssh/进入ssh文件夹内。

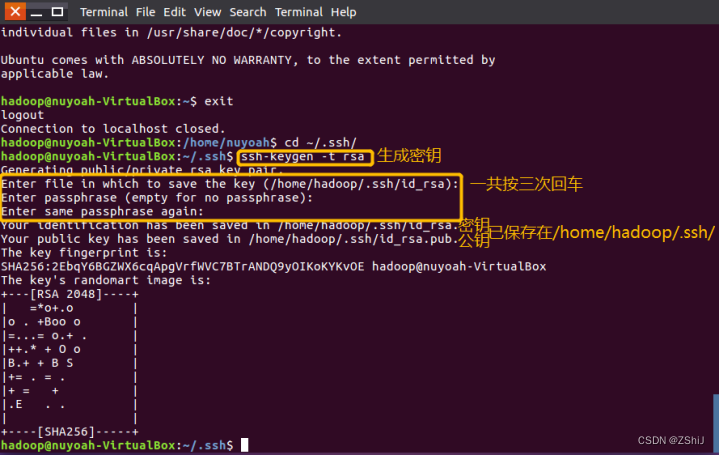

图14:生成密钥并保存

在终端输入ssh-keygen -t rsa生成密钥,接着要等相关指令出来后按enter回车键(一共三次)。完成后我们能看到密钥和公钥都保存在了/home/hadoop/.ssh/里面。

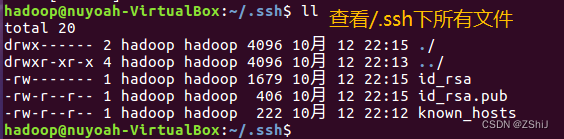

图15:查看/.ssh下的文件

在终端输入ll查看/.ssh下的所有文件,确保密钥和公钥都保存在了这里。

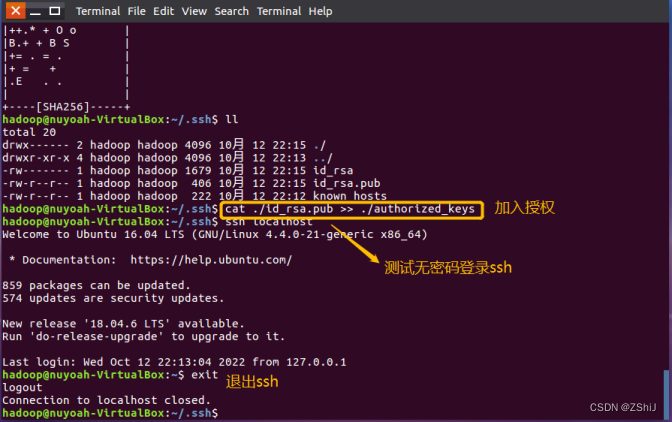

4、确认配置成功

图16:确认配置成功

在终端输入cat ./id_rsa.pub >> ./authorized_kays加入授权,接着输入ssh localhost测试无密码登录ssh,最后输入exit退出ssh。

四、安装 Java

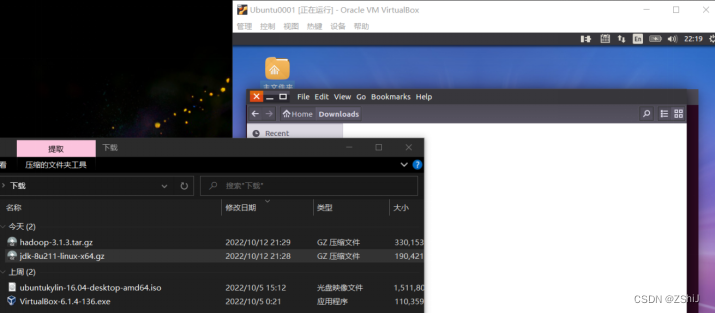

1、拖拽安装包到 downloads

图17:将下载好的安装包拖拽到 Downloads

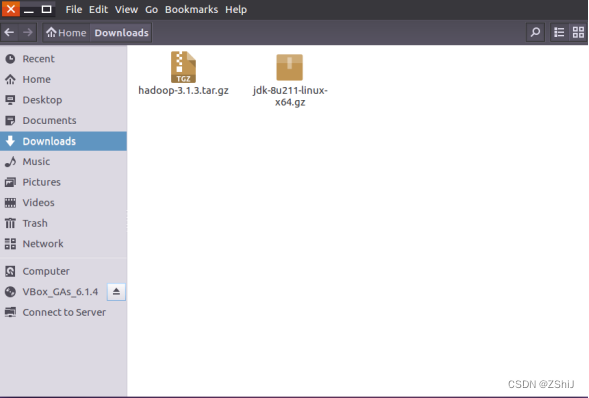

图18:成功拖拽安装包到 Downloads

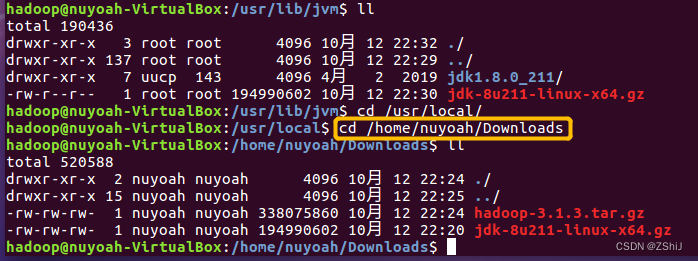

2、Hadoop用户下进入Downloads文件夹

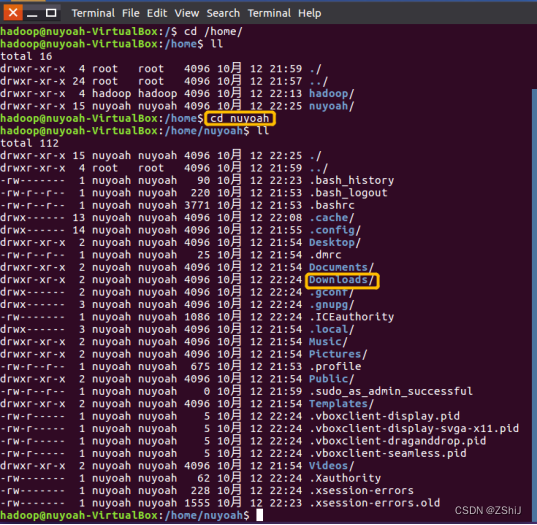

图19:查看Downloads文件夹位置

注意要在Hadoop用户下进入Downloads。(在Ubuntu终端输入su hadoop切换成hadoop用户。)

我这里是将安装包保存在nuyoah/Downloads下。(注意nuyoah是我最开始设置的用户名)通过终端输入ll查看downloads文件夹位置。

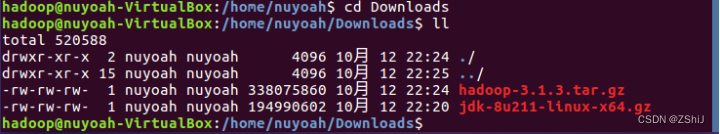

图20:进入Downloads文件夹

进入Downloads文件夹后,在终端输入ll确认Downloads文件夹有刚刚拖进来的安装包。

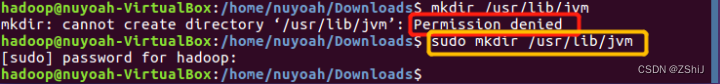

3、创建jvm文件夹

图21:创建jvm文件夹

在终端输入sudo mkdir /usr/lib/jvm创建jvm文件夹。(出现Permission denied错误表示要在指令前加“sudo”。)

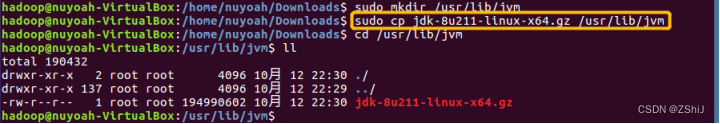

4、将:JDK安装包复制到 jvm 文件夹下

图22:将:JDK安装包复制到 jvm 文件夹

在终端输入sudo cp jdk-8u211-linux-x64.gz /uer/lib/jvm复制JDK安装包到 jvm 文件夹,其中sudo是给权限,cp是复制,jdk-8u211-linux-x64.gz是要复制的文件名,/uer/lib/jvm是要复制到的路径。在终端输入cd /uer/lib/jvm以及ll到目标文件夹下查看是否完成复制。

5、解压

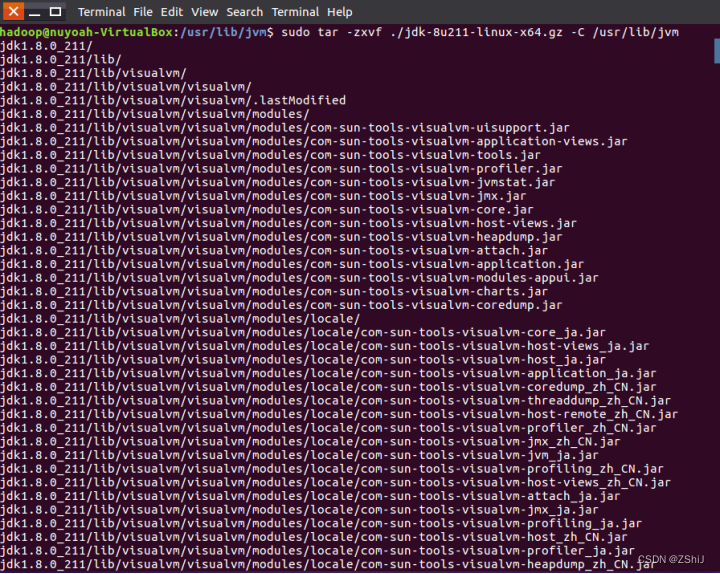

图23:解压jdk

在终端输入sudo tar -zxvf ./jdk-8u211-linux-x64.gz -C /uer/lib/jvm解压指令对jdk文件解压。(-zxvf :z代表gzip的压缩包;x代表解压;v代表显示过程信息;f代表后面接的是文件)

需要记住jdk1.8.0_211/这个文件夹,后面环境配置时需要。

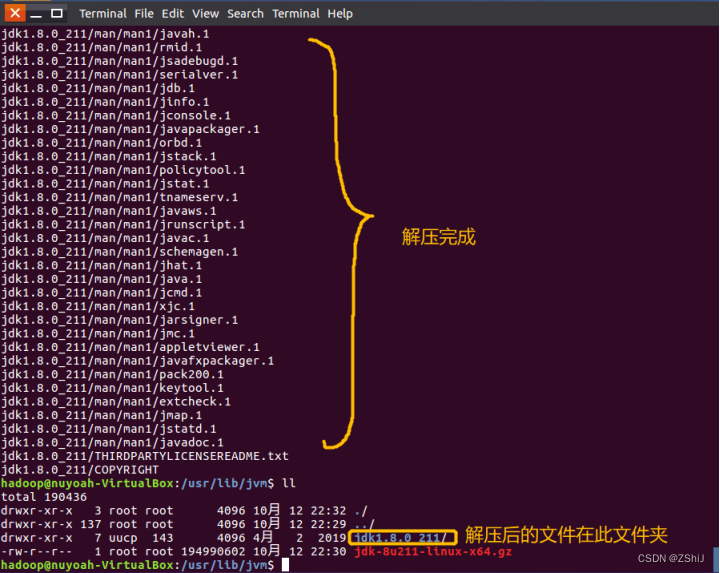

图24:解压完成

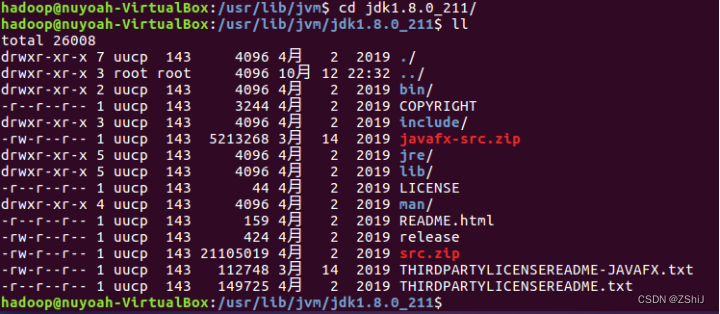

图25:确认解压是否成功

在终端输入cd jdk1.8.0_211/进入该文件夹确认解压是否成功,如果该文件夹为空则前面某一步有问题导致解压不成功,反之则为解压成功。

6、配置环境变量

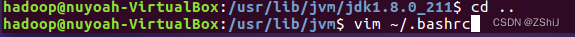

图26:进入环境变量配置

在终端输入cd …返回上一级文件夹,再输入vim ~/.bashrc进入环境变量配置。

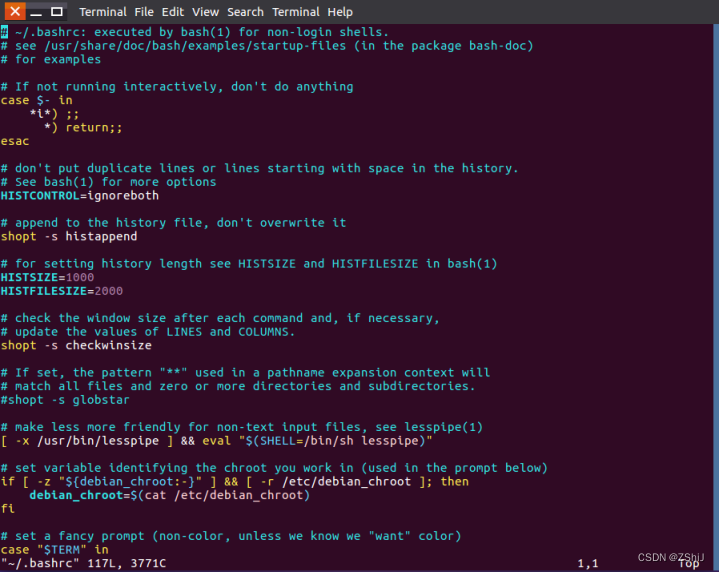

图27:进入环境变量

进入环境变量,此时补课编辑,只可查看。需要按“i”进入 insert 模式。

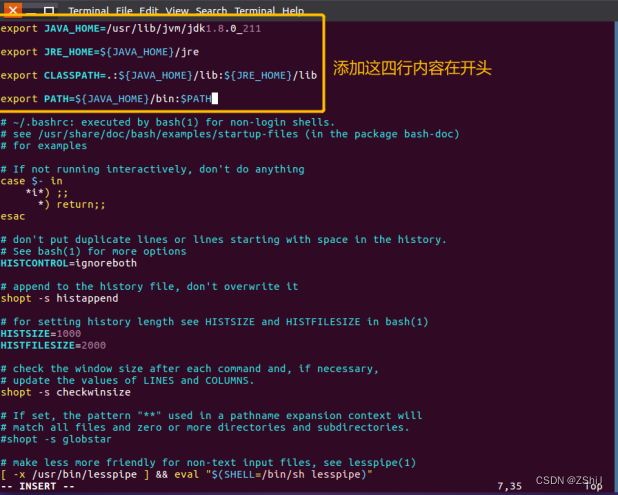

图28:配置环境变量

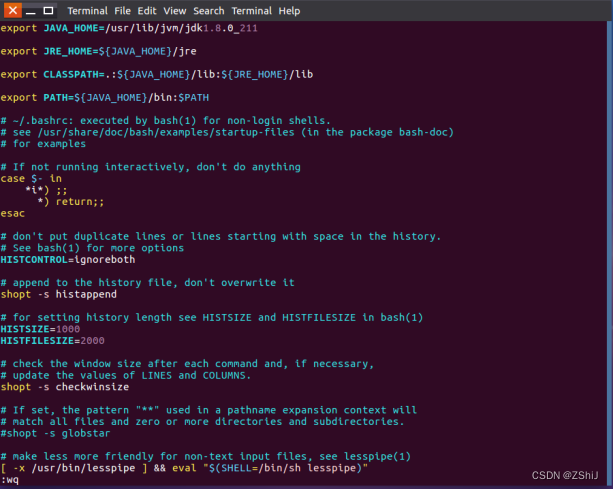

图29:按 ESC 保存,然后 shift+:wq

按 ESC 保存,然后 shift+:wq退出环境配置。

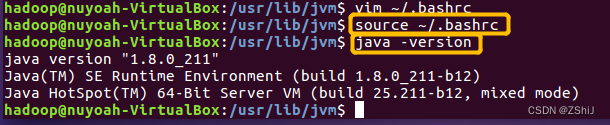

图30:确认jdk安装成功

在终端输入source ~/.bashrc激活刚刚配置的环境变量,接着在终端输入java -version查看java版本,确认jdk安装成功。

五、安装单机 Hadoop

1、确认文件及文件夹

图31:确认文件及文件夹

在终端进入Downloads文件夹确认hadoop的安装包在该文件夹内。

2、解压安装包到/usr/local下

图32:解压安装包到/usr/local

在终端输入sudo tar -zxvf hadoop-3.1.3.tar.gz -C /uer/local解压指令对hadoop文件解压。(-zxvf :z代表gzip的压缩包;x代表解压;v代表显示过程信息;f代表后面接的是文件)

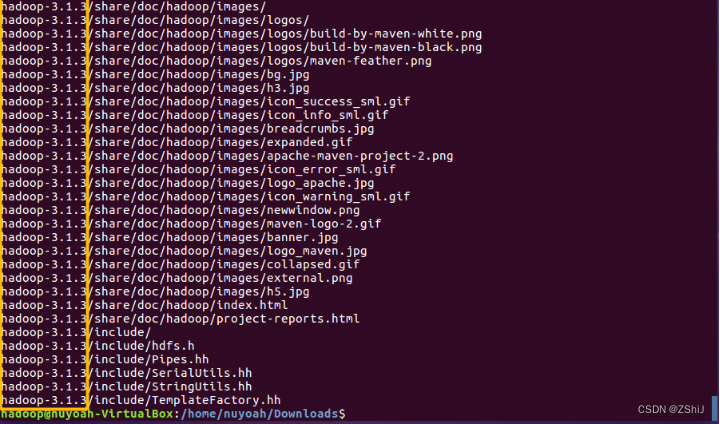

图33:解压完成

Hadoop安装包解压完成,其中hadoop-3.1.3/是解压后的文件夹的名称。

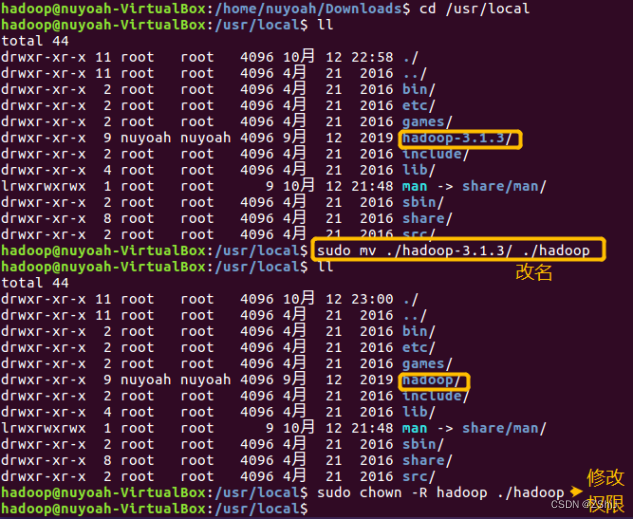

3、修改目录名及目录权限

图34:修改目录名及目录权限

在终端输入cd /uer/local进入local文件夹,通过ll查看改文件夹内的文件。为了方便,通过输入sudo mv ./hadoop-3.1.3/ ./hadoop将文件夹hadoop-3.1.3的名字改成了hadoop。通过输入sudo chown -R hadoop ./hadoop修改权限。

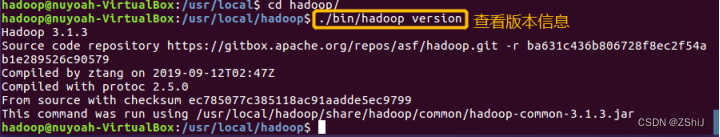

4、查看版本信息

图35:查看版本信息

在终端输入cd hadoop/进入hadoop文件夹,再输入./bin/hadoop version查看版本信息。

5、测试

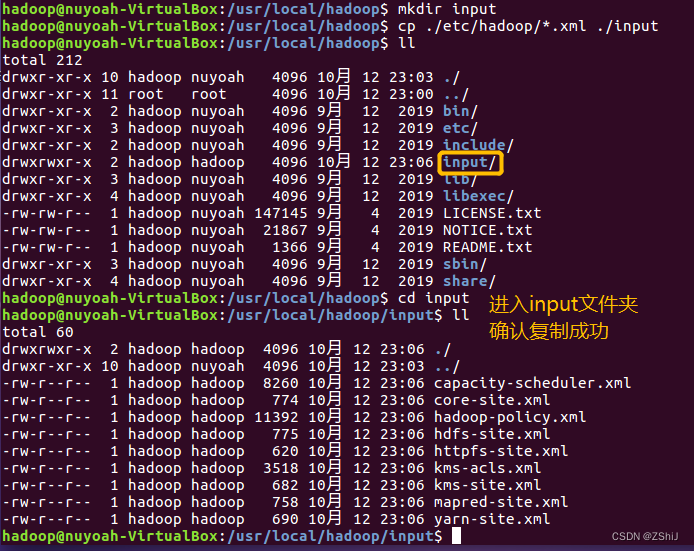

图36:复制文件到新建文件夹input内

在终端输入mkdir input新建文件夹input,接着输入cp ./etc/hadoop/.xml ./input(其中.xml代表所有的.xml文件),此行目的是将uer/local/hadoop/etc/hadoop下的所有的.xml文件复制到input文件夹内。

通过cd input进入input文件夹我们确认了复制成功。

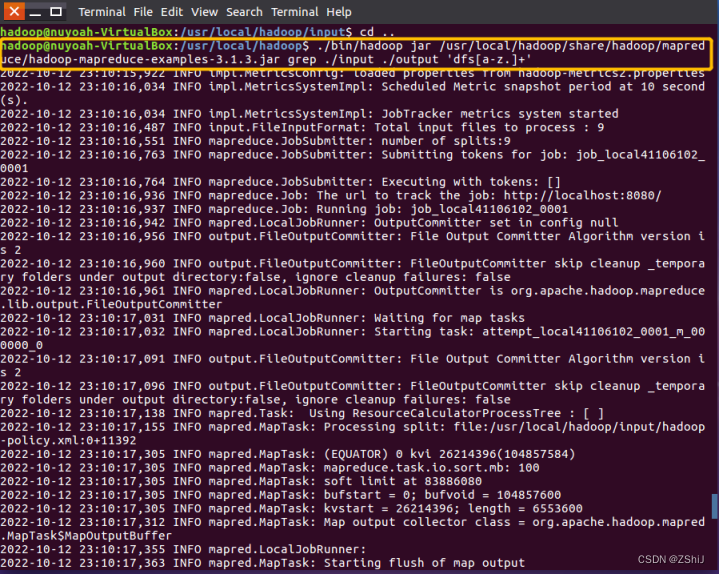

图37:测试

在终端输入./bin/hadoop jar /usr/loacl/hadoop/share/hadoop/mapreduce/

hadoop-mapreduce-examples-3.1.3.jar grep ./input ./output 'dfs[a-z.]+'测试指令进行测试。

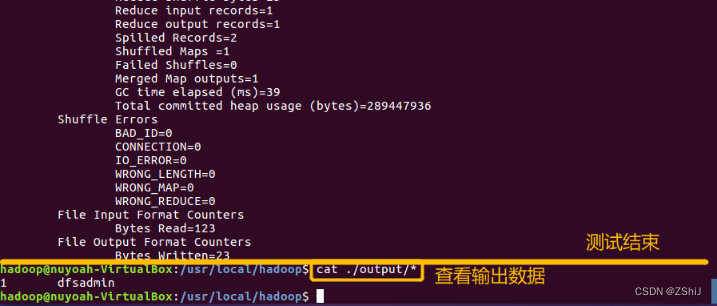

图38:测试完成

测试完成,在终端输入cat ./output/*查看输出数据。

六、Hadoop 伪分布式安装

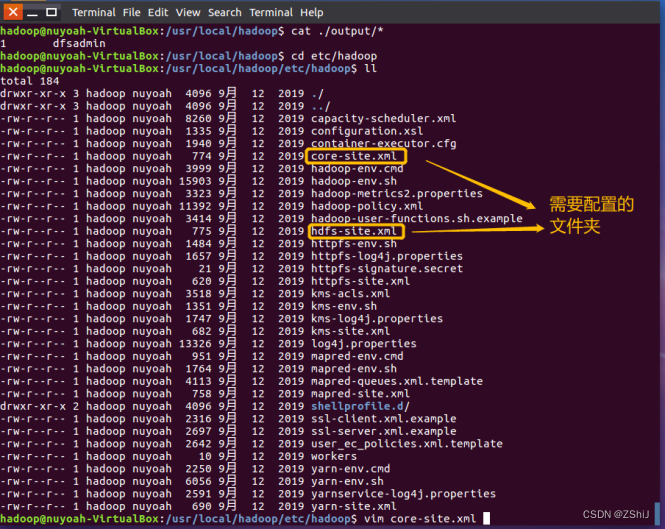

1、修改配置文件(在etc/hadoop下)

图39:查看要修改的配置文件

通过终端cd etc/hadoop进入etc/hadoop查看要修改的配置文件。通过查看得知需要配置core-site.xml和hdfs-site.xml两个文件夹。

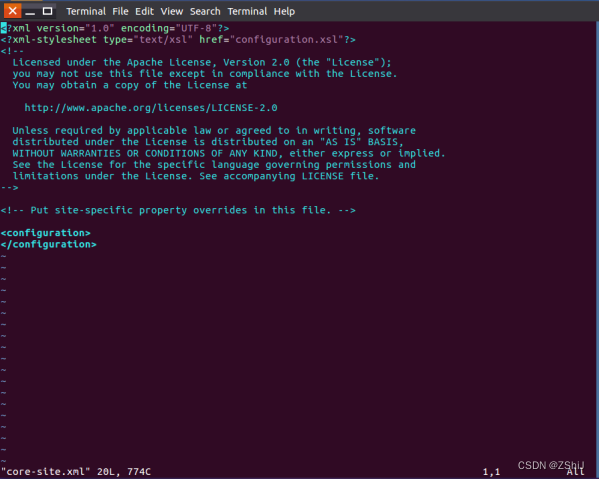

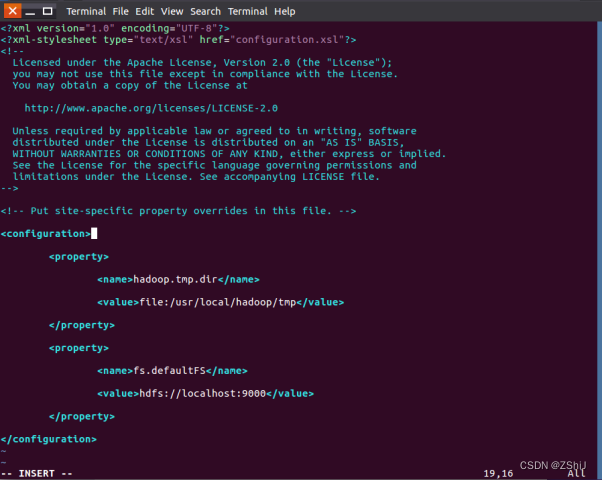

在终端输入vim core-site.xml使用vim编辑器配置。

图40:进入core-site.xml

图41:core-site.xml配置完成

2、配置

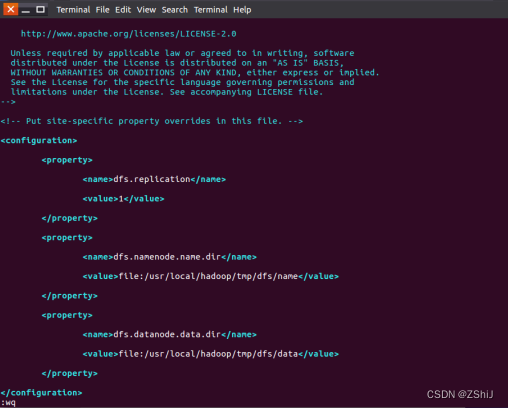

图42:配置hdfs-site.xml

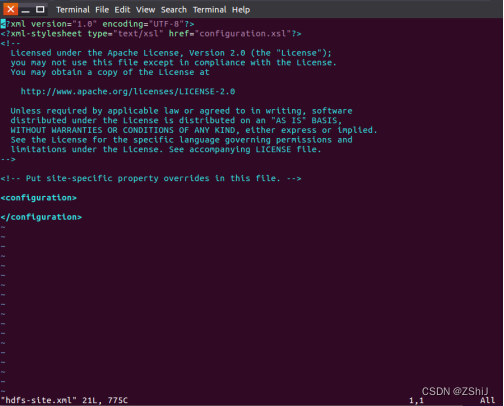

在终端输入vim hdfs-site.xml使用vim编辑器配置。

图43:进入hdfs-site.xml

图44:hdfs-site.xml配置完成

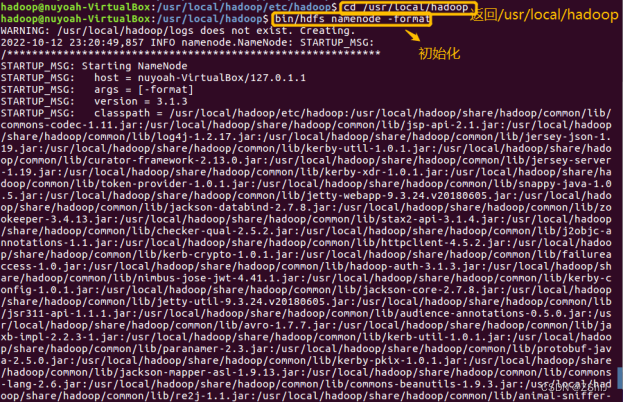

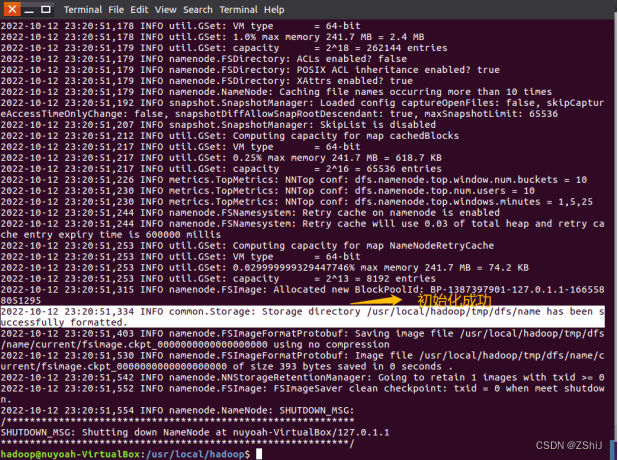

3、初始化

图45:初始化

在终端输入cd /usr/local/hadoop回到/usr/local/hadoop文件夹,再输入bin/hdfs namenode -format进行初始化。

图46:初始化成功

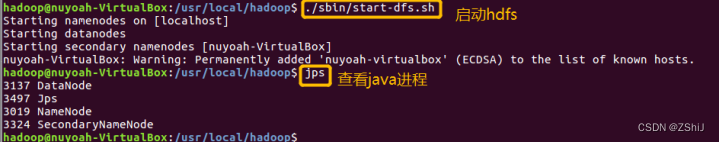

4、启动 hdfs

图47:启动hdfs

在终端输入./sbin/start-dfs.sh启动hsfd,再输入jsp查看java进程。

5、查看 Hadoop(用 Browser)

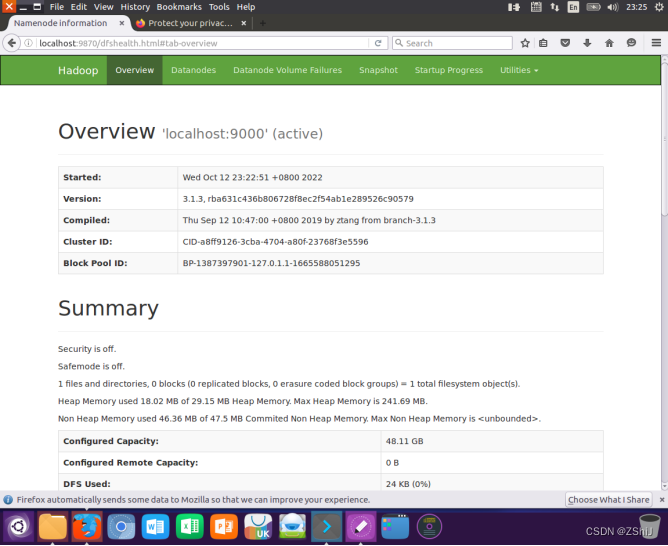

图48:用 Browser查看 Hadoop

注意这里要用Ubuntu自带的浏览器,地址为:http://localhost:9870

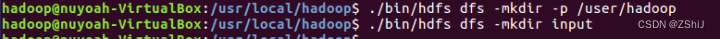

6、创建Hadoop用户的用户目录及input目录

图49:创建 Hadoop 用户的用户目录及 input 目录

在终端输入./bin/hdfs dfs -mkdir -p /usr/hadoop创建Hadoop用户的用户目录,在终端输入./bin/hdfs dfs -mkdir input创建Hadoop用户的input目录。(其中./bin/hdfs dfs是指令前缀,后面是正常的Ubuntu指令。)

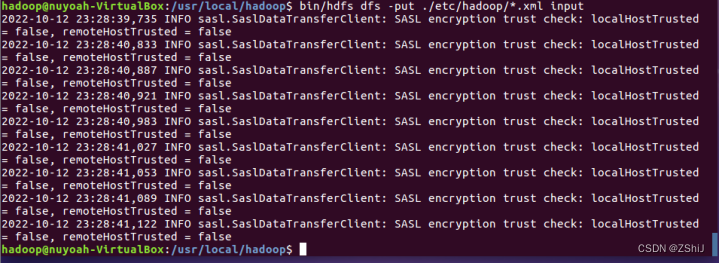

7、将本地配置文件夹上传到分布式文件系统

图50:将本地配置文件夹上传到分布式文件系统

在终端输入bin/hdfs dfs -put ./etc/hadoop/.xml input将本地配置文件夹上传到分布式文件系统.(bin/hdfs dfs是指令前缀,-put是命令,./etc/hadoop/.xml是源,input是目标。)

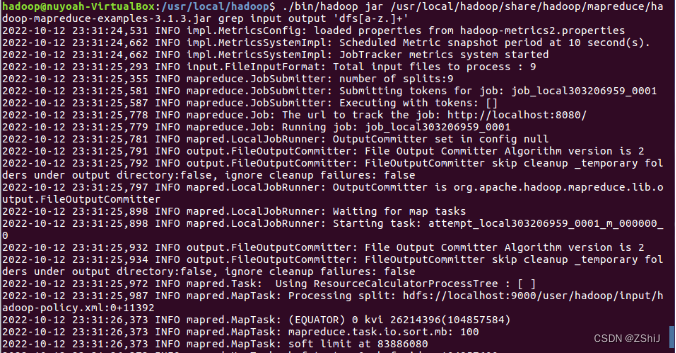

8、测试demo

图51:测试demo

在终端输入./bin/hadoop jar /usr/local/hadoop/share/hadoop/mapreduce/

hadoop-mapreduce-examples-3.1.3.jar grep input output 'dfs[a-z.]+'测试指令进行测试。

注意这里和单机hadoop测试不一样的地方是这里后面是input output,单机时是./input ./output。

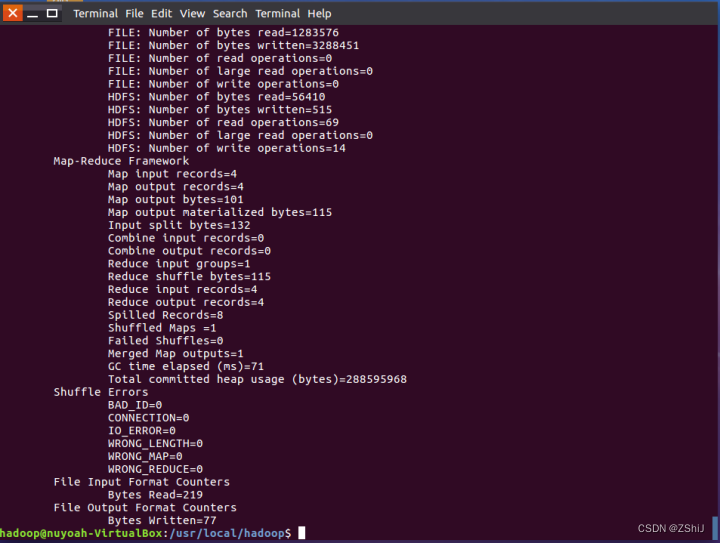

图52:测试完成

9、查看结果

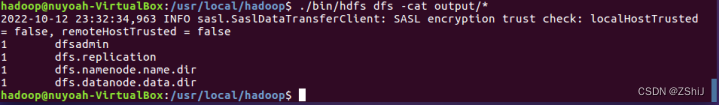

图53:查看测试结果

在终端输入.bin/hdfs dfs -cat output/*查看测试结果。

10、关闭 hdfs

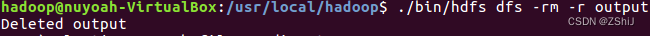

图54:删除output目录

在终端输入.bin/hdfs dfs -rm -r output删除output目录。(每次执行都要吧上一次的output删除,测试过应该是底层写死的无法修改)

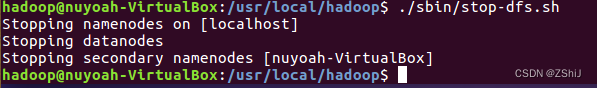

图55:关闭hdfs

在终端输入./sbin/stop-dfs.sh停止执行hdfs。

七、HDFS常用命令

(1)功能:显示

指定的文件的详细信息。

hadoop fs -1s

。

(2)功能:1s 命令的递归版本。

hadoop fs -1s -R。

(3)功能:将

指定的文件的内容输出到标准输出 (stdout )。

hadoop fs -cat

。

(4)功能:将

指定的文件所属的组改为group,使用-R对

指定的文件夹内的文件进行递归操作。这个命令只适用于超级用户。

hadoop fs -chgrp [-RJgroup

。

(5)功能:改变

指定的文件所有者,-R 用于递归改交文件夹内的文件所有者。这个命令只适用于超级用户。

hadoop fs-chown [-R] [owner][ :[group]]

。

(6)功能:将

指定的文件的权限更改为。这个命令只适用于超级用户和文件所有者。

hadoop fs -chmod [- R]

。

(7)功能:将

指定的文件最后 1KB 的内容输出到标准输出 (stdout)上,一f选项用于持续检测新添加到文件中的内容。

hadoop fs -tail [-f]

。

(8)功能:以指定的格式返回

指定的文件的相关信息。当不指定format 的时候,返回文件

的创建日期。

hadoop fs -stat [format]

。

(9)功能:创建一个

指定的空文件。

hadoop fs -touchz

。

(10)功能:创建指定的一个或多个文件夹,-p选项用于递归创建子文件夹。

hadoop fs -mkdir [-p] 。(11)功能:将本地源文件复制到路径指定的文件或文件夹中。

hadoop fs -copy FromLocal 。(12)功能:将日标文件复制到本地文件或文件夾中,可用-ignorearc 选项复制CRC

校验失败的文件,使用-crc选项复制文件以及 CRC信息。

hadoop ts -copyToLocal [-ignorecrc][-crc] 。(13)功能:将文件从源路径复制到日标路径。

hadoop fs -cp 。(14)功能:显示

指定的文件或文件夾中所有文件的大小。

hadoop fs -du

。

(15)功能:清空回收站.

hadoop fs -expunge。(16)功能:复制指定的文件到本地文件系统-指定的文件或文件夹,可用-ignorecrc 选项复制 CRC

校验失败的文件,使用-crc 选项复制文件以及 CRC信息。

hadoop fs-get [ignorecrc] [-crc] 。(17)功能:对指定的源目录中的所有文件进行合并,写入指定的本地文件。-nl

是可选的,用于指定在每个文件结尾添加一个换行符。

hadoop fs -getmerge [-nl] 。(18)功能:以本地文件系统中复制<1ocalsrc>指定的单个或多个源文件到指定的目标文件系统中,也支持从标准输人(stdin

)中读取输人并写人目标文件系统。

hadoop fs-put 。(19)功能:与put 命令功能相同,但是文件上传结束后会从本地文件系统中删除指定的文件。

hadoop fs-moveFromLocal 。(20)功能:将文件从源路径移动到目标路径

hadoop fs -mv 。(21)功能:删除

指定的文件,只删除非室日录和文件。

hardoop 1s -rm

。

(22)功能:除

指定的文什实及其下的所有文件,-r选项表示删除子目录。

hadop fs -rm -r

。

(23)功能:改变

指定的文件的副本系数,-R 选项用于递归政变目录下所有文件的副本系数。

hadoop fs-setrep [-R]

。

(24)功能:检查

指定的文什或文件夾的相关信息。不同选项的作用如下。

hadoop fs -test -[ezd]

。 ①-e检查文件是否存在,如果存在则返回0,否则返回 1。 ②-z检查文件是否是 0字节,如果是则返回 0,否则返回1。 ③ -d如果路径是个日录,则返回1,否则返回 0。

(25)功能:将

指定的文什输出为文木格式,文件的格式世允许是zip和TextRecordinputStream 等

hadoop ts -text

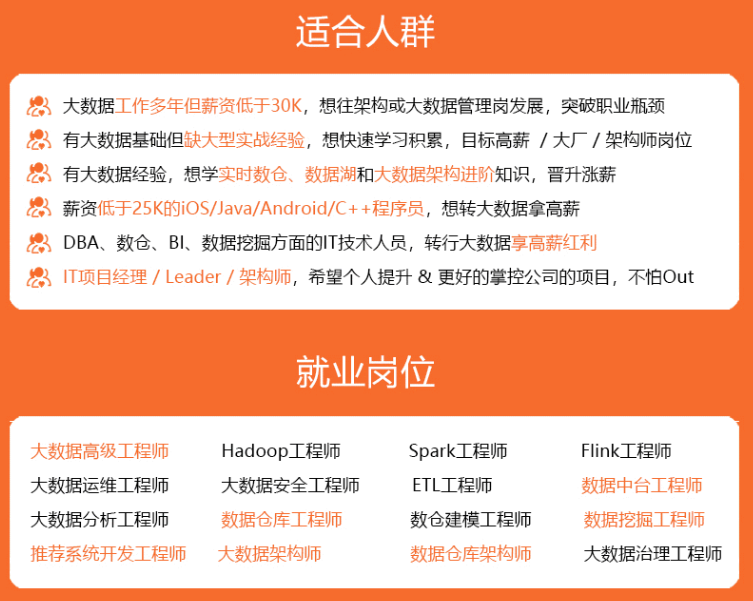

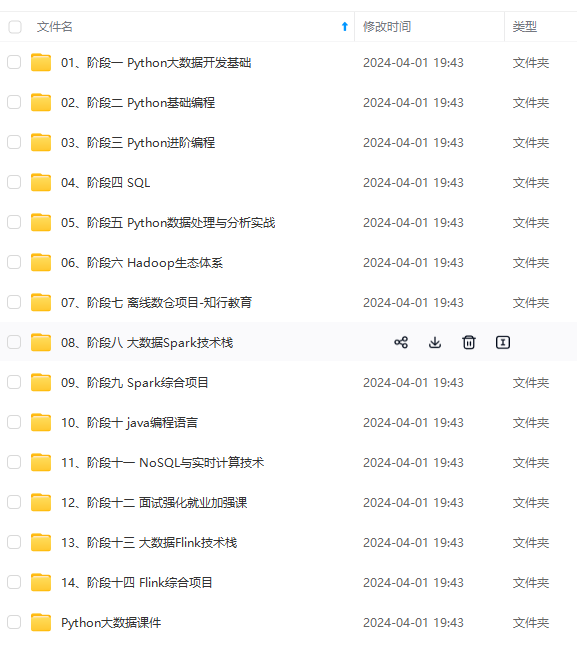

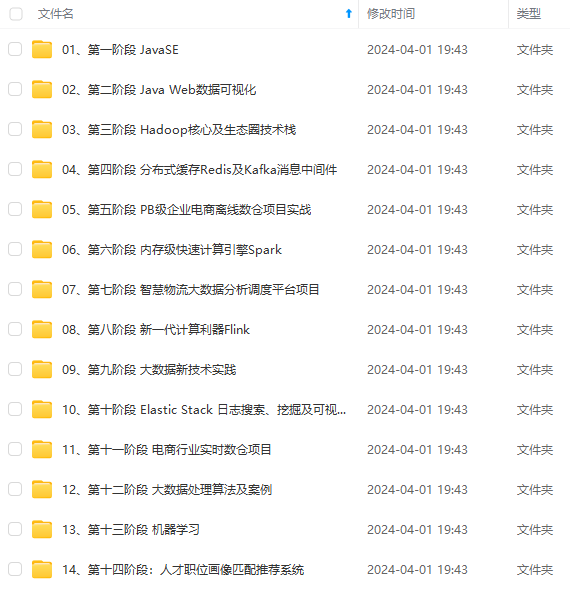

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

(24)功能:检查

指定的文什或文件夾的相关信息。不同选项的作用如下。

hadoop fs -test -[ezd]

。 ①-e检查文件是否存在,如果存在则返回0,否则返回 1。 ②-z检查文件是否是 0字节,如果是则返回 0,否则返回1。 ③ -d如果路径是个日录,则返回1,否则返回 0。

(25)功能:将

指定的文什输出为文木格式,文件的格式世允许是zip和TextRecordinputStream 等

hadoop ts -text

[外链图片转存中…(img-EA1r7MAe-1714296323967)]

[外链图片转存中…(img-BbYDYSTK-1714296323968)]

[外链图片转存中…(img-t1uBX0nM-1714296323968)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

本文详细介绍了在Ubuntu系统上安装和配置SSH服务,无密码登录,安装Java,单机Hadoop的安装、测试和配置,以及HDFS的伪分布式安装步骤,包括常用HDFS命令的说明。

本文详细介绍了在Ubuntu系统上安装和配置SSH服务,无密码登录,安装Java,单机Hadoop的安装、测试和配置,以及HDFS的伪分布式安装步骤,包括常用HDFS命令的说明。

3337

3337

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?