-- 进入hosts文件,配置一下ip和hostname

[root@master ~]# sudo vi /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.81.200 master <=添加本机的静态IP和本机的主机名之间的映射关系

3.4 确保ssh对localhost的免密登陆认证有效

-1. 使用rsa加密技术,生成公钥和私钥。一路回车即可

[root@master ~]# ssh-keygen -t rsa

-2. 进入~/.ssh目录下,将id_rsa.pub复制一份文件,文件名为authorized_keys。保证此文件的权限是600

[root@master ~]# cd ~/.ssh

[root@master .ssh]# cp id_rsa.pub authorized_keys

或者使用ssh-copy-id命令

[root@master .ssh]# ssh-copy-id -i id_ras.pub root@master

-3. 进行验证:

[hadoop@master .ssh]# ssh localhost

#输入yes后,不提示输入密码就对了

3.5 安装Jdk和Hadoop,配置相关环境变量

-1. 上传和解压两个软件包

[root@master ~]# cd /opt/software/

[root@master software]# tar -zxvf jdk-8u221-linux-x64.tar.gz -C /opt/apps/

[root@master software]# tar -zxvf hadoop-2.7.6.tar.gz -C /opt/apps/

-2. 进入apps里,给两个软件更名

[root@master software]# cd /opt/apps/

[root@master apps]# mv jdk1.8.0_221/ jdk

[root@master apps]# mv hadoop-2.7.6/ hadoop

-3. 配置环境变量

[hadoop@master apps]# vi /etc/profile

.....省略...........

#java environment

export JAVA_HOME=/opt/apps/jdk

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH

#hadoop environment

export HADOOP_HOME=/opt/apps/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

4 伪分布式相关文件的配置

4.1 core-site.xml的配置

[root@master ~]# cd $HADOOP_HOME/etc/haoop

[root@master hadoop]# vi core-site.xml

<configuration>

<!-- 配置分布式文件系统的schema和ip以及port,默认8020-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost/</value>

</property>

</configuration>

扩展: hadoop1.x的默认端口是9000,hadoop2.x的默认端口是8020,使用哪一个都可以

4.2 hdfs-site.xml的配置:

[root@master hadoop]# vi hdfs-site.xml

<configuration>

<!-- 配置副本数,注意,伪分布模式只能是1。-->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

4.3 hadoop-env.sh的配置:指定jdk的环境

[root@master hadoop]# vi hadoop-env.sh

................

# The java implementation to use.

export JAVA_HOME=/opt/apps/jdk

..................

5 格式化NameNode

5.1 格式化命令

[root@master hadoop]# hdfs namenode -format

5.2 格式化的日志解读

6 启动HDFS

6.1 启动伪分布式

[root@master hadoop]# start-dfs.sh

6.2 启动滚动信息说明

6.3 jps命令查看守护进程

从上图我们可以看到,启动脚本会开启分布式文件系统上的相关进程:

namenode

datanode

secondary namenode

7 WebUI_50070

可以在浏览器上输入:192.168.10.200:50070 来查看一下伪分布式集群的信息

--1. 浏览一下页面上提示的ClusterID,BlockPoolID

--2. 查看一下活跃节点(Live Nodes)的个数,应该是1个

8 程序案例演示:wordcount程序

8.1 准备要统计的两个文件,存储到~/data/下

--1. 创建data目录

[root@master hadoop]# mkdir ~/data

--2. 将以下两个文件上传到data目录下

- poetry1.txt

- poetry2.txt

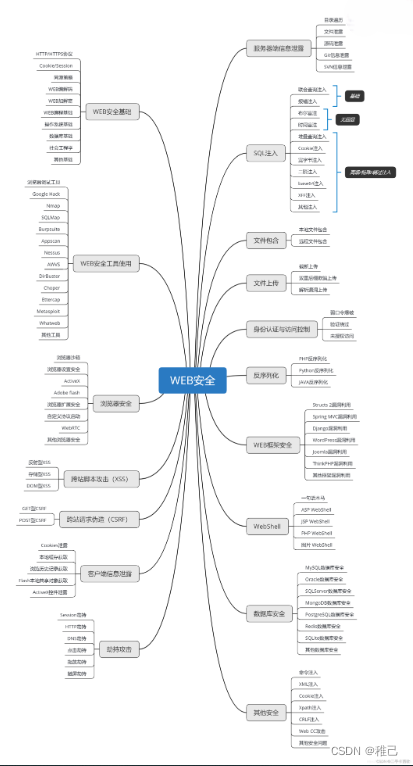

学习路线:

这个方向初期比较容易入门一些,掌握一些基本技术,拿起各种现成的工具就可以开黑了。不过,要想从脚本小子变成黑客大神,这个方向越往后,需要学习和掌握的东西就会越来越多以下是网络渗透需要学习的内容:

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

3755

3755

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?