Python爬虫入门教程23:A站视频的爬取,解密m3u8视频格式

PS:如有需要 Python学习资料 以及 解答 的小伙伴可以加点击下方链接自行获取

-

Python 3.6

-

Pycharm

import requests

import parsel

import re

import os

import pdfkit

安装Python并添加到环境变量,pip安装需要的相关模块即可。

需要使用到一个软件 wkhtmltopdf 这个软件的作用就是把html文件转成PDF

(软件可以点击上方链接在学习交流群中即可获取)

想要把文档内容保存成PDF, 首先保存成html文件, 然后把html文件转PDF

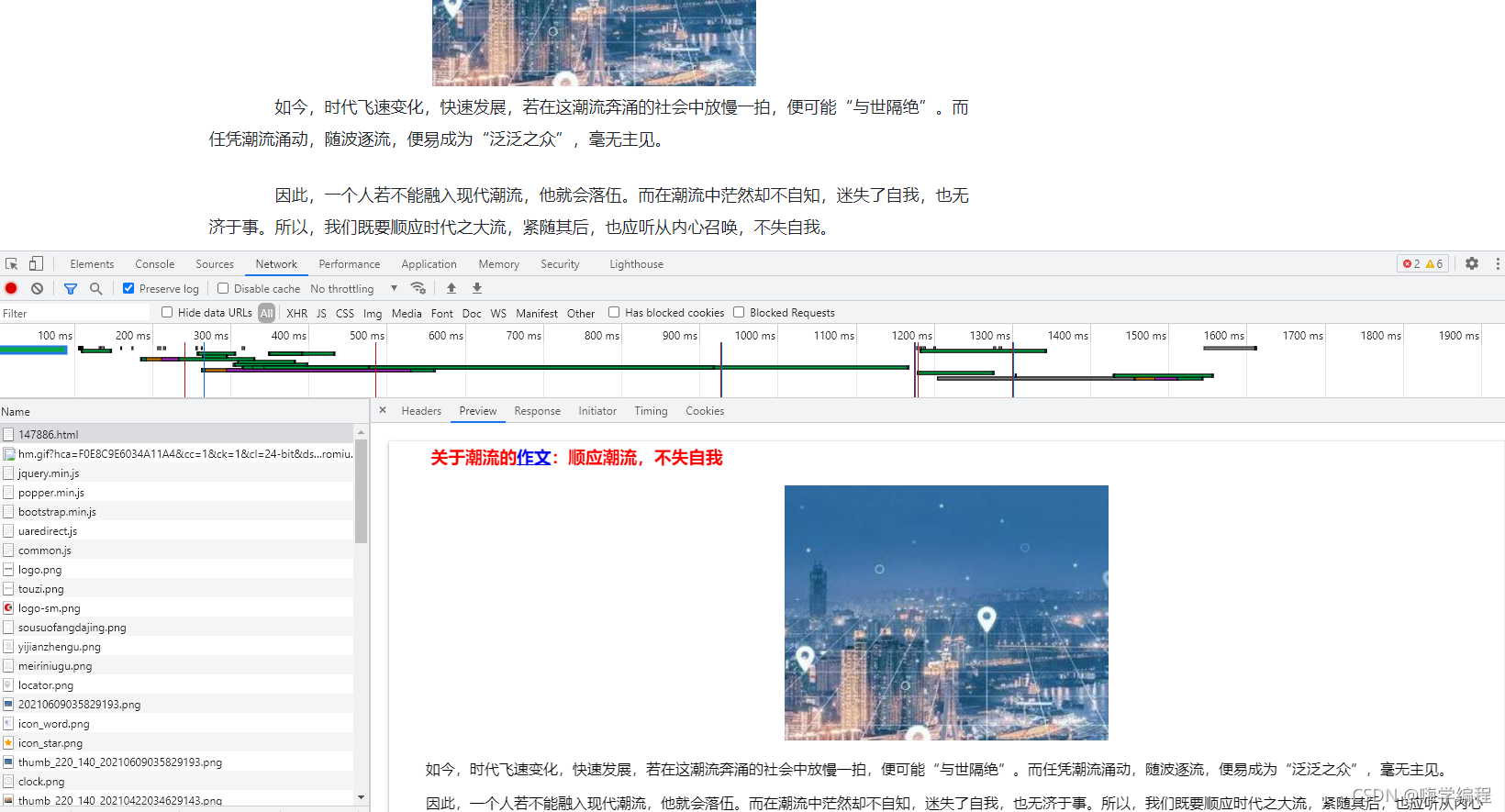

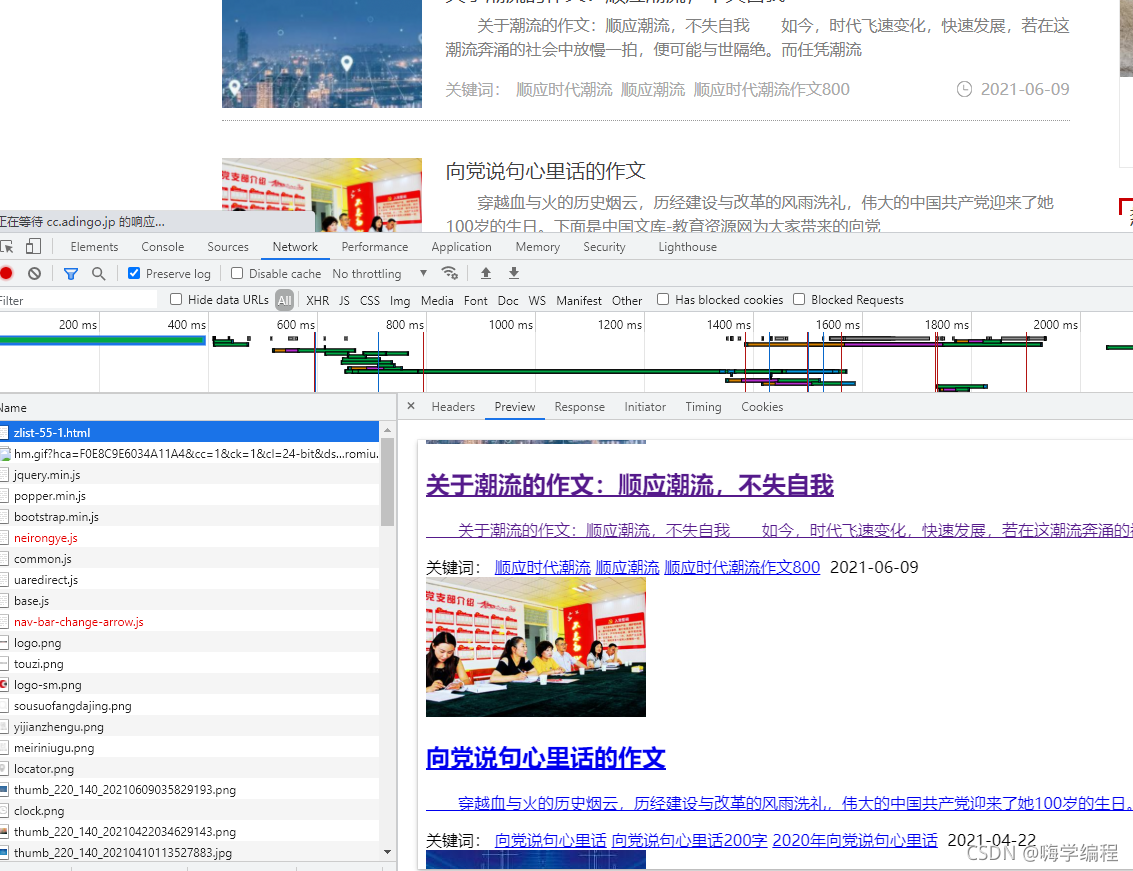

写爬虫程序,对于数据来源的分析,是比较重要的,因为只有当你知道数据的来源你才能通过代码去实现

网站分类有比较多种, 也可以选择自己要爬取的。

这个网站如果你只是正常直接去复制文章内容的话,会直接弹出需要费的窗口…

但是这个网站上面的数据内容又非常好找, 因为网站本身仅仅只是静态网页数据,可以直接获取相关的内容。

通过上述内容,如果想要批量下载文章内容, 获取每篇文章的url地址即可, 想要获取每篇文章的url地址,这就需要去文章的列表页面找寻相关的数据内容了。

-

发送请求,对于文章列表url地址发送请求

-

获取数据,获取网页源代码数据内容

-

解析数据,提取文章url地址

-

发送请求,对于文章url地址发送请求

-

获取数据,获取网页源代码数据内容

-

解析数据,提取文章标题以及文章内容

-

保存数据,把获取的数据内容保存成PDF

-

转成PDF文件

import requests

import parsel

import re

import os

import pdfkit

html_filename = ‘html\’

if not os.path.exists(html_filename):

os.mkdir(html_filename)

pdf_filename = ‘pdf\’

if not os.path.exists(pdf_filename):

os.mkdir(pdf_filename)

html_str = “”"

<!doctype html>

{article}

“”"

最后

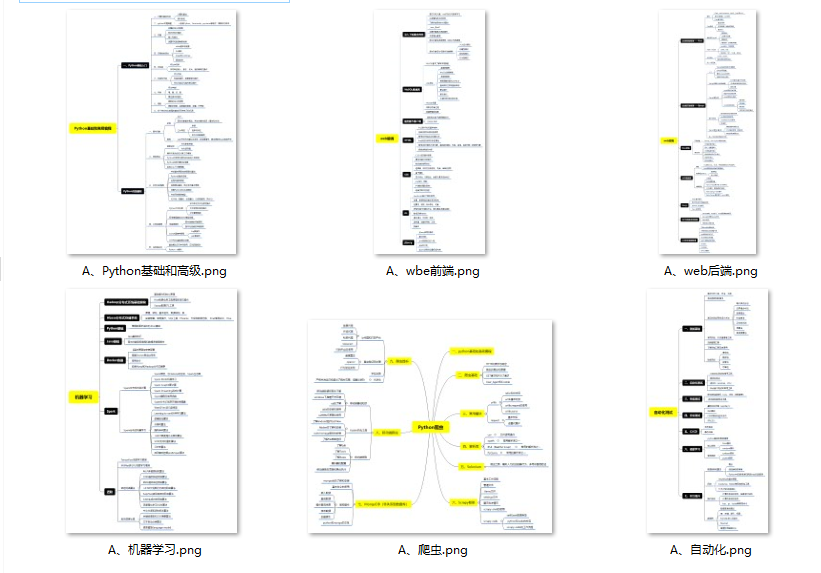

Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习 Python 门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

👉Python所有方向的学习路线👈

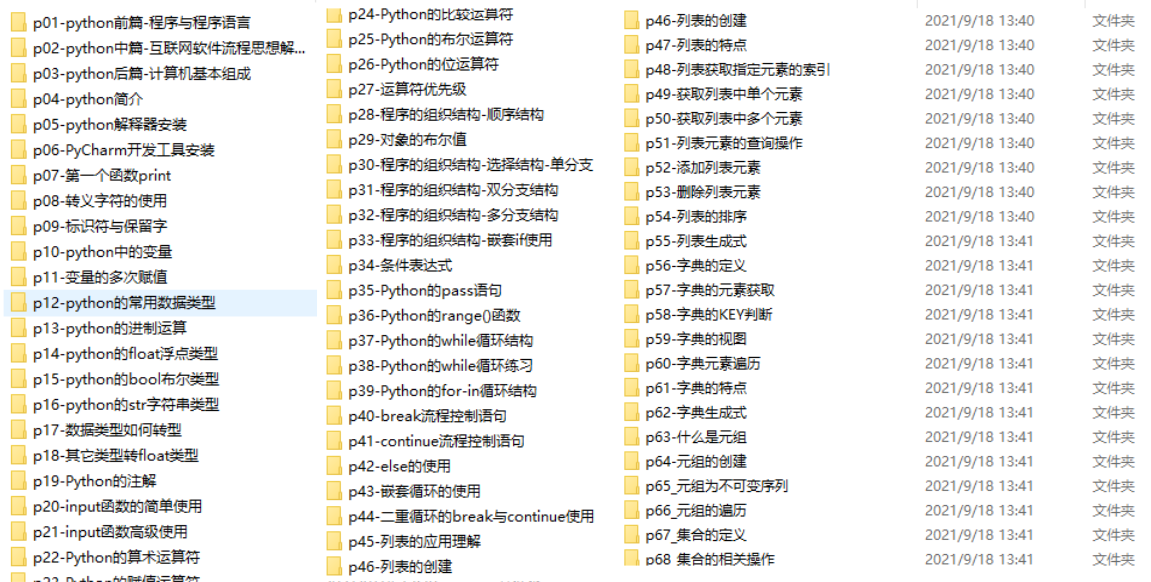

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉Python必备开发工具👈

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

👉Python全套学习视频👈

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

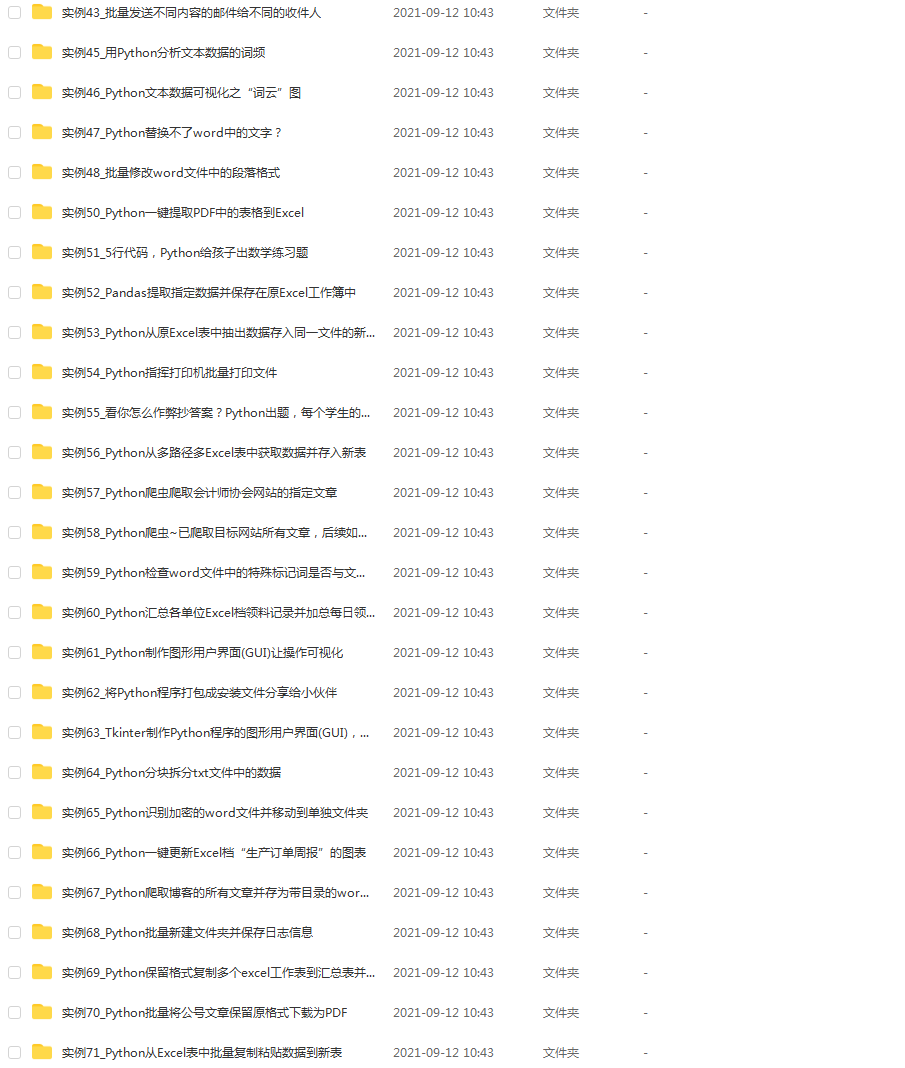

👉实战案例👈

学python就与学数学一样,是不能只看书不做题的,直接看步骤和答案会让人误以为自己全都掌握了,但是碰到生题的时候还是会一筹莫展。

因此在学习python的过程中一定要记得多动手写代码,教程只需要看一两遍即可。

👉大厂面试真题👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

3511

3511

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?