网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

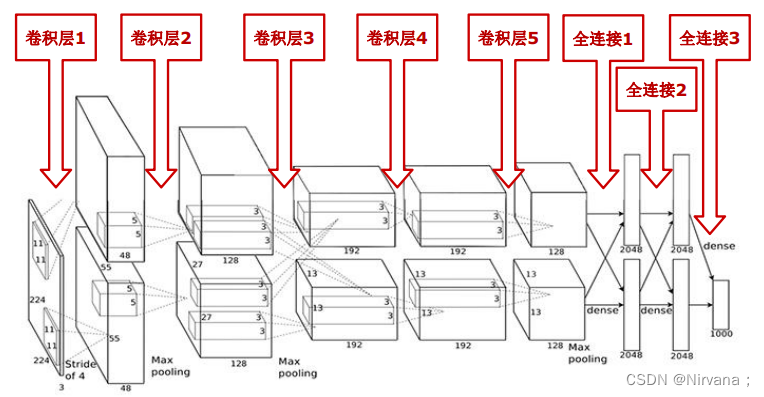

- AlexNet包含8层网络,有5个卷积层和3个全连接层

- AlexNet第一层中的卷积核shape为11X11,第二层的卷积核形状缩小到5X5,之后全部采用3X3的卷积核

- 所有的池化层窗口大小为3X3,步长为2,最大池化采用Relu激活函数,代替sigmoid,梯度计算更简单,模型更容易训练

- 采用Dropout来控制模型复杂度,防止过拟合采用大量图像增强技术,比如翻转、裁剪和颜色变化,扩大数据集,防止过拟合

代码实现

# 导入工具包

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers

# 模型构建

net = keras.models.Sequential([

# 卷积:卷积核数量96,尺寸11\*11,步长4,激活函数relu

layers.Conv2D(filters=96, kernel_size=11, strides=4, activation='relu'),

# 最大池化:尺寸3\*3,步长2

layers.MaxPool2D(pool_size=3, strides=2),

# 卷积:卷积核数量256,尺寸5\*5,激活函数relu,same卷积

layers.Conv2D(filters=256, kernel_size=5, padding='same', activation='relu'),

# 最大池化:尺寸3\*3,步长3

layers.MaxPool2D(pool_size=3, strides=2),

# 卷积:卷积核数量384,尺寸3,激活函数relu,same卷积

layers.Conv2D(filters=384, kernel_size=3, padding='same', activation='relu'),

# 卷积:卷积核数量384,尺寸3,激活函数relu,same卷积

layers.Conv2D(filters=384, kernel_size=3, padding='same', activation='relu'),

# 卷积:卷积核数量256,尺寸3,激活函数relu,same卷积

layers.Conv2D(filters=256, kernel_size=3, padding='same', activation='relu'),

# 最大池化:尺寸3\*3,步长2

layers.MaxPool2D(pool_size=3, strides=2),

# 展平特征图

layers.Flatten(),

# 全连接:4096神经元,relu

layers.Dense(4096, activation='relu'),

# 随机失活

layers.Dropout(0.5),

layers.Dense(4096, activation='relu'),

layers.Dropout(0.5),

# 输出层:多分类用softmax,二分类用sigmoid

layers.Dense(10, activation='softmax')],

name='AlexNet')

# 模拟输入

x = tf.random.uniform((1, 227, 227, 1))

y = net(x)

net.summary()

3.VGG网络

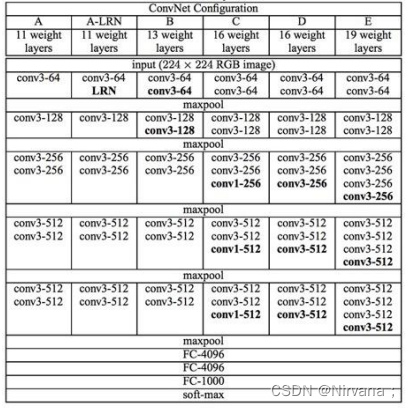

VGG网络是在2014年由牛津大学计算机视觉组和谷歌公司的研究员共同开发的。VGG由5层卷积层、3层全连接层、softmax输出层构成,层与层之间使用最大池化分开,所有隐层的激活单元都采用ReLU函数。通过反复堆叠3X3的小卷积核和2X2的最大池化层,VGGNet成功的搭建了16-19层的深度卷积神经网络。VGG的结构图如下:

VGGNet 论文中全部使用了3X3的卷积核和2X2的池化核,通过不断加深网络结构来提升性能。下图所示为 VGGNet 各级别的网络结构图,以及随后的每一级别的参数量,从11层的网络一直到19层的网络都有详尽的性能测试。虽然从A到E每一级网络逐渐变深,但是网络的参数量并没有增长很多,这是因为参数量主要都消耗在最后3个全连接层。前面的卷积部分虽然很深,但是消耗的参数量不大,不过训练比较耗时的部分依然是卷积,因其计算量比较大。这其中的D、E也就是我们常说的 VGGNet-16 和 VGGNet-19。C相比B多了几个1X1的卷积层,1X1卷积的意义主要在于线性变换,而输入通道数和输出通道数不变,没有发生降维。

代码实现 VGG11

#tensorflow基于mnist数据集上的VGG11网络,可以直接运行

from tensorflow.examples.tutorials.mnist import input_data

import tensorflow as tf

#tensorflow基于mnist实现VGG11

mnist = input_data.read_data_sets('MNIST\_data', one_hot=True)

x = tf.placeholder(tf.float32, [None, 784])

y_ = tf.placeholder(tf.float32, [None, 10])

sess = tf.InteractiveSession()

#Layer1

W_conv1 =tf.Variable(tf.truncated_normal([3, 3, 1, 64],stddev=0.1))

b_conv1 = tf.Variable(tf.constant(0.1,shape=[64]))

#调整x的大小

x_image = tf.reshape(x, [-1,28,28,1])

h_conv1 = tf.nn.relu(tf.nn.conv2d(x_image, W_conv1,strides=[1, 1, 1, 1], padding='SAME') + b_conv1)

#Layer2 pooling

W_conv2 = tf.Variable(tf.truncated_normal([3, 3, 64, 64],stddev=0.1))

b_conv2 = tf.Variable(tf.constant(0.1,shape=[64]))

h_conv2 = tf.nn.relu(tf.nn.conv2d(h_conv1, W_conv2,strides=[1, 1, 1, 1], padding='SAME') + b_conv2)

h_pool2 = tf.nn.max_pool(h_conv2, ksize=[1, 2, 2, 1],

strides=[1, 2, 2, 1], padding='SAME')

#Layer3

W_conv3 = tf.Variable(tf.truncated_normal([3, 3, 64, 128],stddev=0.1))

b_conv3 = tf.Variable(tf.constant(0.1,shape=[128]))

h_conv3 = tf.nn.relu(tf.nn.conv2d(h_pool2, W_conv3,strides=[1, 1, 1, 1], padding='SAME') + b_conv3)

#Layer4 pooling

W_conv4 = tf.Variable(tf.truncated_normal([3, 3, 128, 128],stddev=0.1))

b_conv4 = tf.Variable(tf.constant(0.1,shape=[128]))

h_conv4 = tf.nn.relu(tf.nn.conv2d(h_conv3, W_conv4,strides=[1, 1, 1, 1], padding='SAME') + b_conv4)

h_pool4= tf.nn.max_pool(h_conv4, ksize=[1, 2, 2, 1],

strides=[1, 2, 2, 1], padding='SAME')

#Layer5

W_conv5 = tf.Variable(tf.truncated_normal([3, 3, 128, 256],stddev=0.1))

b_conv5 = tf.Variable(tf.constant(0.1,shape=[256]))

h_conv5 = tf.nn.relu(tf.nn.conv2d(h_pool4, W_conv5,strides=[1, 1, 1, 1], padding='SAME') + b_conv5)

#Layer6

W_conv6 = tf.Variable(tf.truncated_normal([3, 3, 256, 256],stddev=0.1))

b_conv6 = tf.Variable(tf.constant(0.1,shape=[256]))

h_conv6 = tf.nn.relu(tf.nn.conv2d(h_conv5, W_conv6,strides=[1, 1, 1, 1], padding='SAME') + b_conv6)

#Layer7

W_conv7 = tf.Variable(tf.truncated_normal([3, 3, 256, 256],stddev=0.1))

b_conv7 = tf.Variable(tf.constant(0.1,shape=[256]))

h_conv7 = tf.nn.relu(tf.nn.conv2d(h_conv6, W_conv7,strides=[1, 1, 1, 1], padding='SAME') + b_conv7)

#Layer8

W_conv8 = tf.Variable(tf.truncated_normal([3, 3, 256, 256],stddev=0.1))

b_conv8 = tf.Variable(tf.constant(0.1,shape=[256]))

h_conv8 = tf.nn.relu(tf.nn.conv2d(h_conv7, W_conv8,strides=[1, 1, 1, 1], padding='SAME') + b_conv8)

h_pool8 = tf.nn.max_pool(h_conv8, ksize=[1, 2, 2, 1],

strides=[1, 1, 1, 1], padding='SAME')

#Layer9-全连接层

W_fc1 = tf.Variable(tf.truncated_normal([7\*7\*256,1024],stddev&#

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?