注意到豆瓣图书的搜索页面有一个搜索提示,于是在控制台查Network发现搜索提示返回的直接是一个json,例如查“未来简史”,结果如下:

图3,未来简史搜索提示

返回json可以用的属性有:title:书名、url:对应书的豆瓣页面、pic:书封面图资源位置等。如果上面的输入咱们只有书名,就根据书名和返回的json对应,如果有作者、出版年份等属性,就可以更好的核对是否是我们要找的书,为了简化,下面只用了返回json数据的第1条。

基本代码

根据返回的url就可以从这个url去定位我们需要爬的信息。走通了就可以正式写代码了,以下代码采用jupyter notebook的组织方式,也就是切分得比较细。先引入所需库:

读取书名Excel数据,只用了"书名"列,先不考虑其他列

对书名列表进行循环,得到的属性用字典装着,每本书的属性是一个字典,用列表装各个字典。

通过requests.get(‘https://book.douban.com/j/subject_suggest?q={0}’.format(bn))获取搜索建议返回的json数据,其中bn是书名字符串。

爬虫的一般解析是用BeautifulSoup或xpath,我更喜欢用xpath,因此下面的代码主要基于xpath解析文本。

以评分为例,鼠标点击评分部分,然后按Ctrl+Shift+I,或者右键点击检查元素,反正就是定位到评分对应的HTML上,定位到评分的代码部分后,右键,选择Copy->Copy XPath,例如对于评分来说有:

//*[@id=“interest_sectl”]/div/div[2]/strong。

图4,复制评分的xpath

通过con.xpath(‘//*[@id=“interest_sectl”]/div/div[2]/strong/text()’)就可以得到评分数据,返回的是列表,一般就是第0个值。同样,其他地方也是这样,而作者、出版社那几个属性是结构比较散的,需要特殊处理。

图5,自由度较大的书目信息部分

通过//*[@id=“info”]/span[2]可以确定 出版社 这个属性,但是属性的值,具体是哪个出版社不能确定,这些文字是在info这个节点上的。对于这种长度不定的一个html区域,不能写死xpath解析式,需要理清其HTML树结构,建立info的树结构。通过分析几个具体的页面的info部分,建立树结构如下:

图6,info部分的HTML树

需要得到的是{'出版社’:‘中信出版集团’}这样的数据,通过HTML树结构可以看到的特征是键(如出版社)在span里,值可能在text里,也可能封装在span里的子元素里,反正每个键值对之后都有一个br去切分。考虑这些情况写出的代码如下:

为了在大循环里好调用,上面的部分封装成函数,调用getBookInfo()返回的是一个字典,要整合到已有的字典里。涉及字典的组合,查了一下可以用d=dict(d,**dw),其中d是旧字典,dw是要加到d里的新字典,更简便的方式是用d.update(dw)函数,下面的代码就是用的update的。

主循环代码:

图7,爬到的数据概览

基础数据统计分析

我们开始时读入的bsdf有书名、作者、阅读时间等属性,因为爬下来的数据可能会有缺失值,将两个表合并起来进行分析。分析的维度有书名、作者、阅读时间、出版社、页数等。首先是用merge整合两表然后看一些基本的统计量。

输出是一共有421本书,309个作者,97个出版社;

我们就来看看前几位的作者和出版社,通过

bdf[‘作者’].value_counts().head(7)可以输出前7位书单里出现最多的作者,出版社同理,结果如下:

图8,出版社和作者统计

从作者出现次数来看,前6位都是小说类型的书,可以看一下吴军的是哪些书:

图9,每月阅读数量_时间轴折线图.png

好奇不同年份每个月是否有一定规律呢。要统计这个比较方便的就是用数据透视表了,pandas里的pivot_table出场。

文末有福利领取哦~

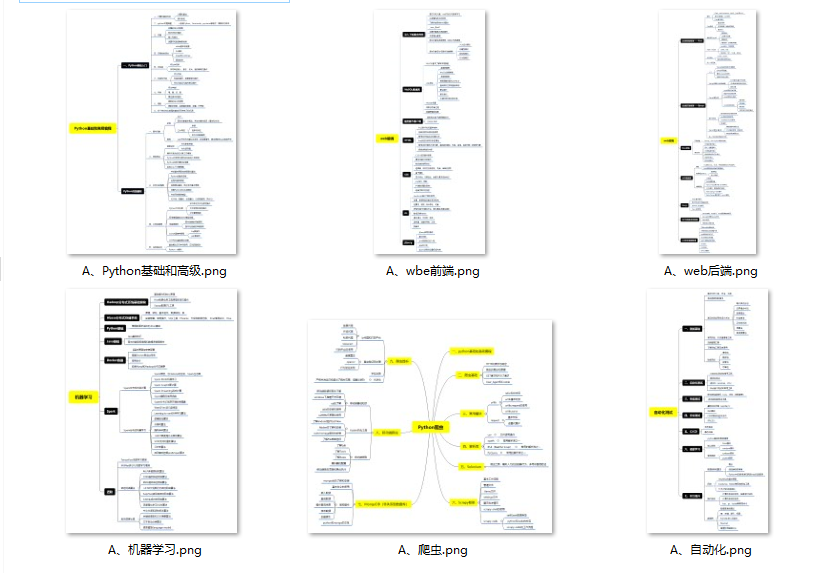

👉一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉二、Python必备开发工具

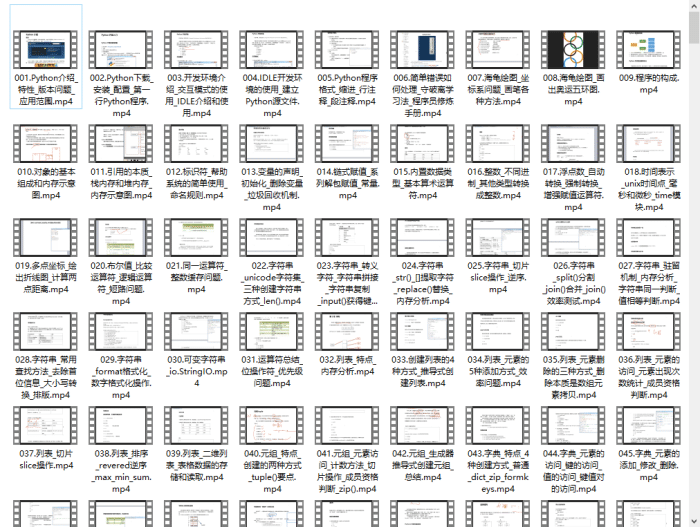

👉三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

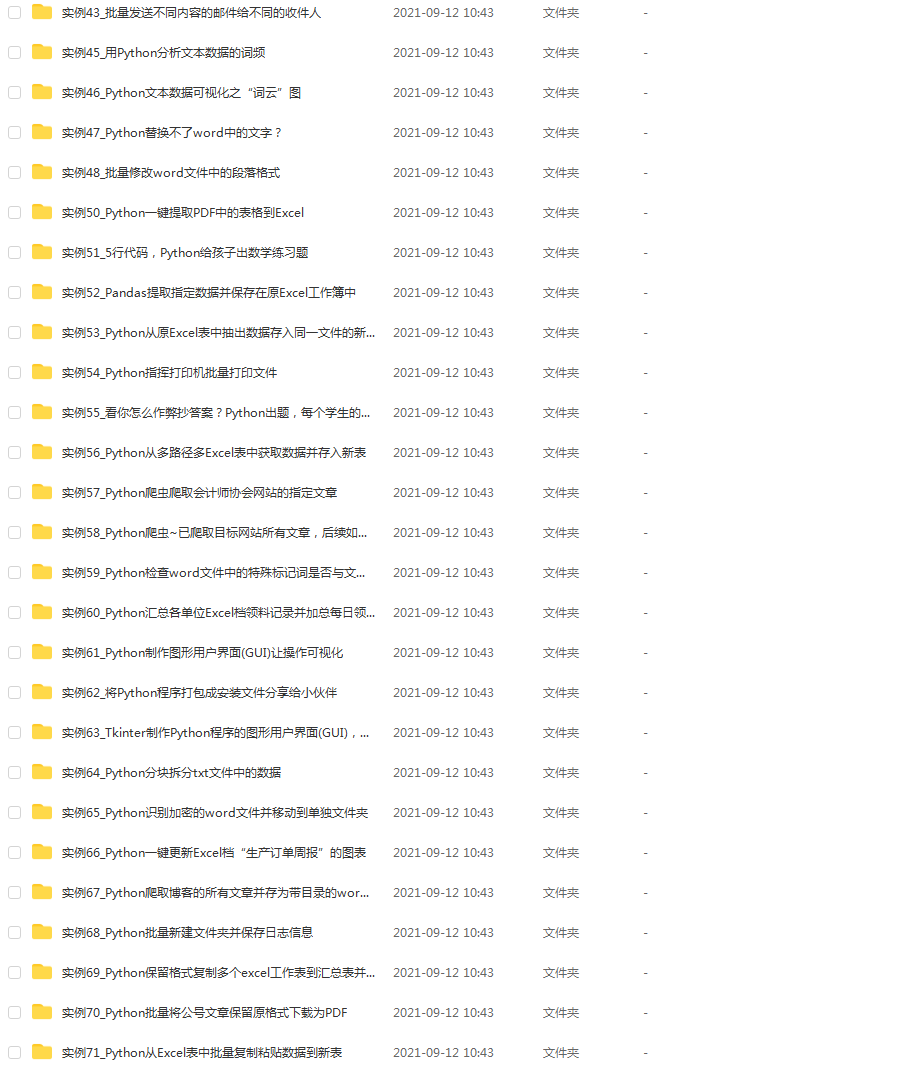

👉 四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(文末领读者福利)

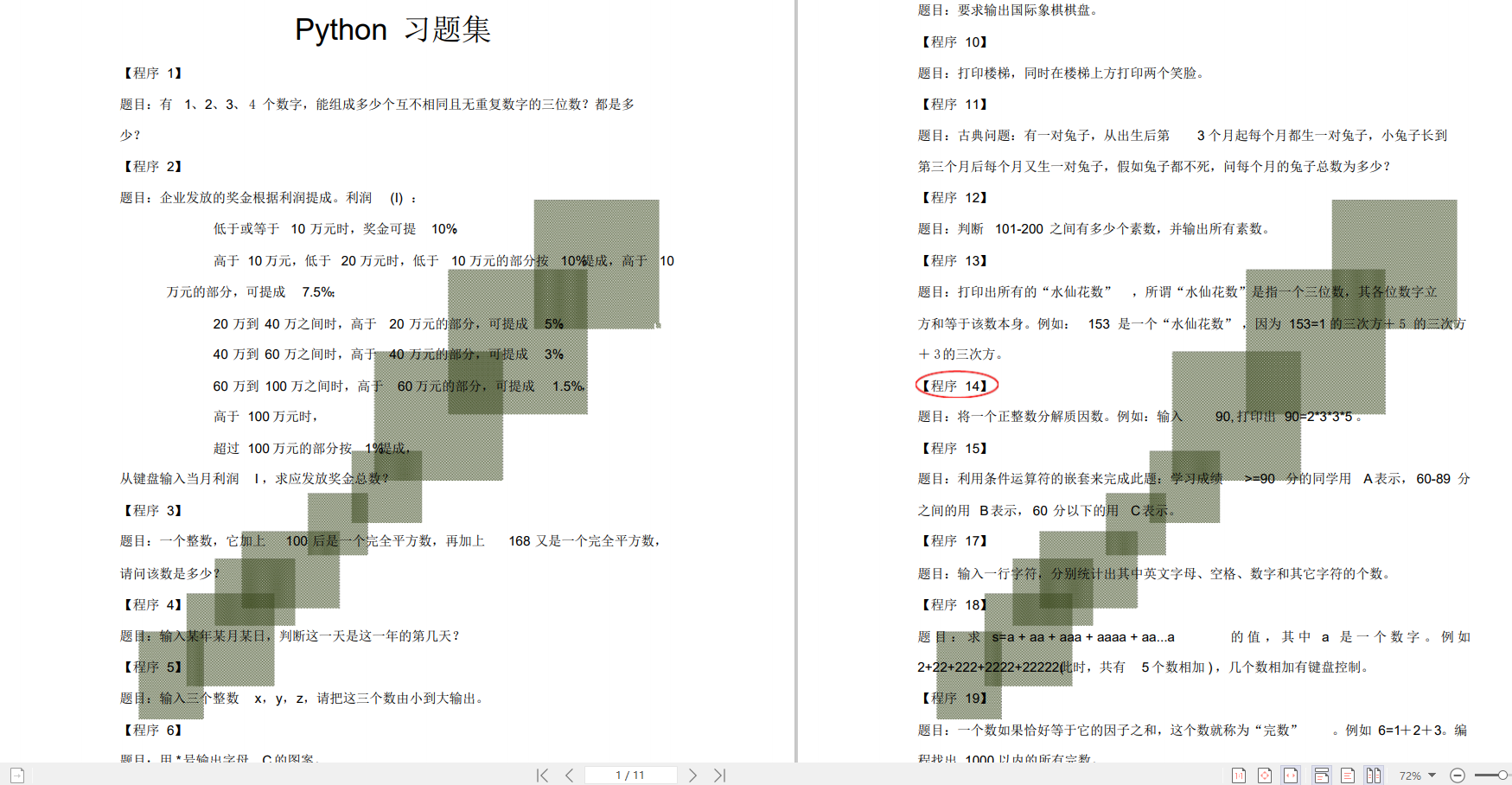

👉五、Python练习题

检查学习结果。

👉六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

👉因篇幅有限,仅展示部分资料,这份完整版的Python全套学习资料已经上传

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

研究,那么很难做到真正的技术提升。**

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

本文介绍了如何使用Python和网络请求抓取豆瓣图书搜索建议中的JSON数据,提取书名、评分、作者和出版社等信息,用于进一步的数据分析和整理。

本文介绍了如何使用Python和网络请求抓取豆瓣图书搜索建议中的JSON数据,提取书名、评分、作者和出版社等信息,用于进一步的数据分析和整理。

900

900

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?