通过Pandas,我们可以轻松地加载数据、进行数据清洗和转换、计算统计量、进行数据可视化等。首先,Pandas提供了丰富的数据加载函数。无论是从CSV文件、Excel文件、SQL数据库还是Web API中加载数据,Pandas都能提供相应的函数来方便地读取数据并转化为Series或DataFrame。其次,Pandas提供了灵活的数据清洗和转换工具。通过Pandas的函数,我们可以方便地处理缺失值、重复值、异常值等数据问题,还可以进行数据类型转换、数据重塑、数据合并等操作。此外,Pandas提供了丰富的统计计算函数,可以方便地计算平均值、标准差、相关系数、累计和等统计量。最重要的是,Pandas还提供了强大的数据可视化功能。通过Pandas的绘图函数,我们可以轻松地绘制折线图、柱状图、散点图等各种图表,直观地展示数据的分布和趋势。

Pandas是Python中一款强大的数据分析和数据处理库。通过Pandas,我们可以方便地加载数据、进行数据清洗和转换、计算统计量、进行数据可视化等。无论是在数据探索、数据清洗还是数据分析方面,Pandas都能提供高效的工具和函数。让我们一起释放数据的潜力,掌握Pandas,开启数据分析的新篇章!

3. Matplotlib

Matplotlib可以绘制多种类型的图表,包括折线图、散点图、柱状图、饼图等。无论是展示时间序列数据的趋势变化,还是比较不同数据点之间的关系,Matplotlib都能提供相应的绘图函数和选项。通过简洁的代码,我们可以轻松地生成美观的图形,并展示数据的特征和趋势。

不仅如此,Matplotlib还可以与Pandas库结合使用,将数据转换为可视化图形。Pandas提供了强大的数据处理和分析功能,而Matplotlib则可以帮助我们更好地理解数据。通过Pandas,我们可以对数据进行清洗、转换和计算,然后使用Matplotlib将处理后的数据转换为图形展示。这样,我们可以更直观地发现数据中的规律和异常,从而做出更准确的决策。

除了丰富的绘图函数和可定制化选项,Matplotlib还提供了众多的辅助功能。例如,我们可以添加标题、轴标签、图例等元素,进一步美化图表。我们还可以调整图表的尺寸、颜色、线型等参数,以满足自己的需求。Matplotlib支持多种输出格式,包括图片文件、PDF文件、交互式图形等,方便我们将图表保存或与他人分享。

Matplotlib是Python中最流行的数据可视化库。通过Matplotlib,我们可以方便地绘制各种类型的图表,帮助我们更好地理解数据的特征和趋势。无论是在数据分析、数据探索还是数据展示方面,Matplotlib都是一个不可或缺的工具。让我们一起揭示数据的美,掌握Matplotlib,开启数据可视化的新篇章!

4. Seaborn

Seaborn的强大之处在于它的图表种类多样且功能丰富。我们可以使用Seaborn绘制热力图,将数据的关联性以颜色的形式展现出来。通过热力图,我们可以更直观地观察数据之间的相关性,为决策提供更准确的依据。此外,Seaborn还能绘制箱线图,帮助我们分析数据的分布情况和异常值,并进行可视化展示。分类图能够清晰地展示不同类别数据之间的差异,帮助我们更好地理解数据背后的故事。还有分布图可以展示数据的分布情况,让我们更直观地了解数据的大致趋势。

与Matplotlib相比,Seaborn的设计风格和默认配色方案更加吸引人。Seaborn的图表具有更大的字体和线条粗细,让图表更加清晰易读。同时,Seaborn的配色方案也更加美观,让图表更具吸引力。这些设计上的改进使得我们能够更好地展现数据分析结果,并与他人分享。无论是在学术研究、商业决策还是数据报告方面,Seaborn都能帮助我们打造更专业的图表。

Seaborn是一个基于Matplotlib的高级数据可视化库。它提供了更多样化、更美观的统计图表绘制方式,使得数据分析结果更加直观和吸引人。通过Seaborn,我们可以轻松绘制热力图、箱线图、分类图、分布图等复杂的图表,并展现数据的美丽之处。让我们一起追求炫丽数据之美,掌握Seaborn,开启数据可视化的新征程!

二、爬虫

1. Requests

Requests提供了一套简洁的API接口,使得我们能够方便地发送HTTP请求。不管是获取网页内容、模拟登录还是进行表单提交,我们只需要几行代码就能搞定。通过设置请求的参数,我们可以轻松地实现网页的GET和POST操作,从而获取所需的数据。Requests还支持设置请求头、代理、Cookies等,让我们更好地模拟用户的操作,提高抓取效果。

除了发送HTTP请求,Requests还能优雅地处理响应。它提供了各种方法来获取响应的内容,如文本、二进制数据、JSON等。我们可以轻松地解析和提取所需的数据,无论是从网页中抓取文本、图片还是其他类型的资源,都能够得心应手。此外,Requests还支持文件上传和下载,让我们能够方便地处理各种文件操作。

Requests的简洁和友好使得它成为了许多开发者和数据分析师的首选工具。无论是在爬虫开发、数据采集还是网络监测方面,Requests都能够让我们的工作更加高效和便捷。它的文档丰富且易于理解,让我们能够快速上手并解决问题。而且,它还具有活跃的社区支持,我们可以从其他开发者的经验中受益,提升自己的技能。

Requests是一个简洁而友好的HTTP库,可以方便地发送HTTP请求和处理响应。它提供了简洁的API接口,使用起来非常方便。无论是获取网页内容、模拟登录还是进行表单提交,我们都可以通过几行代码实现。Requests的优雅和强大使得网页抓取变得更加简单,让我们可以轻松畅游网络世界。让我们一起拥抱Requests,开启网络抓取的新征程!

2. BeautifulSoup

BeautifulSoup提供了多种解析器,可以根据需求选择最合适的解析器。无论是处理HTML文档还是XML文档,我们都能够用最简洁的方式解析它们。通过BeautifulSoup的强大解析功能,我们可以轻松地理解和操作网页的结构,提取出所需的数据。

在与Requests结合使用时,BeautifulSoup的威力更加强大。我们可以使用Requests发送HTTP请求获取网页内容,然后将其传递给BeautifulSoup进行解析。BeautifulSoup能够根据我们的需求,提取出网页中的各种数据,如标题、链接、图片等。无论是做数据采集、爬虫开发还是数据分析,BeautifulSoup都能够让我们事半功倍。

BeautifulSoup的使用非常简单。我们只需几行代码,就能实现数据的提取。它提供了丰富的方法和属性,让我们能够灵活地定位和提取所需的内容。例如,我们可以通过标签名、CSS选择器、正则表达式等方式来选择元素,并提取出其文本、属性等信息。同时,BeautifulSoup还提供了异常处理机制,让我们能够更好地应对解析中可能遇到的问题。

BeautifulSoup的强大功能和简单易用的特点,使得它成为了许多开发者和数据分析师的首选工具。无论是在数据提取、数据清洗还是数据分析方面,BeautifulSoup都能够大显身手。它的文档丰富且易于理解,让我们能够快速上手并解决问题。同时,BeautifulSoup还具有活跃的社区支持,我们可以从其他开发者的经验中受益,提升自己的技能。

BeautifulSoup是一个用于解析HTML和XML文档的库,可以方便地提取网页中的数据。它提供了多种解析器,可以根据需求选择最合适的解析器。结合Requests和BeautifulSoup,我们可以实现网页数据的快速抓取和提取。让我们一起解放数据的力量,让数据为我们所用!

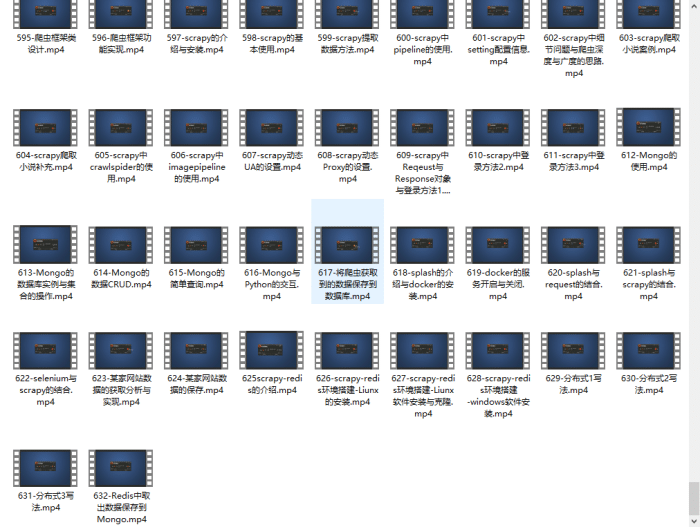

3. Scrapy

Scrapy的强大之处在于它的自动化能力。通过Scrapy,我们可以自动处理网页的请求和响应,无需手动操作。它支持异步操作和分布式爬取,使我们能够更高效地爬取大规模的数据。无论是对于单个网站还是对于多个网站的爬取,Scrapy都能够提供稳定而高效的解决方案。

Scrapy不仅仅是一个爬虫框架,它还提供了强大的数据提取功能。通过设置爬取规则,我们可以指定需要抓取的数据的位置和属性,然后Scrapy会自动提取这些数据。不仅如此,Scrapy还支持数据清洗和存储,使我们能够更加方便地处理和利用爬取到的数据。

Scrapy的灵活性也使其成为处理大规模数据爬取的首选工具。我们可以通过自定义的方式来配置和扩展Scrapy,以满足不同的需求。无论是处理网页上的文本、图片还是视频,Scrapy都能够轻松胜任。同时,Scrapy还提供了强大的调试和错误处理功能,让我们能够更好地应对在爬取过程中可能遇到的问题。

Scrapy的学习曲线相对较陡,但它的强大功能和丰富的文档使得学习变得更加简单。Scrapy拥有一个活跃的社区,我们可以从其他开发者的经验中受益,解决遇到的问题。与此同时,Scrapy还提供了详细且易于理解的文档,使我们能够迅速上手并掌握其使用技巧。

如果你也是看准了Python,想自学Python,在这里为大家准备了丰厚的免费学习大礼包,带大家一起学习,给大家剖析Python兼职、就业行情前景的这些事儿。

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

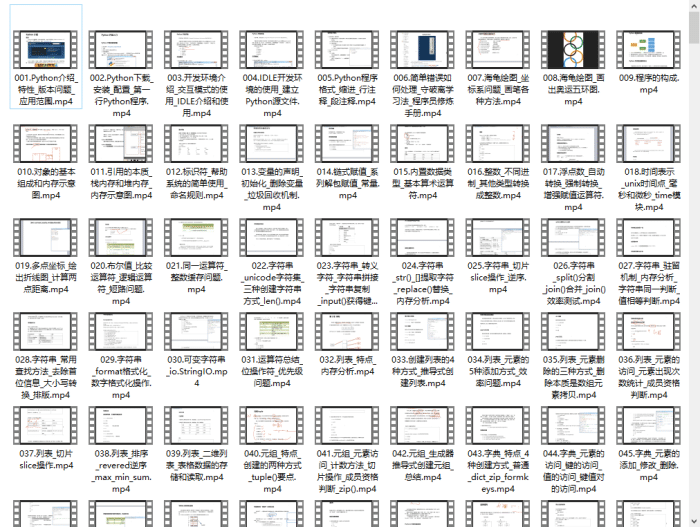

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

成为一个Python程序员专家或许需要花费数年时间,但是打下坚实的基础只要几周就可以,如果你按照我提供的学习路线以及资料有意识地去实践,你就有很大可能成功!

最后祝你好运!!!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

本文介绍了Python中的关键数据分析库Pandas,强调其数据加载、清洗、统计和可视化功能。同时,讲述了Matplotlib和Seaborn在数据可视化的角色,以及如何结合Requests和BeautifulSoup进行高效爬虫操作。Scrapy作为爬虫框架,展示了其自动化和分布式爬取的优势。

本文介绍了Python中的关键数据分析库Pandas,强调其数据加载、清洗、统计和可视化功能。同时,讲述了Matplotlib和Seaborn在数据可视化的角色,以及如何结合Requests和BeautifulSoup进行高效爬虫操作。Scrapy作为爬虫框架,展示了其自动化和分布式爬取的优势。

2195

2195

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?