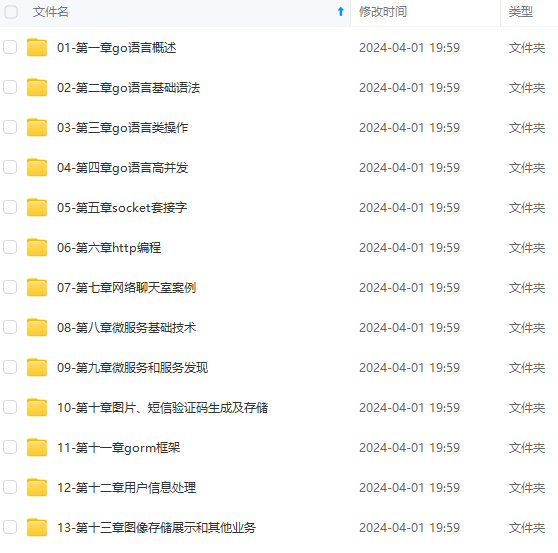

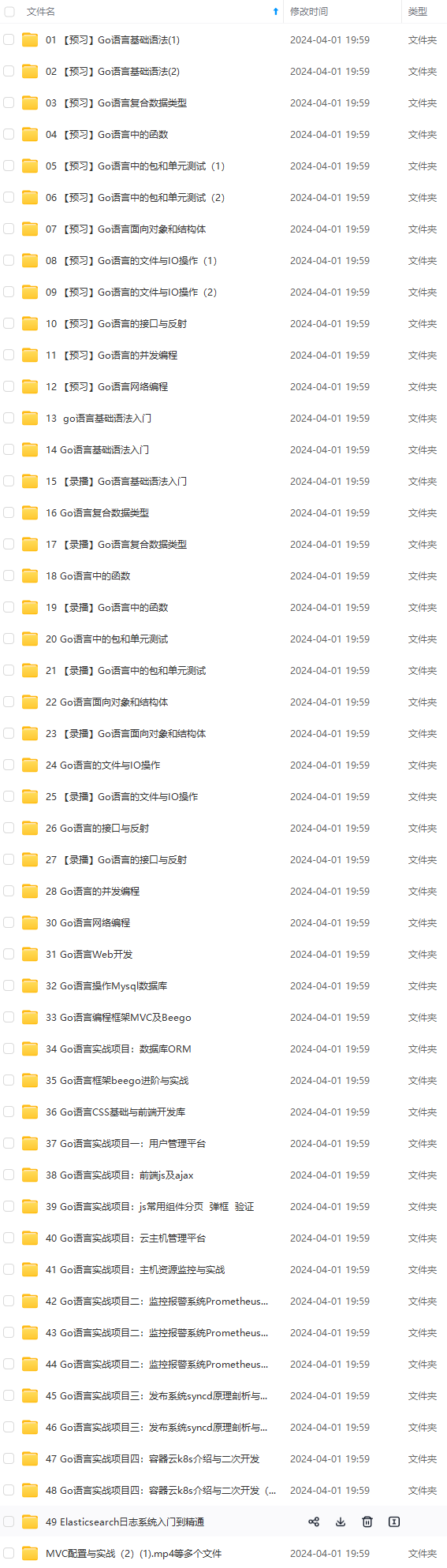

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Go语言开发知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

也可以从 ClickHouse 写回 Kafka。消息流更简单 - 只需插入到 Kafka 表中即可。下面是流程图。

在 Kafka 上创建主题

现在让我们在 Kafka 上设置一个主题,我们可以使用它来加载消息。登录到 Kafka 服务器,然后使用以下示例中的命令创建主题。在此示例中,“kafka”是服务器的 DNS 名称。如果您有其他 DNS 名称,请改用该名称。您还可以调整分区数以及复制因子。

kafka-topics \

--bootstrap-server kafka:9092 \

--topic readings \

--create --partitions 6 \

--replication-factor 2

检查主题是否已成功创建。

kafka-topics --bootstrap-server kafka:9092 --describe readings

你将看到如下所示的输出,其中显示了其分区的主题和当前状态。

Topic: readings PartitionCount: 6 ReplicationFactor: 2 Configs:

Topic: readings Partition: 0 Leader: 0 Replicas: 0,2 Isr: 0,2

Topic: readings Partition: 1 Leader: 2 Replicas: 2,1 Isr: 2,1

Topic: readings Partition: 2 Leader: 1 Replicas: 1,0 Isr: 1,0

Topic: readings Partition: 3 Leader: 0 Replicas: 0,1 Isr: 0,1

Topic: readings Partition: 4 Leader: 2 Replicas: 2,0 Isr: 2,0

Topic: readings Partition: 5 Leader: 1 Replicas: 1,2 Isr: 1,2

现在 Kafak 准备工作已完成。让我们转向ClickHouse。

ClickHouse Kafka 引擎设置

要将数据从 Kafka 主题读取到 ClickHouse 表,我们需要做三件事:

- 一个目标 MergeTree 表,用于为引入的数据提供主目录

- 一个 Kafka 引擎表,使主题看起来像一个 ClickHouse 表

- 用于自动将数据从 Kafka 移动到目标表的具体化视图

首先,我们将定义目标 MergeTree 表。登录到 ClickHouse 执行以下 SQL

CREATE TABLE readings (

readings_id Int32 Codec(DoubleDelta, LZ4),

time DateTime Codec(DoubleDelta, LZ4),

date ALIAS toDate(time),

temperature Decimal(5,2) Codec(T64, LZ4)

) Engine = MergeTree

PARTITION BY toYYYYMM(time)

ORDER BY (readings_id, time);

接下来,我们需要使用 Kafka 引擎创建一个表来连接主题并读取数据。引擎将使用主题“readings”和消费者组名称“readings consumer_group1”从主机 kafka 的代理读取数据。输入格式为 CSV。

请注意,我们省略了“date”列。它是目标表中的别名,将从“time”列自动填充。

CREATE TABLE readings_queue (

readings_id Int32,

time DateTime,

temperature Decimal(5,2)

)

ENGINE = Kafka

SETTINGS kafka_broker_list = 'kafka-headless.kafka:9092',

kafka_topic_list = 'readings',

kafka_group_name = 'readings_consumer_group1',

kafka_format = 'CSV',

kafka_max_block_size = 1048576;

前面的设置处理最简单的情况:单个代理、单个主题且没有专用配置。

最后,我们创建一个物化视图,用于在 Kafka 和合并树表之间传输数据。

CREATE MATERIALIZED VIEW readings_queue_mv TO readings AS

SELECT readings_id, time, temperature

FROM readings_queue;

这就是 Kafka 到 ClickHouse 的集成。让我们来测试一下。

加载数据

现在是时候使用 kafka-console-producer 命令加载一些输入数据了。以下示例使用 CSV 格式添加三条记录。

kafka-console-producer --broker-list kafka:9092 --topic readings <<END

1,"2020-05-16 23:55:44",14.2

2,"2020-05-16 23:55:45",20.1

3,"2020-05-16 23:55:51",12.9

END

传输到 readings

表需要几秒钟。如果我们从表中进行查询,我们会得到以下输出。

SELECT *

FROM readings

┌─readings_id─┬────────────────time─┬─temperature─┐

│ 1 │ 2020-05-16 23:55:44 │ 14.20 │

│ 2 │ 2020-05-16 23:55:45 │ 20.10 │

│ 3 │ 2020-05-16 23:55:51 │ 12.90 │

└─────────────┴─────────────────────┴─────────────┘

Kafka 和 ClickHouse 现已连接。

从 Kafka 重读消息

前面的示例从 Kafka 主题中的起始位置开始,并在消息到达时读取消息。这是正常方式,但有时再次阅读消息很有用。例如,您可能希望在修复架构中的 bug 或重新加载备份后重新读取消息。幸运的是,这很容易做到。我们只是重置使用者组中的偏移量。

假设我们丢失了 readings 表中的所有消息,并希望从 Kafka 重新加载它们。首先,让我们使用 TRUNCATE 命令“丢失”消息。

TRUNCATE TABLE readings;

在重置分区上的偏移量之前,我们需要关闭消息消费。为此,请在 ClickHouse 中分离 readings_queue 表,如下所示。

DETACH TABLE readings_queue

接下来,使用以下 Kafka 命令重置用于 readings_queue 表的使用者组中的分区偏移量 (kafka 节点执行)。

kafka-consumer-groups --bootstrap-server kafka:9092 \

--topic readings --group readings_consumer_group1 \

--reset-offsets --to-earliest --execute

现在重新连接readings_queue表。

ATTACH TABLE readings_queue

等待几秒钟,丢失的记录将被恢复。您可以运行 SELECT 来确认它们已恢复。

添加虚拟列

使用显示原始 Kafka 消息坐标的信息标记行通常很有用。为此,Kafka 表引擎自动定义了虚拟列。下面介绍如何更改 readings 表以显示源主题、分区和偏移量。

首先,让我们通过分离 Kafka 表来禁用消息使用。消息可能会堆积在主题上,但我们不会丢失它们。

DETACH TABLE readings_queue

接下来,我们通过连续执行以下 SQL 命令来更改目标表和物化视图。请注意,我们只是删除并重新创建具体化视图,而更改目标表,从而保留现有数据。

ALTER TABLE readings

ADD COLUMN _topic String,

ADD COLUMN _offset UInt64,

ADD COLUMN _partition UInt64

DROP TABLE readings_queue_mv

CREATE MATERIALIZED VIEW readings_queue_mv TO readings AS

SELECT readings_id, time, temperature, _topic, _offset, _partition

FROM readings_queue;

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化的资料的朋友,可以添加戳这里获取](https://bbs.csdn.net/topics/618658159)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

emperature, _topic, _offset, _partition

FROM readings_queue;

[外链图片转存中...(img-3uXLfsLf-1715629828246)]

[外链图片转存中...(img-GWkUXr0m-1715629828247)]

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化的资料的朋友,可以添加戳这里获取](https://bbs.csdn.net/topics/618658159)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?