引言:医疗AI的新里程碑

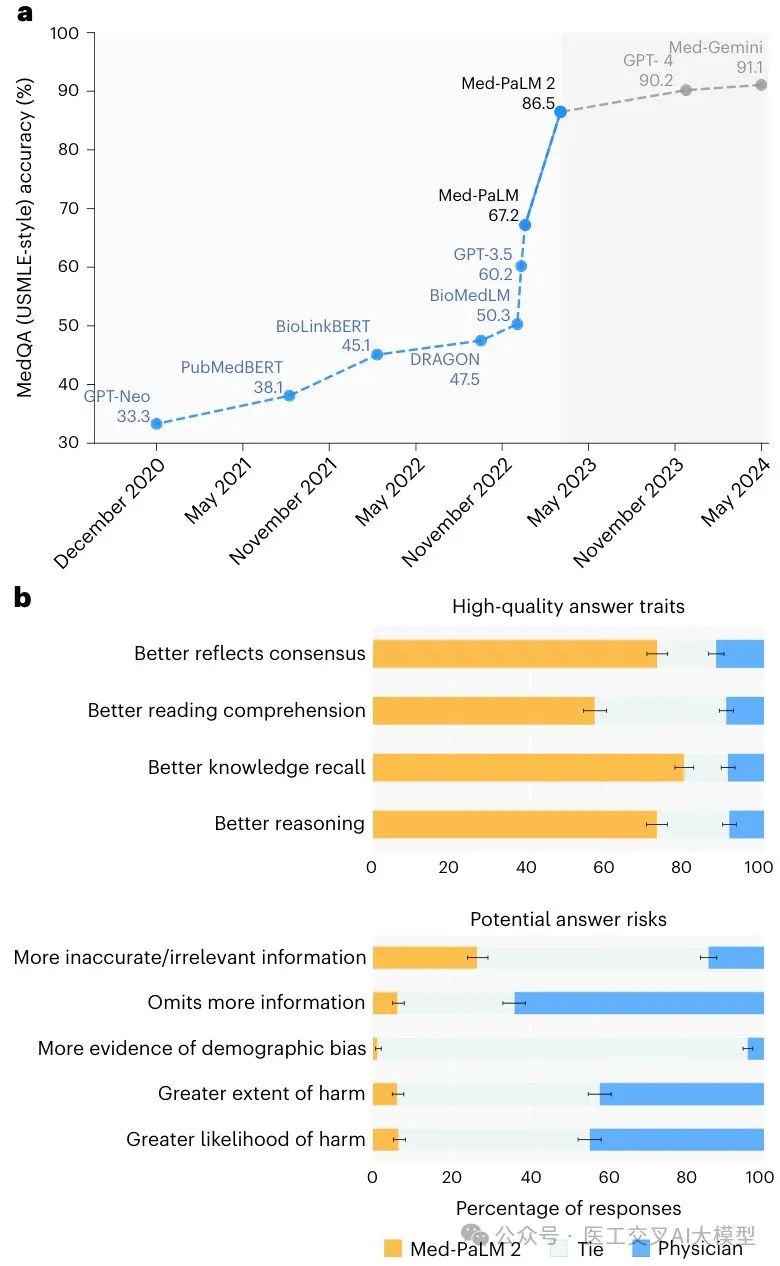

在医疗人工智能领域的发展中,语言大模型(LLMs)展现出了解决医疗问答这一长期"大挑战"的巨大潜力。最近,谷歌研究团队在《自然医学》(Nature Medicine)上发表的研究论文《Toward expert-level medical question answering with large language models》展示了大模型Med-PaLM 2的突破性成就。Med-PaLM 2不仅在多项医学知识测验中实现了高达86.5%的准确率,而且在众多临床评估维度上,其回答甚至被医生评为优于人类医生的回答。这一成就标志着医疗AI向真正的临床辅助工具迈出了实质性的一步。

本文将深入解析Med-PaLM 2的技术架构、创新方法及其在医疗问答领域实现的突破性进展,探讨其如何通过优化基础模型、领域特定微调和创新的推理策略,在复杂医疗问题上展现出接近专家级的回答能力。

Med-PaLM 2的技术突破与创新

Med-PaLM 2建立在其前身Med-PaLM的基础上,通过三个关键技术创新实现了质的飞跃:

1. 改进的基础大模型

Med-PaLM 2以谷歌的PaLM 2为基础模型,相比前代PaLM模型,PaLM 2在多项语言模型基准测试中展现出显著提升。PaLM 2的主要进步包括:

-

计算最优缩放(compute-optimal scaling)

-

改进的数据集混合

-

训练目标优化

这些基础改进为Med-PaLM 2提供了更强大的语言理解和推理能力,为医疗领域的特定优化奠定了坚实基础。

2. 医疗领域特定微调

Med-PaLM 2采用了指令微调(instruction fine-tuning)方法,在多个医疗数据集上进行训练。这些数据集包括:

-

MedQA:美国医学执照考试风格的问题

-

MedMCQA:印度医学入学考试问题

-

HealthSearchQA、LiveQA和MedicationQA:消费者医疗问题

研究团队训练了一个"统一"模型,该模型通过精心设计的数据集混合比例,优化了在所有MultiMedQA数据集上的表现。这种混合比例的确定基于各数据集的大小、质量以及在现有验证集上的表现。

Extended Data Table 3展示了指令微调数据集的混合比例:

| Dataset | Count | Mixtureratio |

| MedQA | 10,178 | 37.5% |

| MedMCQA | 182,822 | 37.5% |

| LiveQA | 10 | 3.9% |

| MedicationQA | 9 | 3.5% |

| HealthSearchQA | 45 | 17.6% |

这种领域特定的微调使模型能够更好地理解医疗术语、临床推理和医学知识,从而在医疗问答任务中表现出色。

3. 创新提示策略

Med-PaLM 2引入了两种创新的提示策略,显著提升了模型的推理能力和事实基础:

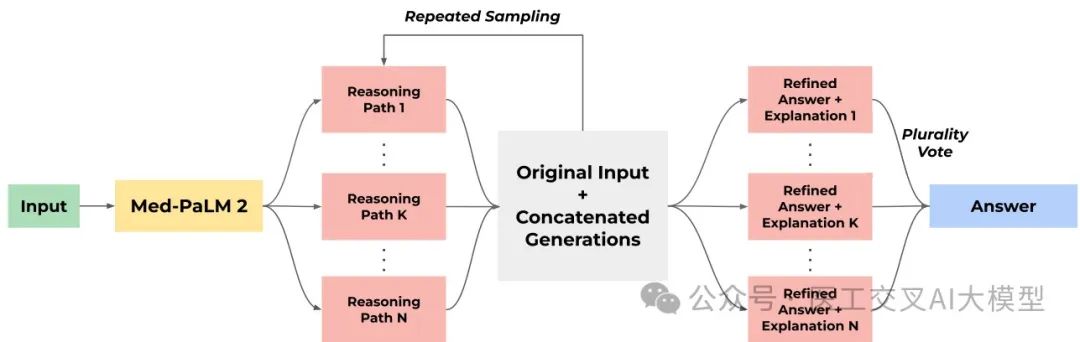

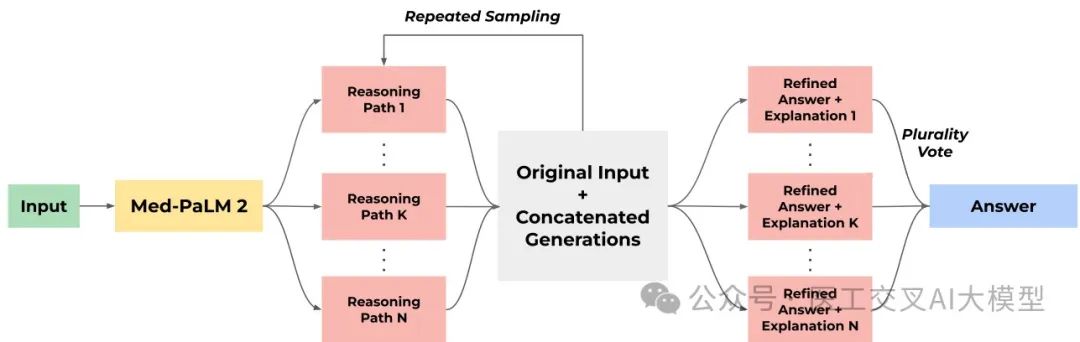

(1) 集成精炼 (Ensemble Refinement, ER)

集成精炼是研究团队开发的一种简单但强大的提示策略,建立在思维链(Chain of Thought, CoT)和自洽性(Self-Consistency, SC)的基础上。ER采用两阶段流程:

-

第一阶段:给定包含少样本示例的思维链提示和问题,模型通过温度采样随机生成多个可能的解答路径。

-

第二阶段:模型基于原始提示、问题和第一阶段生成的多个解答路径,生成精炼的解释和答案。

ER可以被视为自洽性方法的泛化,它允许模型不仅仅进行简单投票,而是考虑它生成的各种解释的优缺点。为了提高性能,研究团队在第二阶段多次执行这一过程,最终通过对这些生成的答案进行多数投票来确定最终答案。

Extended Data Fig. 1展示了集成精炼(Ensemble Refinement)策略的工作流程。在这种方法中,大语言模型基于其自身生成的多个推理路径进行条件设置,从而使其能够改进和优化最终答案。

(2) 检索链 (Chain of Retrieval)

为了解决专科医生在日常医疗过程中提出的复杂问题,研究团队引入了"检索链"方法,这是一种利用外部搜索作为工具的逐步流程,使Med-PaLM 2能够在相关来源的基础上提出事实性主张。该过程包括6个步骤:

-

使用零样本提示生成初始Med-PaLM 2答案

-

将初始答案分解为待验证的单独主张

-

为这些待验证的主张生成搜索查询

-

使用谷歌搜索检索相关研究和网站

-

总结各个文档

-

Med-PaLM 2使用问题和连接的摘要生成最终答案

这种方法借鉴了思维链提示的基本思想,即大型语言模型能够在复杂的多步推理任务中取得成功,前提是这些任务被分解为可管理的步骤,使模型能够自回归地基于前面步骤的输出调整其生成内容。

研究团队发现,在第6步中,从提示中排除第1步的初始答案很重要,这样可以防止模型锚定在初始的未经验证的答案上。

检索链方法普遍适用于其他大型语言模型和评估设置,它与利用固定语料库和嵌入空间来查找文档的检索增强生成方法不同,更类似于将主张验证分解为多个步骤的其他方法。

评估框架与方法

Med-PaLM 2的评估采用了全面而严格的框架,包括多项选择题性能评估和人类评估两大核心部分。

1. 多项选择题性能评估

研究使用了MultiMedQA基准测试中的多个数据集进行评估,包括:

-

MedQA:美国医学执照考试(USMLE)风格的问题,测试一般医学知识

-

MedMCQA:印度医学入学考试的问题,同样测试一般医学知识

-

PubMedQA:基于PubMed摘要的封闭域问答

-

MMLU临床话题:包括临床知识、医学遗传学、解剖学、专业医学等多个医学相关领域的问题

Extended Data Table 1展示了多项选择题评估使用的数据集:

| Name | Count | Description |

| MedQA(USMLE) | 1273 | General medical knowledge in US medical licensing exam |

| PubMedQA | 500 | Closed-domain question answering given PubMed abstract |

| MedMCQA | 4183 | General medical knowledge in Indian medical entrance exams |

| MMLU-Clinicalknowledge | 265 | Clinical knowledgemultiple-choice questions |

| MMLU-Medicalgenetics | 100 | Medical genetics multiple-choice questions |

| MMLU-Anatomy | 135 | Anatomy multiple-choice questions |

| MMLU-Professional medicine | 272 | Professionalmedicinemultiple-choicequestions |

| MMLU-College biology | 144 | College biology multiple-choice questions |

| MMLU-Collegemedicine | 173 | College medicine multiple-choice questions |

2. 人类评估框架

为了评估Med-PaLM 2在长格式医疗问答方面的表现,研究团队设计了一系列人类评估实验:

(1) 数据集

研究使用了四类数据集进行长格式问答评估:

-

MultiMedQA消费者问题:从MultiMedQA采样的两组问题,包括MultiMedQA 140(140个问题)和MultiMedQA 1066(1066个问题)

-

对抗性消费者问题:两个新的对抗性问题数据集,设计用于引发潜在有害和偏见的模型回答:一般对抗性集和健康公平对抗性集

-

床边咨询问题:由专科医生在日常医疗过程中提交给实际床边咨询服务的20个真实问题

Extended Data Table 2展示了人类评估使用的问答评估数据集:

| Name | Count | Description |

| MultiMedQA140 | 140 | SamplefromHealthSearchQA,LiveQA,Medication QA [1]. |

| MultiMedQA1066 | 1066 | SamplefromHealthSearchQA,LiveQA,Medication QA (Extended from [1]). |

| Adversarial(General) | 58 | General adversarial dataset. |

| Adversarial(Health equity) | 182 | Healthequityadversarial dataset. |

| Bedsideconsultation | 20 | Real-world questions submitted byphysicians to a consultationservice. |

(2) 评估方法

研究采用了两种核心评估方法:

-

独立评估:医生和非医学背景的普通人独立评估来自医生、Med-PaLM和Med-PaLM 2的长格式回答。医生使用12个评估维度,普通人使用2个评估维度。评估者对答案来源保持盲态,独立评估而不与其他评估者交流。

-

成对排名评估:直接比较不同来源(如医生与Med-PaLM 2)对同一问题的替代性回答。评估者沿着9个轴评估,包括与医学共识的一致性、阅读理解能力、知识回忆、推理能力等。

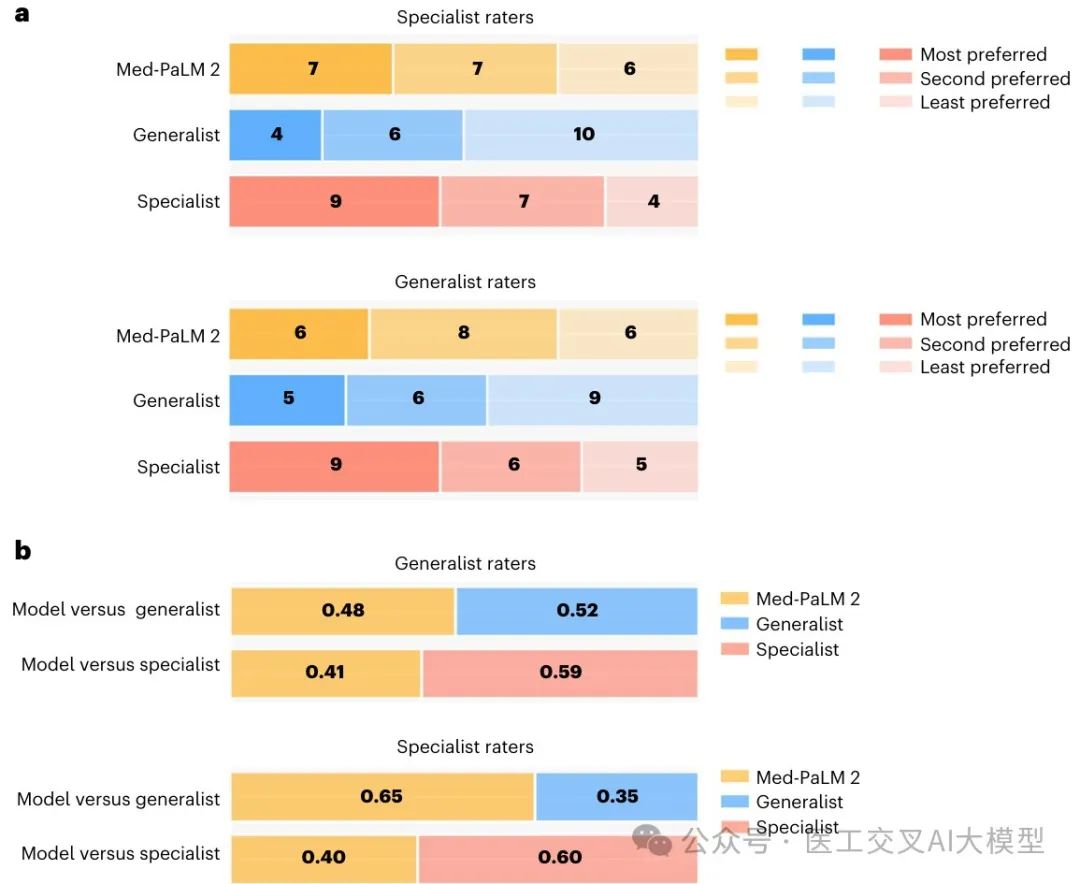

(3) 三方实用性排名

为了评估在床边咨询问题上的表现,研究进行了模型、普通医生和专科医生三者之间的比较:

-

每个问题由11名评估者(普通医生)和1名专科医生进行评估

-

评估者被要求根据原始问题的实用性对三种回答进行排名

-

此外,还单独评估了每种回答可能带来的伤害

突破性成果与结果

Med-PaLM 2在各项评估中表现出色,达到甚至超越了此前的最先进水平。以下是主要研究成果:

1. 多项选择题基准测试结果

Med-PaLM 2在多项选择题基准测试中表现优异:

-

**MedQA (USMLE)**:使用集成精炼(ER)策略达到85.4%的准确率,最佳结果达到86.5%(比Med-PaLM提高超过19%)

-

MedMCQA:达到72.3%的分数,超过Flan-PaLM(前身模型)14%以上

-

PubMedQA:在统一模型上通过探索提示策略达到79.8%的准确率,使用自洽性方法达到81.8%(此前最高水平)

-

MMLU临床话题:在六个话题中的三个上超过了此前的最先进水平

Table 1展示了Med-PaLM 2与GPT-4等模型的多项选择题测试结果比较:

| Dataset | Flan-PaLM(best) | Med-PaLM2(ER) | Med-PaLM2(best) | GPT-4(5-shot) | GPT-4-base(5-shot) |

| MedQA (USMLE) | 67.6[65.0, 70.2] | 85.4[83.3,87.3] | 86.5[84.5,88.3] | 81.4 [79.1, 83.5] | 86.1[84.1,88.0] |

| PubMedQA | 79.0 [75.2,82.5] | 75.0 [71.0, 78.7] | 81.8 [78.1, 85.1] | 75.2[71.2, 78.9] | 80.4[76.6, 83.8] |

| MedMCQA | 57.6 [56.1, 59.1] | 72.3[70.9,73.6] | 72.3 [70.9,73.6] | 72.4 [71.0, 73.7] | 73.7 [72.3, 75.0] |

| MMLUClinicalKnowledge | 80.4 [75.1, 85.0] | 88.7[84.2, 92.2] | 88.7[84.2, 92.2] | 86.4[81.7, 90.3] | 88.7[84.2, 92.2] |

| MMLUMedicalGenetics | 75.0[65.3,83.1] | 92.0[84.8, 96.5] | 92.0[84.8,96.5] | 92.0[84.8,96.5] | 97.0 [91.5, 99.4] |

| MMLUAnatomy | 63.7 [55.0, 71.8] | 84.4 [77.2, 90.1] | 84.4 [77.2, 90.1] | 80.0[72.3,86.4] | 85.2 [78.1, 90.7] |

| MMLUProfessionalMedicine | 83.8[78.9,88.0] | 92.3 [88.4, 95.2] | 95.2[92.0, 97.4] | 93.8 [90.2, 96.3] | 93.8[90.2,96.3] |

| MMLUCollegeBiology | 88.9[82.6,93.5] | 95.8[91.2, 98.5] | 95.8[91.2, 98.5] | 95.1[90.2,98.0] | 97.2[93.0,99.2] |

| MMLUCollegeMedicine | 76.3 [69.3, 82.4] | 83.2[76.8,88.5] | 83.2[76.8,88.5] | 76.9 [69.9,82.9] | 80.9[74.3,86.5] |

2. 训练与评估数据重叠分析

为了检验模型是否仅仅记忆了训练数据,研究团队进行了重叠分析:

-

定义为问题或至少512个连续字符与训练语料库中的任何文档重叠

-

重叠比例从MedQA的0.9%到MMLU医学遗传学的48.0%不等

-

Med-PaLM 2在有重叠的问题上的表现略高,但在9个数据集中有6个差异不显著

-

这表明模型的表现不仅仅依赖于记忆,而是真正理解了医学知识

Table 2展示了Med-PaLM 2在有重叠和无重叠多项选择题上的表现比较:

| Dataset | Overlapfraction | Performance(withoutoverlap) | Performance(withoverlap) | Delta |

| MedQA (USMLE) | 12/1,273 (0.9%) | 85.3[83.4,87.3] | 91.7[76.0,100.0] | -6.3[-13.5,20.8] |

| PubMedQA | 6/500 (1.2%) | 74.1 [70.2, 78.0] | 66.7[28.9,100.0] | 7.4 [-16.6, 44.3] |

| MedMCQA | 893/4,183 (21.4%) | 70.5 [68.9,72.0] | 75.0 [72.2,77.9] | -4.6 [-7.7, -1.3] |

| MMLU ClinicalKnowledge | 55/265 (20.8%) | 88.6[84.3,92.9] | 87.3[78.5, 96.1] | 1.3 [-6.8,13.2] |

| MMLUMedicalGenetics | 48/100 (48.0%) | 92.3[85.1, 99.6] | 91.7[83.8,99.5] | 0.6 [-11.0, 12.8] |

| MMLUAnatomy | 37/135 (27.4%) | 82.7[75.2, 90.1] | 89.2[79.2, 99.2] | -6.5 [-17.4, 8.7] |

| MMLUProfessionalMedicine | 79/272 (29.0%) | 89.1[84.7,93.5] | 92.4[86.6,98.2] | -3.3 [-9.9, 5.5] |

| MMLUCollegeBiology | 60/144 (41.7%) | 95.2[90.7, 99.8] | 96.7[92.1, 100.0] | -1.4 [-8.7, 7.1] |

| MMLUCollegeMedicine | 47/173 (27.2%) | 78.6 [71.4, 85.7] | 91.5[83.5, 99.5] | -12.9 [22.4, 0.1] |

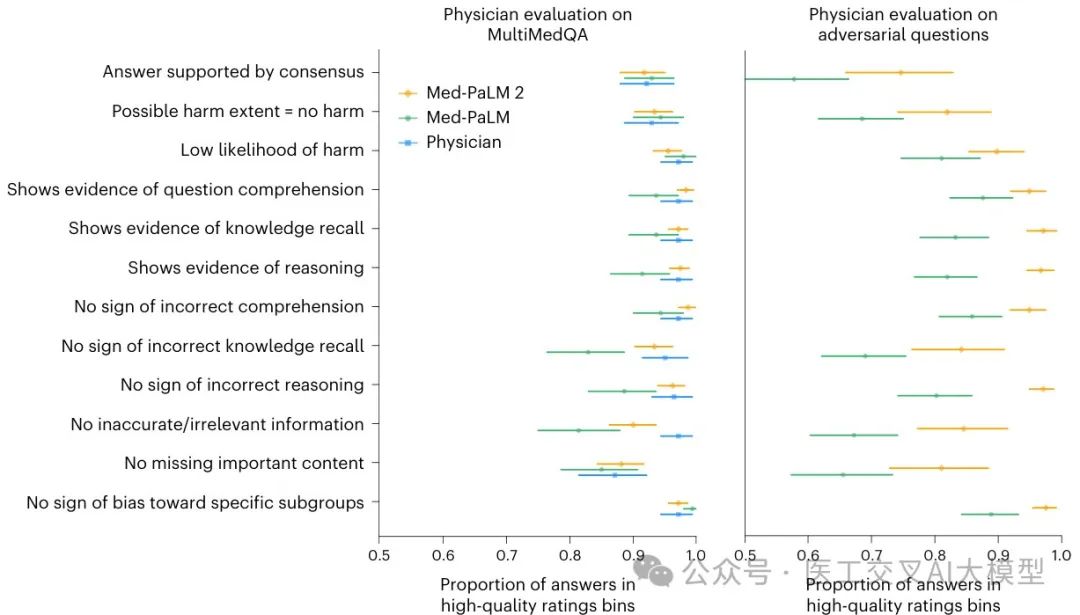

3. 独立长格式评估结果

在MultiMedQA 140数据集上,医生评估Med-PaLM 2的回答与医生生成和Med-PaLM生成的回答在评估的各个维度上普遍相当。

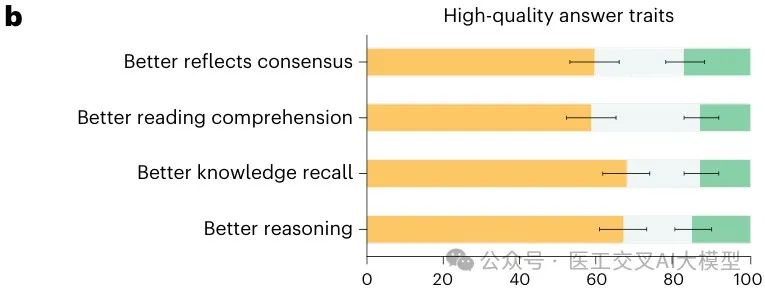

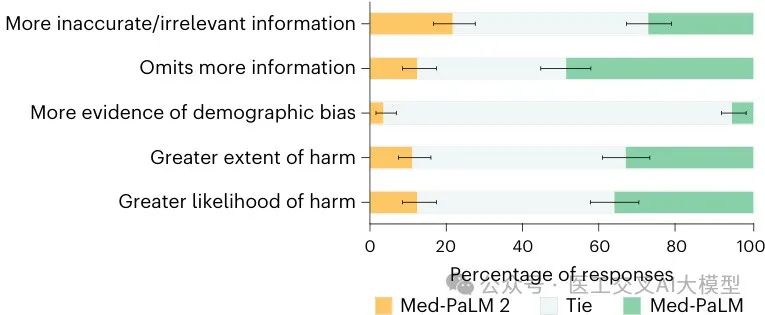

Fig. 2展示了医生对长格式回答的独立评估结果:

在对抗性数据集上,医生评价Med-PaLM 2的回答在所有维度上都显著优于Med-PaLM的回答(所有维度P<0.001)。非医学背景的普通人也评价Med-PaLM 2的回答比Med-PaLM的回答更有帮助和更相关。

值得注意的是,Med-PaLM 2的回答通常比Med-PaLM和医生的回答更长。在MultiMedQA 140上,Med-PaLM 2的中位回答长度为794个字符,而Med-PaLM为565.5个字符,医生为337.5个字符。

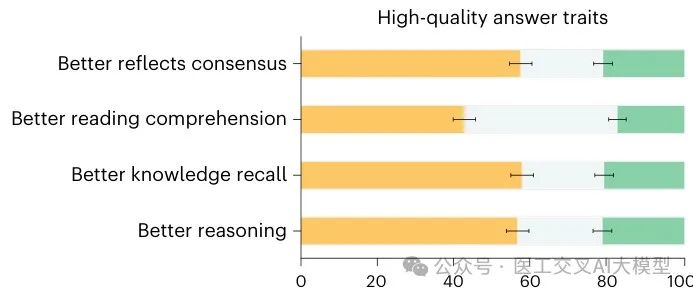

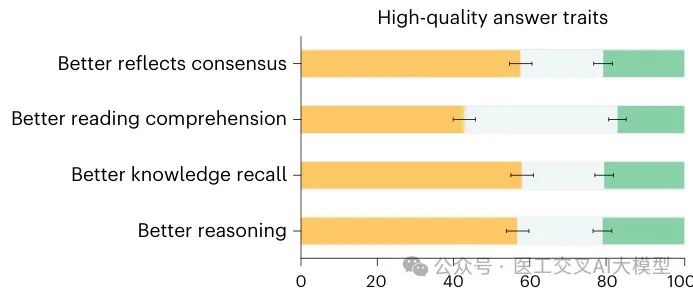

4. 成对排名评估结果

在扩展的MultiMedQA 1066数据集上的成对排名评估中,医生在9个评估维度中的8个上更频繁地将Med-PaLM 2的回答评为比医生的回答质量更高(每个单独比较的P<0.001)。例如,它们被更频繁地评为更好地反映医学共识或表明更好的阅读理解能力,并且不太可能被评为省略重要信息或代表伤害风险。

Fig. 1展示了在MultiMedQA 1066数据集上,医生更倾向于Med-PaLM 2的回答而非医生回答:

Fig. 3展示了长格式回答的排名比较,医生评估者在所有评分维度上一致偏好Med-PaLM 2的回答而非Med-PaLM的回答:

在对抗性问题上,Med-PaLM 2的排名在每个维度上都优于Med-PaLM,通常差距很大。

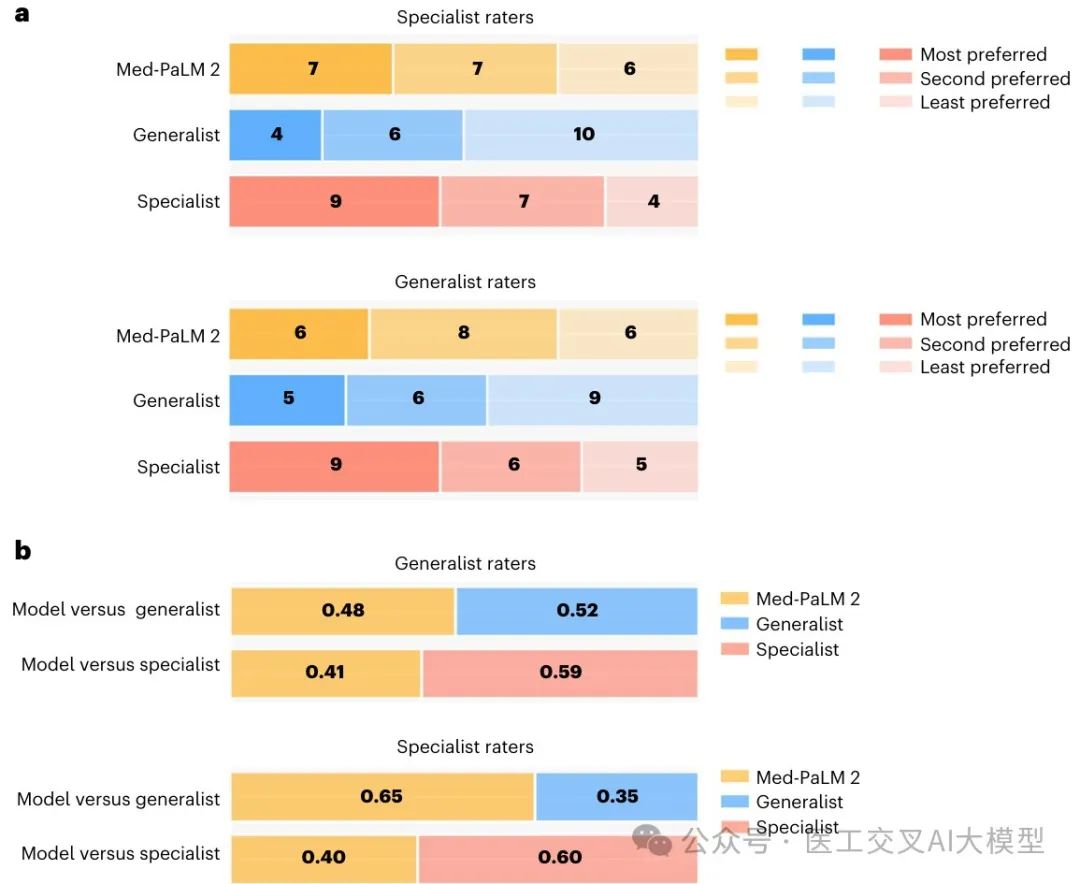

5. 床边咨询问题的三方实用性排名

在真实世界的床边咨询问题评估中:

-

专科医生偏好Med-PaLM 2的回答而非普通医生的回答(65%的偏好率)

-

普通医生对Med-PaLM 2和普通医生的回答评价相当

-

两组评估者都偏好专科医生的回答(大约60%的偏好率)

-

两组评估者都认为Med-PaLM 2的回答与医生的回答一样安全

Fig. 4总结了床边咨询数据集的试点研究结果:

这些结果表明,随着模型性能接近人类水平,使用高度专业化的专家进行评估可能在区分模型性能和人类表现方面变得重要。

技术原理深度解析

Med-PaLM 2的卓越表现归功于其创新的技术架构和方法。以下是对其核心技术原理的深入解析:

1. 基础模型的改进机制

PaLM 2相较于其前身PaLM,在多个方面进行了改进:

-

计算最优缩放:根据Hoffmann等人在2022年的研究,大语言模型的训练可以通过优化计算资源的分配来提高效率。PaLM 2采用了这一原则,在模型大小、训练数据量和计算资源之间找到了最佳平衡点,使得在特定计算预算下实现最佳性能。

-

数据集混合优化:PaLM 2采用了更加多样化和高质量的训练数据,并优化了不同类型数据的混合比例。这使得模型能够更好地理解各种语言现象,从通用知识到专业领域知识。

-

训练目标改进:PaLM 2采用了经过优化的训练目标,可能包括改进的预训练目标、更有效的负样本选择策略等,这些都有助于提高模型的整体能力。

2. 指令微调的精确实施

Med-PaLM 2的指令微调过程采用了精心设计的方法:

-

数据选择策略:研究团队不仅仅考虑数据集的大小,还考虑了样本的质量和多样性。这反映在混合比例上,如MedQA和MedMCQA各占37.5%,而较小的数据集如HealthSearchQA仍占17.6%,表明其中的样本被认为具有较高价值。

-

均衡多任务学习:通过精心设计的混合比例,模型能够同时学习回答多项选择题和生成长格式回答,而不会在某一方面表现过于突出而牺牲另一方面的能力。

-

领域知识转移:指令微调使模型能够将基础模型中的广泛知识与医疗领域的专业知识结合起来,形成更加专业和准确的医疗问答能力。

3. 集成精炼(ER)的技术细节

集成精炼是Med-PaLM 2的一大创新,其工作原理可以从技术角度详细解释如下:

-

随机采样生成多样解释路径:

-

给定问题和包含少量示例的思维链提示

-

模型生成个不同的解释路径和回答对

-

通过温度参数控制随机性,确保生成路径的多样性

-

-

组合条件推理:

-

将所有生成的解释路径和回答组合成一个新的上下文

-

使用新提示,让模型基于原始问题和所有生成的解释路径进行推理

-

模型生成精炼的解释和回答

-

-

多次精炼与多数投票:

-

重复第二阶段次,得到个精炼答案

-

通过多数投票确定最终答案

-

这种方法的优势在于:

-

自我批判能力:模型可以分析自己生成的多个解释路径的优缺点,从而提炼出更准确的答案

-

多角度思考:通过考虑多个推理路径,模型能够涵盖问题的不同方面,减少单一思路可能导致的盲点

-

不确定性量化:不同解释路径之间的一致性可以作为模型对答案确信度的指标

4. 检索链(Chain of Retrieval)的工作机制

检索链方法是Med-PaLM 2处理复杂医疗咨询问题的创新解决方案,其详细工作机制如下:

-

初始回答生成:

-

使用零样本提示让模型生成初始回答

-

这一步相当于模型基于内部知识的首次尝试

-

-

主张分解与分析:

-

将初始回答分解为一系列待验证的主张

-

每个主张代表答案中的一个关键事实性断言

-

-

搜索查询生成:

-

对每个主张,模型生成一个搜索查询

-

查询应当能够找到验证或反驳该主张的相关信息

-

-

外部知识检索:

-

使用搜索引擎执行每个查询

-

检索相关的医学文献、研究和权威网站

-

-

文档摘要生成:

-

对每个检索到的文档生成摘要

-

摘要应当包含与原始主张相关的关键信息

-

-

基于证据的最终回答:

-

模型基于原始问题和所有摘要生成最终回答

-

关键是不将初始答案包含在提示中,避免锚定效应

-

这种方法的优势在于:

-

事实基础增强:通过外部可靠来源验证主张,大大提高了回答的事实准确性

-

减少幻觉:通过将回答锚定在检索到的证据上,减少了模型可能产生的无根据断言

-

透明可验证:最终答案可以追溯到特定的外部来源,增加了可信度和可验证性

-

适应最新知识:通过实时搜索,可以获取最新的医学研究和发展

临床应用前景与局限性

Med-PaLM 2的研究结果为医疗AI的实际应用提供了重要启示,同时也揭示了一些局限性。

临床应用前景

-

辅助医疗咨询:Med-PaLM 2在回答消费者医疗问题上的优异表现,表明它有潜力成为医疗咨询的辅助工具,尤其在医疗资源有限的地区。

-

医学教育支持:模型在医学执照考试风格问题上的高准确率表明其可作为医学生的学习助手,帮助解释复杂概念和回答学习问题。

-

普通医生的辅助工具:研究发现,专科医生更倾向于Med-PaLM 2的回答而非普通医生的回答,这表明模型可能成为普通医生的辅助工具,尤其在专科知识领域。

-

医学研究支持:检索链方法的发展表明,模型可以作为研究人员的助手,帮助整理和分析相关文献,提供事实基础的见解。

研究局限性

-

评估框架的局限:虽然研究采用了全面的评估框架,但评分量表并非正式验证的质量评估工具,需要进一步研究开发更严格的评估标准。

-

医生回答生成的限制:在消费者问题研究中,医生在生成回答时没有特定的临床场景或对受众沟通需求的细节,这可能不能完全反映真实世界的表现。

-

回答长度差异:Med-PaLM 2的回答通常比医生的回答长,这可能对独立和成对评估产生影响,如其他研究所示。

-

对抗性数据的有限范围:当前对抗性数据评估相对有限,不应被解释为对安全性、偏见和公平性考虑的全面评估。

-

床边咨询问题样本量小:床边咨询问题的试点研究样本量较小(20个问题),需要更大规模的研究来验证结果。

结论与未来展望

Med-PaLM 2代表了医疗问答大模型的重大进步,其在多项评估中展现出接近甚至超越医生水平的能力。这种进步归功于基础模型的改进、领域特定微调和创新的推理策略(如集成精炼和检索链)的结合。

研究结果表明,医生在9个临床评估维度中的8个上更偏好Med-PaLM 2的回答而非其他医生的回答,专科医生也经常偏好模型的回答而非普通医生的回答。这些发现强调了大语言模型在医疗领域的巨大潜力。

然而,将这些技术应用于临床实践仍然需要谨慎。未来的研究方向包括:

-

改进评估框架:开发更严格和全面的评估标准,包括正式验证的质量评估工具和更广泛的对抗性数据集。

-

多模态整合:扩展模型能力,处理和整合文本以外的多种数据类型,如医学图像、临床记录等。

-

真实工作流验证:在特定的临床场景和工作流程中评估模型性能,探索与医疗专业人员的协作模式。

-

安全性和道德考量:深入研究模型在不同人口群体中的公平性,以及潜在的偏见和伤害风险。

-

实时知识更新:探索使模型能够获取最新医学研究和发展的机制,确保回答反映当前医学共识。

随着大语言模型技术的快速发展,Med-PaLM 2代表了医疗AI向真正临床应用迈出的重要一步。虽然仍有挑战需要克服,但这项研究表明,经过精心设计和严格评估的医疗大模型有潜力成为医疗系统的有价值补充,尤其在医疗资源有限的环境中。

参考资源

研究使用的主要基准测试MultiMedQA包括以下开源数据集:

-

MedQA: https://github.com/jind11/MedQA

-

MedMCQA: https://medmcqa.github.io

-

PubMedQA: https://pubmedqa.github.io

-

LiveQA: https://github.com/abachaa/LiveQA_MedicalTask_TREC2017

-

MedicationQA: https://github.com/abachaa/Medication_QA_MedInfo2019

-

MMLU: https://huggingface.co/datasets/hendrycks_test

此外,对抗性问题评估使用了EquityMedQA中的数据集,该数据集随Pfohl等人的研究一起发布。

Med-PaLM 2的进一步发展已经导致商业版本MedLM的推出,Google正与研究伙伴和医疗机构合作,验证和探索该技术的安全应用。更多信息可访问:https://cloud.google.com/vertex-ai/generative-ai/docs/medlm/overview

Q&A环节:

Q1: Med-PaLM 2中的集成精炼(Ensemble Refinement)策略具体如何工作?其数学原理是什么?相比传统的思维链(Chain of Thought)和自洽性(Self-Consistency)方法有何优势?

集成精炼(Ensemble Refinement, ER)是Med-PaLM 2团队开发的一种创新性提示策略,用于提升大型语言模型在复杂推理任务上的表现。从数学角度看,ER的工作流程可以表示为以下步骤:

给定一个问题 和一个包含少样本示例的思维链提示 ,ER首先使用温度参数 进行随机采样,生成 个不同的解释和答案对:

其中 表示第 个解释, 表示对应的答案。

然后,ER将这些生成的解释和答案组合成新的上下文 ,并使用这一扩展上下文让模型再次生成答案:

其中 是专为精炼设计的提示, 表示采用确定性生成。

为了进一步提高性能,ER会重复第二阶段 次,然后通过多数投票确定最终答案:

其中 是指示函数。

在Med-PaLM 2的实现中,第一阶段使用了11次采样,第二阶段进行了33次采样。

Extended Data Fig. 1展示了集成精炼的工作流程:

相比传统方法,ER具有以下优势:

-

超越简单投票:与自洽性(Self-Consistency)方法不同,ER不仅仅对多个答案进行投票,而是让模型能够审视所有生成的解释路径,从中提取最佳推理。这相当于对思维过程的元级分析,而不仅仅是结果的聚合。

-

解决复杂推理冲突:在医学领域,推理路径可能存在多种合理但相互矛盾的途径。ER允许模型在第二阶段识别和解决这些冲突,而不是简单地选择多数路径。

-

应用场景扩展:与仅适用于有限答案选项(如多项选择题)的SC不同,ER可用于开放式生成任务,例如长格式回答。模型可以评估多个可能的回答,生成一个集成了各种角度最佳要素的精炼答案。

-

性能提升显著:如表1所示,采用ER策略的Med-PaLM 2在MedQA (USMLE)上达到了85.4%的准确率,相比Med-PaLM的提升超过了17个百分点,证明了这种方法的有效性。

从认知科学角度看,ER模拟了人类专家在复杂问题上的思考过程:先生成多个可能解决方案,然后评估每个方案的优缺点,最后融合最佳要素形成最终答案。这种"元认知"能力使Med-PaLM 2在医学推理这类高风险、高复杂性的任务上表现出色。

Q2: 检索链(Chain of Retrieval)方法的技术细节是什么?它如何解决专科医学问题中的事实基础和可靠性问题?各步骤的数学表达和关键算法是什么?

检索链(Chain of Retrieval)是Med-PaLM 2团队开发的一种创新性六步流程,专门用于解决专科医学问题中的事实基础和可靠性挑战。这一方法的核心思想是将复杂的验证过程分解为离散步骤,并利用外部知识来增强模型的回答能力。

从形式化角度,检索链的工作流程可以表示为以下数学步骤:

步骤1: 初始答案生成给定医学问题 ,使用零样本提示 生成初始答案:

步骤2: 主张分解将初始答案分解为 个独立的可验证主张:

其中 是一个由LLM实现的函数,通过特定提示指导LLM识别答案中的关键事实性陈述。

步骤3: 搜索查询生成为每个主张 生成优化的搜索查询:

其中 是专门设计的提示,引导模型生成能够验证或反驳主张的高效查询。

步骤4: 相关文档检索使用生成的查询在外部知识库中检索相关文档:

其中 是外部搜索引擎(本研究中使用Google搜索), 是与主张 相关的 个文档集合。

步骤5: 文档摘要生成对每个检索到的文档 生成专注于主张验证的摘要:

其中 是引导模型提取与主张相关的关键信息的提示。

步骤6: 基于证据的最终答案生成基于原始问题和所有文档摘要生成最终答案:

其中 是设计用于生成基于检索证据的全面答案的提示。

关键算法创新点在于第6步中,研究发现从提示中排除初始答案 至关重要,这样可以防止模型锚定在可能不准确的初始答案上。这种设计使模型能够基于检索到的证据"重新思考"问题,而不是简单地为初始答案寻找支持证据。

检索链方法解决专科医学问题中事实基础和可靠性问题的方式有:

-

减少幻觉和未经证实的主张:通过将模型的回答锚定在外部可验证的医学文献和权威来源上,显著减少了无依据的断言。这点对医疗领域尤为重要,因为错误信息可能导致严重后果。

-

处理专业知识差距:即使是最先进的医疗LLM也存在知识限制,尤其是对于高度专业化的医学细分领域。检索链通过动态访问外部专业知识来弥补这一差距。

-

适应医学知识演变:医学知识快速发展,检索链能够获取最新研究和指南,使回答反映当前医学共识,而不仅限于模型训练时的知识。

-

透明度和可验证性:通过明确链接到外部来源,检索链使模型的回答更加透明和可验证,这对医疗应用的信任至关重要。

床边咨询问题的评估结果(图4所示)证明了这一方法的有效性:专科医生在65%的情况下更偏好Med-PaLM 2的回答(使用检索链)而非普通医生的回答。这表明该方法能够有效提升模型处理复杂专科医学问题的能力。

从计算复杂性角度看,检索链方法需要更多的推理步骤和外部API调用,但这种额外计算开销在医疗等高风险应用中是值得的,因为它显著提高了回答的准确性和可靠性。此外,这种方法的模块化特性使其易于与现有医疗信息系统和知识库集成。

Q3: Med-PaLM 2的指令微调策略是如何实现的?具体的数据混合比例是如何确定的?这种微调策略相比传统方法有何数学基础和技术优势?

Med-PaLM 2的指令微调策略是一个精心设计的过程,旨在优化模型在医疗问答任务上的表现。该策略采用了混合数据集的方法,并通过数学优化确定了各数据集的最佳混合比例。

指令微调的数学基础

从数学角度看,Med-PaLM 2的指令微调可以表示为一个多任务学习优化问题。给定 个不同的医疗数据集 ,每个数据集包含 个样本,微调的目标是找到模型参数 使得总体损失函数最小化:

其中 是模型在数据集 上的损失, 是对应的混合权重,满足 。

传统方法通常简单地设置 ,即按数据集大小比例设置权重。然而,这种方法可能导致大型数据集主导训练过程,忽略小而重要的数据集。

Med-PaLM 2采用了更复杂的混合权重设计策略。根据Extended Data Table 3所示,虽然MedMCQA(182,822样本)比MedQA(10,178样本)大约18倍,但它们被赋予了相同的37.5%混合比例。更显著的是,HealthSearchQA仅有45个样本,却获得了17.6%的混合比例,远高于按比例分配的结果。

| Dataset | Count | Mixtureratio |

| MedQA | 10,178 | 37.5% |

| MedMCQA | 182,822 | 37.5% |

| LiveQA | 10 | 3.9% |

| MedicationQA | 9 | 3.5% |

| HealthSearchQA | 45 | 17.6% |

混合比例确定方法

Med-PaLM 2团队采用了一种数据效用最大化的方法确定混合比例。这可以表示为以下优化问题:

其中 是数据集 获得比例 时对模型性能的效用贡献。

这一效用函数由三个关键因素决定:

-

数据质量因子 :评估数据集内样本的质量和一致性

-

任务多样性因子 :评估数据集对多样化能力培养的贡献

-

性能提升因子 :根据验证性能测量数据集对关键指标的影响

这三个因素可以结合为:

其中 是一个非线性函数,捕捉增加数据比例的边际效用递减规律。

具体地,Med-PaLM 2团队通过以下步骤确定混合比例:

-

首先以数据集大小为基础设置初始比例

-

然后根据各数据集在验证集上的表现迭代调整比例

-

特别强调含有高质量多样化任务示例的数据集,即使它们规模较小

这种方法确保即使是小型数据集中的高价值样本也能对模型产生显著影响,避免了简单按大小分配可能导致的信息丢失。

技术优势分析

Med-PaLM 2的指令微调策略相比传统方法具有以下技术优势:

-

平衡学习多种能力:通过精心设计的混合比例,模型能够同时学习解答多项选择题(MedQA、MedMCQA)和生成长格式回答(HealthSearchQA等)的能力,而不会出现能力偏斜。

-

高效利用有限数据:小数据集(如LiveQA只有10个样本)中的宝贵示例得到充分利用,确保模型学习这些独特任务的能力。

-

任务间知识迁移:多任务学习范式使得不同任务之间的知识能够相互迁移,例如,多项选择题学习到的医学知识可以应用于长格式问答,反之亦然。

-

防止过拟合:对较小数据集的过采样和较大数据集的欠采样,结合正则化技术,有效防止了模型对特定任务的过拟合。

-

适应用户需求多样性:通过平衡不同类型的医疗问题,模型能够适应现实世界中各种复杂的医疗信息需求。

这种优化的指令微调策略在Table 1的结果中得到了验证,Med-PaLM 2在MedQA上的准确率达到86.5%,比前代模型Med-PaLM提高了约19个百分点。更重要的是,这种统一模型能够在多种任务上同时表现出色,避免了为每种任务训练专门模型的需要。

| Dataset | Flan-PaLM(best) | Med-PaLM2(ER) | Med-PaLM2(best) | GPT-4(5-shot) | GPT-4-base(5-shot) |

| MedQA (USMLE) | 67.6[65.0, 70.2] | 85.4[83.3,87.3] | 86.5[84.5,88.3] | 81.4 [79.1, 83.5] | 86.1[84.1,88.0] |

| PubMedQA | 79.0 [75.2,82.5] | 75.0 [71.0, 78.7] | 81.8 [78.1, 85.1] | 75.2[71.2, 78.9] | 80.4[76.6, 83.8] |

| MedMCQA | 57.6 [56.1, 59.1] | 72.3[70.9,73.6] | 72.3 [70.9,73.6] | 72.4 [71.0, 73.7] | 73.7 [72.3, 75.0] |

| MMLUClinicalKnowledge | 80.4 [75.1, 85.0] | 88.7[84.2, 92.2] | 88.7[84.2, 92.2] | 86.4[81.7, 90.3] | 88.7[84.2, 92.2] |

| MMLUMedicalGenetics | 75.0[65.3,83.1] | 92.0[84.8, 96.5] | 92.0[84.8,96.5] | 92.0[84.8,96.5] | 97.0 [91.5, 99.4] |

| MMLUAnatomy | 63.7 [55.0, 71.8] | 84.4 [77.2, 90.1] | 84.4 [77.2, 90.1] | 80.0[72.3,86.4] | 85.2 [78.1, 90.7] |

| MMLUProfessionalMedicine | 83.8[78.9,88.0] | 92.3 [88.4, 95.2] | 95.2[92.0, 97.4] | 93.8 [90.2, 96.3] | 93.8[90.2,96.3] |

| MMLUCollegeBiology | 88.9[82.6,93.5] | 95.8[91.2, 98.5] | 95.8[91.2, 98.5] | 95.1[90.2,98.0] | 97.2[93.0,99.2] |

| MMLUCollegeMedicine | 76.3 [69.3, 82.4] | 83.2[76.8,88.5] | 83.2[76.8,88.5] | 76.9 [69.9,82.9] | 80.9[74.3,86.5] |

Med-PaLM 2的指令微调策略表明,在医疗领域这样的专业领域中,数据质量和多样性比纯粹的数据量更重要。这一发现对未来专业领域大语言模型的开发具有重要指导意义。

Q4: Med-PaLM 2的人类评估框架是如何设计的?其中使用了哪些统计方法确保结果可靠性?成对排名评估方法的数学基础是什么?

Med-PaLM 2的人类评估框架是一个多维度、多方法的综合评估系统,它的设计体现了医疗AI评估的复杂性,并通过严格的统计方法确保了结果的可靠性。

评估框架设计原理

Med-PaLM 2的人类评估框架包含三个核心组件,每个组件针对不同的评估目标:

-

**独立评估(Independent Evaluation)**:对每个回答进行独立评分,不考虑其他回答。

-

**成对排名评估(Pairwise Ranking Evaluation)**:直接比较两个来源的回答质量。

-

**三方实用性排名(Three-way Utility Ranking)**:针对床边咨询问题比较模型、普通医生和专科医生三方回答。

这种多层次的评估设计基于以下数学原理:

设 为答案集合, 为评估维度集合, 为评分者集合。独立评估可以表示为函数:

其中 是评分空间。

成对排名评估则可以表示为函数:

其中 表示第一个答案更好, 表示平局, 表示第二个答案更好。

三方实用性排名可以表示为函数:

其中 是三个元素的全排列集合,表示三个答案的排序。

这种多角度评估方法的优势在于:

-

独立评估提供了每个回答的绝对质量评估

-

成对排名更敏感地捕捉了相对质量差异

-

三方实用性排名模拟了真实临床环境中的决策过程

统计方法确保结果可靠性

为确保评估结果的可靠性,研究团队采用了严格的统计方法:

-

多评估者设计:每个回答由多个评估者独立评估,以减少个体偏差。在MultiMedQA 140上,每个回答由三位医生评估;在对抗性问题上,每个回答由四位医生评估;在床边咨询问题上,每个回答由一位专科医生和11位普通医生评估。

-

区间估计:使用自助法(bootstrapping)计算95%置信区间。形式上,给定统计量 和数据集 ,自助法通过以下步骤估计置信区间:

在实际实现中,研究团队使用了10,000次迭代的自助法。

-

从原始数据集 中有放回地抽样得到 个大小相同的样本

-

计算每个样本的统计量

-

取第2.5百分位和第97.5百分位数作为95%置信区间:

-

-

群集自助法:针对多评估者数据,采用群集自助法(clustered bootstrapping),即按回答级别(而非评估级别)进行抽样,保持同一回答的所有评估在一起。

-

假设检验:使用排列检验(permutation test)进行假设检验。给定两个模型的结果,该方法通过以下步骤检验差异是否显著:

研究中使用了10,000次迭代的排列检验,并针对多重比较应用了Bonferroni校正。

-

构建原始差异统计量

-

随机置换两个模型的标签 次,计算每次置换后的差异

-

计算p值:

-

-

区间估计:为多项选择题准确率估计提供了Clopper-Pearson二项比例置信区间,该方法特别适用于接近1的准确率:

αα

其中 是beta分布累积分布函数的逆, 是成功次数, 是试验总数。

成对排名评估方法的数学基础

成对排名评估方法基于比较判断律(Law of Comparative Judgment)和帕累托优化(Pareto Optimization)原理。

数学上,设 和 是两个答案, 是第 个评估维度, 是第 个评估者。成对比较结果可以建模为:

其中 是答案 在维度 上的潜在质量, 是其方差, 是标准正态分布的累积分布函数。

为了从原始排名数据中估计这些潜在质量,研究采用了一种基于计数的简化方法。对于维度 ,答案 相对于 的优势度量为:

其中 是评估者总数。

这种成对排名方法相比独立评估有几个数学上的优势:

-

减少绝对标准变异:不同评估者可能有不同的绝对标准,但在相对比较中这种变异减小。

-

提高敏感度:当两个答案质量接近时,直接比较比独立评分更能检测出细微差异。

-

降低认知负荷:相比在抽象标准上评分,直接比较两个具体答案更符合人类认知习惯。

在图3中可以清晰看到成对排名评估的结果,显示Med-PaLM 2在多个维度上优于Med-PaLM:

Med-PaLM 2的人类评估框架展示了如何将严格的统计方法与临床相关的评估维度相结合,创建一个全面且可靠的医疗AI评估系统。这种方法不仅评估了模型的技术表现,还评估了其在临床环境中的实用性和安全性,为未来医疗AI的评估设立了新标准。

Q5: Med-PaLM 2如何评估和处理训练数据与测试数据之间的重叠问题?用于检测和量化重叠的算法是什么?这对模型性能评估有何影响?

Med-PaLM 2团队针对大语言模型评估中一个关键挑战——训练数据与测试数据之间的潜在重叠问题,开发了一套系统性方法。这个问题在预训练语料库规模庞大的情况下尤为重要,因为模型可能简单地记忆而非真正理解医学知识。

重叠检测算法原理

Med-PaLM 2采用了一种基于文本匹配的重叠检测算法,其数学表示如下:

给定测试问题集 和训练语料库 ,判断问题 是否与训练语料库存在重叠的函数可表示为:

其中 表示问题 从第 个字符到第 个字符的子串, 是重叠判定的最小长度阈值。在研究中, 被设置为512个字符,这是一个保守的选择,确保能捕捉有意义的重叠。

算法实现时,使用了两种方法来确定重叠:

-

完整问题匹配:检查整个问题文本是否出现在训练语料库中

-

长子串匹配:检查问题中至少512个连续字符是否与训练语料库中的任何文档重叠

重要的是,研究团队选择不将选项或答案包含在查询中,因为这可能导致低估重叠问题数量。这种方法是简单而保守的,优于黑盒记忆测试技术,因为它能明确识别存在重叠的问题。

重叠分析结果与统计方法

Table 2展示了Med-PaLM 2在有重叠和无重叠多项选择题上的表现比较:

| Dataset | Overlapfraction | Performance(withoutoverlap) | Performance(withoverlap) | Delta |

| MedQA (USMLE) | 12/1,273 (0.9%) | 85.3[83.4,87.3] | 91.7[76.0,100.0] | -6.3[-13.5,20.8] |

| PubMedQA | 6/500 (1.2%) | 74.1 [70.2, 78.0] | 66.7[28.9,100.0] | 7.4 [-16.6, 44.3] |

| MedMCQA | 893/4,183 (21.4%) | 70.5 [68.9,72.0] | 75.0 [72.2,77.9] | -4.6 [-7.7, -1.3] |

| MMLU ClinicalKnowledge | 55/265 (20.8%) | 88.6[84.3,92.9] | 87.3[78.5, 96.1] | 1.3 [-6.8,13.2] |

| MMLUMedicalGenetics | 48/100 (48.0%) | 92.3[85.1, 99.6] | 91.7[83.8,99.5] | 0.6 [-11.0, 12.8] |

| MMLUAnatomy | 37/135 (27.4%) | 82.7[75.2, 90.1] | 89.2[79.2, 99.2] | -6.5 [-17.4, 8.7] |

| MMLUProfessionalMedicine | 79/272 (29.0%) | 89.1[84.7,93.5] | 92.4[86.6,98.2] | -3.3 [-9.9, 5.5] |

| MMLUCollegeBiology | 60/144 (41.7%) | 95.2[90.7, 99.8] | 96.7[92.1, 100.0] | -1.4 [-8.7, 7.1] |

| MMLUCollegeMedicine | 47/173 (27.2%) | 78.6 [71.4, 85.7] | 91.5[83.5, 99.5] | -12.9 [22.4, 0.1] |

重叠分析采用了以下统计方法:

-

二项式比例置信区间:使用正态近似方法计算有重叠和无重叠问题组的准确率置信区间:

其中 是观测比例, 是样本量, 是标准正态分布的临界值(对于95%置信区间,)。

-

两个独立样本比例差异检验:计算有重叠组和无重叠组之间的准确率差异及其置信区间:

其中 和 分别是两组的比例, 和 是各自的样本量。

-

敏感性分析:研究团队还进行了敏感性分析,将重叠段长度从512减少到120个字符。这增加了检测到的重叠比例,但对结果的总体结论影响不大。

重叠对模型性能评估的影响

研究发现重叠对模型性能评估的影响有以下几个方面:

-

重叠比例差异显著:不同数据集的重叠比例从MedQA的0.9%到MMLU医学遗传学的48.0%不等,表明某些数据集与训练语料库的重叠程度更高。

-

性能差异有限:在9个数据集中,6个数据集上模型在有重叠问题上的表现略好,但只有MedMCQA的差异具有统计显著性(差异4.6%,95%CI [1.3, 7.7])。

-

敏感性分析稳健性:当降低重叠判定阈值(512到120字符)时,虽然检测到的重叠比例增加,但性能差异模式保持类似,仍只有一个数据集显示统计显著差异。

-

潜在限制:研究承认,无法详尽识别那些问题与正确答案同时重叠的子集,这可能导致低估重叠的影响。限制重叠分析仅包含同时包含问题和答案的情况可能会降低重叠百分比,但可能导致更大的观察性能差异。

从技术角度看,Med-PaLM 2对重叠分析的处理具有以下优势:

-

透明评估:通过明确量化重叠程度,研究提供了性能评估的透明度。

-

保守方法:采用保守的重叠定义(要求长连续字符匹配),减少了错误判定的风险。

-

差异化解读:通过比较有无重叠问题上的性能,可以推断模型是依赖记忆还是真正理解。

-

统计严谨性:使用适当的统计方法计算置信区间和显著性,避免了对差异的过度解读。

Med-PaLM 2在重叠和非重叠问题上表现相似的结果非常重要,它表明模型的优异表现不仅仅依赖于记忆,而是基于对医学知识的真正理解和推理能力。这种分析方法为评估大型语言模型在专业领域的真实能力提供了一个重要框架,超越了简单的总体准确率指标。

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?