最近开始集中校招提前批和人才计划面试,偶尔也穿插着社招的面试,根据目前的简历和面试情况,跟大家汇报一下一线大模型技术方向的人才风向标。

**总结几个关键结论和要点放在前面:

**

1.有大模型方向论文的硕博很少,大部分论文还是在模型架构排列组合,屎上雕花。

2.有大模型训练经验简历的很少,有65B以上大模型全量训练的更少,有预训练的经验就像捡到了宝。

3.模型评测和强化学习方面经验很稀缺。

4.大模型选型上一定要紧跟行业主流认知。

5.成功落地的场景稀少,目前都在探索阶段。

6.大模型需求依然很旺盛,优秀简历很抢手

7.大模型八股文的频率高吗?

下面就这几个点展开说一下:

1.有大模型方向论文的硕博很少,大部分论文还是在模型架构排列组合,屎上雕花。

这个无可厚非,每一次技术革新都意味代价,大家搞论文也不一定是为了影响力这么远大的目标,很多时候是为了混口饭吃。

在本来就价值不大的领域方向上,针对只会有1%发生频率的特定问题,进行了过度网络结构优化,最后取得几个点的提升,这类典型的比较水的工作太多了,现在已经无法吸引面试官眼球了。

首先这部分工作有两个问题,第一是真的没有太大的作用了,可能还比不过chagpt zeroshot直接来解决这些的水平,另外,往往有更简单的方法其实明明也可以做的很好,但可惜就是想做的胡哨。

在大模型时代,大力出奇迹和朴素简单有用都是有价值的,唯一没太大用处的就是稀奇古怪的方法组合起来,解决了一个不太经常出现的问题。

这时候如果你有一篇大模型相关的录用的研究,会让面试官眼前一亮。

2.有大模型训练经验简历的很少,有65B以上大模型全量训练的更少,预训练的经验就像捡到了宝。

这个更无可厚非,毕竟整个行业大家都买不到卡了,大部分人手中的卡可能还是32GB的V100,也还没有多少张。

大部分人的简历还是围绕大模型做一些边角工作,或者注定天花板不是很高的方法,比如lora,ptuning等。

7B全量微调的起步的8张40GB的A100,这个储备也不是那么好弄了现在。65B全量微调的起步得上百张卡了。

预训练更别提了,简单算下,8张A100 每天可以过个位数GB数据,假设要跑GB数据的话,几个月就没了。

另外做大模型训练的更像是一个团队的工程活,每个人负责拧一个螺丝。有完整的从0起步的经验也是各家的香饽饽,简历已经在猎头那一端被抢爆了。

3.模型评测和强化学习方面经验很稀缺。

模型评测和强化学习算是大模型目前的黑科技了,谁能做的又快又准又好,就能和同行显著拉开差距。

强化学习要求的训练资源也不低,经典的ppo方法直接加载4个模型,两个训练两个不训练,使得7B大小的模型,起步要求变成了8张80GB的A100,叠加大家卡短缺的问题,搞得人就更少了。

另外,模型评测和强化学习本来就有很大的坑,属于很不好拿收益的两个方向。

之前写过两篇文章大模型评测,也太难了吧和大模型RLHF的trick,讲过这个问题。

**评测:**怎么评价一个模型的好坏,不仅困难,而且十分重要,绝对是一个核心的科技,这现在也是除了oepnai各家没怎么搞定的一个问题。

这个问题很关键,是因为基座大模型的训练耗时耗力,如果不能想出很好的提早检验方式的话,做实验的速度会慢特别多,所有的时间成本都可以折合成算力上。

所以你做实验慢了,相当于比别人少了GPU,足够触目惊心吧。

强化学习:

如果你动手跑几次ppo的过程就发现了,大模型的强化学习非常难以训练,难以训练不仅仅指的是费卡,还是指的非常容易训崩。

第一,费卡。假设你训llama 7b,SFT 和 RM 都用7B的模型,那么显存耗费 = 2*7B(TRIAN MODE) + *7B(EVAL MODE), 分别对应 policy model / critic model,还有ref model/reward model

本来你能用几张40GB A100的卡+deepspeed 做7b的全参数微调,强化学习就得升级到80GB的A100了,勉勉强强能跑到7B。想跑更大的就得充钱了。

第二,容易崩。LLM训着训着就不听你话了,要么变成停不下来的复读机,输出到后面没有逻辑直到maxlen,要么变成哑巴,直接一个eosid躺平。

RLHF中的问题其实在RL游戏训练里面很常见了,如果环境和参数设置不好的话,agent很容走极端,在 一头撞死or循环鬼畜之间反复横跳。

原始的ppo就是很难训,对SFT基模型和RM的训练数据以及采样prompt的数据要求很高,参数设置要求也很高。

自从openai带了一波RLHF的节奏后,大家都觉得强化学习在对齐方面的无敌功力,但自己跑似乎又不是那么回事,这玩意也太有讲究了吧。

更多的魔鬼在细节了,openai像拿了一个比赛的冠军,告诉你了成功的solution,结果没告诉你各个步骤的重要性和关键设置,更没有告诉你失败和无效的经验。

这两块的有用的经验太稀缺了,可能整个行业的面试官也没有很好的认知和判断,碰上有这样经验的人就当请教了。

最差的情况就是明明搞一些困难的问题也没拿到什么结果,还一本正经地写上了取得了一定结果,这样会拉高别人的预期,再狠狠得摔在了地上。

4.大模型选型上一定要紧跟行业主流认知

有些同学弄了一些偏门模型的经验,然后信誓旦旦的给了一些结论,显得十分不靠谱的。

主流认知就是llama系列微调潜力最好,中文zeroshot推理chagtlm/llama变种等都可以,微调chatglm其实效果一般。

这些原因我之前也讲过了,出门右转这篇文章大模型微调样本构造的trick。

但是还有一些简历还是在选型上没有充分紧跟开源社区,有一些跟主流认知的偏差的地方,这样就没办法在一个层次上互相交流沟通,显得面试在鸡对鸭讲。

5.成功落地的场景稀少,目前都在探索阶段

从现在的简历来看,整个行业的进展还是比较慢的,尤其是在落地领域。

大多数的大模型项目还是抱着试试看或者玩玩的心态,另外或者是demo的状态,或多或少总会遇到各种坑无法落地。

比如幻觉问题很严重,风控问题解决不了,资源消耗覆盖不住,推断延迟太大影响体验等等。

这里面每一个问题都可以展开讲一堆,是实际落地问题里面必然会碰到的问题。

整个行业的简历很少碰到有人完整的从0起步,一点点解决了这些棘手的问题并正了八经落地的,当然这个要求可能太高了,也就离创业成功不远了。

6.大模型需求依然很旺盛,优秀简历很抢手

目前除了一些知名的垂直的初创公司做大模型基建基座外,还有很多优秀的AIGC应用公司在具体的应用方向上发力。

另外,大公司在这方向上也来势汹汹,手快的组很快申请到了计算资源,例如很多以前跟搜索,交互,NLP相关的部门,都在摩拳擦掌准备分一杯羹梗。

大公司的项目有更明显的玩票特点,相对更不靠谱一点,这也和大公司本身有比较强的拖底效应有关,创业公司搞不出来就干黄了,大公司搞不出来就当练手了,至少还摸了一把,蹭了新鲜。

目前几乎每个大厂都有10+个以上的达模型jd,候选人投递的时候一定要仔细考察,分辨是玩票性质还是做的比较扎实。

7.大模型八股文的频率高吗?

如果简历比较扎实的话,有相对较为丰富的大模型经验,其实基本上是不会问八股文的,因为一个小时的时间,交流一点一线搞大模型的经验和心得都来不及,根本没有时间问八股文。

如果简历比较虚,或者没有相关经验,但是过往经历ok,准备往这个方向转的话,还是会着重考察潜力和基础的。潜力就是对应一些考察思维的题目,基础对应着一些八股文。

附上技术清单

在这里,我们想要强调的是:成功求职并不是一件难事,关键在于你是否做好了充分的准备。通过学习和掌握AI技术的相关知识和技能,了解面试中可能出现的问题和技巧,你就能够在面试中展现出自己的专业素养和实力,赢得面试官的青睐和认可。因此,让我们一起努力,用知识和技能武装自己,迎接AI时代的挑战和机遇吧!

有需要的朋友可以扫描下方二维码,免费获取更多相关资料!

最后,祝愿所有转行、求职的同学都能够在AI产品面试中取得优异的成绩,找到心仪的工作!加油!

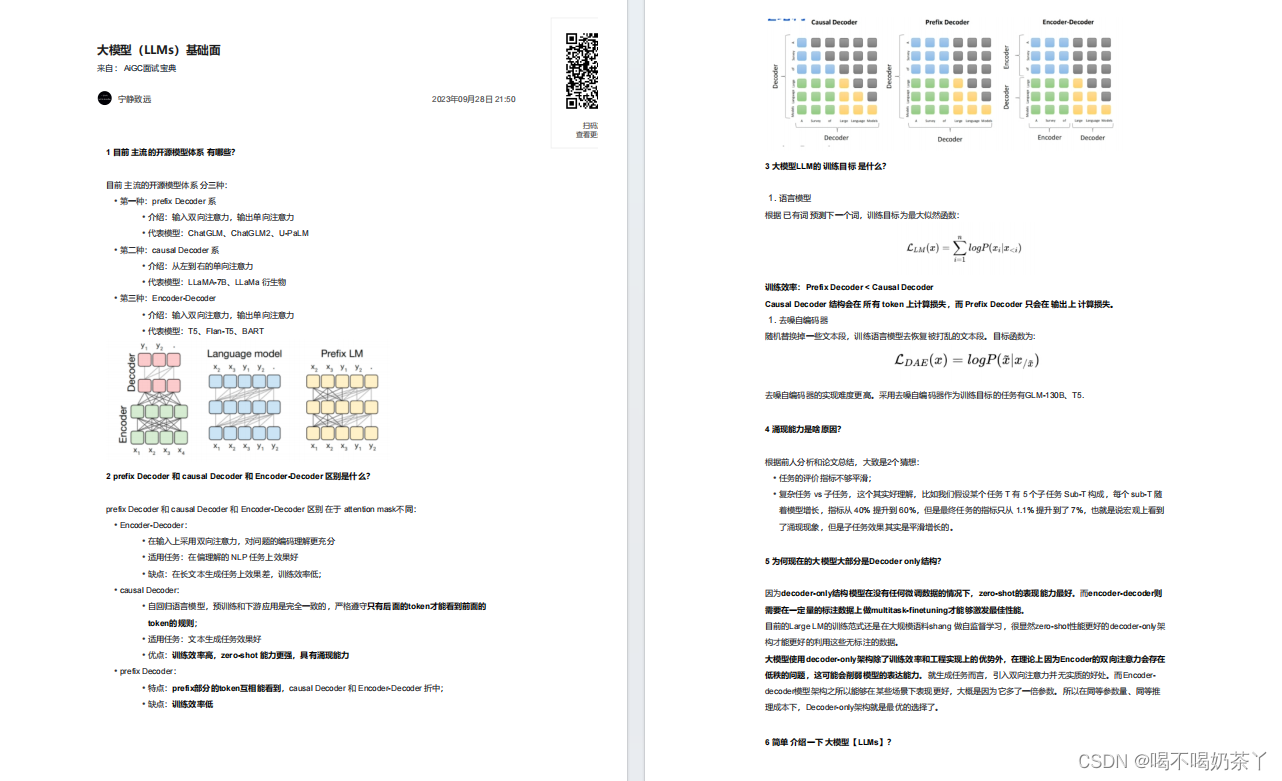

大模型基础面

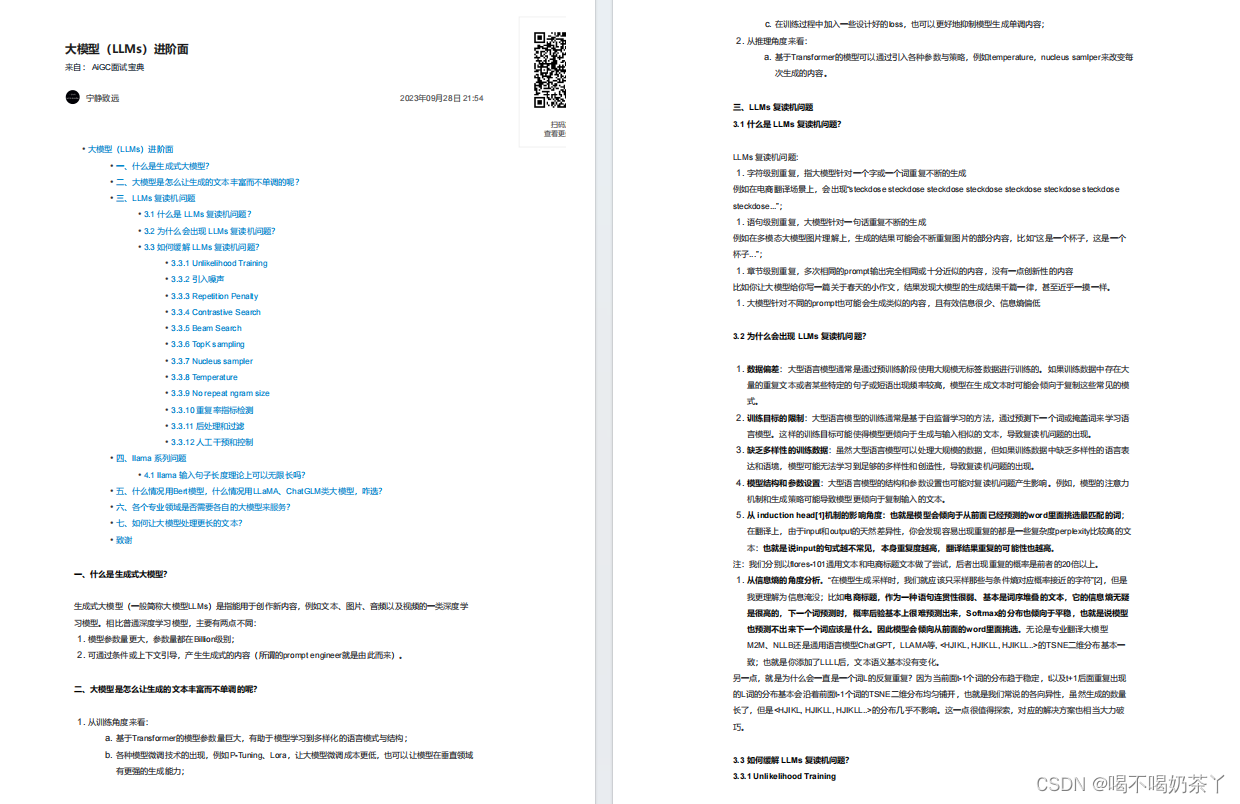

大模型进阶面

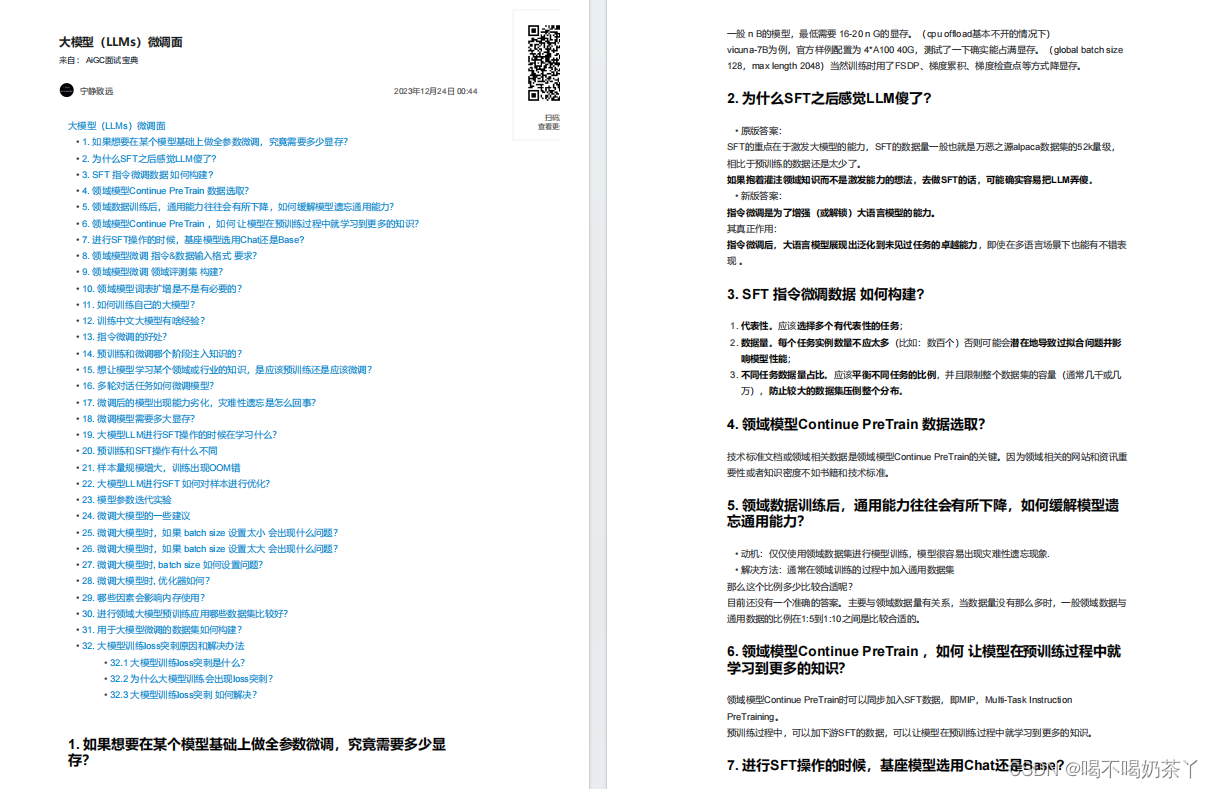

大模型微调面

大模型langchain面

大模型推理面

更多面试题分享

934

934

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?