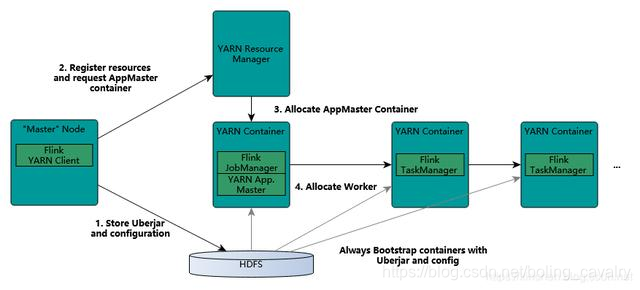

除了常见的standalone模式,Flink还支持将任务提交到Yarn环境执行,任务所需的计算资源由Yarn Remource Manager来分配,如下图(来自Flink官网):

因此需要搭建一套Yarn环境,通过CDH部署Yarn、HDFS等服务是常见方式,接下来就采用此方式来部署;

部署方式

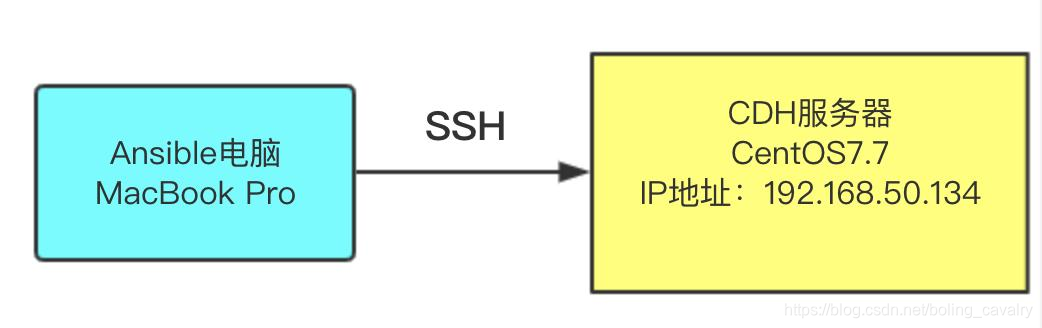

ansible是常用的运维工具,可以大幅度简化整个部署过程,接下来会使用ansible来完成部署工作,如果您对ansible还不够了解,请参考《ansible2.4安装和体验》,部署操作如下图所示,在一台安装了ansible的电脑上运行脚本,由ansible远程连接到一台CentOS7.7的服务器上,完成部署工作:

硬件准备

-

一台可以运行ansible的电脑,我这里用的是MacBook Pro,也用CentOS验证过,都可以顺利完成部署;

-

一台CentOS7.7的电脑用于运行Yarn和Flink(文中的CDH服务器就是指该电脑),为了操作简单,本次实战将CDH、Yarn、HDFS、Flink都部署在这一台机器上,实测发现,此电脑CPU至少要双核,内存不低于16G,如果您想用多台电脑部署CDH,建议自行修改ansible脚本来分别部署,脚本地址后面会给出;

软件版本

-

ansible电脑操作系统:macOS Catalina 10.15(实测用CentOS也能成功)

-

CDH服务器操作系统:CentOS Linux release 7.7.1908

-

cm版本:6.3.1

-

parcel版本:5.16.2

-

flink版本:1.7.2

注意:因为flink需要hadoop2.6版本,所以parcel选择了5.16.2,这里面对应的hadoop是2.6版

CDH服务器设置

需要登录CDH服务器执行以下设置:

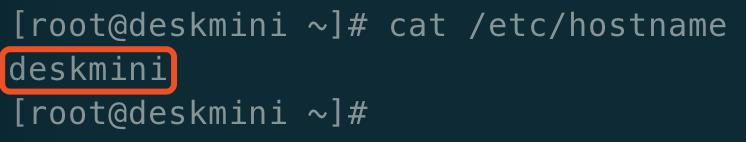

- 检查/etc/hostname文件是否正确,如下图:

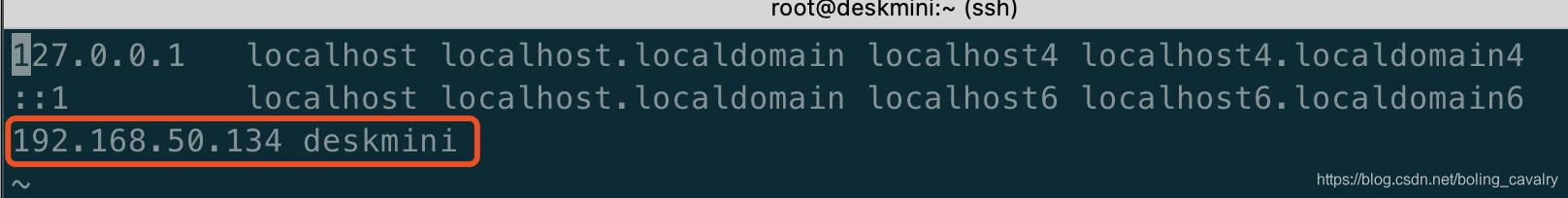

- 修改/etc/hosts文件,将自己的IP地址和hostname配置上去,如下图红框所示(事实证明这一步很重要,如果不做可能导致在部署时一直卡在"分配"阶段,看agent日志显示agent下载parcel的进度一直是百分之零):

下载文件(ansible电脑)

本次实战要准备13个文件,如下表所示(后面会给出每个文件的获取方式):

| 编号 | 文件名 | 简介 |

| — | — | — |

| 1 | jdk-8u191-linux-x64.tar.gz | Linux版的jdk安装包 |

| 2 | mysql-connector-java-5.1.34.jar | mysql的JDBC驱动 |

| 3 | cloudera-manager-server-6.3.1-1466458.el7.x86_64.rpm | cm的server安装包 |

| 4 | cloudera-manager-daemons-6.3.1-1466458.el7.x86_64.rpm | cm的daemon安装包 |

| 5 | cloudera-manager-agent-6.3.1-1466458.el7.x86_64.rpm | cm的agent安装包 |

| 6 | CDH-5.16.2-1.cdh5.16.2.p0.8-el7.parcel | CDH应用离线安装包 |

| 7 | CDH-5.16.2-1.cdh5.16.2.p0.8-el7.parcel.sha | CDH应用离线安装包sha验证码 |

| 8 | flink-1.7.2-bin-hadoop26-scala_2.11.tgz | flink安装包 |

| 9 | hosts | ansible用到的远程主机配置,里面记录了CDH6服务器的信息 |

| 10 | ansible.cfg | ansible用到的配置信息 |

| 11 | cm6-cdh5-flink1.7-single-install.yml | 部署CDH时用到的ansible脚本 |

| 12 | cdh-single-start.yml | 初次启动CDH时用到的ansible脚本 |

| 13 | var.yml | 脚本中用到的变量都在在此设值,

例如CDH包名、flink文件名等,便于维护 |

下面是每个文件的下载地址:

-

jdk-8u191-linux-x64.tar.gz:Oracle官网可下,另外我将jdk-8u191-linux-x64.tar.gz和mysql-connector-java-5.1.34.jar一起打包上传到csdn,您可以一次性下载,地址:https://download.csdn.net/download/boling_cavalry/12098987

-

mysql-connector-java-5.1.34.jar:maven中央仓库可下,另外我将jdk-8u191-linux-x64.tar.gz和mysql-connector-java-5.1.34.jar一起打包上传到csdn,您可以一次性下载,地址:https://download.csdn.net/download/boling_cavalry/12098987

-

cloudera-manager-server-6.3.1-1466458.el7.x86_64.rpm:https://archive.cloudera.com/cm6/6.3.1/redhat7/yum/RPMS/x86_64/cloudera-manager-server-6.3.1-1466458.el7.x86_64.rpm

-

cloudera-manager-daemons-6.3.1-1466458.el7.x86_64.rpm:https://archive.cloudera.com/cm6/6.3.1/redhat7/yum/RPMS/x86_64/cloudera-manager-daemons-6.3.1-1466458.el7.x86_64.rpm

-

cloudera-manager-agent-6.3.1-1466458.el7.x86_64.rpm:https://archive.cloudera.com/cm6/6.3.1/redhat7/yum/RPMS/x86_64/cloudera-manager-agent-6.3.1-1466458.el7.x86_64.rpm

-

CDH-5.16.2-1.cdh5.16.2.p0.8-el7.parcel:https://archive.cloudera.com/cdh5/parcels/5.16.2/CDH-5.16.2-1.cdh5.16.2.p0.8-el7.parcel

-

CDH-5.16.2-1.cdh5.16.2.p0.8-el7.parcel.sha:https://archive.cloudera.com/cdh5/parcels/5.16.2/CDH-5.16.2-1.cdh5.16.2.p0.8-el7.parcel.sha1 (下载完毕后,将扩展名从.sha1为.sha)

-

flink-1.7.2-bin-hadoop26-scala_2.11.tgz:http://ftp.jaist.ac.jp/pub/apache/flink/flink-1.7.2/flink-1.7.2-bin-hadoop26-scala_2.11.tgz

-

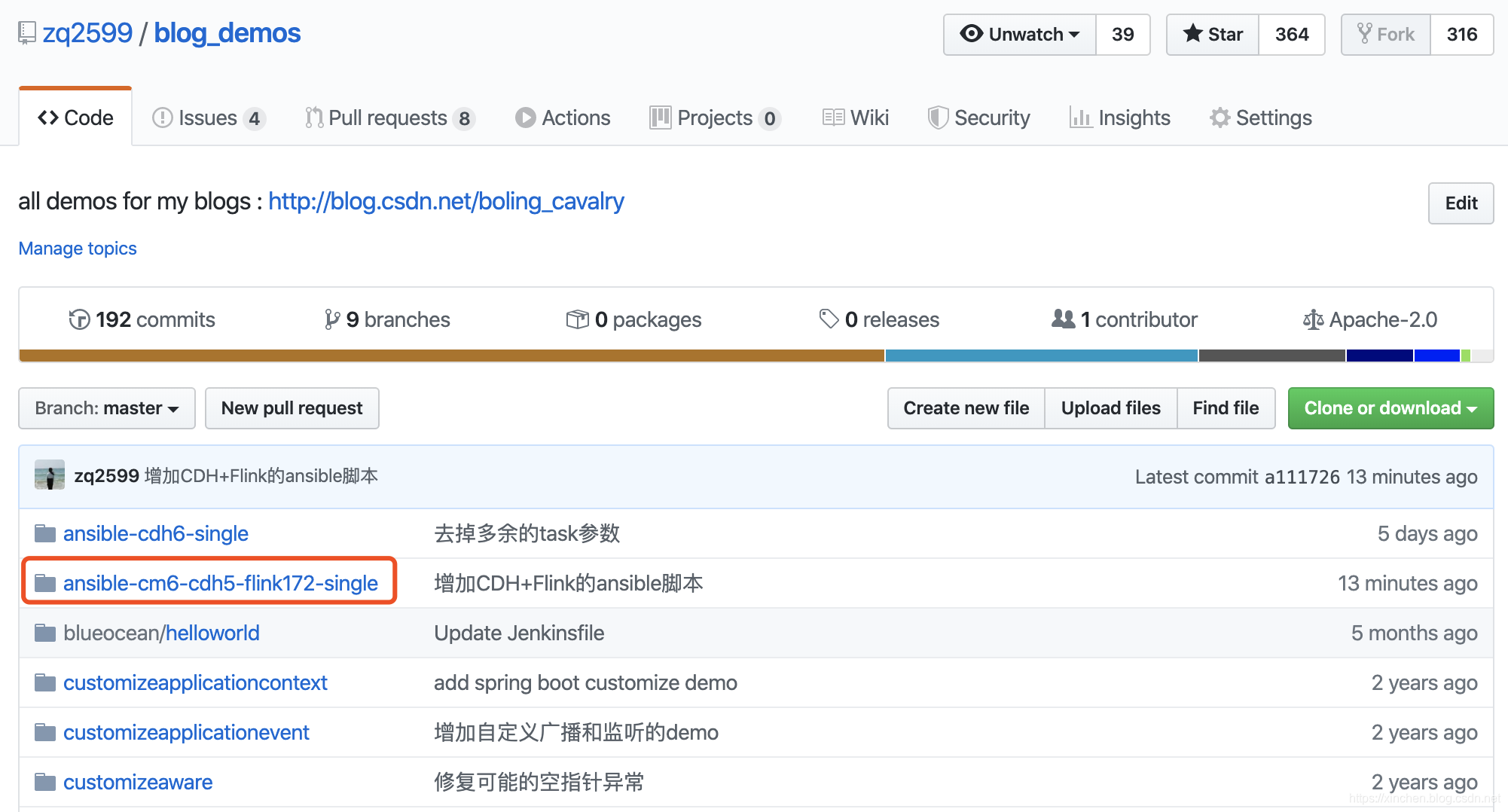

hosts、ansible.cfg、cm6-cdh5-flink1.7-single-install.yml、cdh-single-start.yml、var.yml :这五个文件都保存在我的GitHub仓库,地址是:https://github.com/zq2599/blog_demos ,这里面有多个文件夹,上述文件在名为ansible-cm6-cdh5-flink172-single的文件夹中,如下图红框所示:

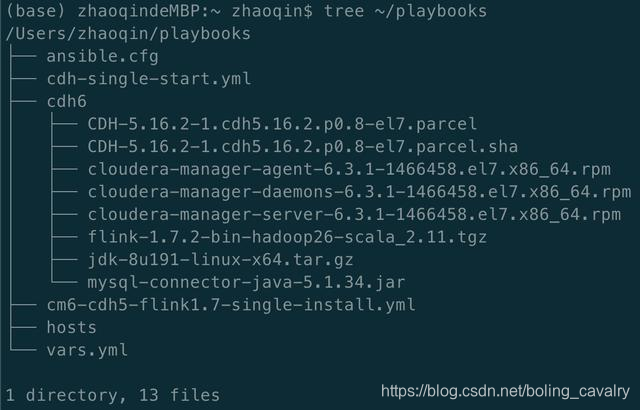

文件摆放(ansible电脑)

如果您已经下载好了上述13个文件,请按照如下位置摆放,这样才能顺利完成部署:

-

在家目录下新建名为playbooks的文件夹:mkdir ~/playbooks

-

把这五个文件放入playbooks文件夹:hosts、ansible.cfg、cm6-cdh5-flink1.7-single-install.yml、cdh-single-start.yml、vars.yml

-

在playbooks文件夹里新建名为cdh6的子文件夹;

-

把这八个文件放入cdh6文件夹(即剩余的八个):jdk-8u191-linux-x64.tar.gz、mysql-connector-java-5.1.34.jar、cloudera-manager-server-6.3.1-1466458.el7.x86_64.rpm、cloudera-manager-daemons-6.3.1-1466458.el7.x86_64.rpm、cloudera-manager-agent-6.3.1-1466458.el7.x86_64.rpm、CDH-5.16.2-1.cdh5.16.2.p0.8-el7.parcel、CDH-5.16.2-1.cdh5.16.2.p0.8-el7.parcel.sha、flink-1.7.2-bin-hadoop26-scala_2.11.tgz

-

摆放完毕后目录和文件情况如下图,再次提醒:文件夹playbooks一定要放在家目录下(即:~/):

ansible参数设置(ansible电脑)

最后如何让自己一步步成为技术专家

说句实话,如果一个打工人不想提升自己,那便没有工作的意义,毕竟大家也没有到养老的年龄。

当你的技术在一步步贴近阿里p7水平的时候,毫无疑问你的薪资肯定会涨,同时你能学到更多更深的技术,交结到更厉害的大牛。

推荐一份Java架构之路必备的学习笔记,内容相当全面!!!

成年人的世界没有容易二字,前段时间刷抖音看到一个程序员连着加班两星期到半夜2点的视频。在这个行业若想要拿高薪除了提高硬实力别无他法。

你知道吗?现在有的应届生实习薪资都已经赶超开发5年的程序员了,实习薪资26K,30K,你没有紧迫感吗?做了这么多年还不如一个应届生,真的非常尴尬!

进了这个行业就不要把没时间学习当借口,这个行业就是要不断学习,不然就只能被裁员。所以,抓紧时间投资自己,多学点技术,眼前困难,往后轻松!

【关注】+【转发】+【点赞】支持我!创作不易!

了解详情https://docs.qq.com/doc/DSmxTbFJ1cmN1R2dB

习薪资26K,30K,你没有紧迫感吗?做了这么多年还不如一个应届生,真的非常尴尬!

进了这个行业就不要把没时间学习当借口,这个行业就是要不断学习,不然就只能被裁员。所以,抓紧时间投资自己,多学点技术,眼前困难,往后轻松!

【关注】+【转发】+【点赞】支持我!创作不易!

了解详情https://docs.qq.com/doc/DSmxTbFJ1cmN1R2dB

342

342

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?