robots.txt简介

定义与作用

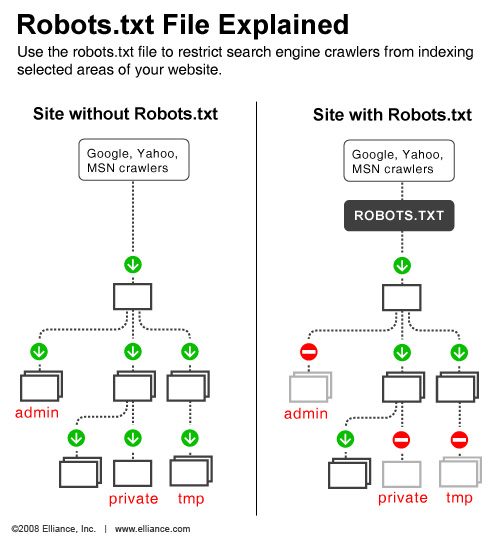

robots.txt 是一个位于网站根目录的重要文本文件,用于管理和控制网络爬虫的行为。它通过定义特定规则,指示爬虫哪些页面可以访问,哪些应被禁止抓取,从而有效保护敏感信息并优化网站性能。这个机制不仅有助于减轻Web服务器负载,还能防止未授权的页面被公开索引,为网站管理员提供了强大的工具来管理搜索引擎和其他自动化程序的访问行为。

历史背景

在互联网发展的早期阶段,随着网站数量激增,搜索引擎面临着如何高效抓取和索引网页的巨大挑战。为了平衡网站所有者的权益和搜索引擎的需求,1994年6月30日,互联网从业者们在公开邮件组中提出了 Robots协议 3。这份由搜索引擎人员和网站站长共同制定的行业规范迅速获得了广泛认可,几乎所有主流搜索引擎都采纳了这一标准,包括早期的AltaVista、InfoSeek,以及后来崛起的Google、Bing和中国本土的百度、搜狗等3。

Robots协议的核心理念体现了互联网界的道德共识:搜索技术应当服务于人类利益,同时尊重信息提供者的意愿,维护其隐私权2。这一协议的诞生标志着网站管理者开始拥有更多控制权,能够在一定程度上决定哪些内容应该被搜索引擎收录,哪些应该保持私密2。这种自主控制机制不仅提高了网站的安全性,也为搜索引擎优化(SEO)奠定了基础,成为现代互联网生态不可或缺的一部分。

robots.txt文件结构

基本语法

在探讨robots.txt文件的基本语法之前,我们需要明确其核心目的是控制搜索引擎爬虫对网站内容的访问和索引。这个看似简单的文本文件实际上包含了丰富的指令和规则,为网站管理员提供了精细的控制能力。

robots.txt文件的基本语法主要包括以下几个关键元素:

-

User-agent :指定规则适用的搜索引擎爬虫。例如:

User-agent: *这里的*表示通配符,适用于所有搜索引擎爬虫。如果要针对特定搜索引擎,可以直接写出其名称,如User-agent: Googlebot。

-

Disallow :用于禁止爬虫访问特定的URL或目录。例如:

Disallow: /private/这表示禁止访问/private/目录下的所有内容。需要注意的是,Disallow指令后必须紧跟一个斜杠(/),表示禁止访问整个目录。

-

Allow :与

Disallow相反,用于允许爬虫访问特定的URL或目录。例如:

Allow: /public/这表示允许访问/public/目录下的所有内容。然而,在实际应用中,Allow指令并不像Disallow那样常用,因为默认情况下,爬虫会被允许访问网站的大部分内容。

-

通配符和正则表达式 :为了提高灵活性,robots.txt支持使用通配符和正则表达式。例如:

Disallow: /*.pdf$这表示禁止访问所有以.pdf结尾的文件。$符号在这里表示URL的结尾。

-

注释 :为了提高可读性,可以在文件中添加注释。注释以

#符号开始,直到行末都被忽略。例如:

# 这是一条注释

Disallow: /test/ # 禁止访问/test/目录通过巧妙运用这些基本语法元素,网站管理员可以根据具体需求灵活定制robots.txt文件,实现对搜索引擎爬虫的精准控制。这种控制不仅能保护网站的隐私和安全,还能优化搜索引擎对网站内容的抓取和索引,从而提升整体的用户体验和SEO效果。

常用指令详解

在robots.txt文件中,除了常用的User-agent和Disallow指令外,还有几个值得关注的指令,它们能帮助网站管理员更精确地控制搜索引擎的抓取行为。这些指令包括:

-

Allow :与

Disallow相反,用于指定允许访问的URL或目录。例如:

User-agent: *

Disallow: /

Allow: /public/这段配置表示禁止访问网站的所有内容,但特许访问/public/目录下的页面。

-

Sitemap :用于指定网站地图文件的URL,帮助搜索引擎更快地发现和抓取网站内容。例如:

Sitemap: https://www.example.com/sitemap.xml-

Crawl-delay :指定搜索引擎爬虫访问网站的时间间隔,单位为秒。例如:

User-agent: *

Crawl-delay: 5这表示搜索引擎爬虫每次访问网站之间至少要间隔5秒,有助于减轻服务器压力。

-

Host :指定网站的主要域,用于处理多个子域的情况。例如:

Host: www.example.com这表示www.example.com是主域,其他子域如blog.example.com的robots.txt规则将遵循主域的设置。

这些指令的合理使用可以显著提高网站的SEO效果和用户体验。例如,通过结合Disallow和Allow指令,可以精确控制哪些内容应该被搜索引擎索引,哪些应该被屏蔽。同时,Sitemap指令可以帮助搜索引擎更快地发现网站的新内容,而Crawl-delay则可以在保护服务器资源的同时,确保搜索引擎有足够的机会抓取网站内容。

在实际应用中,这些指令的组合使用可以实现复杂的控制策略。例如,一个典型的robots.txt文件可能包含以下内容:

User-agent: *

Disallow: /admin/

Disallow: /temp/

Allow: /public/

Sitemap: https://www.example.com/sitemap.xml这段配置实现了以下功能:

-

禁止访问

/admin/和/temp/目录 -

允许访问

/public/目录 -

提供网站地图文件的URL

通过这种方式,网站管理员可以有效地控制搜索引擎的抓取行为,既保护了敏感信息,又优化了网站的可见性。

robots.txt配置实例

常见配置模式

在robots.txt文件的实际应用中,网站管理员常常面临各种复杂情况,需要灵活运用不同的配置模式来满足特定需求。以下是几种常见的配置模式及其应用场景:

-

全面开放模式

适用于大多数小型网站或新上线的网站,旨在最大化搜索引擎的抓取效率:

User-agent: *

Disallow:这种配置允许所有搜索引擎自由访问网站的各个角落,有助于快速建立网站在搜索引擎中的索引。

-

部分限制模式

适合有一定规模的网站,需要保护某些敏感区域:

User-agent: *

Disallow: /admin/

Disallow: /login/

Disallow: /tmp/这里禁止搜索引擎访问管理界面、登录页面和临时文件夹,既能保护网站安全,又能避免不必要的索引。

-

精细化控制模式

适用于大型电子商务网站或内容管理系统,需要对不同类型的内容进行差异化处理:

User-agent: *

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /wp-includes/

User-agent: Googlebot

Allow: /product/

Allow: /category/

User-agent: Baiduspider

Disallow: /product/

Disallow: /category/这种配置展示了如何针对不同搜索引擎设置差异化的访问规则。例如,允许Googlebot访问产品和类别页面,同时阻止Baiduspider访问同一内容。这种方法有助于优化特定搜索引擎的排名,同时保持对其他搜索引擎的控制。

-

动态内容管理

对于频繁更新的网站,可以通过以下方式控制对动态生成内容的访问:

User-agent: *

Disallow: /*?*此配置禁止搜索引擎抓取带有查询字符串的URL,有助于减少重复内容的索引问题。

-

图片和媒体文件优化

对于内容丰富的多媒体网站,可以采用以下配置来优化搜索引擎的表现:

User-agent: *

Disallow: /*.jpg$

Disallow: /*.png$

Disallow: /*.gif$

Disallow: /*.mp4$

User-agent: Googlebot

Allow: /*.jpg$

Allow: /*.png$

Allow: /*.gif$

Allow: /*.mp4$这种配置仅允许Googlebot访问图像和视频文件,有助于提高网站在Google图像搜索和视频搜索中的可见性,同时减少其他搜索引擎对这类资源的过度抓取。

通过这些多样化的配置模式,网站管理员可以根据自身需求灵活调整robots.txt文件,既保护了网站的隐私和安全,又优化了搜索引擎的抓取效率和用户体验。在实际应用中,应根据网站的具体情况进行适当调整,以达到最佳的效果。

特殊需求配置

在robots.txt文件的配置中,针对特殊需求进行个性化设置是一项重要的技能。这种针对性的配置不仅可以优化搜索引擎的抓取行为,还能有效保护网站的隐私和安全。以下是几种常见的特殊需求配置示例:

针对特定搜索引擎的差异化配置

通过为不同搜索引擎设置独特的访问规则,可以实现更精细的控制。例如:

User-agent: Googlebot

Allow: /product/

Allow: /category/

User-agent: Baiduspider

Disallow: /product/

Disallow: /category/这段配置允许Googlebot访问产品和类别页面,同时阻止Baiduspider访问同一内容。这种方法有助于优化特定搜索引擎的排名,同时保持对其他搜索引擎的控制。

控制对动态内容的访问

对于频繁更新的网站,可以采用以下配置来管理对动态生成内容的访问:

User-agent: *

Disallow: /*?*此配置禁止搜索引擎抓取带有查询字符串的URL,有助于减少重复内容的索引问题。

图片和媒体文件的优化

对于内容丰富的多媒体网站,可以采用以下配置来优化搜索引擎的表现:

User-agent: *

Disallow: /*.jpg$

Disallow: /*.png$

Disallow: /*.gif$

Disallow: /*.mp4$

User-agent: Googlebot

Allow: /*.jpg$

Allow: /*.png$

Allow: /*.gif$

Allow: /*.mp4$这种配置仅允许Googlebot访问图像和视频文件,有助于提高网站在Google图像搜索和视频搜索中的可见性,同时减少其他搜索引擎对这类资源的过度抓取。

复杂的URL匹配

在某些情况下,可能需要对特定格式的URL进行精细控制。例如,假设我们需要允许访问以".html"结尾的页面,但禁止访问其他所有页面:

User-agent: *

Disallow: /

User-agent: *

Allow: *.html$这种配置虽然看起来矛盾,但实际上实现了只允许访问以".html"结尾的页面,而禁止访问其他所有页面的效果。

通过这些特殊的配置技巧,网站管理员可以根据具体需求灵活调整robots.txt文件,实现对搜索引擎抓取行为的精准控制。这不仅能保护网站的隐私和安全,还能优化搜索引擎的抓取效率和用户体验。在实际应用中,应根据网站的具体情况进行适当调整,以达到最佳的效果。

robots.txt生成方法

手动编写

在手动创建robots.txt文件时,网站管理员可以使用多种文本编辑器,如Notepad、TextEdit、vi和emacs等。选择合适的编辑器后,按以下步骤操作:

-

创建名为robots.txt的文件

-

使用UTF-8编码保存文件

-

将文件置于网站根目录

文件内容应遵循特定格式,包括User-agent、Disallow和Allow等指令。编写时应注意避免使用可能导致问题的文字处理软件,如Microsoft Word,因其可能引入非标准字符或格式。

通过手动编写,管理员可精确控制搜索引擎爬虫的访问行为,保护敏感信息并优化网站性能。

在线工具生成

在手动编写robots.txt文件可能存在困难的情况下,在线生成工具成为了许多网站管理员的首选解决方案。这些工具不仅简化了创建过程,还提供了额外的功能,如实时验证和预览。以下是几个值得推荐的在线生成工具:

| 工具名称 | 特点 |

|---|---|

| W3Cschool在线robots.txt生成器 | 提供多种常见设置选项,可根据具体需求生成符合robots协议的文件 |

| 站长之家robots检测工具 | 支持实时验证和预览功能 |

使用这些工具时,只需按照界面提示选择所需选项,即可快速生成符合要求的robots.txt文件。这种方法特别适合那些对技术细节不太熟悉的用户,能够有效降低出错率,同时提高工作效率。

robots.txt使用注意事项

常见误区

在使用robots.txt文件时,网站管理员常常陷入一些误区,这些误解可能导致意外后果,甚至危及网站安全。以下是几个最常见的陷阱:

-

过度信任robots.txt的保护能力

许多网站管理员错误地认为,只要在robots.txt文件中禁止访问某些目录或文件,就能完全阻止搜索引擎或其他自动化工具的访问。然而,这种想法存在严重缺陷:

-

robots.txt文件本身是公开的,任何人都可以访问

-

恶意爬虫或黑客可能故意无视robots.txt规定

-

正规搜索引擎也可能因技术原因未能正确解析复杂规则

这意味着敏感信息仍然可能被不当访问或泄露。因此,不应将robots.txt作为唯一的防护手段,而是应与其他安全措施(如密码保护、防火墙等)结合使用。

-

Allow指令的误用

在尝试使用Allow指令时,管理员常犯的一个错误是将其置于Disallow指令之前。这种顺序会导致意想不到的结果:

User-agent: *

Allow: /public/

Disallow: /private/在这种配置下,搜索引擎可能会忽略Disallow指令,因为它在Allow指令之后出现。正确的做法是将Disallow指令放在Allow指令之前:

User-agent: *

Disallow: /private/

Allow: /public/-

通配符使用的不当

虽然通配符(如*和$)能提高配置灵活性,但也易引发问题。例如:

Disallow: /*.php$这条规则意图禁止访问所有.php文件,但实际效果可能超出预期,连同子目录下的.php文件也被禁止。正确做法是:

Disallow: /.php$-

忽视大小写敏感性

某些服务器和操作系统对文件名和目录名的大小写敏感。因此,在编写robots.txt时,需格外注意大小写一致性:

Disallow: /Images/这条规则可能无法正确匹配实际存在的/images/目录。为确保兼容性,建议统一使用小写字母。

通过避免这些常见误区,网站管理员可以更好地利用robots.txt文件的优势,同时最大限度地降低潜在风险。在实施任何重大更改前,建议先进行充分测试,并定期审查robots.txt文件的有效性,以确保其始终符合网站的安全和SEO目标。

最佳实践

在robots.txt文件的最佳实践中,网站管理员需要采取一系列策略来优化搜索引擎的抓取行为,同时保护网站的隐私和安全。以下是一些关键的优化建议和安全措施:

-

定期审核和更新

robots.txt文件不是一次设置就万事大吉的。随着网站的发展和业务需求的变化,文件中的规则也需要相应调整。建议每季度至少进行一次全面审核,检查是否有新的敏感内容需要保护,或者是否可以放宽某些限制以提高SEO效果。

-

使用通配符和正则表达式

通配符和正则表达式的灵活运用可以大大简化ruleset,使其更加简洁高效。例如:

Disallow: /*.pdf$

Disallow: /*.docx$这样可以一次性禁止所有.pdf和.docx文件的抓取,而不必逐个列出每个文件。

-

谨慎使用全局禁止

虽然Disallow: /可以快速禁止所有内容的抓取,但这通常是不明智的做法。更好的方法是保留默认的允许访问状态,只对特定内容进行禁止。这样可以确保不会意外封锁重要的网页。

-

利用Sitemap指令

在robots.txt文件中加入Sitemap指令可以帮助搜索引擎更快地发现和抓取网站内容:

Sitemap: https://www.example.com/sitemap.xml这不仅提高了抓取效率,还能确保搜索引擎优先关注最重要的页面。

-

测试和监控

在正式部署新的robots.txt文件之前,务必进行全面测试。可以使用Google Search Console等工具来验证文件的有效性。部署后也要持续监控,观察搜索引擎索引的变化,及时发现问题并做出调整。

-

备份原始文件

在修改robots.txt文件时,最好先备份原始文件。这样万一出现错误,可以快速恢复到先前的工作状态,避免造成不可挽回的损失。

-

考虑移动设备优化

随着移动互联网的普及,越来越多的用户通过智能手机和平板电脑访问网站。在配置robots.txt文件时,应考虑到这一点,确保移动版网站的内容也能被正确抓取和索引。

-

国际化网站的处理

对于面向全球用户的多语言网站,可以在robots.txt文件中为不同语言版本的网站设置专门的规则。例如:

User-agent: *

Disallow: /en/

Disallow: /fr/

Disallow: /es/

User-agent: Googlebot

Allow: /en/

Allow: /fr/

Allow: /es/这样可以确保主要搜索引擎能够正确索引各语言版本的内容,同时避免重复内容的问题。

通过遵循这些最佳实践,网站管理员可以充分利用robots.txt文件的强大功能,既保护网站的隐私和安全,又优化搜索引擎的抓取效率,从而提升整体的SEO效果和用户体验。

1456

1456

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?