MatMul-Free LLM:重新定义大型语言模型的计算范式

在人工智能和自然语言处理领域,大型语言模型(LLMs)一直是研究和应用的热点。然而,随着模型规模的不断扩大,其计算成本也呈指数级增长,这给模型的训练和部署带来了巨大挑战。近期,一项名为MatMul-Free LLM的创新技术引起了学术界和产业界的广泛关注,它通过消除传统LLMs中最耗费计算资源的矩阵乘法(MatMul)操作,为大型语言模型的发展开辟了一条全新的道路。

MatMul-Free LLM的核心理念

MatMul-Free LLM的核心思想是用更简单、更高效的运算来替代传统LLMs中的矩阵乘法操作。这种方法不仅大幅降低了计算复杂度,还保持了模型的性能水平。根据GitHub上的MatMul-Free LLM项目介绍,该技术与🤗 Transformers库兼容,这意味着它可以无缝集成到现有的深度学习框架中。

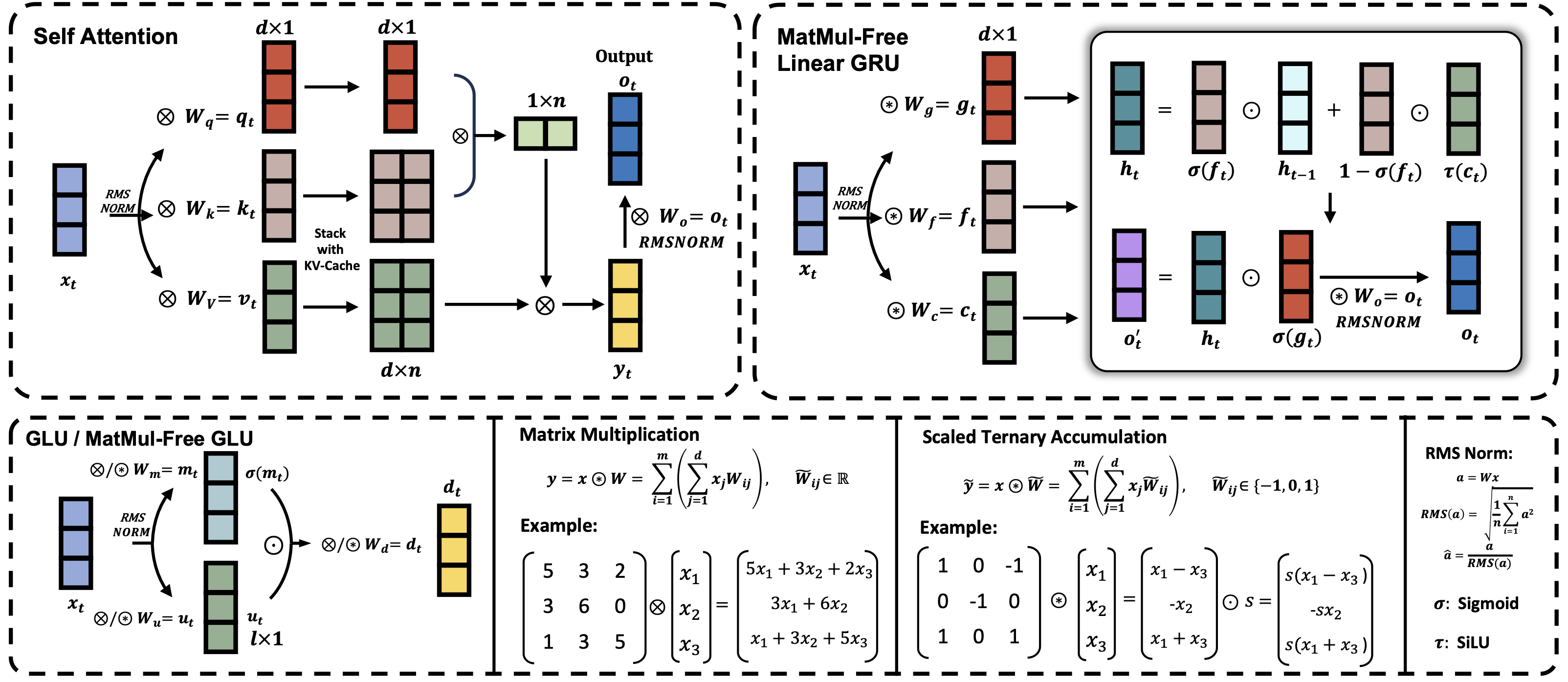

上图展示了MatMul-Free LLM的基本架构,它通过创新的设计消除了传统LLMs中的矩阵乘法操作,从而实现了

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?