DeepSpeech:开源嵌入式语音识别引擎

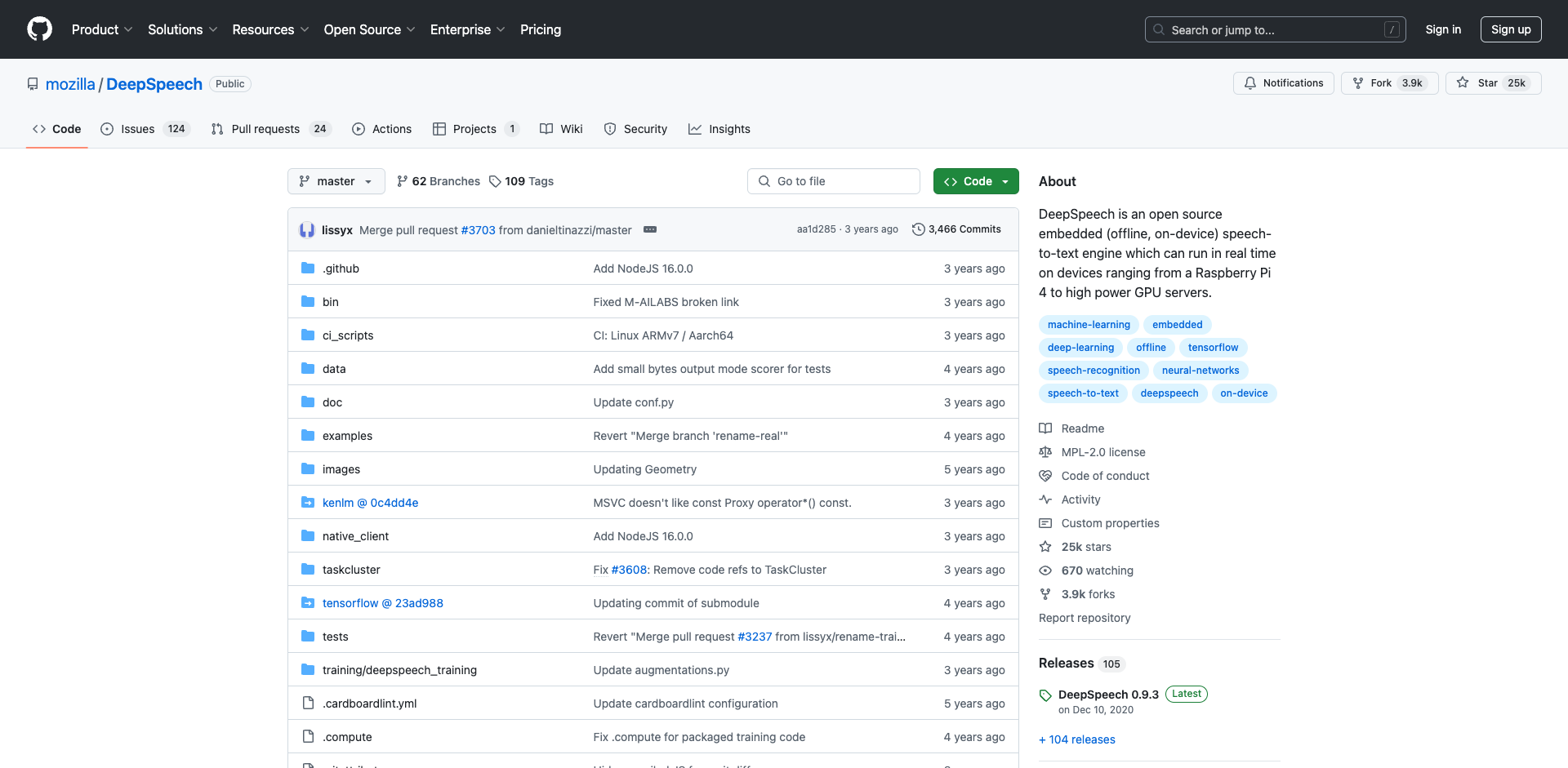

DeepSpeech是一个由Mozilla开发的开源语音识别引擎,它可以在各种设备上实现离线、实时的语音转文本功能。无论是树莓派这样的嵌入式设备,还是高性能的GPU服务器,DeepSpeech都能很好地运行。本文将全面介绍DeepSpeech项目的背景、特点、应用场景及使用方法。

DeepSpeech的诞生背景

DeepSpeech项目最初是基于百度2014年发表的研究论文《Deep Speech: Scaling up end-to-end speech recognition》而开发的。该论文提出了一种全新的端到端语音识别方法,使用深度学习技术直接从原始音频数据学习转录文本,无需传统语音识别中的音素等中间表示。

Mozilla看到了这种方法的潜力,决定基于TensorFlow框架实现一个开源版本,以推动语音识别技术的发展和应用。经过多年的开发和优化,DeepSpeech已经成为一个功能强大、性能优异的语音识别引擎。

DeepSpeech的主要特点

DeepSpeech具有以下几个突出特点:

-

开源免费:DeepSpeech采用MPL 2.0开源协议,任何人都可以自由使用、修改和分发。

-

嵌入式设计:DeepSpeech可以在资源受限的嵌入式设备上运行,支持离线语音识别。

-

实时性能:通过优化算法和模型,DeepSpeech可以实现实时的语音转文本。

-

多平台支持:提供Python、C++、Java、JavaScript等多种编程语言的API。

-

可定制性强:用户可以使用自己的数据集训练定制化模型。<

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2688

2688

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?