二、ai数据安全

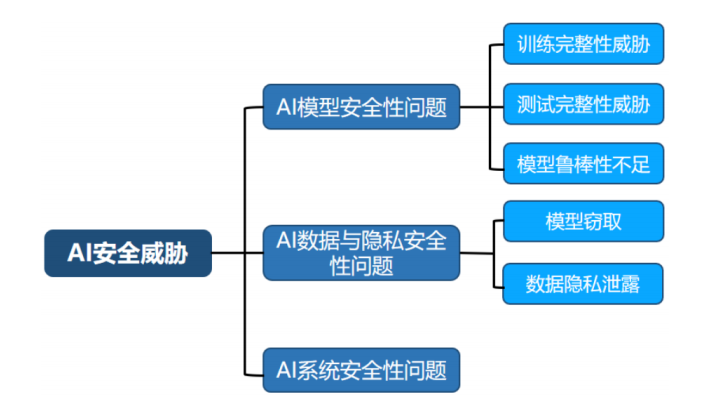

数据安全问题是指 AI 技术所使用的训练、测试数据和模型参数数据被攻击者窃取。针对 AI 技术使用的数据,攻击者可以通过 AI 模型构建和使用过程中产生的信息在一定程度上窃取 AI 模型的数据,主要通过两种方式来进行攻击:

1)基于模型的输出结果,模型的输出结果隐含着训练/测试数据的相关属性。

2)基于模型训练产生的梯度(参数),该问题主要存在于模型的分布式训练中,多个模型训练方之间交换的模型参数的梯度也可被用于窃取训练数据。

三、ai系统安全

承载 AI 技术的应用系统主要包括 AI 技术使用的基础**物理设备和软件架构(pytorch等),**是 AI 模型中数据收集存储、执行算法、上线运行等所有功能的基础。

对抗样本攻击

研究者还发现在输入数据上添加少量精心构造的人类无法识别的**“扰动”,可以使 AI 模型输出错误的预测结果。这种添加扰动的输入数据通常被称为对抗样本(Adversarial Example)**。在许多安全相关的应用场景中,对抗样本攻击会引起严重的安全隐患。属于ai模型安全。

以自动驾驶为例,攻击者可以在路牌上粘贴对抗样本扰动图案,使得自动驾驶系统错误地将“停止”路牌识别为“限速”路牌 。这类攻击可以成功地欺骗特斯拉等

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

828

828

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?