一、为什么评估比训练更复杂?

大型语言模型(LLM)的评估面临三重挑战:

✅ 能力维度多:语言理解、逻辑推理、领域知识等需分别验证

✅ 评估成本高:人工评测耗时,自动化指标易失准

✅ 动态变化快:模型迭代后需重新建立评估基线

二、核心评估框架设计(4层金字塔)

1. 基础能力评估

-

评测指标:Perplexity、BLEU、ROUGE

-

典型任务:Cloze Test、文本续写、语义相似度计算

-

工具推荐:OpenAI Evals、HELM Benchmark

2. 任务性能评估

-

分类任务:准确率/F1值(GLUE/SuperGLUE)

-

生成任务:BLEU-4、METEOR、人工打分

-

检索任务:Recall@k、MRR(MS MARCO)

3. 生成质量评估

-

流畅度:语法正确性、文本连贯性

-

事实性:FactScore指标(验证知识准确性)

-

安全性:毒性检测(Detoxify)、偏见分析(HONEST)

4. 系统工程评估

-

推理成本:Tokens/美元,QPS

-

服务稳定性:容错率、降级机制

-

扩展能力:微调API响应速度,模型热更新耗时

三、工程实践中的避坑指南

▶ 评估方案设计原则

-

分阶段验证:单元测试→集成测试→端到端测试

-

数据分层:构建10%核心测试集+90%自动生成集

-

动态基线:建立版本对比机制(如v1.2 vs v1.3提升度)

▶ 高效评估工具链

python

# 自动化评估示例(HuggingFace集成)

from evaluate import load

bertscore = load("bertscore")

results = bertscore.compute(

predictions=generated_texts,

references=gold_texts,

lang="zh"

)▶ 典型问题解决方案

-

幻觉问题:RAG增强+FactScore双重验证

-

长尾失效:构建对抗测试集(Adversarial Examples)

-

数据污染:使用N-gram重叠检测(Nucleus Detection)

四、前沿评估体系演进

-

多模态评估:图文一致性(CLIPScore)、视频描述准确性

-

自我进化评估:模型自主生成测试用例(Self-Instruct)

-

价值观对齐:宪法AI(Constitutional AI)评估框架

五、关键工具推荐

| 工具类型 | 推荐方案 | 适用场景 |

|---|---|---|

| 自动化评估 | LangChain Evaluators | RAG系统验证 |

| 人工评估平台 | Scale AI | 标注质量管控 |

| 可视化分析 | Weights & Biases | 训练/评估对比 |

| 安全检测 | NVIDIA NeMo Guardrails | 内容过滤 |

实践建议:评估应贯穿模型全生命周期,建议建立评估看板实时监控模型表现,结合A/B测试持续优化

最后

今天贴心为大家准备好了一系列AI大模型资源,包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

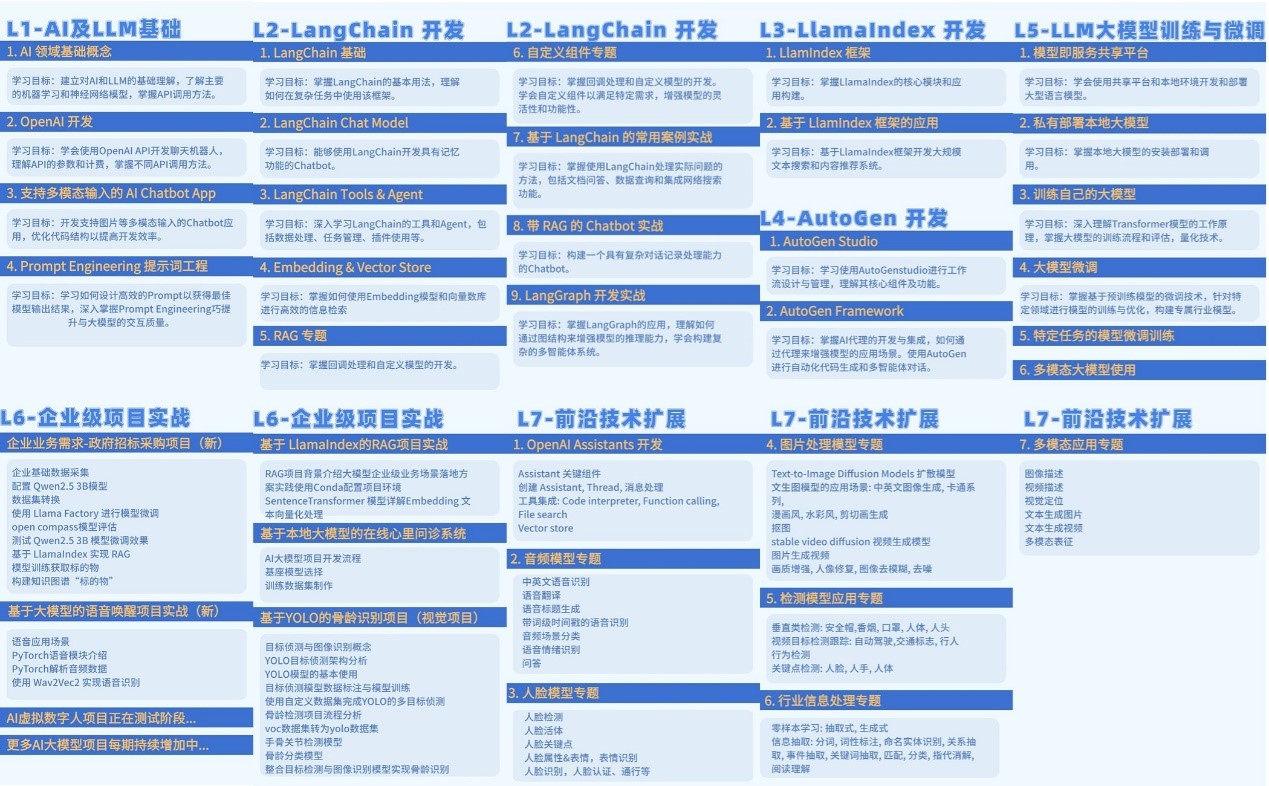

1.学习路线图

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?