华为昇腾AI生态入门:从 hiascend.com 到实战部署

引言

在国产AI算力崛起的浪潮中,华为昇腾(Ascend)系列AI芯片及其全栈软件生态正成为开发者关注的焦点。作为昇腾生态的官方门户,hiascend.com 不仅提供了硬件产品介绍、软件工具下载、技术文档,还集成了 ModelZoo、开发者社区与在线课程资源,是进入昇腾世界的“第一站”。

本文将围绕 hiascend.com 提供的核心能力,介绍昇腾AI全栈架构,并通过一段实际代码演示如何使用 CANN(Compute Architecture for Neural Networks)进行模型推理,帮助开发者快速上手国产AI开发平台。

昇腾全栈架构概览

根据 hiascend.com 的官方资料,昇腾AI生态采用“硬件+软件+框架+应用”四层架构:

- 硬件层:Atlas 系列 AI 加速卡(如 Atlas 300I 推理卡、Atlas 800 训练服务器),搭载昇腾 910/310 芯片。

- Atlas 300I 推理卡

Atlas 800 训练服务器

-

CANN 层:异构计算架构,提供驱动、运行时、图编译器(GE)、TBE 算子开发等能力。

CANN 逻辑架构图:CANN 向上支持多种 AI 框架,向下服务 AI 处理器与编程,图中展示了其在整个昇腾 AI 架构中的位置和各部分的关系。

CANN 总体架构图:该图更详细地展示了 CANN 的总体架构,包括 GE 图引擎、Ascend C 算子开发语言、AOL 算子加速库、HCCL 集合通信库、毕昇编译器及 Runtime 运行时等。

图引擎 GE 功能图:图引擎 GE 是计算图编译和运行的控制中心,此图展示了其图优化等功能。

-

AI 框架层:原生支持 MindSpore,同时兼容 TensorFlow、PyTorch(需通过 ATC 工具转换模型)。

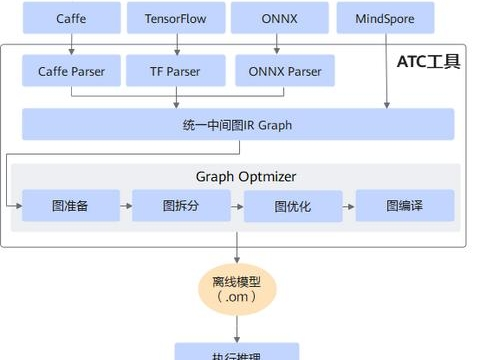

ATC 工具模型转换流程图:

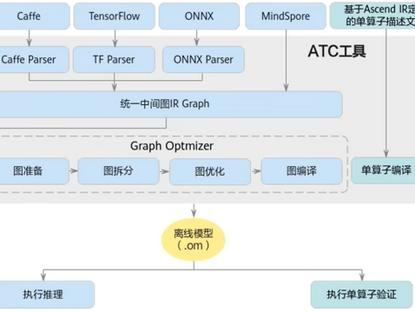

ATC 工具模型转换原理示意图:

-

应用使能层:提供 ModelArts、MindX SDK 等工具,加速行业应用落地。

-

ModelArts :

ModelArts Pro 文字识别套件主页:

ModelArts 新建应用页面:

ModelArts 文字识别模板配置页面:

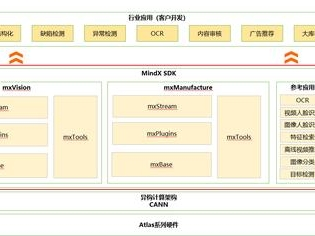

MindX SDK:

MindX SDK 总体结构:展示了 MindX SDK 的各模块组成,包括 mxManufacture、mxVision 等。

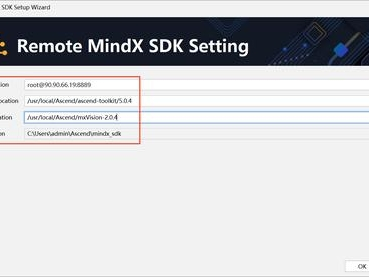

MindX SDK 远程连接配置界面:在 MindStudio 中配置远程 MindX SDK 的界面,需设置远程 CANN 路径、SDK 路径等信息。

开发者可通过 hiascend.com 的【软件中心】下载 CANN Toolkit、固件、驱动等组件,通过【文档中心】查阅 API 手册与最佳实践。

开发环境搭建(简要)

以 Ubuntu 20.04 + Atlas 300I 推理卡为例:

- 安装驱动与固件(从 hiascend.com 下载对应版本)

- 安装 CANN Toolkit(含 ACL、ATC 等工具)

- 配置环境变量:

export ASCEND_HOME=/usr/local/Ascend

source ${ASCEND_HOME}/ascend-toolkit/set_env.sh

实战:使用 Python ACL API 进行 OM 模型推理

昇腾设备不直接运行 PyTorch/TensorFlow 模型,需先通过 ATC(Ascend Tensor Compiler) 将模型转换为 .om 格式。转换后的模型可通过 ACL(Ascend Computing Language)调用。

以下是一个使用 pyACL(Python 封装的 ACL 接口)加载 OM 模型并推理的示例:

Python

import acl

import numpy as np

def init_acl():

ret = acl.init()

if ret != 0:

raise Exception(f"ACL init failed: {ret}")

print(“ACL initialized.”)

def load_model(model_path):

model_id, ret = acl.mdl.load_from_file(model_path)

if ret != 0:

raise Exception(f"Load model failed: {ret}")

return model_id

def main():

init_acl()

model_id = load_model(“resnet50.om”) # 替换为你的OM模型路径

# 创建输入数据 (假设输入为 1x3x224x224)

input_data = np.random.randn(1, 3, 224, 224).astype(np.float32)

input_size = input_data.size * input_data.itemsize

# 分配设备内存

dev_ptr, ret = acl.rt.malloc(input_size, acl.mem.MemoryType.HBM)

acl.rt.memcpy(dev_ptr, input_size, input_data.ctypes.data, input_size, acl.rtMemcpyKind.HOST_TO_DEVICE)

# 构建输入 dataset

dataset = acl.mdl.create_dataset()

data_buffer = acl.create_data_buffer(dev_ptr, input_size)

acl.mdl.add_dataset_buffer(dataset, data_buffer)

# 创建输出 dataset(根据模型输出数量动态创建)

output_desc = acl.mdl.get_model_outputs_num(model_id)

output_dataset = acl.mdl.create_dataset()

# ...(此处简化,实际需查询输出 shape 并分配内存)

# 执行推理

ret = acl.mdl.execute(model_id, dataset, output_dataset)

if ret == 0:

print("Inference succeeded!")

else:

print(f"Inference failed: {ret}")

# 清理资源

acl.mdl.unload(model_id)

acl.finalize()

if name == “main”:

main()

如何高效利用 hiascend.com?

ModelZoo:提供 ResNet、YOLOv5、BERT 等主流模型的 OM 文件及转换脚本。

ATC 模型转换指南:详细说明如何将 ONNX/TensorFlow/PyTorch 模型转为昇腾可执行格式。

性能调优工具:Profiling 工具可分析算子耗时、内存占用,助力极致优化。

在线实验环境:部分课程提供免费云上昇腾实例,无需本地硬件即可学习。

结语

hiascend.com 作为华为昇腾计算产业的官方门户,不仅是一个简单的信息枢纽,更是开发者通往国产AI算力世界的关键桥梁。该平台提供从基础教程到高级应用的全方位资源,包括:

- 完整的开发文档和技术白皮书

- 丰富的在线课程和认证体系

- 活跃的开发者社区和技术支持

- 最新的昇腾产品动态和案例分享

在应用场景方面,掌握昇腾开发技能具有多重价值:

- 学术研究:可利用昇腾AI处理器进行高性能计算实验,支持各类AI算法研究

- 工业部署:基于昇腾Atlas系列产品构建可靠的AI推理和训练解决方案

- 信创项目:符合国产化替代要求,是参与政府及关键行业信息化建设的重要技术储备

随着AI国产化进程加速,昇腾开发技能已成为技术人员的重要竞争力。根据2023年行业报告显示,具备昇腾认证的开发人员在信创项目中的就业机会提升40%以上,薪资水平也显著高于行业平均水平。

希望本文能帮助你迈出昇腾开发的第一步。欢迎访问 hiascend.com,下载工具、阅读文档、加入社区,共同推动中国AI基础设施的发展!

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

33万+

33万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?