/*square1.cpp*/

/*未经优化的矩阵乘法程序*/

#include

using namespace std;

#define N 1000

int a[N][N] = {0}, b[N][N] = {0}, c[N][N] = {0};

int main() {

int i, j, k;

for (i = 0; i < N; i++) {

for (j = 0; j < N; j++) {

a[i][j] = i+j;

b[i][j] = i+j;

}

}

for (i = 0; i < N; i++) {

for (j = 0; j < N; j++) {

for (k = 0; k < N; k++) {

c[i][j] += a[i][k] * b[k][j];

}

}

}

}

/*square2.cpp*/

/*优化过的矩阵乘法程序*/

#include

using namespace std;

#define N 1000

int a[N][N] = {0}, b[N][N] = {0}, c[N][N] = {0};

int main() {

int i, j, k;

for (i = 0; i < N; i++) {

for (j = 0; j < N; j++) {

a[i][j] = i+j;

b[i][j] = i+j;

}

}

for (i = 0; i < N; i++) {

for (k = 0; k < N; k++) {

for (j = 0; j < N; j++) {

c[i][j] += a[i][k] * b[k][j];

}

}

}

}

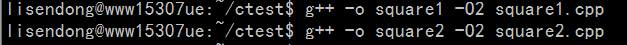

两段程序的唯一差别,就是把 三层循环中的 j 循环 和k 循环的顺序交换了一下。

square1.cpp中因为第三层循环(最内层循环)是对k进行循环,因此b[k][j]是对b逐列进行访问。我们知道内存中二维数组是以行为单位连续存储的,逐列访问将会每次跳1000*4(bytes)。根据cpu cache的替换策略,将会有大量的cache失效。

因此square2.cpp将j循环和k循环交换位置,这样就保证了

c[i][j] += a[i][k] * b[k][j];

这条语句对内存的访问是连续的,增加了cache的命中率,大大提升了程序执行速度。

我们来看一下实测效果:(测试环境:64位双核2.4GHz cpu)

执行时间测试:

时间居然会相差近10倍。 可见利用好cpu cache优化我们的程序,是非常有必要掌握的技能。

平时写程序时,也应当尽量使cpu对内存的访问,是尽可能连续的。

2447

2447

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?