编辑&整理:深度学习自然语言处理 公众号

近期,大规模语言模型在多个自然语言处理的基准测试中取得了显著的进展。这些模型之所以能够取得成功,部分原因在于它们通过对互联网上收集的庞大语料库进行广泛的预训练。然而,预训练语料库可能因为开发者有意或无意的数据收集行为,包含了各种评估基准的数据。这种数据泄露可能导致无法准确评估模型的真实性能,模型可能仅仅是记住了难题的答案。研究发现,当一个大型语言模型的预训练数据中包含了某个数据集的内容时,它在该数据集上的表现会有所提升,但在其他不相关任务上的性能却可能下降,这最终可能导致对模型性能的评估变得不准确。

中国科学院深圳先进技术研究院和中国科学技术大学的研究人员提出了一种简单而有效的数据泄露检测方法,该方法基于选择题选项内容可交换的特点,通过打乱原始数据中选项的顺序生成一组衍生数据,然后利用大模型的计算衍生数据集的对数概率分布来检测原始数据集是否泄露。该方法能够在不访问模型的训练数据或权重的情况下,识别语言模型预训练数据中基准测试集的存在以及数据泄露的程度。这种方法有助于确保评估模型性能时的准确性和可靠性。

Paper: https://arxiv.org/abs/2409.01790

Code: https://github.com/nishiwen1214/Benchmark-leakage-detection

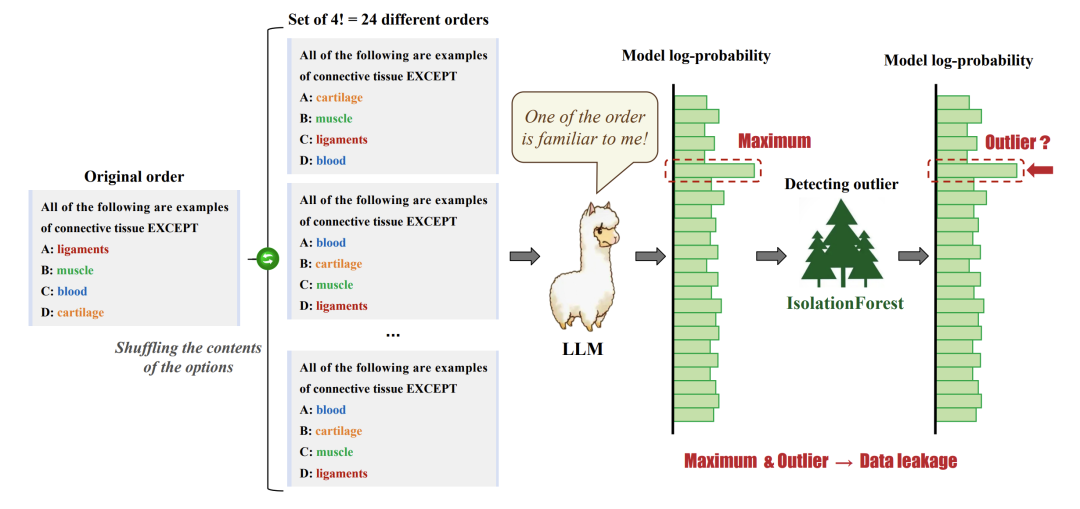

一些当前主流的基准测试(例如,MMLU、CMMLU、C-Eval、E-Eval、CMB)都是以选择题的形式构建的。理论上,通过改变原始数据选项内容的顺序,模型预测该数据的对数概率可能会变高或变低,但波动不会很大。例如,如果模型没有在该条数据的任何顺序上进行过训练,那么“以下所有项都是结缔组织的示例,除了A:韧带B:肌肉C:血液D:软骨”和“以下所有项都是结缔组织的示例,除了A:软骨B:血液C:肌肉D:韧带”的对数概率不会有太大差异,因为选项内容之间不存在顺序依赖关系。

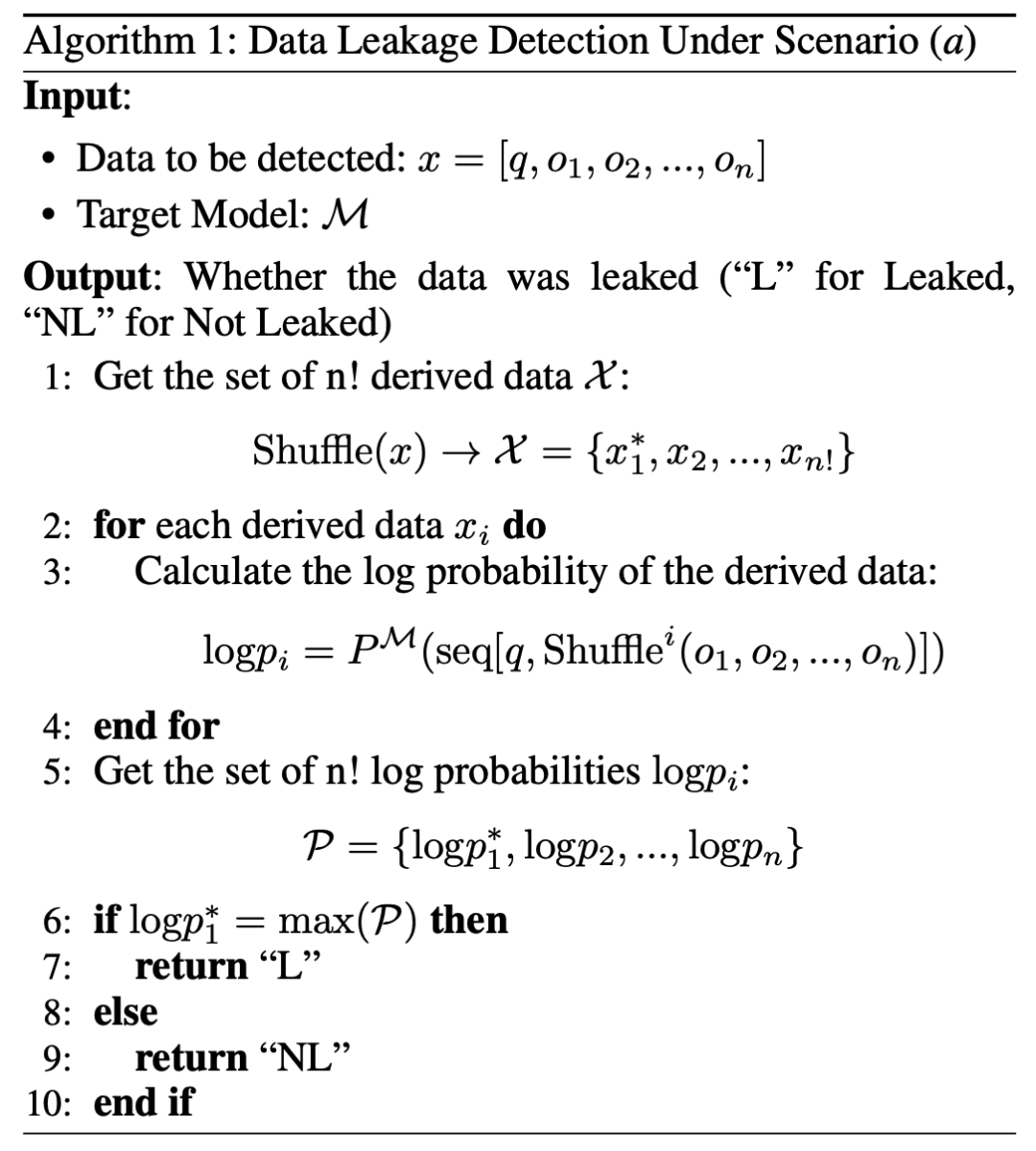

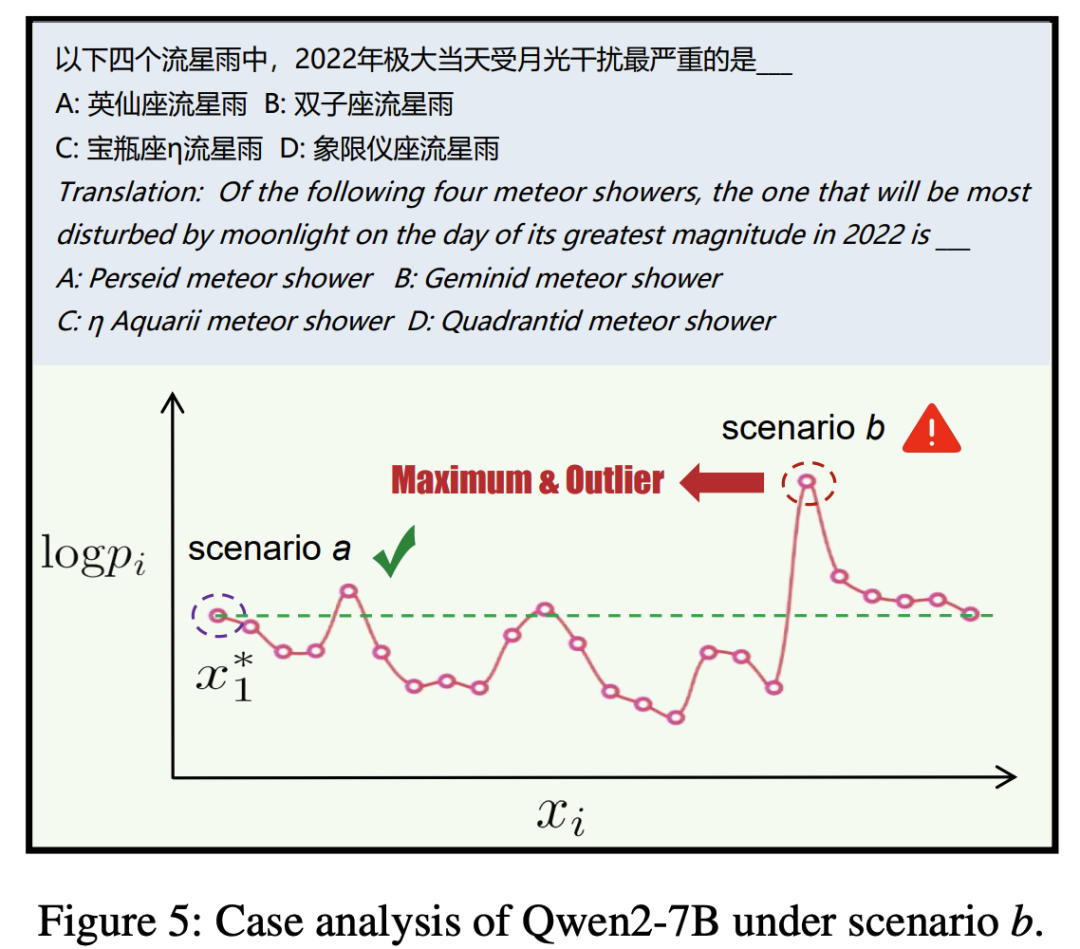

如图所示,包含四个选项的数据可以在打乱选项内容后组成24种不同的衍生数据。如果不知道预训练数据中选项的顺序(打乱的选项顺序可能在基准构建过程中或预训练数据构建过程中被假设,如果24个对数概率高低不一,而没有明显的离群最大值,那么就不存在数据泄露;如果存在一个显著的对数概率最大的异常值,那么就说明存在数据泄露。通过这种检测方法,也可以检测到人为和故意打乱选项顺序的情况,如果不考虑选项打乱,只需要原始顺序数据的对数概率是24个中的最大值就可以确定(理论上的概率是1/24)。因此,该论文考虑了两种情况:

-

预训练数据选项的顺序没有被打乱

-

预训练数据选项的顺序被打乱过。

论文使用了LLaMA2-7b-base模型作为预训练模型,从MMLU中随机抽取了1000条数据,其中500条用于持续预训练,随后利用这1000条数据进行测试,以检测哪些数据在训练过程中被使用过。同样,论文也采用了CMMLU数据来对Qwen2-7b-base模型进行测试。论文的实验考虑了两种情况:

-

预训练数据中的选项顺序保持不变

-

预训练数据中的选项顺序可能被扰乱

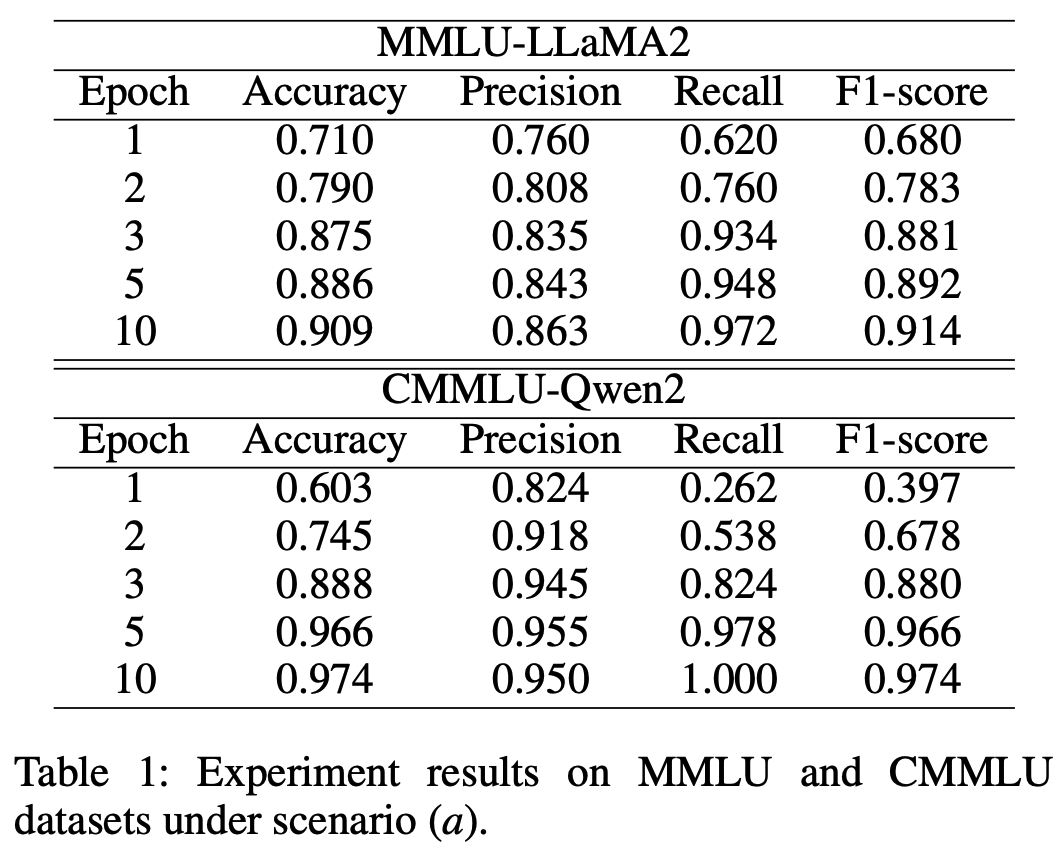

场景(a)的实验结果显示在表1中。在场景(a)中,如果一段数据的其他23个变体的对数概率都低于原始数据的对数概率,就预测该数据发生了泄露。经过10次训练,LLaMA2-7B模型在检测准确率和F1分数上都超过了90%。即便只是进行一次预训练,我们的检测方法也能实现71%的准确率。

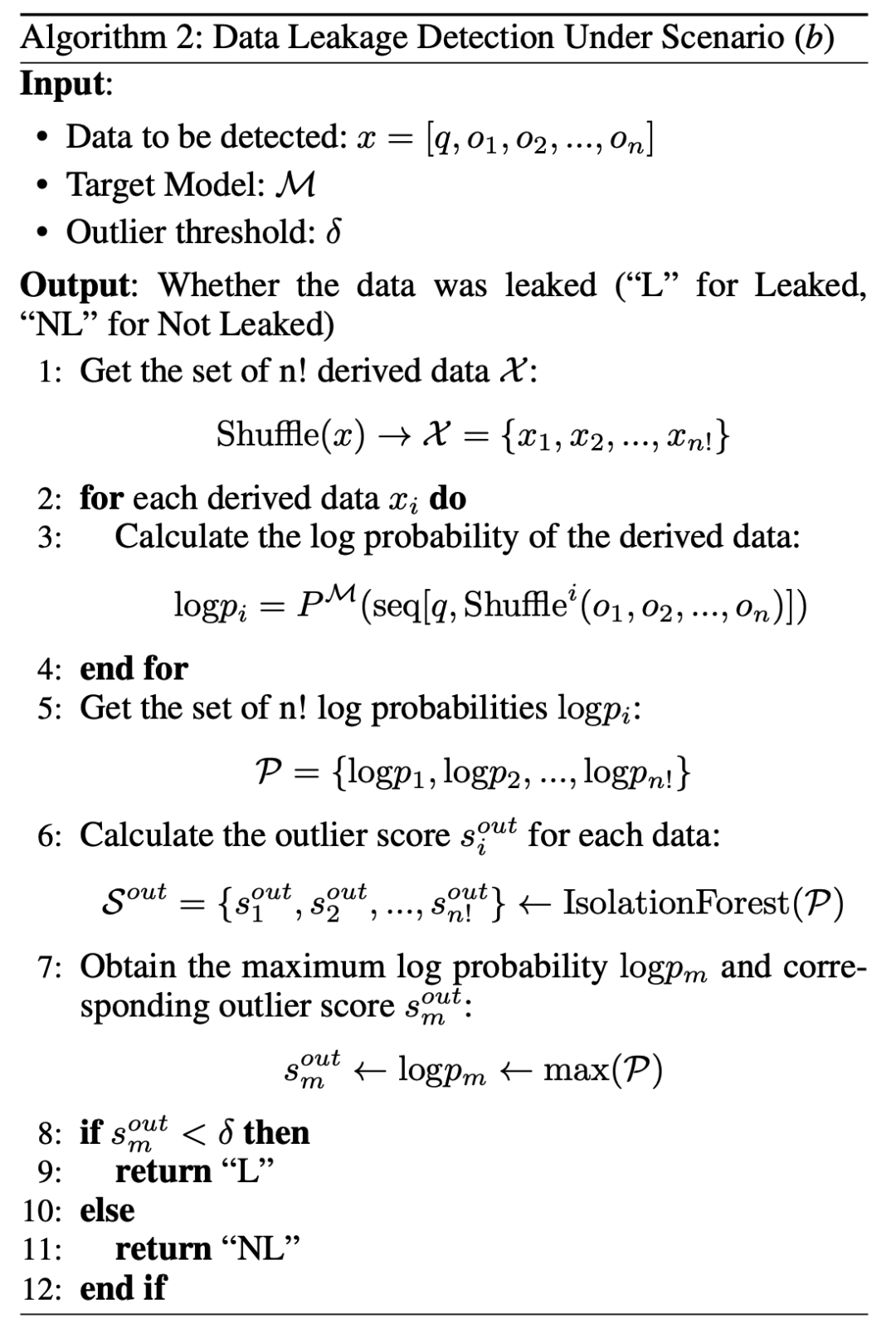

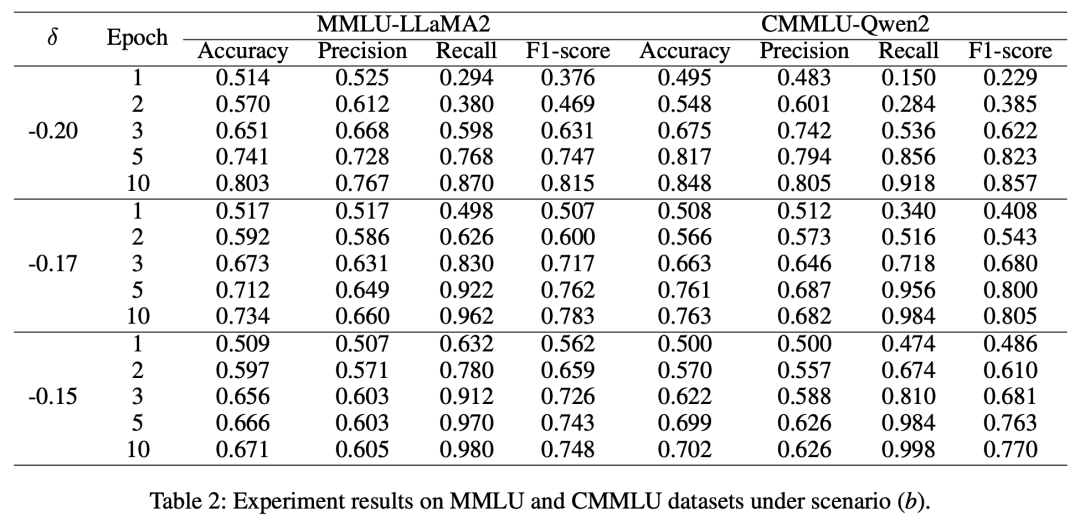

场景(b)的实验结果展示在表2中。研究人员选取了-0.2、0.17和-0.15作为检测离群点的阈值。场景(b)极具挑战性,但即便数据只经过一次预训练,检测方法仍能达到大约50%的准确率。总的来说,该数据泄露检测方法在场景(a)中表现出色,在较为困难的场景(b)中表现尚可。

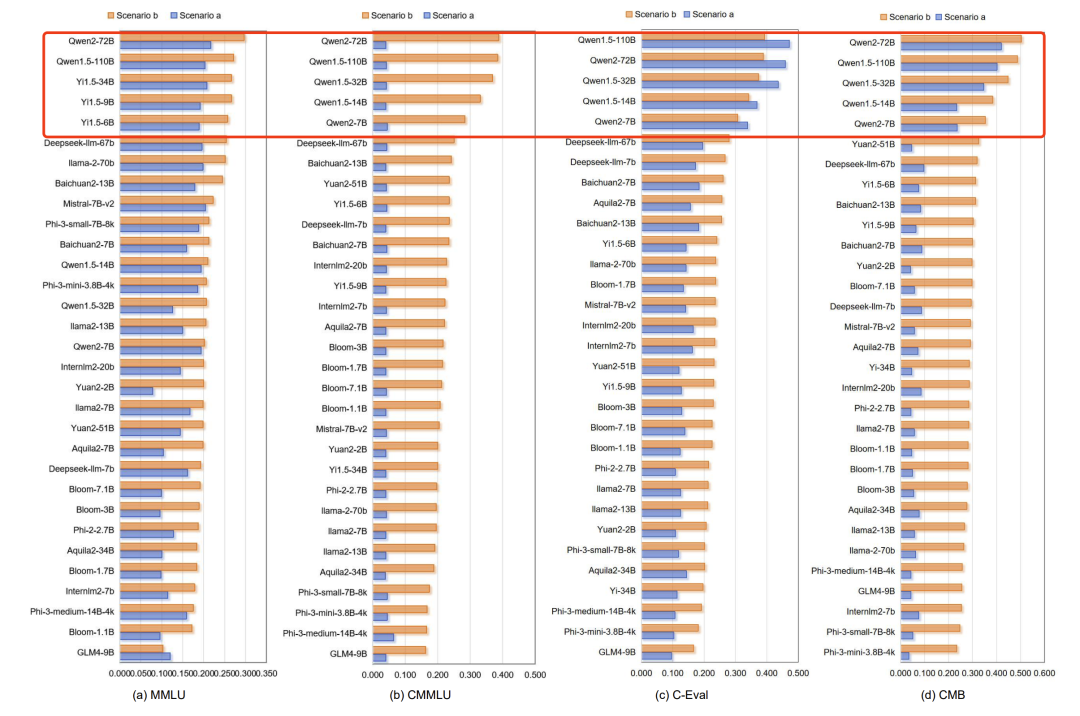

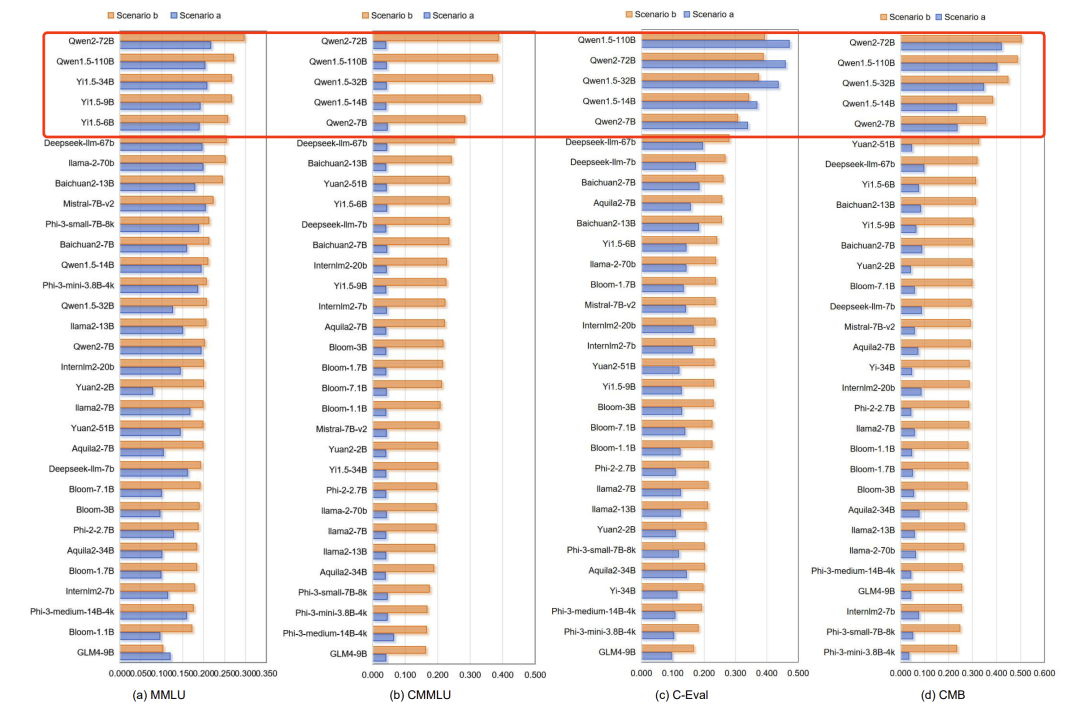

论文对四个主流基准(MMLU、CMMLU、C-Eval、CMB)进行了全面的数据泄漏检测实验。在MMLU基准上,模型之间没有太大差距,数据泄露风险排名前五的模型是Qwen2-72B、Qwen1.5-110B、Yi-34B、Yi1.5-9B和Yi1.5-6B。总体而言,MMLU基准上的LLMs泄露是一个严重的问题,由于MMLU是英语领域中最常用和广泛使用的基准之一,这个问题值得我们关注。在CMMLU基准上,场景a显示的泄露指标都非常低,基本上只有0.04,这基本上符合正常情况1/24=0.042的预期。然后我们发现,在使用算法2检测后,场景b下检测到的数据泄露指标都显著更高,尤其是Qwen家族,排名最高。我们假设CMMLU基准在收集原始数据后可能对选项进行了洗牌,或者LLM的开发人员在预训练数据的洗牌操作中进行了洗牌。在与CMMLU类似的中文综合基准C-Eval上,建模的数据泄露风险排名前五的也都是Qwen1.5-110B、Qwen2-72B、Qwen1.5-32B、Qwen1.5-14B和Qwen2-7B。在中药基准CMB上,数据泄露风险排名前五的LLMs仍然是Qwen2-72B、Qwen1.5-110B、Qwen1.5-32B、Qwen1.5-14B和Qwen2-7B。特别是,Qwen家族的LLMs在数据泄露值上远远领先于其他模型,算法1的得分远高于其他模型。在数据泄露值方面,Qwen家族的LLMs几乎是其他LLMs的十倍。算法1检测到Qwen2-72B在CMB基准的测试数据中有42%被泄露。总体而言,GLM4-9B在所有三个基准MMLU、CMMLU和C-Eval上的数据泄露风险最低,在CMB上的数据泄露风险较低。Qwen家族的LLMs在所有四个基准上都有非常高的泄露风险,我们发现模型越大,泄露指数越高,这可能是因为较大的模型拥有更多的预训练数据,并且更能够牢固地学习和记忆数据。除了Qwen家族的LLMs,Yi家族、DeepSeek家族和Baichuan家族的LLMs也存在轻微的基准泄露风险。轻微的基准泄露很难避免,但我们希望研究人员在开发LLMs时避免严重的基准泄露。

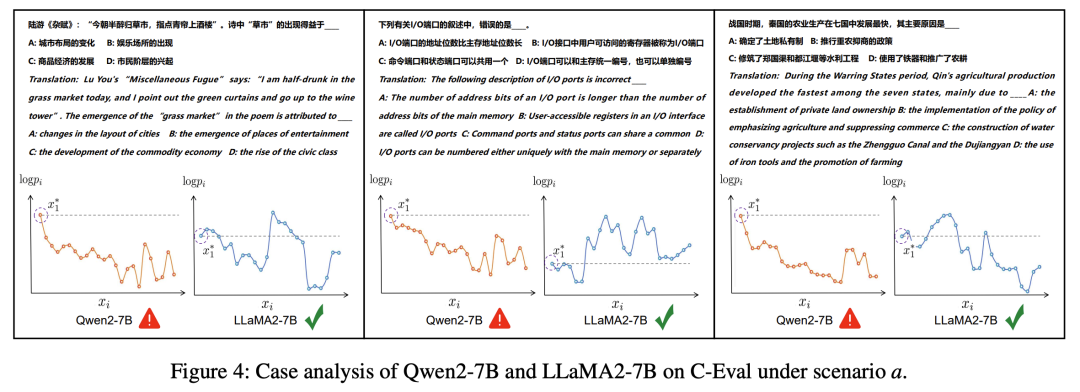

在案例研究中,论文从C-Eval中挑选了三个例子来直观展示在场景a下的数据泄漏情况。例如,第一个例子是关于陆游的《杂赋》中的“草市”,研究人员通过混洗选项内容得到了24个不同的数据排列。研究人员使用Qwen2-7B和LLaMA2-7B模型计算了这些排列的对数概率,并发现在Qwen2-7B模型中,原始数据的对数概率显著高于其他排列,暗示了数据泄漏的风险。而在LLaMA2-7B模型中,原始数据的对数概率并不突出,表明没有数据泄漏。特别地,对于Qwen2-7B模型,尽管原始序列的对数概率不是最高,但第19个衍生序列的对数概率最高,被算法2检测为异常值,表明存在泄漏风险。这个例子说明了即使在选项内容被混洗的情况下,论文的算法2也能有效地检测出数据泄漏。

结论

这项工作强调了大型语言模型(LLMs)中基准数据泄漏的严重性,并引入了一种创新的检测方法,能够识别各种情况下的泄漏,包括多项选择选项的顺序可能已被混洗的情况。论文基于两个LLMs设计实验验证了该方法的有效性,并评估了31个开源LLMs在四个主流基准集上的数据泄漏风险,展示了LLMs之间的基准泄漏排行榜,并特别发现Qwen家族的LLMs在几个基准测试中显示出高风险。这项工作强调了开发者和研究人员在确保LLMs评估的完整性和公平性方面保持警惕的必要性。论文呼吁社区继续努力解决这一问题,改进其的检测技术,并维护人工智能领域基准评估的稳健性。这篇论文是建立更可靠、更值得信赖的LLMs评估标准,以及以信心和诚信推进人工智能领域的垫脚石。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?