文章链接:https://arxiv.org/pdf/2410.13830

项目链接:https://dreamvideo2.github.io/

亮点直击

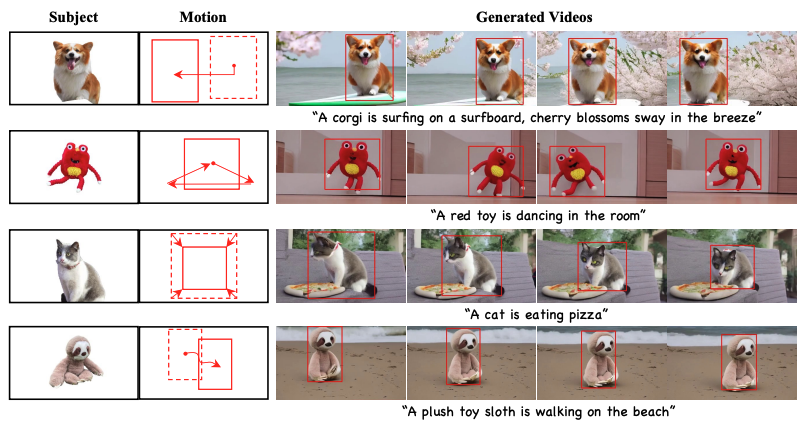

DreamVideo-2,首个无需微调,同时支持主体定制和运动控制的零样本视频定制框架,能够通过设计的参考注意力学习主体外观,并使用二值mask引导的运动模块实现运动轨迹控制。

识别出DreamVideo-2中运动控制占主导的问题,并通过使用混合mask 增强参考注意力(即mask参考注意力)和设计重加权扩散损失来解决该问题,从而有效平衡了主体学习和运动控制。

构建了一个大型、全面且多样性丰富的视频数据集,以支持零样本视频定制任务。

大量实验结果表明,DreamVideo-2优于现有的先进视频定制方法。

总结速览

解决的问题

现有的视频定制生成方法需要在测试时进行复杂的微调,且难以平衡主体学习与运动控制,限制了其在实际应用中的效果。

提出的方案

提出了DreamVideo-2,一种无需测试时微调的零样本视频定制框架,通过单张图像和一组边界框序列指导视频生成,确保生成视频的特定主体和运动轨迹。

应用的技术

-

参考注意力机制:利用模型固有的主体学习能力来学习特定主体。

-

mask 引导的运动模块:通过从边界框中提取的二值mask 来精准控制运动。

-

掩码参考注意力:将混合隐空间mask 建模方案集成到参考注意力中,以增强目标位置的主体表征。

-

重加权扩散损失:区分边界框内外区域的贡献,确保主体和运动控制的平衡。

达到的效果

在一个新构建的数据集上的大量实验表明,DreamVideo-2在主体定制和运动控制方面均优于现有的先进方法。

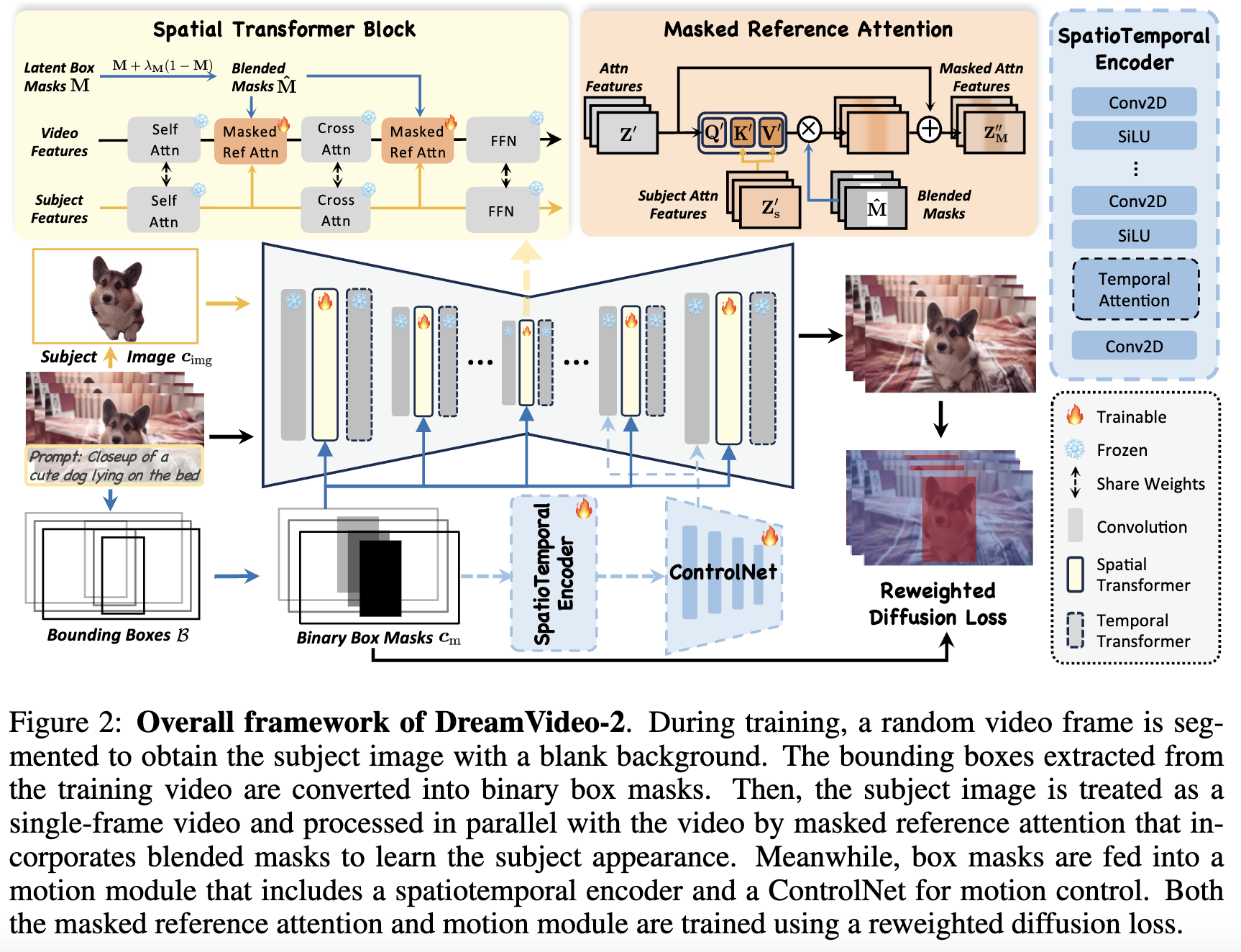

方法

给定一个定义主体外观的单个主体图像和一个描述运动轨迹的边界框序列,DreamVideo-2旨在生成包含指定主体和运动轨迹的视频,无需在推理时进行微调或修改,如下图2所示。为了学习主体外观,利用模型的固有能力,并引入了参考注意力。对于运动控制,提出使用mask作为运动控制信号,并设计了 mask 引导运动模块。此外,为了平衡主体学习和运动控制,通过混合 mask (即mask参考注意力)增强参考注意力,并设计了重加权扩散损失。最后,详细介绍了训练、推理和数据集构建过程。

通过参考注意力进行主体学习

对于主体学习,专注于使用单张图像来捕捉外观细节,这虽然具有挑战性,但有助于实际应用。给定单个输入图像,首先对其进行分割以获得主体图像 ,背景为空白,有效地保留了独特的ID特征,同时最小化背景干扰。

为了捕捉主体外观的复杂细节,先前的研究通常使用额外的图像编

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?