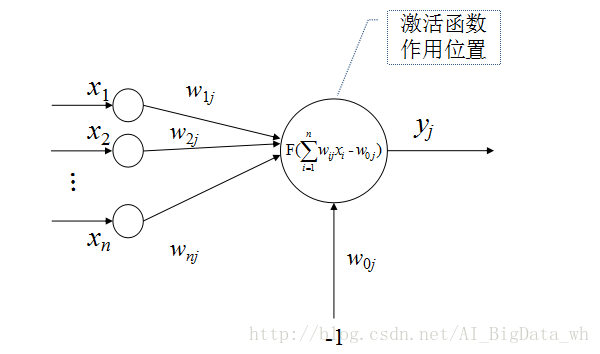

在感知器模型、神经网络模型、深度学习模型中均会看见激活函数的声影。激活函数又被称为转移函数、激励函数、传输函数或限幅函数,其作用就是将可能的无限域变换到一指定的有限范围内输出,这类似于生物神经元具有的非线性转移特性。

常用的激活函数有:线性函数、斜坡函数、阶跃函数、符号函数、Sigmoid函数、双曲正切函数、Softplus函数、Softsign函数、Relu函数及其变形、Maxout函数等。

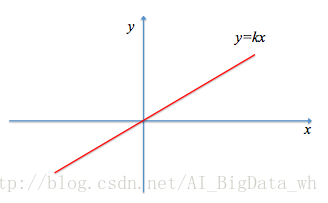

线性函数

线性函数是最简单的激活函数:

y=F(x)=kx.

其中 y 为输出值,

在深度学习模型中,线性函数几乎不被用到。因为其体现不出深度学习模型的价值,如假定深度学习模型有

斜坡函数

斜坡函数的定义如下所示:

y=F(x)=⎧⎩⎨⎪⎪r,x,−r,当x≥

本文详细介绍了深度学习中常用的激活函数,包括线性、斜坡、阶跃、符号、Sigmoid、双曲正切、Softplus、Softsign、ReLU及其变形Maxout函数。激活函数的作用是将输入进行线性或非线性映射,影响模型的训练效果。各种函数有其优缺点,如Sigmoid和tanh可能导致梯度消失,而ReLU系列函数能有效缓解这一问题。Maxout函数具有强大的拟合能力。选择激活函数需结合实际需求和模型结构。

本文详细介绍了深度学习中常用的激活函数,包括线性、斜坡、阶跃、符号、Sigmoid、双曲正切、Softplus、Softsign、ReLU及其变形Maxout函数。激活函数的作用是将输入进行线性或非线性映射,影响模型的训练效果。各种函数有其优缺点,如Sigmoid和tanh可能导致梯度消失,而ReLU系列函数能有效缓解这一问题。Maxout函数具有强大的拟合能力。选择激活函数需结合实际需求和模型结构。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1421

1421

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?