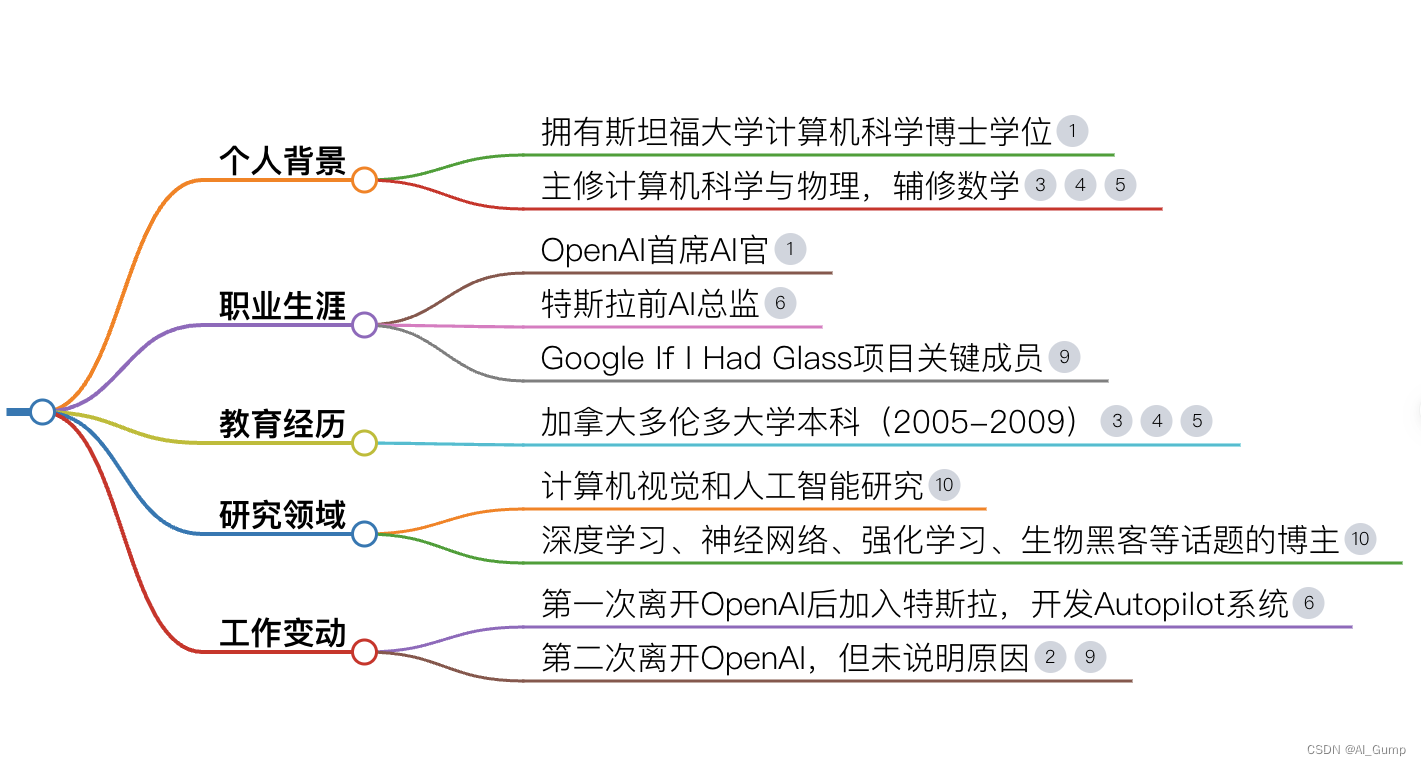

对于AK哥不太了解的朋友们,AK哥联合创立了OpenAI,是Tesla前AI总监,目前属于离职状态,并且在业务时间也在分享关于AI教育相关内容,其中手搓GPT系列也是爆火全网,可以说是AI工程师的宝藏男孩。

他不仅拥有顶尖的AI学术研究背景,还在学界、工业界有过多年经验,参与主导了许多项目,可以说是对前沿AI最有洞察力的几人之一

完整视频可看B站

【精校】大神Andrej Karpathy最新红杉AI活动演讲问答【中英】

核心观点提取:

1、LLM OS

- LLM 操作系统(外设:多模态数据;CPU:transformer 架构 LLM,软件 1.0基建:各种框架)

- LLM OS 类比 windows 操作系统:自带应用也支持三方的生态

-

- Windows 自带一些默认应用:edge 浏览器,但也支持三方 Chrome浏览器;

- OpenAI的 LLM OS 也会自带一些 apps,但也可以自己打造三方的Agents

- 目前开发基于LLM能力的APP的状态: 需要时间学会使用这个基础设施

-

- 大模型现在的应用就像早期的 iphone app,一开始不好用,后面会越来越好

- 现在不是LLM成熟到一个类似于安卓的状态,,需要花时间去学会使用现有的软件基建

- LLM OS 的生态:除了类似 Mac + Windows的系统外,还可能有各种开源发行版的 Linux

-

- 闭源: GPT、gemini、Anthropic

- LLaMA 和 Mistral 不是真正的开源,只能算开放权重的模型, 比如只给你操作系统的二进制文件,可能可以微调一下,但是从根本上进行调整不太可能

- 真正开源的:llm 360(LLM360 | Open-source LLMs for Transparency, Trust, and Collaborative Research 🚀 真正开源整个 Infrastrcuture,就像可以从源码编译操作系统一样,可以从原始数据训练出来这个模型

- 这些非开源的模型,微调带来的结果是过拟合微调数据的结果,会在其他能力上有所退步;只有真正开源的才可以从训练上加能力

- 可以参考::

2、Scaling Law

- Scaling Law 是第一性原理,但需要把一些事情聊透

-

- 需要高质量的数据准备+算法+训练架构

- 就像光速 = 3*10^8 km/s; 如果没有达到光速,就突破广义相对论中的时间倒流

- 不是有钱就能干大模型的,主要的限制 是 AI 基建(卡、训练部署)+数据+算法

-

- AI 基建还没好到有钱就能干(是一个非常复杂的分布式计算的问题,人才也有限)一下子训练 1w 张卡也是最近才能达成的事情,AI 基建没有准备好大规模的训练

3、现阶段遇到的 LLM 问题

- 算法侧:diffusion model 扩散模型 和 autoregressive model 自回归模型都是一种展示概率分布的模型,但却又很明确的分界线。我们现在也需要多模态,所以在考虑怎么用一个大一统模型或者混合的架构来统一这两个能力

- 能耗效率:人脑 20W vs LLM 大概 MW 级别;

-

- 需要让现有的计算架构适应LLM的数据pipeline

- Precision 降低 ,降低能耗

- Sparsity 离散型,人脑不是每一次思考都并不是需要跑完全连接层的

- 需要架构调整,冯诺依曼架构不够好,数据搬进搬出耗能太高,可以参考:张鹏对谈安克阳萌:GPU 和 Transformer 可能是中间态,机器人+大模型会诞生超级品类

4、公司风格

- Elon Musk

-

- 管理风格: 公司这么大还像一个创业公司,没有中间管理层, 喜欢小而强大的技术团队,不会公司变大而招更多庸才,不行就开掉

- 氛围: 不喜欢开大会,办公环境要有活力;

- 跟团队连接非常紧密,Elon 会直接跟工程师对话,会直接解决资源卡点等问题

5、对 AI 的态度:

- 偏好一个拥有强大生态的AI体系,就像珊瑚礁一样,这个体系下很多创业公司都可以存活,激活整个经济,不喜欢 N 个寡头大公司

观众 QA:

Q:model composability

A:传统代码很 composable,神经网络全连接默认不好搞;但是整体可以 fine tune。 Pre-train + Fine-tune

Q:模型能力

A:我们现在只做了 alpha go 的一步,第二步是 RL;对应就是我们 LLM 只做了模仿,第二步是超越人类

比如如果我们要解决一个数学问题,GPT 的训练部分是需要 收集这部分的数据

GPT:人类出题,人类解题;解题过程中有部分对模型是能学到,有部分对模型是思维跳跃太大,跟不上

我们达到到第二步,是需要模型自己训练自己,即强化学习的概念(RL)

目前的 GPT-4的 人类强化学习(RLHF) 是一个很弱的 RL

就是让人两个答案二选一,选的其实就是一个偏好,很容易过拟合

Q:怎么做成本优化和性能优化

A:业界常用的范式,先搞一个最牛逼的模型达到效果,然后慢慢后退,找到你能接受的最便宜 的模型

可以用 GPT4 做知识蒸馏,最后蒸馏 fine tune 到小模型

Q:怎么看待Llama开源,以及其他开源社区模型的进步

A:大模型是资本密集型, Meta 放出大模型,吸引更多的想法,主力生态后面再收割,逻辑合理

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?