第一眼看到逻辑回归(Logistic Regression)这个词时,脑海中没有任何概念,读了几页后,发现这非常类似于神经网络中单个神经元的分类方法。

书中逻辑回归的思想是用一个超平面将数据集分为两部分,这两部分分别位于超平面的两边,且属于两个不同类别(和SVM的想法有些相似),如下图:

因此,一般的逻辑回归只能处理两分类问题,同时两个类别必须是线性可分的。对于线性不可分问题,在SVM中,可以使用核函数升维的方式解决,不过那都是后话了。还是先看看逻辑回归吧。

一、Sigmoid函数

了解神经网络的朋友想必不会对这个东西陌生,在神经网络中它就是所谓的激励函数,其最常用的一种表现形式如下:

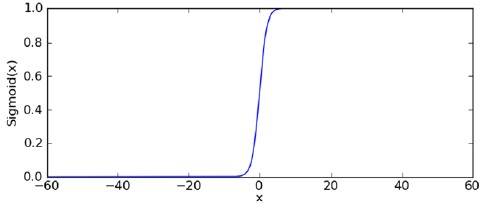

函数曲线如下:

很显然它是对阶跃函数的一个很好的近似,当输入大于零时,输出趋近于1,输入小于零时,输出趋近于0,输入为0时,输出刚好为0.5。

在逻辑回归中,训练和分类所用数据的取值范围是任意的,因此我认为,Sigmoid在逻辑回归中除了有分类作用外,最主要作用是将数据映射到0和1之间,之后我会说明具体原因。

二、超平面与梯度上升(下降)

作为分界面的超平面定义如下:

其中可取x0 = 1,即将w0作为一个常量偏移。

通过该式可以计算得到一个z值,这个z值将作为Sigmoid函数的输入,其输出大于0.5和小于0.5分别表示两个不同的类别,也即实现了两分类。现在的问题是,给定一组训练数据,如何求出超平面中的系数,即w。

我们使用梯度上升算法进行优化求解。了解神经网络的朋友对梯度上升或梯度下降应该也很熟悉吧。一个函数的梯度定义为:

本文介绍了逻辑回归的基本思想,通过Sigmoid函数将数据映射到0和1之间进行分类,并利用梯度上升(下降)算法求解超平面系数。逻辑回归主要用于两分类问题,线性可分的数据集。文章还探讨了Sigmoid函数的作用,以及如何在C#中实现逻辑回归算法,同时指出该方法的优缺点和局限性。

本文介绍了逻辑回归的基本思想,通过Sigmoid函数将数据映射到0和1之间进行分类,并利用梯度上升(下降)算法求解超平面系数。逻辑回归主要用于两分类问题,线性可分的数据集。文章还探讨了Sigmoid函数的作用,以及如何在C#中实现逻辑回归算法,同时指出该方法的优缺点和局限性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2375

2375

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?