大模型评估是目前非常重要的一个方向,直接影响了AI系统的可靠性和实用性。随着大模型在各个领域的应用越来越广泛,评估这些模型的表现变得至关重要。

有效的评估可以帮助我们了解模型的优劣,发现改进的方向,并确保模型在实际应用中产生期望的效果,评估方法的发展对提高模型的准确性、公平性和安全性起着关键作用。

这篇文章探讨如何评估大型语言模型(LLMs)作为评估器(LLM-evaluators)的有效性。主要难点在于如何选择合适的比较基线、评分方法和评估指标,同时还要考虑如何在开发和生产环境中应用和优化这些评估器。相关研究包括各种评估LLMs的方法,如人工标注、微调的分类器和奖励模型等。

文章出自亚马逊的高级应用科学家,值得收藏学习。

一、评估方法

有多种方法用于评估LLM-evaluators的有效性,可以参考下面的几种

-

直接打分:这个方法就是直接给模型生成的单个回答打分,不用跟别的回答比。这就像是你直接给一篇作文打分,不用看别的作文做对比。比如,如果你想评估一个模型回答某个政策问题的准确性,你就直接看它的回答是否符合事实,然后打分。

假设你问模型“气候变化的主要原因是什么?”模型回答“主要原因是温室气体的排放”。你觉得这个回答挺准确,于是你给它打个高分,比如90分。

-

成对比较:这个方法更高级一点,它通过比较模型生成的回答与人类回答之间的差异来进行打分。比如你想看看模型在理解语言或表达语气上的能力时,你会用这种方法。

你问模型和人类同样的问题,比如“如何更好地管理时间?”然后比较模型的回答和人类的回答,看看哪个更有说服力、更连贯。如果模型的回答与人类的相差不大,你就认为它表现得不错。

-

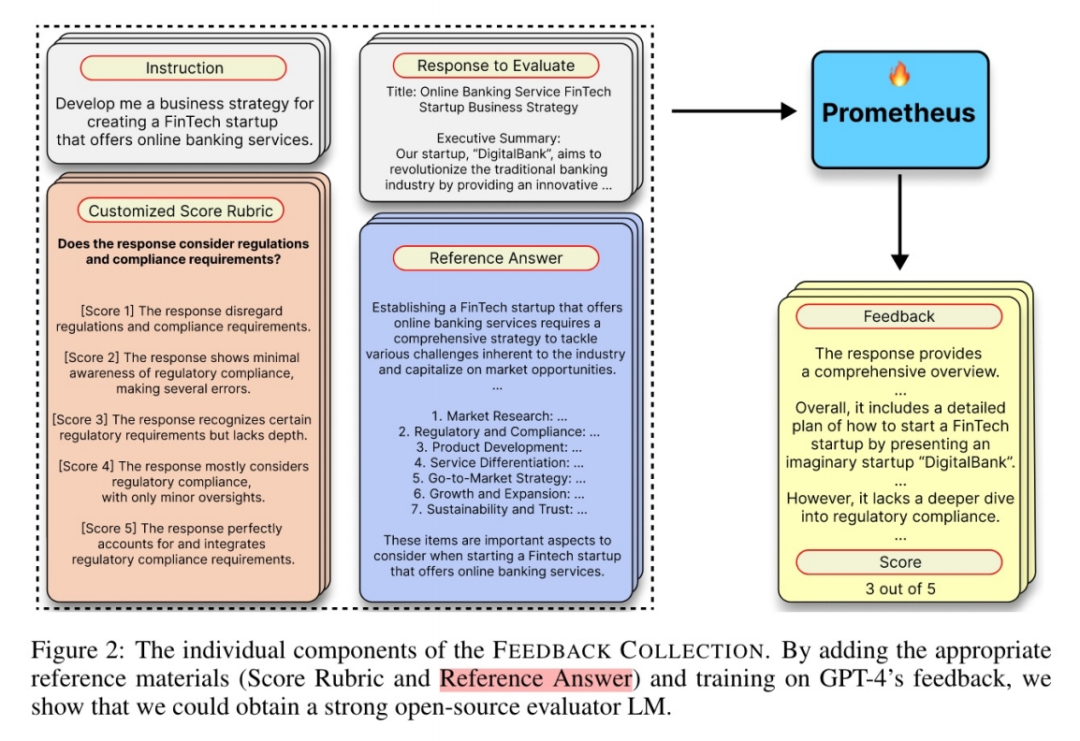

参考标准评估:这个方法是把模型的回答跟一些参考答案对比,参考答案里包含了模型生成的回答应该有的信息。这个方法更复杂一点,就像是把模型生成的答案和标准答案做逐字对比,看相似度有多高。

你有一个标准答案,比如“早睡早起可以帮助提高工作效率,因为这样可以保证你每天有足够的休息时间。”模型的回答是“早睡早起能提高效率,因为它让你每天有足够的时间休息。”你会对比这两句话,看看它们的相似度,然后根据相似度打分。

-

分类指标:这里提到了 召回率 Recall 和精确率 Precision,这两个指标主要用来评估模型在处理分类问题时的表现。简单来说,召回率表示模型有多好地把所有正确的东西都找出来,而精确率表示模型找出来的东西中有多少是正确的。这两个指标通常用于检测模型在判断某些事实是否一致或在识别有害内容时的表现。

换句话说,你有一个模型用来检测评论中是否有不当内容。召回率高意味着模型能找到大部分有问题的评论,而精确率高意味着模型标记为“不当”的评论确实大多是不当的。如果一个模型的召回率和精确率都很高,那么说明它在识别不当内容方面表现得很好。

-

相关性指标:这些指标(如Cohen’s Kappa, Kendall’s Tau, Spearman’s rho)用于衡量两个评分之间的一致性。特别是Cohen’s Kappa,它考虑到了偶然一致的情况,适用于二元或分类数据。简单来说,这些指标可以用来判断两个评估者(比如两个不同的模型或一个模型和一个人工评估者)在给出评分时是否有高度的一致性。

假设你有两个模型在给学生的作文评分,Cohen’s Kappa可以告诉你这两个模型在评分时是否一致。如果Cohen’s Kappa值高,说明两个模型打分时的意见很一致,可靠性也高。

这些方法和指标的引入,是为了更全面和准确地评估模型的表现,确保它们在不同情境下都能提供有用和可信的结果。

二、结论分析

-

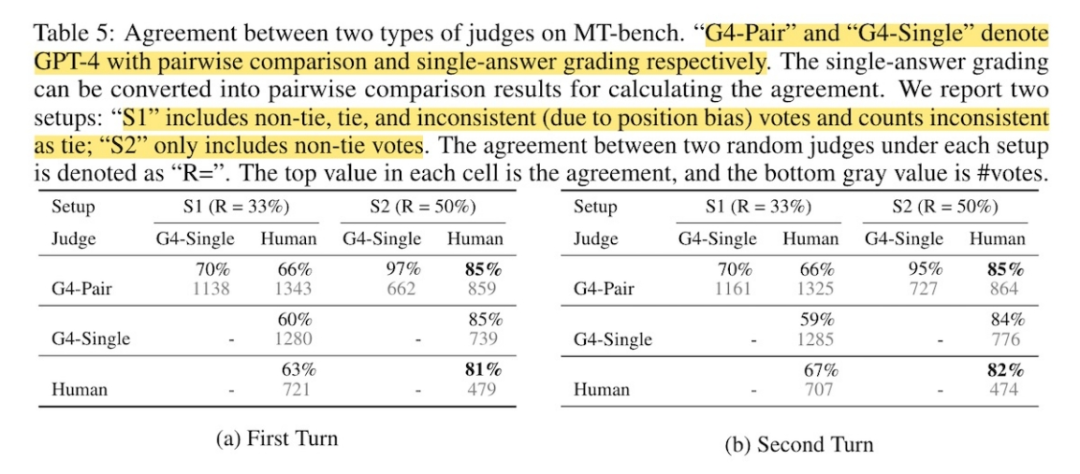

直接评分与成对比较: 在主观评估任务中,成对比较比直接评分更可靠,结果更稳定。例如,在Chatbot Arena数据集中,gpt-4与人类判断的一致性达到了83%-87%。

-

参考基准评估:参考基准评估在评估生成响应与参考的匹配程度时表现良好,但在某些任务中可能存在挑战。例如,在HaluEval数据集中,gpt-4的评分为0.897,接近人类判断的0.902。

-

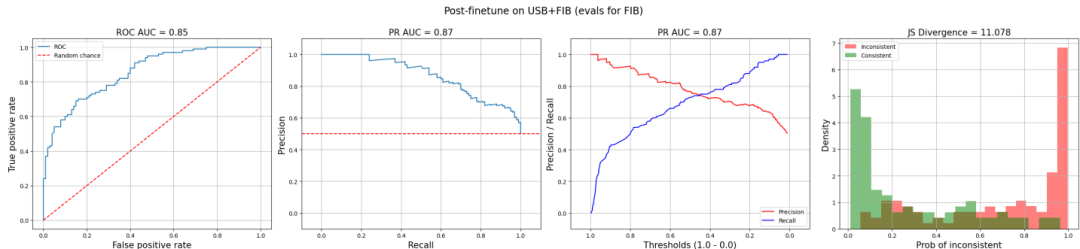

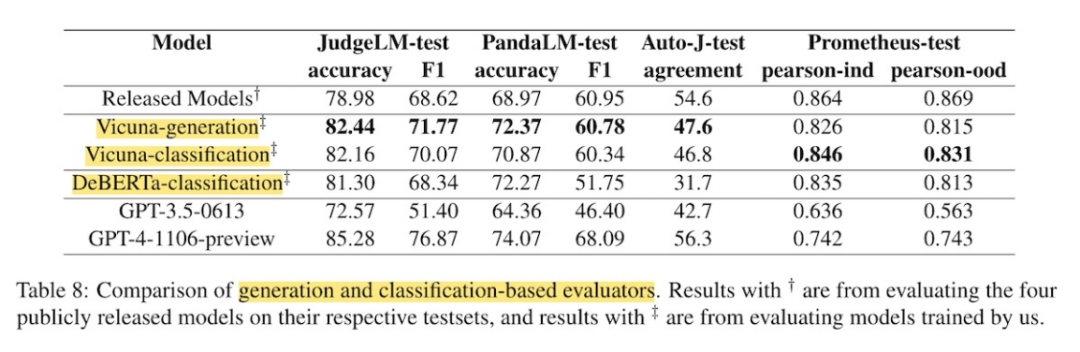

分类指标与相关性指标:分类指标在评估事实不一致性和毒性等任务中表现良好,而相关性指标在衡量评分一致性时有一定应用,但需谨慎解释。例如,在LLMBar数据集中,DeBERTa-classification评估器的准确率为0.52,接近随机猜测的0.5。

三、关键问题及回答

问题1:LLM-evaluators在选择基线进行比较时有哪些考虑因素?

在选择基线进行比较时,LLM-evaluators需要考虑以下几个因素:

基线的类型:基线可以是人类标注者、小型微调评估器模型或其他LLMs。通常情况下,人类标注者被用作基线,因为它们在准确性和速度上更容易匹配。

评估任务的性质: 如果任务是客观的(如事实一致性、毒性检测),则直接评分更为合适;如果是主观的(如说服力、语气、连贯性),则成对比较更为可靠。

评估的准确性需求:对于需要高准确性的任务,可能需要使用微调的分类器模型作为基线,而不是人类标注者。

问题2:LLM-evaluators在评估响应时有哪些不同的评分方法?每种方法的优缺点是什么?

LLM-evaluators在评估响应时采用了三种主要的评分方法:

直接评分: 评估器直接对单个响应进行评分,不需要比较对象。优点是适用范围广,适用于客观评估任务;缺点是可能无法全面捕捉响应的所有质量维度。

成对比较: 评估器选择两个响应中较好的一个或宣布平局。优点是在主观评估任务中表现更稳定,结果更可靠;缺点是需要两个响应进行比较,可能不适用于某些单响应任务。

参考基准评估: 评估器将生成的响应与黄金参考进行比较。优点是能够进行更复杂的模糊匹配,适用于需要高精度评估的任务;缺点是需要大量的标注数据来构建和维护黄金参考。

问题3:在评估LLM-evaluators的性能时,为什么选择分类指标和相关指标?这些指标各自的适用场景是什么?

选择分类指标和相关指标来评估LLM-evaluators的性能是因为它们各有适用的场景:

分类指标: 如召回率和精确率,适用于二分类或多分类任务。在评估LLM-evaluators时,这些指标可以直观地反映模型在识别有害行为、事实一致性等方面的能力。分类指标的优点是计算简单、易于解释;缺点是对噪声数据的敏感性较高。

相关指标: 如Cohen’s Kappa、Kendall’s Tau和Spearman’s rho,用于评估LLM-evaluators与人类判断的一致性。这些指标适用于评估模型的稳定性和可靠性,特别是在主观评估任务中。相关指标的优点是能够提供更细致的一致性度量;缺点是计算复杂度较高,且对随机误差的敏感性较高。

最后分享

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

5. 大模型面试题

面试,不仅是技术的较量,更需要充分的准备。在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

如有侵权,请联系删除。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?