引言:为什么需要替代方案?

当遇到DeepSeek服务繁忙时(特别是在访问高峰期),选择本地部署或云端替代方案能有效保障业务连续性。

本文提供两种技术路线的详细对比与实践指导,助您根据实际需求做出最优选择。

*本文主要面向非技术背景用户提供选择建议(※注:企业用户及技术专家请结合实际情况综合评估后决策).

一.普通用户选择指南(一图看懂如何选):

1.核心对比表

| 维度 | 本地部署版 | 云端网页版 |

| 使用门槛 | 需技术基础(安装/维护) | 打开浏览器即用 |

| 模型大小 | <70B(残血版) | 671B(满血版) |

| 启动成本 | 高(需自备服务器/显卡) | 零成本(注册即用) |

| 数据隐私 | ★★★★★(数据完全本地存储) | ★★★☆☆(依赖云端安全措施) |

| 响应速度 | 极快(本地运行) | 中等(依赖网络质量) |

| 功能更新 | 手动升级 | 自动获取最新功能 |

| 典型场景 | 敏感数据处理/长期高频使用 | 临时需求/轻度使用 |

2.决策三步法

第一步:需求自测

✅ 选本地部署 如果:

- 每天使用超过3小时

- 处理身份证号/医疗记录等敏感数据

- 已有闲置高性能电脑(特别是带NVIDIA显卡)

- 接受小模型的降智(特别是1.5B/7B模型)

✅ 选云端版 如果:

- 每周使用≤10次

- 主要处理公开数据/测试用途/日常搜索对话

- 使用MacBook/轻薄本等非性能设备

- 想体验AI的初级用户

第二步:成本计算器

| 方案 | 第一年成本 | 后续年成本 |

| 本地部署 | 约8000元(二手服务器) | 约500元/年(电费维护) |

| 云端版 | 免费(基础功能) | 约1200元/年(会员套餐) |

注:以每日使用1小时为基准计算

第三步:试用手册

混合使用建议:

- 敏感操作:在本地处理隐私数据

- 临时需求:使用云端快速响应

- 大文件处理:先传云端快速处理,再下载到本地分析

3.选择建议

选择云端版:

- 只是想体验AI功能

- 使用频率≤10次/周

- 没有高性能设备

考虑本地部署:

- 已成为深度用户(日均使用>2小时)

- 处理公司/个人机密数据

- 愿意学习基础运维知识

二.云端网页版(满血版平替):

| 平台名称 | 特点 | 直达链接 |

| 硅基流动 | 注册送14元体验金 | |

| 超算中心 | 无需下载APP | |

| 当贝AI | 打开即用/响应最快 | |

| 秘塔AI | 法律文档专用版 | |

| Monica | 海外用户推荐 |

**.2/25新增两个体验感优秀的方案:

1.火山方舟(注册送15元额度):火山方舟入口

2.腾讯元宝(免费):腾讯元宝 - 轻松工作 多点生活

三.本地化部署(保姆喂饭级教程)

1.选择适合你的DeepSeek版本

首先,挑选一个适合自己电脑的版本:

1) 小巧版(1.5B)

特点:轻便灵活,适合文字处理

对电脑要求低,普通笔记本也能运行

可满足尝鲜需求

2) 标准版(7B)

特点:智商在线,能处理复杂任务

需较好电脑配置(16G内存起步)

推荐首选,性价比最高!

3) 加强版(8B)

特点:更强性能,但对配置要求高

建议有高配电脑的用户选择

普通用户慎入,以免电脑崩溃...

别急着往下冲,先检查下你的电脑配置!

| 模型参数 | 显存需求 | 内存需求 | 推荐显卡/硬件 | 适用场景 |

| 1.5B | ≥1GB | ≥4GB | 核显/低端独显 | 移动设备/简单文本生成 |

| 7B | ≥4GB | ≥8GB | GTX 1060/RX 580 | 基础NLP任务 |

| 8B | ≥4GB | ≥8GB | RTX 3060(12GB) | 中等复杂度推理 |

| 14B | ≥8GB | ≥16GB | RTX 3080(10GB)/RTX 4080 | 编程开发/复杂推理 |

| 32B | ≥16GB | ≥32GB | RTX 4090(24GB) | 多模态任务 |

| 70B | ≥35GB | ≥64GB | 双RTX 4090/A100(40GB) | 企业级复杂场景 |

| 671B | ≥800GB | ≥512GB | 浪潮NF5688G7服务器8 | 全球级超复杂任务 |

Windows用户:

- 内存:最少8GB(建议16GB)

- 显卡:要有NVIDIA显卡(GTX 1060以上,1.5B模型核显也可用)

- CPU:i5处理器或同等级别

Mac用户:

- 内存:8GB起步

- 芯片:M1或更新款(亲测M1 pro Macbook Pro可比较流畅地运行14B模型)

- 系统:最新版macOS

2.开始部署本地化:

第一步:安装Ollama管理工具,视其为DeepSeek的“管家”,负责全面管理。

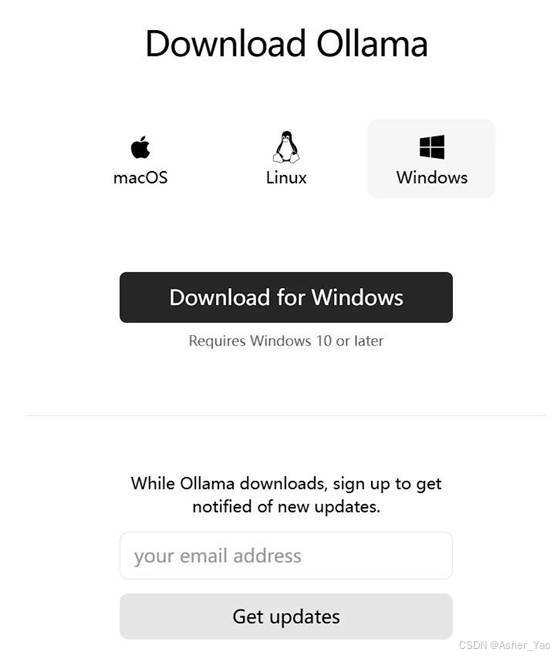

去Ollama官网下载安装包(Ollama)

点击Download

Windows用户,点击 Download for Windows

Mac用户,点击 Download for Mac

文件下载完成后:

Windows用户双击安装,Mac用户拖进应用程序文件夹

安装完成.

第二步:部署DeepSeek模型

切换到Ollama官网,选择Models,找到【deepseek-r1】,一般建议选择【7b】版本,配置适中,性能也尚可。

选择7b,然后复制右边的 ollama run deepseek-r1

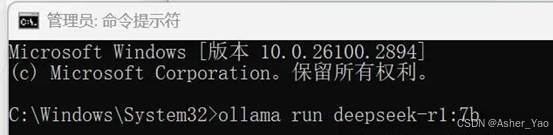

第三步:以管理员身份运行命令提示符

打开命令行(Windows按Win+R输入cmd,Mac打开终端)

输入或粘贴命令行:ollama run deepseek-r1:7b

安心等待下载完成...

安装完成,进行下一步

第四步:安装DeepSeek运行的界面

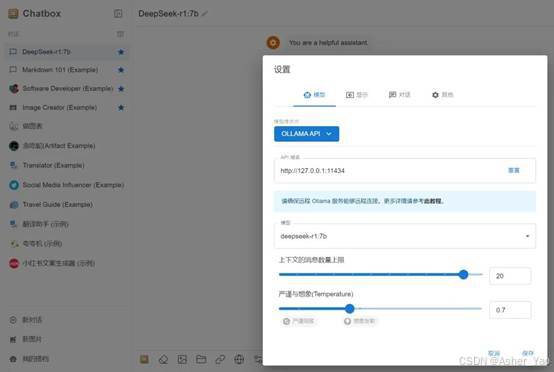

下载安装Chatbox(Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载)

点击免费下载后进行安装

完成后进入软件选择"Ollama API"

参考图中配置

第五步:使用DeepSeek

大功告成!可以和Deepseek-r1:7b模型进行对话了!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?