参考自https://github.com/titu1994/DenseNet/blob/master/densenet.py

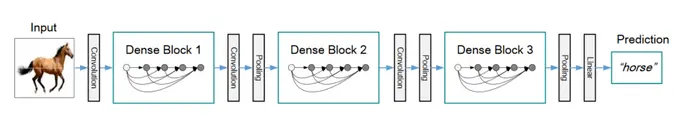

先来一张图,便于理解网络结构,推荐的dense_block一般是3。两个dense_block之间的就是过渡层。每个dense_block内部都使用密集连接。

Conv_block:

卷积操作,按照论文的说法,这里应该是一个组合函数,分别为:BatchNormalization、ReLU和3x3 Conv。

def conv_block(ip, nb_filter, bottleneck=False, dropout_rate=None, weight_decay=1e-4):

''' Apply BatchNorm, Relu, 3x3 Conv2D, optional bottleneck block and dropout

Args:

ip: Input keras tensor

nb_filter: number of filters

bottleneck: add bottleneck block

dropout_rate: dropout rate

weight_decay: weight decay factor

Returns: keras tensor with batch_norm, relu and convolution2d added (optional bottleneck)

'''

concat_axis = 1 if K.image_data_format() == 'channel_first' else -1

x = BatchNormalization(axis=concat_axis, epsilon=1.1e-5)(ip)

x = Activation('relu')(x)

if bottleneck:

inter_channel = nb_filter * 4

x = Conv2D(inter_channel, (1, 1), kernel_initializer='he_normal', padding='same', use_bias=False,

kernel_regularizer=l2(weight_decay))(x)

x = BatchNormalization(axis=concat_axis, epsilon

本文档介绍了如何使用Keras实现DenseNet网络结构。内容包括Conv_block、Transition_block、Dense_block的详细解释,以及如何构建完整的DenseNet模型。DenseBlock中的密集连接通过concatenate函数实现,利用1x1卷积进行通道数的压缩,并在Transition_block中使用Maxpooling进行下采样。

本文档介绍了如何使用Keras实现DenseNet网络结构。内容包括Conv_block、Transition_block、Dense_block的详细解释,以及如何构建完整的DenseNet模型。DenseBlock中的密集连接通过concatenate函数实现,利用1x1卷积进行通道数的压缩,并在Transition_block中使用Maxpooling进行下采样。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?