作者 | 自动驾驶之心

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心技术交流群

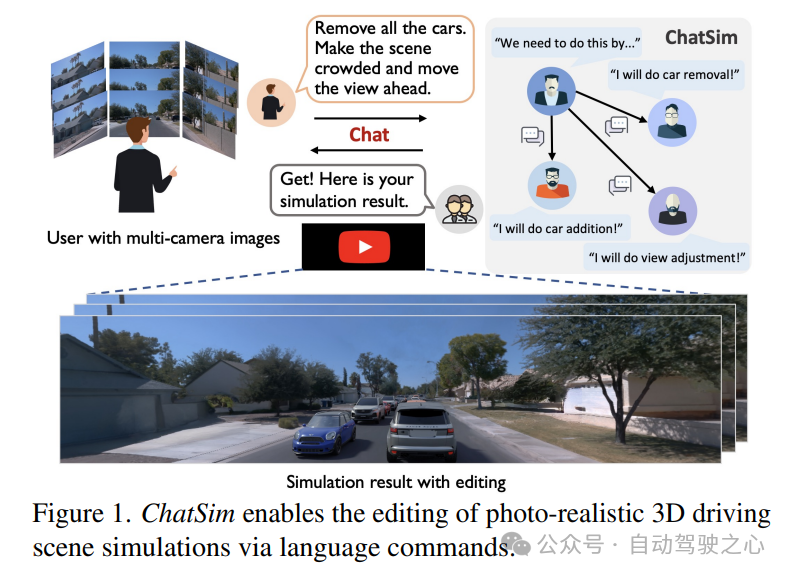

自动驾驶中的场景仿真因其生成定制数据的巨大潜力而受到了重视。然而,现有的可编辑场景仿真方法在用户交互效率、多相机逼真渲染和外部数字资产集成方面存在局限性。为了解决这些挑战,本文介绍了 ChatSim,这是第一个通过自然语言命令实现可编辑逼真3D驾驶场景仿真并集成外部数字资产的系统。为了实现高度灵活的命令编辑,ChatSim利用了一个大型语言模型(LLM)agent协作框架。为了生成逼真的结果,ChatSim采用了一种新颖的多相机神经辐射场方法。此外,为了释放大量高质量数字资产的潜力,ChatSim采用了一种新颖的多相机光照估计方法,以实现场景一致的资产渲染。我们在 Waymo Open Dataset 上的实验表明,ChatSim能够处理复杂的语言命令并生成相应的逼真场景视频。

原文:Editable Scene Simulation for Autonomous Driving via Collaborative LLM-Agents

链接:https://arxiv.org/pdf/2402.05746.pdf

开源代码:https://github.com/yifanlu0227/ChatSim

如下所示,ChatSim能够通过语言命令编辑逼真的3D驾驶场景模拟:

ChatSim性能怎么样?

方法兼容混合、高抽象和多轮命令,在广角渲染的真实感中提高了4.5%,实现了SoTA性能。此外,证明了我们的照明估计在质量和数量上都优于SoTA方法,将强度误差和角度误差分别降低了57.0%和9.9%。现有和提出的自动驾驶模拟方法的比较。

ChatSim框架一览

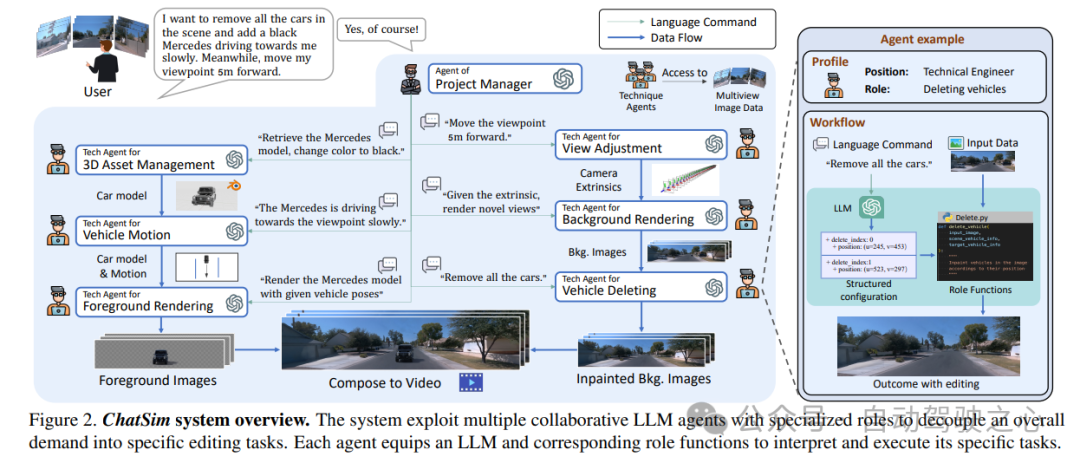

图2:ChatSim系统概述。该系统利用具有专门角色的多个协作LLM agent,将总体需求解耦为特定的编辑任务。每个agent都配备了LLM和相应的角色功能来解释和执行其特定任务。

这里提出了两种新的渲染技术,以增强模拟中的照片真实性。为了解决多个相机引起的渲染挑战,提出了多相机神经辐射场(McNeRF),这是一种新的NeRF模型,考虑了不同的相机曝光时间以实现视觉一致性。为了使用特定位置的照明和精确的阴影渲染逼真的外部数字资产,提出了McLight,这是一种与我们的McNeRF相结合的新型混合照明估计方法。请注意,背景渲染agent和前景渲染agent分别利用McNeRF和McLight。

效果怎么样?

主要在Waymo开放数据集上演示了各种结果,其中包含高质量的多摄像机图像和相应的校准。对于McLight skydome估计,从在线HDRI数据库中收集449个HDRI用于自动编码器训练,并使用第二阶段的街景全景数据集HoliCity;请参阅附录中的更多数据集详细信息。在实验中,在每帧中使用前置、左前和右前摄像头。在渲染过程中,以10Hz的采样率为每个场景选择40帧,总共120幅图像。平均选择其中的1/8作为测试集,其余用于训练。输入图像以数据集1920×1280的初始分辨率使用;在所有实验中使用GPT-4作为LLM;

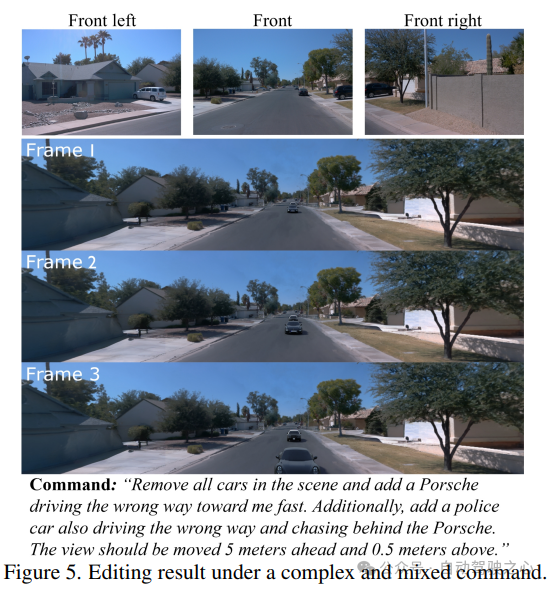

在复杂和混合的命令下编辑结果:

更多实验结果:

【新年活动一】

【新年活动二】

自动驾驶之心知识星球新人8折优惠、续费6折优惠,微信扫码领取!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?