点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

编辑 | 自动驾驶之心

A Survey on Robotics with Foundation Models: toward Embodied AI https://arxiv.org/abs/2402.02385

尽管具身AI的探索已经历了数十年,但赋予智能体以人类水平的智能,包括感知、学习、推理、决策、控制和泛化能力,使它们能够在开放、非结构化和动态环境中执行通用任务,仍然是一个持续存在的挑战。基础模型还不能直接与物理世界中的实体进行交互,也就是说,它们只是为人类和代理提供辅助信息,而不是决策者,因此目前的应用仅限于互联网。因此,如何将基础模型与决策模型融洽融合是具身智能的关键问题。近日,美的集团发表了一篇综述描述了解决该问题的一些关键

这篇综述旨在全面且最新地概述机器人学中的具身智能基础模型,重点关注自主操作,涵盖高级规划和低级控制。1)高级规划:这涉及处理来自用户的自然语言指令和来自交互环境的观测,最终形成逐步决策。基础模型有助于利用其底层世界知识来解释指令、感知环境和通过复杂任务进行推理;2)低级控制:重点是在监控环境和机器人状态的同时执行指令,最终确定精确的执行参数,如机器人手臂末端执行器的位置或关节的角度。基础模型的能力使同时学习多个任务和做出精细的执行决策成为可能。此外,文章还展示了它们常用的数据集、模拟器和基准测试。文章还强调了该领域固有的关键挑战,并勾勒出了未来研究的潜在途径。下面一起来看看综述正文~

1 高级规划的基础模型

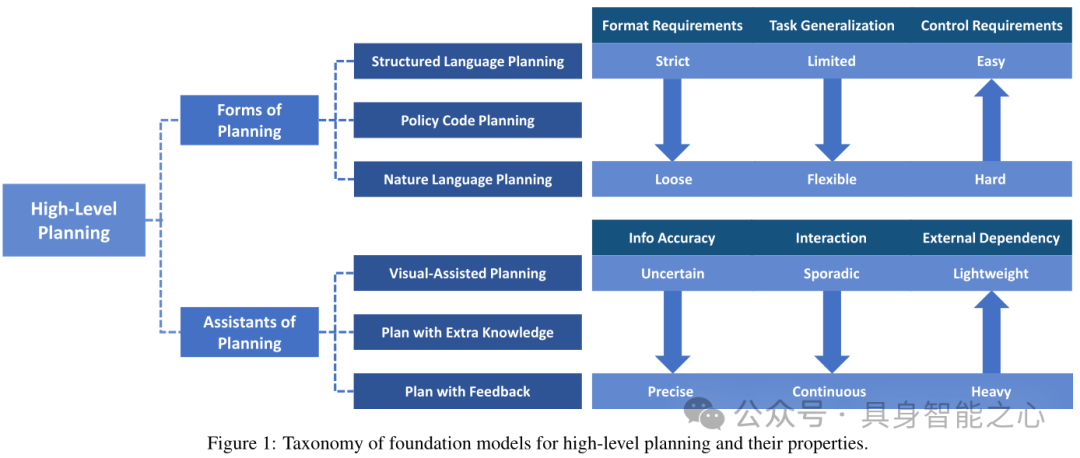

高级规划通常涉及复杂的长期任务,需要模型处理来自用户的自然语言指令和来自交互环境的观测,并形成逐步决策。因此训练单个策略模型以基于简单明了的指令完成整个任务仍然是一个挑战。该模型不仅需要掌握多种技能,还需要理解这些技能之间的顺序执行顺序,这使得训练过程本质上变得复杂。鉴于视觉和语言基础模型在复杂推理和上下文泛化方面所展示出的卓越能力,学者们普遍开始探索应用基础模型解决高级规划挑战。文章从(1.1)规划的形式和(1.2)规划的辅助工具两个角度,回顾了如何应用基础模型来理解用户命令和规划长期任务。

1.1 规划的形式(Forms of Planning)

基础模型,如大型语言模型(LLMs)和视觉语言模型(VLMs),能够生成多种规划格式,从高度结构化的格式(如规划领域定义语言PDDL)到富有表现力的编程代码,甚至是更灵活的自然语言。基础模型的规划形式通常有以下两类:

(1)更严格的形式提供了更高的精确度,并且更容易被机器人控制器解读,但其预定义的性质限制了基础模型的表达能力。这一局限性意味着模型只能在这些结构内生成内容,可能在零样本任务中降低其有效性。如,策略代码规划(Policy Code Planning)将自然语言指令解耦为代码形式的几个步骤。值得注意的是,规划形式是一个组织良好、顺序敏感的程序,涉及复杂的规划。代码擅长提供对空间位置的精确描述和对象的独占引用。此外,使用代码作为高级规划提供了表达函数或反馈循环、处理感知输出和参数化控制原语API的优势。

(2)相反,虽然结构较为松散的形式提供了更强的表达能力和更适合解读自然语言用户命令的优点,但可能为机器人执行带来挑战。例如,自然语言规划(Natural Language Planning))步骤需要复杂的低级控制器才能进行有效理解和执行。自然语言生成是基础模型固有的能力,具有良好的可解释性。然而,自然语言可能缺乏清晰的表达,从而误导代理并终止任务。学者提出多种方法来缓解自然语言规划的以上问题:

CAPEAM模型利用子目标规划器从任务指令中提取子目标和具体对象,从而通过这些子目标和对象的组合减少表达歧义。此外,它利用外部模型来评估子目标,以验证它们的可行性、正确性和清晰度。

ViLA模型直接应用最先进的多模态基础模型GPT4-V,通过思维链推理和丰富的web级知识,为长期任务生成自然语言规划。

RSFT提出识别快速思维和慢速思维,以便更精确地规划和执行,这分别是指采摘等直接动作和重新排列等多步骤推理任务。

1.2 规划的辅助工具(Assistants of Planning)

为了弥合机器人语言处理与实际感知信息之间的差距,研究人员正在探索通过增加额外的辅助工具来增强基础模型(如LLMs)以实现更有效的规划。这包括(1)将视觉模型集成到LLMs中,以辅助目标识别,(2)并纳入外部反馈来指导机器人操作。此外,(3)将额外的常识知识与基础模型相结合也对推理和规划有益。

(1) 视觉辅助规划(Visual-Assisted Plan)

部分学者将视觉模型集成到LLMs中,以辅助目标识别。基于视觉辅助规划语言的基础模型通常需要传统深度学习模型(例如,2D/3D检测模型)或其他大型视觉语言模型的支持对图像数据进行处理,进行任务规划。比如,直接将视觉基础模型的检测结果整合到LLM的提示中进行规划或重新规划;或者利用LLM生成初始规划,并在VLM的帮助下生成初始规划。

视觉基础模型也可以为LLM进行下一步的规划提供参考价值或辅助功能:例如,SayCan模型引入了一个视觉模型来预测规划中成功执行每种技能的概率,并与LLM共同确定流程的下一步。GD模型在视觉模型的帮助下,直接预测了下一步每个token的概率,并结合了LLM和视觉模型估计的概率,用一个联合解码过程选择下一个token。

VLM也可以直接集成LLM和可视化信息进行任务规划,利用VLM的一种简单有效的方法是在原始框架中用VLM代替LLM,这样的模型展示了强大的零射击推理和泛化能力,在具身推理任务和视觉语言任务中都表现良好。尽管VLMs显著提高了定位能力,但在细粒度语义理解方面存在不足,而细粒度语义理解对于微小物体操作和灵巧操作至关重要。为弥补以上不足,OCI-Robotics模型对VLMs进行微调以预测目标物体的精确位置,在一定程度上缓解了这一缺陷。

(2) 根据外部知识(Extra Knowledge)规划

基础模型通常缺乏特定领域的知识,因此在某些场景中可能会导致任务规划错误,这些额外的知识可以从自我规划(即“内部”)和其他模型(即“外部”)中获得。比如:ClIN模型从失败的规划中学习,递归地将这些见解用于后续规划,直到成功。CAPEAM模型引入了一种环境感知记忆系统,该系统记录对象的历史位置以增强代理交互。LMZSP 模型 通过另一种预训练的基础模型,将大型语言模型(LLMs)的原始任务规划的每一步转换为精确可接受的行动。PLAN模型从外部知识构建注入常识性的提示,作为增强任务规划的外部提示。

(3) 根据反馈规划(Plan with Feedback)

上述方法,如PaLM-E或ViLA,采用初步的一次性规划,而交互式规划在任务执行过程中动态发展。准确地说,基础模型在指令和实时反馈的帮助下预测后续行动,并在每一步之后不断更新它们的规划。典型的反馈包括:1)来自环境的反馈,表明任务完成或行动成功的信号。2)来自人的反馈,包括人机直接交互,作为增强规划能力的直观信号。

2 低级控制的基础模型

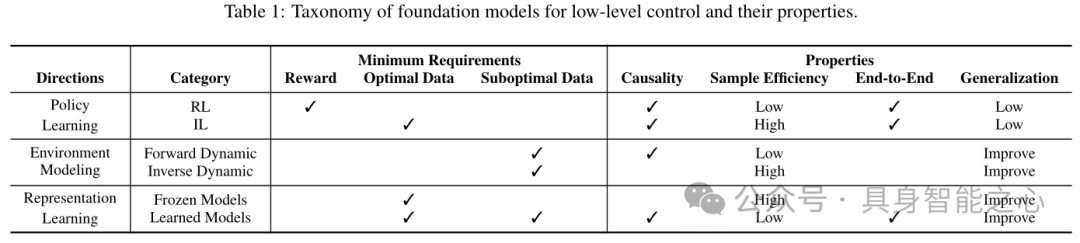

除了利用大型基础模型的分解和规划能力,来帮助机器人对复杂的长期任务进行高级规划外,许多研究还提出利用语言和视觉基础模型的识别、推理和泛化能力来生成精确的低级控制。机器人低级控制的最终目标是学习一种策略来输出目标关节位置。从学习过程中关注的不同模块的角度,文章将这些方法分为三类:(2.1)策略学习。(2.2)环境建模。(2.3)表征学习。

2.1 策略学习

策略学习通常分为以下两类:(1)强化学习、(2)模仿学习。

(1) 强化学习(Reinforcement Learning,RL)

强化学习问题通常使用马尔可夫决策过程(MDP)进行表述。马尔可夫决策过程(Markov Decision Process,MDP)假设智能体(agent)处在一个环境中,每个状态是智能体对当前环境的感知。智能体只能通过执行动作来影响环境,而环境则根据一定的概率分布转移到新的状态,并反馈给智能体一个奖赏。

强化学习是机器学习的一种范式和方法论,旨在通过智能体(agent)与环境的交互来学习策略,以最大化累积奖励或实现特定目标。与监督学习和无监督学习不同,强化学习不需要显式地提供输入/输出对或未标记的数据集,而是通过试错的方式学习。强化学习在现实世界应用中的一个主要挑战是如何进行奖励塑造,即强化学习需要精心设计奖励函数才能学习。因此,许多最新研究将注意力转向利用大型基础模型中包含的各种任务的知识和理解来提供奖励,从而减少繁重的人工参与。比如,L2R模型提出将奖励函数作为语言指令与低级动作之间的桥梁,并探索利用大型语言模型(LLMs)的代码生成能力将任务描述转换为奖励函数。

另一个重要挑战在于强化学习方法的低样本效率。最近,许多研究表明,基础模型可以通过向学习过程注入从互联网规模数据中学习到的更多先验知识,从而大大加速上述技术的发展。例如,FRL模型提出了一个基础强化学习框架,并实例化了一个演员-评论家方法FAC,该方法利用基础模型中的价值、奖励和策略先验知识来实现样本高效学习、对噪声先验的鲁棒性以及最小化人工干预。此外,可以在视觉和语言领域使用带有Transformer架构的膨胀互联网规模数据,如Q-Transformer使用Transformer架构学习Q函数和多任务策略的设计决策,这些决策基于大规模离线数据集。

(2) 模仿学习(Imitation Learning)

在模仿学习中,智能体(agent)通过观察专家的行为(即“演示”或“示范”)来学习如何执行任务。这些专家演示通常包含了一系列状态-动作对,展示了在给定任务中如何做出最优或接近最优的决策。模仿学习的目标是让智能体能够学会一个策略,该策略能够复现专家的行为,从而在新的、未见过的情境下也能表现出良好的性能。

模仿学习(IL)与强化学习(RL)的区别在于提供了专家演示,但奖励函数是未知的。模仿学习的目标是恢复(或尽可能接近)专家的策略,以便在新的状态下也能实现较高的奖励或任务成功率。由于专家演示的分布通常较窄,主要问题是存在累积误差,且学习到的策略的泛化能力较差。受大型语言模型(LLMs)和视觉语言模型(VLMs)通过大量数据训练在开放世界中实现强大零样本性能的启发,一种直观且直接的方法是将这种模式扩展到具身人工智能(embodied AI),并使用大规模的机器人数据来训练高能力的策略。

3.2 环境建模

除了直接从演示或与环境交互中学习策略外,学习环境(世界)模型也很重要,该模型可以与其他算法(如强化学习和轨迹优化)结合使用,以生成更好的策略。

(1) 前向动态学习

前向动态学习基于当前或历史观测和动作预测下一状态。这一学习目标结合了因果关系的本质,因为下一状态是当前状态下执行动作的结果。因此,它能够有效模拟环境,包含物理规则。但代价是构建准确的动态模型既困难又需要大量数据。如SWIM模型在高层次的抽象和结构化动作空间中学习,即预测目标姿态和路径点。随后,可以在无监督的方式下使用一小部分机器人数据对模型进行微调,这既不需要奖励函数也不需要与任务相关的监督。

(2) 逆向动态学习

逆向动态学习旨在以当前状态和下一状态作为输入来预测动作。由于它利用未来的信息来恢复过去的行为,因此它是非因果的。因此,这种学习方法降低了训练的难度,并且不像正向动态学习那样需要大量的数据。Brandfonbrener等人在多个领域的机器人操作任务上进行了广泛的实验,实验结果表明:1)当从零开始学习时,学习逆动态可以比其他预训练目标表现得更好;2)与正向动态目标相比,逆动态学习可以提取出更平滑、更具辨别力的表示,且样本效率更高。

3.3 表征学习

利用大规模互联网数据训练的视觉和语言基础模型可以提取出对图像和文本指令有益的表征,为下游的具身AI任务提供了坚实的基础。此外,它们还能够与文本的特征相匹配。遵循这一思路,许多研究将大型语言模型(LLMs)和视觉语言模型(VLMs)作为固定的表征提取器,并建立了一个组合流程:

(1) 冻结基础模型

最直接的方法之一是冻结基础模型,将大型模型作为某些特定功能(如目标检测、语义分割和目标跟踪)的只读组件使用。例如,SMS模型通过使用开放词汇对象检测模型,它能够识别当前场景中的对象,并结合大型语言模型(LLMs),明确构建场景的语义占用分布作为特征。

(2) 学习控制模型

许多工作建议使用如无监督学习、自监督学习和迁移学习等方法,来从机器人数据中提取描述性和可理解的表示。如DualMind提出了一种类似的两阶段学习策略,用于学习一种能够处理多个决策任务的通用策略:在第一阶段,策略以自监督的方式进行训练,以学习世界中的潜在通用知识。随后,在第二阶段,使用参数的一小部分来基于多模态提示训练条件策略。该方法采用编码器-解码器Transformer架构,结合Token-Leaner和交叉注意力机制,以增强特征提取能力。

3 数据集、模拟器和基准测试

此外,文章还展示了基础模型常用的数据集、模拟器和基准测试。

3.1 数据集

与强调抽象、二维和基于网络信息的视觉和语言数据集相比,具身智能的数据集更注重现实世界环境中的三维信息、对象的可用性,以及机器人与对象之间的交互,这些都基于现实世界物理定律的约束。文章将具身智能的数据集分为三类,包括对象数据集、人类数据集和机器人数据集。

(1)对象数据集:对象数据集通常包含大量合成或真实扫描的物品及其对应的标签,包括类别、网格、点云等。这些数据集可用于各种下游任务,包括机器人环境构建、感知、新视图合成、对象重建、对象生成和机器人操作任务。

(2)人类数据集:人类数据集通常以视频的形式存在,包含在不同环境和场景下从第一人称或第三人称视角进行活动的人,从在厨房做家务到在户外骑自行车。它们包含关于物体和环境的外观、人与物体的交互,以及运动和动态中嵌入的物理规则的真实世界信息,如果这些知识能够成功转移到智能体上,那么对具身智能将非常有益。

(3)机器人数据集:机器人数据集包含直接控制机器人在现实世界或模拟器中执行任务的演示,收集方法多种多样,如远程操作设备、预训练智能体等。然而,这些收集过程既耗时又费力,例如设置机器人执行任务的环境,以及教授操作人员使用相关设备。这导致很难将机器人数据集扩展到非常大的规模,这是具身智能面临的一个挑战。

3.2 模拟器

在具身智能领域,高保真模拟器对于高效训练和缩小模拟与现实世界应用之间的差距至关重要。模拟器开发中的关键挑战包括:1)实时软体材料模拟,其中像ManiSkill2这样的高级模拟器使用材料点方法(MPM)来实现比传统方法(如有限元方法FEM)更真实、更复杂的交互;2)支持多个控制器以适应各种任务和控制方法,像ManiSkill2和Nvidia Isaac Sim这样的模拟器为从避障到抓取放置等各种任务提供了动作空间的灵活性;3)处理多个环境并行计算的能力,这对于强化学习中的大规模数据收集和训练至关重要,其中像ManiSkill2和Isaac Gym这样的模拟器在管理众多同时运行的环境方面展示了卓越的计算效率和功能。

3.3 基准测试

为了确保公平的比较,基准测试对于评估各种系统和算法至关重要。两个值得注意的基准测试是FMB,它提供了一个基准测试,用于测试和改进机器人操作技能,如抓取、移动和组装物体,使用3D打印的物品以便于复制和研究;以及ManiSkill2,它提供了一系列20个有针对性的操作任务集合,旨在解决操作技能基准测试中的常见挑战。

4 讨论与未来方向

机器人技术与基础模型的融合探索目前仍处于起步阶段。尽管取得了显著进展,但众多挑战仍阻碍着机器人在现实环境中的实际应用。文章重点讨论了该领域现有的一些挑战以及潜在的未来研究方向:

4.1 规划与控制的协同

当前的具身智能在抓取和放置物体等简单任务上取得了前所未有的成功。然而,对于长期任务(如物体重新排列),仅学习一个策略也非常困难,因为错误会随着步骤的增加而迅速累积。因此,同时学习高级规划和低级控制,并使它们无缝协作至关重要。与在单一大型策略网络中整合规划和控制相比,许多先前的工作研究了如何合理分解复杂任务并有效学习技能。然而,它们仅使用预定义的原始任务(技能),无法推广到新任务,这是机器人在现实应用中成功部署的先决条件。目前,视觉和语言基础模型的发展也为这一方向提供了强大的推动力,例如,使用LLMs进行更合理的规划并扩展技能库。

4.2 基础模型的“幻觉”问题

基础模型的安全性和可靠性,特别是它们倾向于“产生幻觉”或生成误导性信息的问题,已经引起了人们的广泛关注,因为基础模型提供的不准确解释或指令可能导致严重的故障或失败。一个典型的例子是GPT-4V,它有时会在解释图像时包含实际上并不存在的物体。此外,模型需要与物理实体集成,模型的误用可能导致灾难性后果。

4.3 高效数据收集

为了进一步提高大型视觉和语言基础模型的泛化能力,扩大数据集规模可能是最重要的工作之一。目前,机器人数据集的规模远远不及视觉和语言基础模型所使用的规模。目前收集数据的速度,基本上不可能收集到与视觉和语言互联网规模数据集相当规模的机器人数据。(1)Huang等人利用高保真模拟器进行大规模轨迹收集或训练,然后通过Sim2Real方法将智能体部署到实际应用中。然而,模拟器和现实世界之间在外观和内部动态上都存在分布差异,这可能会显著降低性能,而Sim2Real方法无法完全弥补这一差距。(2)另一个解决方案是利用额外的人类活动数据集。这些数据相对容易通过从互联网上下载来收集,并且包含现实世界的观察和动态信息。但是,由于机器人和人类的形态差异很大,因此很难将这些信息与机器人的输入和输出对齐。

4.4 扩充现有数据集

与视觉和语言任务相比,为具身AI任务收集大规模训练数据要困难得多,成本也更高。因此,如何有效地扩充现有的机器人数据集是一个不可回避的问题。(1)一个直接的方法是使用常用的数据增强技术,如修改亮度、翻转、裁剪、注入噪声等,增强图像数据。然而,这些方法可能会破坏图像中的语义信息,从而降低最终性能。(2)最近提出了一种不破坏语义信息的数据增强方法,利用视觉语言模型(VLMs)和大型语言模型(LLMs)进一步提高策略的泛化性能。比如,ROSIE方法将数据增强问题重新表述为图像修复问题,它使用VLMs来描绘图像中与任务相关的区域,并使用最先进的扩散模型Imagen Editor根据文本指令对该区域进行增强。然而,这些方法本质上并没有增加机器人轨迹的数量,这意味着当智能体进入危险或分布外状态时,它仍然不知道如何从错误中恢复。

4.5 计算与部署的效率

无论是训练阶段还是推理阶段,都需要大量的计算资源。在大规模数据集上训练这些庞大的模型需要大量高端GPU。因此,采用诸如LoRA和MiniGPT-4等高效的预训练和微调技术对于降低训练成本至关重要。此外,在资源受限的边缘设备上部署这些大型模型也面临挑战,通过模型压缩技术优化大型模型的计算效率,并设计轻量级模型,对于在边缘设备上实现部署至关重要。

4.6 机器人的安全性和可解释性

在现实世界场景中部署机器人系统,特别是在人口和物体密集的区域,如人机协作或室内环境,确保运行安全至关重要。这涉及到减轻碰撞风险,防止人员受伤和物体损坏。(1)虽然某些方法通过利用李雅普诺夫函数为机器人系统提供理论保障,但它们仅考虑具有低维输入的理想且简单的实验环境,并需要精确的环境建模。然而,对于像图像这样的高维输入的实际应用来说,情况更为复杂。(2)相比之下,其他方法侧重于使用分布外(out-of-distribution, OOD)检测来促进机器人错误的实时识别。然而,这些方法在处理新场景中的泛化挑战以及错误后的恢复策略制定方面仍面临困难,这是当前研究的一个关键领域。

投稿作者为『自动驾驶之心知识星球』特邀嘉宾,欢迎加入交流!重磅,自动驾驶之心科研论文辅导来啦,申博、CCF系列、SCI、EI、毕业论文、比赛辅导等多个方向,欢迎联系我们!

① 全网独家视频课程

BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、大模型与自动驾驶、Nerf、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

网页端官网:www.zdjszx.com

网页端官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

国内最大最专业,近3000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型、端到端等,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

1232

1232

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?