作者 | cvlife.net 编辑 | 计算机视觉life

原文链接:https://www.zhihu.com/question/667652717

点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

本文只做学术分享,如有侵权,联系删文

碰上大雾天气,纯视觉方案是如何识别车辆和障碍物的呢?

作者 小林

如果真的是纯纯的,特头铁的那种纯视觉方案的话。

可以简单粗暴的理解为:人眼不行的,机器也不行。

但是,现下,应该还没有如此100%纯度的纯视觉。

即便头铁如特斯拉,虽然取消的了雷达和超声波传感器。

但是在视觉传感器上疯狂做假发,而且依然保留的一定的冗余,来补上视觉的局限。

更准确的说,不应该叫纯视觉,而应该叫视觉优先。

这样,在大雾天。如果非得开,还能开一开。

优先级最大的摄像头系统,料堆得最满。

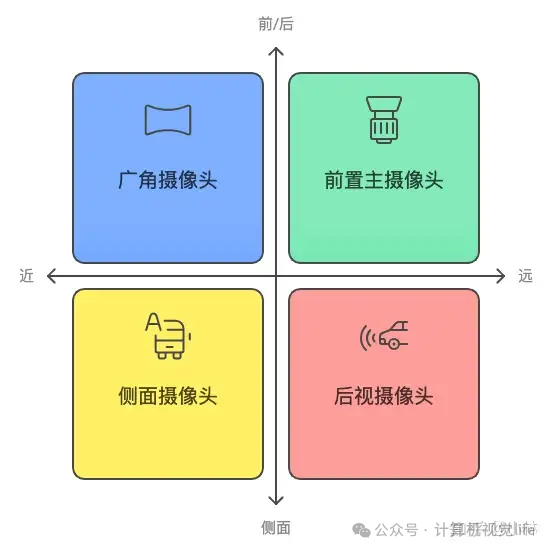

前置主摄像头:

负责捕捉前方远距离的视野,识别车辆、道路标志和路况。

广角摄像头:

捕捉前方的广角视野,尤其适合识别近距离的物体,比如停靠车辆和交叉路口的动态情况。

侧面摄像头:

布置在车辆两侧,用于监控车道变换、盲区检测和周围车辆的动态。后视摄像头:负责监控车辆后方的状况,辅助倒车以及识别后方来车。

基本上,覆盖了所有该看的地方和角度。

然后,在某些瞬间失明或者视力下降的时候,还有一些传感能够暂时提供参考信息。

GPS和高精度地图(GPS & High-Precision Maps):

GPS结合高精度地图数据,车辆能够确定自己的定位,识别出所在道路的限速、地形和路线结构。

惯性测量单元(IMU):

用来感知车辆的姿态、加速度和转向等信息。

这些数据帮助车辆在复杂的驾驶条件下保持平衡,并提供精确的动态反馈。

视觉优先,其实也更接近人类驾驶是的感知-规划-决策-执行的模式。

人虽然大部分的信息摄入来自于眼睛。

但是对于行动的决策判断,还有耳朵听到的,身体发肤感受到的,以及莫名其妙的第六感。

综合起来构筑起一个立体的信息。

视觉优先,今后的路应该不是走摄像头这一根独木桥。应该是如何接近

更像一个人的感知系统

把视觉之外的,哪些信息。

尽量通过不做加法的方式,给逆向仿生出来。

也许,有一天AI真的可以把驾驶这件事也给“暴力破解”了吧。

作者 小a同学

先问个问题,作为一名老司机的您,正常情况下敢在大雾天开车吗?

而纯视觉方案的智能驾驶也是一样的!

最近看到国外媒体做了一个有趣的试验:

用一辆洒水车在前面向跟在后面的车猛烈洒水,干扰其摄像头,然后突然闪开,露出车道上的模拟障碍物。而特斯拉发生了碰撞,这就证实了纯视觉系统的局限性。即确实存在看不见导致来不及反应的时候。

常规遇到这种情形,比如进入雾区或雨区,能见度变差,系统通常会先根据视觉所能观察到的距离适配行驶速度,也就是减速,并提示驾驶者接管车辆。

如果超出报警时间仍无人接管,处理方式与驾驶者长时间方向盘脱手一样————激烈报警和逐渐停车。这是在当前法规仅允许智能驾驶起辅助作用,且厂家不为辅助驾驶时发生的事故承担交通安全的主要法律责任,责任主体依然在驾驶者的情况下。

系统所做的一切操作都旨在尽量保证安全并免除厂商潜在的民事责任。

纯视觉方案,其实更接近人类驾驶是的感知-规划-决策-执行的模式。

人虽然大部分的信息摄入来自于眼睛。

但是对于行动的决策判断,还有耳朵听到的,身体发肤感受到的,以及莫名其妙的第六感。

综合起来构筑起一个立体的信息。

而纯视觉方案今后的路应该也不是走摄像头这一根独木桥。应该是如何接近,更像一个人的感知系统。

目前在纯视觉方案里面,特斯拉的体验是最好的。那么看看特斯拉是如何做的

特斯拉在智能驾驶方面遵循的是一种底线思维模式,也就是试探硬件少得不能再少的底线在哪里。

这就反过来促使研发团队在测试和软件开发上竭尽全力,让软件能力最大化地把硬件的作用发挥出来。

而一些十分特殊的场景,则可以用概率算法去压缩它发生的范围。只要不遇到极端情况,其使用体验就是好的,而且可以保证单车低成本、高利润率。

但这并没有消除“看不见”这个局限性,只是把因此而导致系统完全不能发挥作用的场景压缩到极致的、极少的场景。

对整车厂来说,智能驾驶竞争在软件,不在硬件。因为硬件都是供应商制造的,只要花钱采购都能得到。

而如何应用这些硬件,决定了竞争胜负。

比如击剑比赛,比的不是剑,而是运动员的剑术。特斯拉的策略就是把剑术练到家,方法就是用尽量少,尽量简单的硬件去修炼软件功夫。

当它达到高水平时,再升级装备就会更加显著地体现出竞争优势。而且,可尽量保持硬件上相对更低的成本。

这里要避免一个误解,就是认为特斯拉的智能驾驶就是最强的,放在哪里都最强。事实不是这样的。它在中国的体验效果就不如在美国。

自动驾驶系统非常依赖在使用当地的训练。特斯拉在美国本土的训练要比在中国相对完备得多,因此体验更好,开放使用的功能更深。

作者 周臻

能用,但是不好用。

纯视觉方案的先天不足就是在应对恶劣环境时不好用,在当下智能驾驶只是作为辅助驾驶时,这种缺陷尚且可以克服。但是随着智能驾驶技术成熟,在未来走向无人驾驶的终极目标时,纯视觉的这种先天不足将会成为难以跨越的天堑。这也是我不看好特斯拉FSD的最主要原因。

余承东曾经点评过FSD,认为其“上限很高,下限很低。”我觉得这说到了纯视觉方案的根本缺陷。美国发生的很多FSD导致人员伤亡的案例,也证明了其安全性能不足的问题很严重。

就拿大雾天来说,这是很正常的一种气象,早晚时段都可能起雾。人类在大雾中可以谨慎缓慢行驶来克服,智能驾驶遇到大雾天气,采用谨慎缓行的策略也可以通行,其表现并不会比人类司机更好。人类驾驶员在这种大雾天气容易出现交通事故,纯视觉方案也容易出现交通事故,这就是纯视觉方案下限很低的重要原因。

而加上了激光雷达和毫米波雷达的智能驾驶可以更好地了解周边道路环境,可以看得更远,看得更清楚,即使在大雾中也可以挥洒自如,而且安全性能好得多,其高下优劣一眼可辨。这就是激光雷达方案的智能驾驶下限很高的主要原因。

更何况,智能驾驶要面对的恶劣环境还有很多,暴雨,暴雪,雾霍,烟雾,沙尘暴等恶劣天气都是纯视觉方案难以克服的缺陷,纯视觉方案很难真正摆脱人类驾驶员做到无人驾驶,注定是没有出路的。

作者 车轮上的智慧殿堂

大雾天开车,简直是雾里看花,花里胡哨,让人心里没底。不过,随着技术的发展,特别是自动驾驶技术的进步,即便是在这样的天气条件下,我们的车辆也能做到眼观六路,耳听八方,这背后靠的就是一些高科技的视觉方案。今天咱们就聊聊,这些纯视觉方案是怎么在大雾天识别车辆和障碍物的。

说到底,现在的自动驾驶汽车,特别是那些号称纯视觉方案的家伙,它们就像是拥有了“火眼金晴的孙悟空,即使是在雾气蒙蒙的情况下,也能准确地识别出前方的车辆和其他障碍物。这得归功于一系列先进的算法和技术,比如深度学习、图像处理以及多传感器融合等,它们就像是一套组合拳,让车辆能在复杂环境中稳操胜券。

拿图像去雾算法来说吧,这玩意儿就像是给相机装上了吸尘器,能把图像里的“灰尘”一也就是那些因雾气造成的模糊感,清除得干干净净。这样一来,即使是在大雾弥漫的路上,摄像头捕捉到的画面也会清晰许多,使得后续的目标检测变得更加容易。

当然,图像去雾只是第一步,接下来就是让这些处理过的图像派上用场了。这时候,就得说到YOLO这样的目标检测算法了。YOLO,全名You Only Look Once,听着就像是在说:“看一眼就够了!”这种算法能够一次性处理整张图片,而不是像传统方法那样,先选出可能含有目标的区域再逐一检查。这样不仅速度快,而且在处理动态变化的环境时也更加灵活。举个例子,当一辆车在雾中快速驶来,YOLO能够迅速识别出它的位置,并及时做出反应,确保安全。

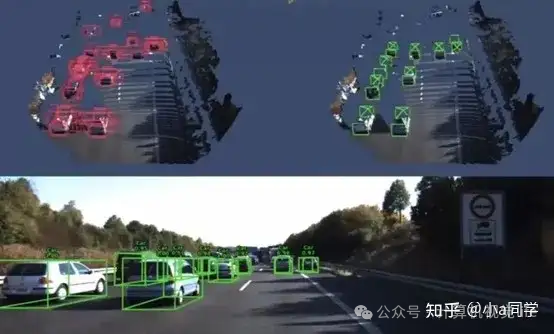

不过,话说回来,虽然YOLO等算法在正常天气下已经相当厉害了,但在恶劣天气中,比如大雾,它们也会遇到挑战。这时候,就轮到多模式传感器融合登场了。简单来说,就是把不同类型的传感器,比如激光雷达(LiDAR)和雷达(RADAR),以及摄像头的信息结合起来,相当于给车辆配备了一套全方位的“感官系统”。激光雷达在短距离内能够提供非常精确的三维信息,而雷达则在远距离探测方面表现出色,尤其是穿透力强,不易受天气影响。这样一来,即便是在大雾中,车辆也能通过这些传感器获取到周围环境的详细信息,再结合视觉数据,使得检测更加准确可靠。

当然,除了硬件设备外,软件算法也在不断进化。比如说,有些团队就在尝试通过深度学习的方法,让车辆学会在不同天气条件下调整自己的'视力”。这就像是给我们的眼睛加上了智能调光功能,无论是在晴天还是雾天,都能自动调节到最佳状态。这样一来,即便是突然遭遇浓雾,车辆也能迅速调整策略,确保行驶安全。

还有一些挺创新的技术,就比如说VESY传感器。它把雾天图像帧的显著性映射和目标检测算法YOLO 的输出融合到了一起,给实时应用提供了一种可行的办法。这种做法就好像是给车辆装上了“夜视仪”似的,就算是在能见度特别低的情况下,也能看清前方的障碍物。

在大雾天气下,纯视觉方案并不是孤立作战,而是通过一系列的算法优化、多传感器信息融合以及硬件升级等多种手段,共同保障了车辆的安全行驶。这就好比是一支乐队,只有各个乐器协调一致,才能演奏出美妙的音乐。同样,只有各项技术紧密配合,才能在复杂环境中确保车辆平稳前行。当然了,尽管技术越来越先进,但毕竟人命关天,在恶劣天气条件下,我们还是要保持警惕,毕竟技术再好,也不能完全替代人的判断力和应急反应能力!

下次遇到大雾天开车,虽然咱们心里可能还是会有些志忑,但至少知道背后有一整套强大的技术支持,让我们的出行更加安心。当然了,安全第一,任何时候都不能放松警惕,毕竟技术虽好,但最终还是人为本!

『自动驾驶之心知识星球』欢迎加入交流!重磅,自动驾驶之心科研论文辅导来啦,申博、CCF系列、SCI、EI、毕业论文、比赛辅导等多个方向,欢迎联系我们!

① 全网独家视频课程

端到端自动驾驶、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

② 国内首个自动驾驶学习社区

国内外最大最专业,近4000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(端到端自动驾驶、世界模型、仿真闭环、2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?