序言

降温,回家休整数日。

各种意义上的降温。

爬完了一座山,以为已经走遍了山河湖海。

其实我们都知道,路还很长,只是那座无法再走回去的山上,留有几分红绿。

上山的人,下山的人。

道阻且长,且行,且珍惜。

文章目录

- 序言

- 20241118

- 20241119

- 20241120

- 20241121

- 20241122

- 20241123

- 20241124

- 20241125

- 20241126

- 20241127

- 20241128

- 20241129

- 20241130

- 20241201

- 20241202

- 20241203

- 20241204

- 20241205

- 20241206

- 20241207

- 20241208(高百总决赛)

- 20241209

- 20241210 :umbrella:

- 20241211 :snowflake:

- 20241212:sunny:

- 20241213:cloud:

- 20241214:sunny:

- 20241215:sunny:(AK破240)

- 20241216:sunny:

- 20241217~20241218:sunny:

- 20241219:cloud:

- 20241220~20241222(完篇)

- 20241223(后记)

- 真·完篇

20241118

pytorch 高维张量 Tensor 维度操作与处理,einops

huggingface中的transformers跟pytorch有所区别,前者是语言建模,后者是纯序列建模

import torch

from torch import nn

import torch.nn.functional as F

import numpy as np

import pandas as pd

d = 4 # 模型维度

B = 2

T = 3

h = 2 # 多头注意力中的头数

ff = 8 # 前馈网络的维度

X = torch.randn(T, B, d) # [seq_len, batch_size, d_model]

X.shape # torch.Size([3, 2, 4])

encoder = nn.TransformerEncoderLayer(d, h, ff, dropout=0.0)

W_in, b_in = encoder.self_attn.in_proj_weight, encoder.self_attn.in_proj_bias

# (3d, d), (3d, )

W_in.shape, b_in.shape # (torch.Size([12, 4]), torch.Size([12]))

encoder(X).shape # torch.Size([3, 2, 4])

1 张量内存

[pytorch] Tensor shape 变化 view 与 reshape(contiguous 的理解))

https://stackoverflow.com/questions/26998223/what-is-the-difference-between-contiguous-and-non-contiguous-arrays

- 张量内存 layout

- 在大多数深度学习框架(如 PyTorch)中,(高维)张量的数据是以一维数组的形式在内存中连续存储的。对于多维张量,其高维结构是通过一维内存数组和步幅(strides)来实现的。

- pytorch 存储顺序(Storage Order)是 Row-major,最后一个维度变化最快。

- Strides(步幅)

- 对于一个形状为

(

D

0

,

D

1

,

D

2

)

(D_0,D_1,D_2)

(D0,D1,D2)(

2*3*4) 的 3D 张量,其步幅计算如下:- stride[2] = 1 \text{stride[2]} = 1 stride[2]=1

- stride[1] = D 2 × stride[2] = D 2 \text{stride[1]} = D_2\times \text{stride[2]}=D_2 stride[1]=D2×stride[2]=D2 (3)

- stride[0] = D 1 × stride[1] = D 1 × D 2 \text{stride[0]} = D_1\times \text{stride[1]}=D_1\times D_2 stride[0]=D1×stride[1]=D1×D2(3*4=12)

- 对于一个形状为

(

D

0

,

D

1

,

D

2

)

(D_0,D_1,D_2)

(D0,D1,D2)(

A = torch.randint(0, 5, (2, 3, 4))

"""

tensor([[[0, 0, 3, 0],

[3, 3, 1, 1],

[0, 3, 1, 4]],

[[1, 1, 0, 2],

[4, 1, 1, 0],

[4, 1, 0, 3]]])

"""

- 当张量在内存中的数据排列不再符合其形状和步幅之间的默认关系时,张量就是非连续的(is not contiguous)。

- 特征:

.is_contiguous()方法返回 False。 - 影响:某些操作在非连续张量上可能性能较差,或者需要额外的内存拷贝。

- 解决方法:使用 .contiguous() 方法,将张量拷贝为内存中连续的版本。

- 特征:

- 什么样的操作会导致内存的不连续

- permute, transpose, view;

- transpose 是 permute 的特例,transpose 只允许交换两个维度。

- permute, transpose, view;

reshape不改变内存中的数据顺序

A = torch.randn(3, 4)

A.shape, A.stride(), A.is_contiguous() # (torch.Size([3, 4]), (4, 1), True)

A = A.transpose(0, 1)

A.shape, A.stride(), A.is_contiguous() # (torch.Size([4, 3]), (1, 4), False)

A = A.contiguous()

A.shape, A.stride(), A.is_contiguous() # (torch.Size([4, 3]), (3, 1), True)

2 view v.s. reshape

- view(类比sql中的概念)

- 不会复制数据:view 创建的是原始张量的一个新的视图,内存数据保持不变,只是重新解释内存中的数据。因为它依赖于张量的内存布局,所以无法对非连续的张量使用。

- 不连续内存,view 时有可能报错;

- reshape: 它会自动处理非连续张量,尽可能返回视图,如果无法返回视图,则会拷贝

- 不要求内存连续:reshape 可以用于非连续的张量。如果张量不连续,reshape 会自动尝试创建一个新的连续张量并复制数据,以确保能够完成形状转换。

- 可能复制数据:当张量是内存不连续的,reshape 可能会进行数据复制,生成一个新的内存布局的张量。否则,它和 view 的行为是一样的,不复制数据。

- 不改变数据在内存中的顺序,只改变张量的形状解释。

A = torch.randn(2, 3, 4)

A.view(-1, 4).shape, A.view(-1, 4).stride(), A.view(-1, 4).is_contiguous(),

# (torch.Size([6, 4]), (4, 1), True)

A = torch.randn(2, 3, 4)

A_t = A.permute(1, 2, 0)

A.stride(), A_t.shape, A_t.stride(), A_t.is_contiguous()

# ((12, 4, 1), torch.Size([3, 4, 2]), (4, 1, 12), False)

3 encoder recap

https://pytorch.org/docs/stable/generated/torch.nn.TransformerEncoderLayer.html

- input:

X

∈

R

T

×

B

×

d

model

\mathbf{X} \in \mathbb{R}^{T \times B \times d_{\text{model}}}

X∈RT×B×dmodel (

batch_first=False) - multihead selfattn

- 线性变换(linear projection, 矩阵乘法)生成 Q、K、V矩阵

- X flat = X . reshape ( T × B , d m o d e l ) X_{\text{flat}}=\mathbf X.\text{reshape}(T\times B,d_{model}) Xflat=X.reshape(T×B,dmodel) (3d -> 2d)

-

Q

K

V

=

X

W

i

n

T

+

b

i

n

\mathbf{QKV}=\mathbf X\mathbf W_{in}^T+\mathbf b_{in}

QKV=XWinT+bin(

encoder_layer.self_attn.in_proj_weight,encoder_layer.self_attn.in_proj_bias)- W i n ∈ R 3 d model × d model \mathbf{W}_{in} \in \mathbb{R}^{3d_{\text{model}} \times d_{\text{model}}} Win∈R3dmodel×dmodel, b i n ∈ R 3 d model \mathbf{b}_{in} \in \mathbb{R}^{3d_{\text{model}}} bin∈R3dmodel

- Q K V ∈ R T × B , 3 d m o d e l \mathbf{QKV}\in \mathbb R^{T\times B,3d_{model}} QKV∈RT×B,3dmodel

- 拆分

Q

,

K

,

V

\mathbf Q, \mathbf K,\mathbf V

Q,K,V

- Q , K , V = split ( Q K V , d m o d e l ) \mathbf Q, \mathbf K,\mathbf V=\text{split}(\mathbf{QKV},d_{model}) Q,K,V=split(QKV,dmodel)(按列进行拆分)

- Q , K , V ∈ R T × B , d model \mathbf Q, \mathbf K,\mathbf V\in \mathbb R^{T \times B, d_{\text{model}}} Q,K,V∈RT×B,dmodel

- 调整形状以适应多头注意力

- d k = d model h d_k = \frac{d_{\text{model}}}h dk=hdmodel (4/2 = 2)

reshape_for_heads

Q heads = Q . reshape ( T , B , h , d k ) . permute ( 1 , 2 , 0 , 3 ) . reshape ( B × h , T , d k ) K heads = K . reshape ( T , B , h , d k ) . permute ( 1 , 2 , 0 , 3 ) . reshape ( B × h , T , d k ) V heads = V . reshape ( T , B , h , d k ) . permute ( 1 , 2 , 0 , 3 ) . reshape ( B × h , T , d k ) \begin{align*} \mathbf{Q}_{\text{heads}} &= \mathbf{Q}.\text{reshape}(T, B, h, d_k).\text{permute}(1, 2, 0, 3).\text{reshape}(B \times h, T, d_k) \\ \mathbf{K}_{\text{heads}} &= \mathbf{K}.\text{reshape}(T, B, h, d_k).\text{permute}(1, 2, 0, 3).\text{reshape}(B \times h, T, d_k) \\ \mathbf{V}_{\text{heads}} &= \mathbf{V}.\text{reshape}(T, B, h, d_k).\text{permute}(1, 2, 0, 3).\text{reshape}(B \times h, T, d_k) \end{align*} QheadsKheadsVheads=Q.reshape(T,B,h,dk).permute(1,2,0,3).reshape(B×h,T,dk)=K.reshape(T,B,h,dk).permute(1,2,0,3).reshape(B×h,T,dk)=V.reshape(T,B,h,dk).permute(1,2,0,3).reshape(B×h,T,dk)

- 计算注意力分数:

Scores

=

Q

heads

K

heads

⊤

d

k

\text{Scores} = \frac{\mathbf{Q}_{\text{heads}} \mathbf{K}_{\text{heads}}^\top}{\sqrt{d_k}}

Scores=dkQheadsKheads⊤

- Q heads ∈ R ( B × h ) × T × d k \mathbf{Q}_{\text{heads}} \in \mathbb{R}^{(B \times h) \times T \times d_k} Qheads∈R(B×h)×T×dk, K heads ⊤ ∈ R ( B × h ) × d k × T \mathbf{K}_{\text{heads}}^\top \in \mathbb{R}^{(B \times h) \times d_k \times T} Kheads⊤∈R(B×h)×dk×T,因此 Scores ∈ R ( B × h ) × T × T \text{Scores} \in \mathbb{R}^{(B \times h) \times T \times T} Scores∈R(B×h)×T×T。

- 计算注意力权重: AttentionWeights = softmax ( Scores ) \text{AttentionWeights}=\text{softmax}(\text{Scores}) AttentionWeights=softmax(Scores)

- 计算注意力输出:

AttentionOutput

=

AttentionWeights

×

V

heads

\text{AttentionOutput}=\text{AttentionWeights}\times{\mathbf V_\text{heads}}

AttentionOutput=AttentionWeights×Vheads

- V heads ∈ R ( B × h ) × T × d k \mathbf{V}_{\text{heads}} \in \mathbb{R}^{(B \times h) \times T \times d_k} Vheads∈R(B×h)×T×dk,因此 AttentionOutput ∈ R ( B × h ) × T × d k \text{AttentionOutput} \in \mathbb{R}^{(B \times h) \times T \times d_k} AttentionOutput∈R(B×h)×T×dk。

- 合并多头输出: AttentionOutput = AttentionOutput . reshape ( B , h , T , d k ) . permute ( 2 , 0 , 1 , 3 ) . reshape ( T , B , d model ) \text{AttentionOutput} = \text{AttentionOutput}.\text{reshape}(B, h, T, d_k).\text{permute}(2, 0, 1, 3).\text{reshape}(T, B, d_{\text{model}}) AttentionOutput=AttentionOutput.reshape(B,h,T,dk).permute(2,0,1,3).reshape(T,B,dmodel)

- 线性变换(linear projection, 矩阵乘法)生成 Q、K、V矩阵

4 qkv, mhsa

X flat = X . reshape ( T × B , d m o d e l ) X_{\text{flat}}=\mathbf X.\text{reshape}(T\times B,d_{model}) Xflat=X.reshape(T×B,dmodel)

X.shape, X

"""

(torch.Size([3, 2, 4]),

tensor([[[ 1.9269, 1.4873, 0.9007, -2.1055],

[ 0.6784, -1.2345, -0.0431, -1.6047]],

[[ 0.3559, -0.6866, -0.4934, 0.2415],

[-1.1109, 0.0915, -2.3169, -0.2168]],

[[-0.3097, -0.3957, 0.8034, -0.6216],

[-0.5920, -0.0631, -0.8286, 0.3309]]]))

"""

X_flat = X.reshape(-1, d)

# (T*B, d)

X_flat.shape # torch.Size([6, 4])

- Q K V = X flat W i n T + b i n \mathbf{QKV}=\mathbf X_{\text{flat}}\mathbf W_{in}^T+\mathbf b_{in} QKV=XflatWinT+bin

QKV = F.linear(X_flat, W_in, b_in)

QKV.shape # torch.Size([6, 12])

Q, K, V = QKV.split(d, dim=1)

Q.shape, K.shape, V.shape # (torch.Size([6, 4]), torch.Size([6, 4]), torch.Size([6, 4]))

# 调整Q、K、V的形状以适应多头注意力

d_k = d // h # 每个头的维度

def reshape_for_heads(x):

# x.shape: (T*B, h*d_k)

# 最末尾的维度上展开,d => h * d_k

# (T*B, h, d_k) => (T, B, h, d_k)

# permute(1, 2, 0, 3) => (B, h, T, d_k)

print(x.shape, x.is_contiguous())

y = x.contiguous().view(T, B, h, d_k).permute(1, 2, 0, 3).reshape(B * h, T, d_k)

print(y.shape)

return y

5 einsum ⇒ eninops

- einsum: 顾名思义,更多是求和约定;不太适合直接做 reshape

from einops import rearrange

Q heads = Q . reshape ( T , B , h , d k ) . permute ( 1 , 2 , 0 , 3 ) . reshape ( B × h , T , d k ) K heads = K . reshape ( T , B , h , d k ) . permute ( 1 , 2 , 0 , 3 ) . reshape ( B × h , T , d k ) V heads = V . reshape ( T , B , h , d k ) . permute ( 1 , 2 , 0 , 3 ) . reshape ( B × h , T , d k ) \begin{align*} \mathbf{Q}_{\text{heads}} &= \mathbf{Q}.\text{reshape}(T, B, h, d_k).\text{permute}(1, 2, 0, 3).\text{reshape}(B \times h, T, d_k) \\ \mathbf{K}_{\text{heads}} &= \mathbf{K}.\text{reshape}(T, B, h, d_k).\text{permute}(1, 2, 0, 3).\text{reshape}(B \times h, T, d_k) \\ \mathbf{V}_{\text{heads}} &= \mathbf{V}.\text{reshape}(T, B, h, d_k).\text{permute}(1, 2, 0, 3).\text{reshape}(B \times h, T, d_k) \end{align*} QheadsKheadsVheads=Q.reshape(T,B,h,dk).permute(1,2,0,3).reshape(B×h,T,dk)=K.reshape(T,B,h,dk).permute(1,2,0,3).reshape(B×h,T,dk)=V.reshape(T,B,h,dk).permute(1,2,0,3).reshape(B×h,T,dk)

Q, K, V = QKV.split(d, dim=1)

# (T*B, h*d_k)

Q.shape, K.shape, V.shape # (torch.Size([6, 4]), torch.Size([6, 4]), torch.Size([6, 4]))

torch.einsum('t b h k->(b h) t k', Q.contiguous().reshape(T, B, h, d_k))

"""

---------------------------------------------------------------------------

RuntimeError Traceback (most recent call last)

Cell In[37], line 1

----> 1 torch.einsum('t b h k->(b h) t k', Q.contiguous().reshape(T, B, h, d_k))

File ~/anaconda3/lib/python3.10/site-packages/torch/functional.py:386, in einsum(*args)

381 return einsum(equation, *_operands)

383 if len(operands) <= 2 or not opt_einsum.enabled:

384 # the path for contracting 0 or 1 time(s) is already optimized

385 # or the user has disabled using opt_einsum

--> 386 return _VF.einsum(equation, operands) # type: ignore[attr-defined]

388 path = None

389 if opt_einsum.is_available():

RuntimeError: einsum(): invalid subscript given at index 9 in the equation string, subscripts must be in [a-zA-Z]

"""

其他一些使用案例:

rearrange(Q, '(T B) (h d_k) -> T B h d_k', T=T, B=B, h=h, d_k=d_k)

rearrange(Q, '(T B) (h d_k) -> B h T d_k', T=T, B=B, h=h, d_k=d_k)

rearrange(rearrange(Q, '(T B) (h d_k) -> B h T d_k', T=T, B=B, h=h, d_k=d_k), 'B h T d_k -> (B h) T d_k', T=T, B=B, h=h, d_k=d_k)

rearrange(Q, '(T B) (h d_k) -> (B h) T d_k', T=T, B=B, h=h, d_k=d_k)

20241119

上海降温,扬州就更冷了。一年这么快就又过去了,又到了这个季节。

宅了两天,只昨天出过一次门,这次主要是大腿太疼了,到今天都还是酸痛。脚其实不太清楚有没有肌肉疲劳,因为没走什么路,感受不出来,感觉这次脚上应该是没出什么问题。

总之南马确实办得很好,赛道设计很走心,沿途风景非常好,各方面都不输无锡。我想还是会破三的,我确信自己有这个实力,可能就在毕业之前,也可能在很久以后,或许再也不会到来。

另外,老爹老娘这次来唯一的作用就是帮我把房退了,早上没陪我去起点,跑完也没开车去终点接我,还得我自己坐地铁几十公里回去,虽然本也是说好就这样的,毕竟交通管制,车确实也不太好开,但还是显得草率了些。谁知道呢,这世界本来也就是个草台班子,人为赋予了些意义罢了,只是缺少这些虚无缥缈,也未免是太单调了。

PS:成绩证书出来了,排名3000多,前15%,太菜了,虽然好汉不提当年勇,但上半年扬马我可是能排到前1%的。另外,证书附带24张照片以及一段纪录片,30K之后全是痛苦面具,不忍直视,不过我找到了那个南师大小姐姐的照片,赛道上没看清脸,是真的又美又有实力,人家表情管理就超到位。

einops库杂记

https://einops.rocks/1-einops-basics/

快速开始

einops(Einstein Operations)提供了一种语法来便捷地操纵张量。einops 支持大多数张量库(当然包括 numpy 和 pytorch)。einops 针对所有张量库的语法都完全一致。einops 不会影响反向传播的正常进行。这些特性意味着 einops 可以和现有的深度学习框架和代码库无缝集成。

如果要跟着下面的步骤实操,需要先下载test_images.npy文件(可以从 einops 的 GitHub 仓库下载到,但是现在好像不行了),再将以下代码粘贴进一个util.py文件:

import numpy as np

from PIL.Image import fromarray

from IPython import get_ipython

def display_np_arrays_as_images():

def np_to_png(a):

if 2 <= len(a.shape) <= 3:

return fromarray(np.array(np.clip(a, 0, 1) * 255, dtype='uint8'))._repr_png_()

else:

return fromarray(np.zeros([1, 1], dtype='uint8'))._repr_png_()

def np_to_text(obj, p, cycle):

if len(obj.shape) < 2:

print(repr(obj))

if 2 <= len(obj.shape) <= 3:

pass

else:

print('<array of shape {}>'.format(obj.shape))

get_ipython().display_formatter.formatters['image/png'].for_type(np.ndarray, np_to_png)

get_ipython().display_formatter.formatters['text/plain'].for_type(np.ndarray, np_to_text)

from IPython.display import display_html

_style_inline = """<style>

.einops-answer {

color: transparent;

padding: 5px 15px;

background-color: #def;

}

.einops-answer:hover { color: blue; }

</style>

"""

def guess(x):

display_html(

_style_inline

+ "<h4>Answer is: <span class='einops-answer'>{x}</span> (hover to see)</h4>".format(x=tuple(x)),

raw=True)

在与util.py同级的目录中创建 Notebook,然后先执行以下代码段:

from utils import display_np_arrays_as_images

display_np_arrays_as_images()

这会将 numpy 的数组转换成图片显示出来。

比如:

ims = numpy.load('./resources/test_images.npy', allow_pickle=False)

# 有 6 张 96x96、带有 3 个色彩通道的图片,打包进同一个张量

print(ims.shape, ims.dtype) # (6, 96, 96, 3) float64

这是ims[0]:

这是 ims[1]:

常用的方法

重排rearrange

from einops import rearrange

# 交换 height 和 width 的顺序

rearrange(ims[0], 'h w c -> w h c')

组合图片(将加载的张量转换为一整张图片:)

rearrange(ims, 'b h w c -> (b h) w c')

横向组合:

rearrange(ims, 'b h w c -> h (b w) c')

可以组合多个维度,比如rearrange(ims, 'b h w c -> (b h w c)').shape # (165888,)

20241120

只进不出撑得慌,晚饭前出去摇了5K@504,感觉不算太差,主要是大腿疼,脚确实是没啥问题,把伤痛越跑越好了属于是。

熬点东西出来呗。

PS:旧电脑里还是放了点东西的,丢了有点可惜,而且微信聊天记录全丢了,可能跟过去割裂一下也没啥不好的。

einops杂记(二)

对应组合,也可以分解:

rearrange(ims, '(b1 b2) h w c -> (b2 h) (b1 w) c ', b1=2)

同时可以将两者结合:

rearrange(ims, '(b1 b2) h w c -> (b1 h) (b2 w) c ', b1=2)

另一个例子:

rearrange(ims, '(b1 b2) h w c -> (b2 h) (b1 w) c ', b1=2)

下面的操作将每张图的高度加倍,宽度减半:

rearrange(ims, 'b h (w w2) c -> (h w2) (b w) c', w2=2)

也可以横向拉伸:

rearrange(ims, 'b (h h2) w c -> h (b w h2) c', h2=2)

纵向拉伸:

rearrange(ims, 'b (h h2) w c -> (b h) (w h2) c', h2=2)

重点注意坐标轴的顺序:

比较下面两种操作的结果:

rearrange(ims, 'b h w c -> h (b w) c')

rearrange(ims, 'b h w c -> h (w b) c')

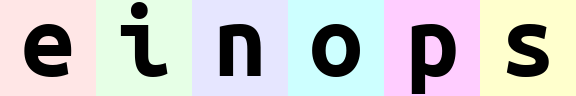

就像一串数字一样,最左侧的数字(最高位)是最重要的。einops 在组合时会先从低位(右侧)排列,排列完低位后再排列高位。对于上面的例子:

(b w)表示在水平方向上先排列w(表示每张图的所有水平像素),再排列b(表示每张图本身)。于是图片会一张一张地排出来。(w b)表示在水平方向上先排列b,再排列w。于是会先顺序排出e、i、n、o、p、s各自的第一列像素,然后排第二列,如此重复。

再看一个例子:

rearrange(ims, '(b1 b2) h w c -> h (b1 b2 w) c ', b1=2) # 输出 'einops'

rearrange(ims, '(b1 b2) h w c -> h (b2 b1 w) c ', b1=2) # 输出 'eoipns'

以上两行代码都将 w 放在最右侧,在输出水平方向的像素时,总是排完一张图,再排下一张。不同的是 b1 和 b2 的顺序。解构的模式是 (b1 b2),其中 b1=2,那么可以想象将原先的 b=6 重排成了一个 2×32×3 的矩阵:

- 第一行代码是先排列

b2(因为它在b1右边),再排列b1,而这与前面解构出的顺序是一致的,于是- 先固定

b1为第一行,输出该行的所有元素(ein) - 然后固定

b1为第二行,输出该行的所有元素(ops)

- 先固定

- 而第二行代码是先排列

b1,再排列b2,于是- 先固定

b2为第一列,然后输出该列的所有元素(eo) - 然后固定

b2为第二列,然后输出该列的所有元素(ip) - 然后固定

b2为第三列,然后输出该列的所有元素(ns)

- 先固定

20241121

- 好天气,好舒服。

堆叠和拼接张量

einops 还可以处理 list。将 ims 转换为一个 list:x = list(ims)

此时 x 是一个带有 6 个元素的 list,每个元素是一个 numpy.ndarray,对应一个字母的图片。当用 einops 处理 x 时,输入的第一个维度是 list 本身的维度,对于 x,就是原先的 b。

堆叠张量:

rearrange(x, 'b h w c -> h w c b')

# 等价于

numpy.stack(x, axis=3)

拼接张量:

rearrange(x, 'b h w c -> h (b w) c')

# 等价于

numpy.concatenate(x, axis=1)

增加和删除轴

可以通过在输入中写 1 来减少轴,也可以通过在输出中写 1 来增加轴。(unsqueeze)

x = rearrange(ims, 'b h w c -> b 1 h w 1 c') # 类似 numpy.expand_dims

print(x.shape)

print(rearrange(x, 'b 1 h w 1 c -> b h w c').shape) # 类似 numpy.squeeze

输出:

(6, 1, 96, 96, 1, 3)

(6, 96, 96, 3)

下面的代码将在 h 和 w 方向上分别取 b 和 c 的最大值,形成一个 (6, 1, 1, 3) 的张量:

reduce(ims, 'b h w c -> b () () c', 'max')

reduce操作

如果要在某个轴的方向上求平均,传统的写法是x.mean(-1)

但是这种代码可读性不佳。如果缺乏经验,那么我们难以立即知道 -1 指的是哪个轴。

在 einops 中,上面的代码可以写成:

reduce(x, 'b h w c -> b h w', 'mean')

如果某个轴在输入中出现,但在输出中没有出现,那么这个轴就是被执行 reduce 操作的轴。在上面的例子中,轴 c 被执行了求平均值操作。

在 batch 轴上执行求平均值操作:

# 等价于 ims.mean(axis=0)

reduce(ims, 'b h w c -> h w c', 'mean')

# 也等价于 reduce(ims, 'b h w c -> h w', 'mean')

有如下几种 reduce 操作:

mean求平均值min求最小值max求最大值sum求和prod求乘积

einops 的语法允许我们设计池化操作。下面的代码执行了 2×2 平均池化:

reduce(ims, 'b (h h2) (w w2) c -> h (b w) c', 'mean', h2=2, w2=2)

当然,这张图片的长和宽都减半了。

2×22×2 最大池化:

reduce(ims, 'b (h h2) (w w2) c -> h (b w) c', 'max', h2=2, w2=2)

相比平均池化,最大池化没有那么平滑。

另一个例子:

reduce(ims, '(b1 b2) h w c -> (b2 h) (b1 w)', 'mean', b1=2)

20241122

嘴上说跑步的热情被浇灭了,这周一下子又疯得不行,估计是12.8镇江南山将至,家门口的比赛估计还是想好好跑一下的。

嘉伟在健身房黑练了一个多星期,跑步机5k完成大PB,16分17秒,差7秒达二级。其实这才是嘉伟真正的实力,以前他就是PB如喝水,说实话校运会那天他如果是认真跑,以那种天气和氛围,大概率也是能进17分的。

简单总结一下嘉伟神勇的历史:

21年9月入学,在田径队5000米测试中,最后半圈落后一哥WXY超过50米,完成绝杀,令人瞠目结舌,高百10K首秀44分06秒。

22年11月,场地测试5000米18分16PB(那天晚上我跟另一个人轮流带他1000米,他告诉我前一天跑步机跑了37分半,我都不敢相信,因为在那之前他的PB是一个月前高百跑出来的39分45秒),然后在12月的市运会,又跑出1500米4分40秒跟800米2分11的PB(雨战)。

23年上半年,4月上半马1小时24分29秒PB(这也是我目前唯一还能吹的,就是我的半马PB要比嘉伟快25秒),不过以嘉伟去年的表现,他半马至少应该是120以内的水平。

23年下半年,9月嘉伟在129测试赛中跑出17分46的5000米PB,紧接着10月闻泰安世10K36分25秒PB,然后11月11日高百10K36分33秒,11月26日首马破三(2:59:15),12月上旬市运会,再次5000米17分02PB,1500米4分39PB

24年上半年因为锡马跑崩受伤(342),以至于上半马也没跑好(128),消沉了很长时间,到下半年,NIKE校园精英接力赛也跑崩,加上紧张的日程,缺少训练,高百也没有跑出特别惊艳的成绩,嘉伟似乎真的已经不行了。结果,校运会1500米4分36秒PB拿捏白辉龙,5000米17分44秒拿捏小崔。

如今,那个PB如喝水的嘉伟又回来了。

PS:想想跟天赋怪真没法比,就嘉伟这男默女泪的大长腿,练一辈子也赶不上… 今天晚饭后慢跑半个小时,感觉身体已经完全恢复,没有明显的伤痛,确是一件好事。其实我不想再认真训练。嘉伟明年上半年大概率是要再跑一次全马的,之前他说是想去芜湖,觉得机场一马平川没有爬升很好跑,或许到时候再陪他跑一回吧。

做了个小玩意儿,最近不务正业了几天,学了点laya air3和unity的东西,看完觉得太好玩了,但是这几年游戏产业形势挺好,但是游戏策划是一顶一的一个没码,主要是想看看这种在canvas上画出来的H5页游应该怎么抓包和脚本自动化。小组件其实都能抓得到,都是在一张大图上割出来的,但是具体的位置,动画效果的捕捉就不太好搞了。

- .atlas文件里保存的是大贴图上各个小贴图所在的坐标及尺寸

- 皮肤图片来自:如https://web.sanguosha.com/10/pc/res/assets/runtime/general/big/static/542803.png,修改编号可以找到很多皮肤

- .sk或者.skel文件是骨骼文件,大多是一些动图,不仅是皮肤,包括UI上的一些动态元素

selenium确实无法定位canvas上的元素,除非扒JS看每个元素的位置。一些动态元素的点击,似乎没有什么特别好的办法,我其实不是特别懂,是不是后端会保存一个前端canvas的快照,这样每次点击的时候其实逻辑处理都在后端,所以前端并不能找到,而且H5页游经常出现一种情况,就是点击元素,没有反应,可能就是前后端快照不一致?瞎猜的。

总之可以用笨方法,就是自己先点一遍,然后让按键精灵记下来操作次序,然后模拟即可。下面是一个这种思路的脚本:

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@stu.sufe.edu.cn

import time

import logging

from pynput import mouse, keyboard

# Initialize a logger

def initialize_logger(file_path, mode = 'w'):

logger = logging.getLogger()

logger.setLevel(logging.DEBUG)

formatter = logging.Formatter("%(asctime)s | %(filename)s | %(levelname)s | %(message)s")

file_handler = logging.FileHandler(file_path, mode=mode, encoding="utf8")

file_handler.setFormatter(formatter)

logger.addHandler(file_handler)

console = logging.StreamHandler()

console.setLevel(logging.INFO)

console.setFormatter(formatter)

logger.addHandler(console)

return logger

# Terminate the given logger

def terminate_logger(logger):

for handler in logger.handlers[:]:

logger.removeHandler(handler)

# Operate manually

def rubbing(rubbing_path = "./rubbing.log"):

def _on_move(x, y):

logging.info(f"move to ({x}, {y})")

def _on_click(x, y, button, pressed):

logging.info(f'{"press" if pressed else "release"} {button} at ({x}, {y})')

def _on_scroll(x, y, dx, dy):

logging.info(f"scroll at ({x}, {y}) by [{dx}, {dy}]")

logger = initialize_logger(rubbing_path, 'w')

with mouse.Listener(on_move=_on_move, on_click=_on_click, on_scroll=_on_scroll) as listener:

listener.join()

terminate_logger(logger)

# Simulate the action by rubbing

def printing(rubbing_path = "./rubbing.log"):

with open(rubbing_path, 'r', encoding="utf8") as f:

lines = f.read().splitlines()

mouse_controller = mouse.Controller()

for line in lines:

asctime, filename, levelname, message = line.split('|')

asctime, filename, levelname, message = asctime.strip(), filename.strip(), levelname.strip(), message.strip()

left = message.find('(')

right = message.find(')')

x, y = message[left + 1: right].split(', ')

x, y = int(x), int(y)

pos = mouse_controller.position

mouse_controller.move(x - pos[0], y - pos[1])

if message.startswith("move"):

pass

elif message.startswith("press"):

if "Button.left" in message:

mouse_controller.press(mouse.Button.left)

elif "Button.right" in message:

mouse_controller.press(mouse.Button.right)

else:

assert False, f"Unknown press operation: {message}"

elif message.startswith("release"):

if "Button.left" in message:

mouse_controller.click(mouse.Button.left)

elif "Button.right" in message:

mouse_controller.click(mouse.Button.right)

else:

assert False, f"Unknown release operation: {message}"

elif message.startswith("scroll"):

left = message.find('[')

right = message.find(']')

dx, dy = message[left + 1: right].split(', ')

dx, dy = int(dx), int(dy)

mouse_controller.scroll(dx, dy)

else:

assert False, f"Unknown message: {message}"

time.sleep(.001)

# Simulate the action by rubbing (easy)

def printing(rubbing_path = "./rubbing.log"):

with open(rubbing_path, 'r', encoding="utf8") as f:

lines = f.read().splitlines()

mouse_controller = mouse.Controller()

for line in lines:

asctime, filename, levelname, message = line.split('|')

asctime, filename, levelname, message = asctime.strip(), filename.strip(), levelname.strip(), message.strip()

if message.startswith("move") or message.startswith("release"):

time.sleep(.01)

continue

left = message.find('(')

right = message.find(')')

x, y = message[left + 1: right].split(', ')

x, y = int(x), int(y)

pos = mouse_controller.position

mouse_controller.move(x - pos[0], y - pos[1])

if message.startswith("press"):

if "Button.left" in message:

mouse_controller.click(mouse.Button.left)

time.sleep(.3)

elif "Button.right" in message:

mouse_controller.click(mouse.Button.right)

time.sleep(1)

else:

assert False, f"Unknown press operation: {message}"

continue

elif message.startswith("scroll"):

left = message.find('[')

right = message.find(']')

dx, dy = message[left + 1: right].split(', ')

dx, dy = int(dx), int(dy)

mouse_controller.scroll(dx, dy)

else:

assert False, f"Unknown message: {message}"

if __name__ == "__main__":

time.sleep(3)

# rubbing()

printing()

rubbing就是拓印,将操作拓印到日志中,然后printing就是根据拓印的日志来印刷操作,上一个printing控制不好间隔,容易出错,下面一个个性化地调了一下间隔,比较容易成功,主要是一些双击的操作对间隔有要求。键盘类似,但需要把键位映射一下。

def keyboard_listener():

def _on_press(key):

info = f'press key {key}'

logging.info(info)

def _on_release(key):

info = f'release key {key}'

logging.info(info)

with keyboard.Listener(on_press=_on_press, on_release=_on_release) as listener:

listener.join()

20241123

返沪,元气基本恢复。上海天气出奇的好,可惜下周大降温,凛冬将至。

骑上车才发现自己左膝盖疼,但不是一直疼,就是有时候突然来一下狠的,一整圈都疼。

晚上常规30箭步×8组(+20kg),发现是膝盖连接大腿前侧的那个点在疼,不是髌骨,说起来膝盖也几百年没疼过了,主要原因还是南马跑的时候左脚落地一直很别扭,后跟不稳,总觉得要往内崴下来,就很刻意地左脚外侧着地,避免向内崴伤,最后就这么全程别扭地跑下来也挺神奇的。

本来后跟跑也确实伤膝盖,没辙,不过应该问题不大,最近休息得也很充分了。力量训练后断断续续慢跑了3K多,LZR和韬哥在,晚上去蜀地源放纵了一下,撑得很,虽然本来也不太想跑,就这么养生也挺好的,跟刚开始跑步的时候一样的水平,返璞归真。

PS:今天小崔一个人又刷了30个400米,圈速1’15"-1’20",间歇60-90秒,现在的小朋友是真的越来越疯狂了,年轻耐造就是好。

基于LangGraph 实现 Reflexion Agent(generator vs. critic)

参考资料:https://blog.langchain.dev/reflection-agents/

相关的几篇论文

Agentic Reasoning Design Patterns

- Reflection 反思

Self-Refine: lterative Refinement with Sel.Feedback, Madaan et al. (2023)*Reflexion: Language Agents with Verbal Reinforcement Learing, Shinn et al., (2023) - Tool use 工具使用(目前主流的几个大模型都已经提供了工具调用,即函数调用的功能)

.Gorilla: Large Language Model Connected with Massive APis, Patil et al. (2023).MM-REACT: Prompting ChatGPT for Multimodal Reasoning and Action, Yang et al. (2023) - Planning(即思路)

Chain-of.Thought Prompting Elicits Reasoning in large Language Models, Wei et al. (2022) HuggingGPT: Solving Al Tasks with ChatGPT and its Friends in Hugging Face, Shen et al. (2023

4.Multi-agent collaboration(多智能体协同)

Communicative Agents for Software Development, Qlan et al… (2023)AutoGen: Enabling Next-Gen LLM Applications via Multi.Agent Conversation, Wu et al. (2023)

一些理解:

- prompt engineering

- 重在结构,structure/workflow/pipeline 的设计,而不只是措辞上;

- reflexion agent: https://arxiv.org/abs/2303.11366

- role design

- generator(student) & critic(teacher)

- reflect on and critique its past actions,

- sometimes incorporating additional external information such as tool observations.

- execution

- role design

- “System 1” vs. “System 2” thinking,

- where System 1 is reactive or instinctive (fast thinking)

- 直觉的本能反应

- System 2 is more methodical and reflective (slow thinking)

- o1,learned implicit reasoing

- reflection can help LLM systems break out of purely System 1 “thinking” patterns and closer to something exhibiting System 2-like behavior.

- where System 1 is reactive or instinctive (fast thinking)

- reflexion agent

- 本质是对 messages 的操作和管理(左右互搏)

- generator vs. reflector

- 对于 generator 的输出,ai message(assistant),对于 reflector 则是 human message(user)

- 反之对于 reflector 的输出,ai message(assistant),对于 generator 则是 human message(user)

- generator vs. reflector

- 本质是对 messages 的操作和管理(左右互搏)

一个基础的反思:

from dotenv import load_dotenv

assert load_dotenv()

第一步是生成

ChatPromptTemplate实例化之后是ChatPromptValue.stream()而非.invoke(),长文的输出就显得没有那么耗时;- system prompt 不属于 messages

- messages 意味着是对话式的,一问一答的方式;

from langchain_core.messages import AIMessage, BaseMessage, HumanMessage

from langchain_core.prompts import ChatPromptTemplate, MessagesPlaceholder

from langchain_openai import ChatOpenAI

prompt = ChatPromptTemplate.from_messages(

[

(

"system",

"You are an essay assistant tasked with writing excellent 5-paragraph essays."

" Generate the best essay possible for the user's request."

" If the user provides critique, respond with a revised version of your previous attempts.",

),

MessagesPlaceholder(variable_name="messages"),

]

)

prompt.pretty_print()

输出结果:

================================ System Message ================================

You are an essay assistant tasked with writing excellent 5-paragraph essays. Generate the best essay possible for the user's request. If the user provides critique, respond with a revised version of your previous attempts.

============================= Messages Placeholder =============================

{messages}

然后调用模型,串联prompt:

llm = ChatOpenAI(model='gpt-4o-2024-08-06')

generate = prompt | llm

prompt.invoke({'messages': [('human', 'write an essay on why the little prince is relevant in modern childhood')]}) # ChatPromptValue(messages=[SystemMessage(content="You are an essay assistant tasked with writing excellent 5-paragraph essays. Generate the best essay possible for the user's request. If the user provides critique, respond with a revised version of your previous attempts.", additional_kwargs={}, response_metadata={}), HumanMessage(content='write an essay on why the little prince is relevant in modern childhood', additional_kwargs={}, response_metadata={})])

prompt.invoke({'messages': [HumanMessage(content='write an essay on why the little prince is relevant in modern childhood')]}) # ChatPromptValue(messages=[SystemMessage(content="You are an essay assistant tasked with writing excellent 5-paragraph essays. Generate the best essay possible for the user's request. If the user provides critique, respond with a revised version of your previous attempts.", additional_kwargs={}, response_metadata={}), HumanMessage(content='write an essay on why the little prince is relevant in modern childhood', additional_kwargs={}, response_metadata={})])

resp = generate.invoke({'messages':

[HumanMessage(content='write an essay on why the little prince is relevant in modern childhood')]})

print(resp.content)

输出模型响应:

Antoine de Saint-Exupéry's "The Little Prince" is a timeless tale that continues to resonate with readers of all ages, especially children. While the book was first published in 1943, its themes remain pertinent in today's rapidly changing world. The story's exploration of imagination, the value of relationships, and the critique of adult behavior offers vital life lessons that modern children can benefit from. This essay will delve into these aspects, illustrating why "The Little Prince" is relevant in contemporary childhood.

Firstly, "The Little Prince" celebrates the boundless creativity and imagination inherent in children. In today's digital age, where structured activities and screen time often dominate, the book serves as a reminder of the importance of nurturing a child's imagination. The protagonist's journey across various planets and encounters with whimsical characters like the fox and the talking rose encourage children to think beyond the confines of their everyday experiences. This imaginative exploration fosters creativity, which is crucial for problem-solving and innovation, skills increasingly prioritized in the modern world.

Secondly, the story underscores the significance of relationships and emotional intelligence, areas often overlooked in modern childhood. The Little Prince's interactions emphasize understanding, empathy, and the invisible bonds that connect individuals. In a time when social media can sometimes replace face-to-face interactions, these lessons are invaluable. The prince's relationship with the fox, which highlights the idea that "you become responsible, forever, for what you have tamed," teaches children the importance of nurturing and maintaining relationships. This is especially relevant as they navigate friendships and family dynamics in a complex social landscape.

Moreover, "The Little Prince" offers a poignant critique of adult behavior and societal values, prompting children to question the world around them. The various grown-ups the prince encounters, preoccupied with power, wealth, and status, serve as caricatures of adult obsessions that often overshadow what truly matters. In an era where consumerism and material success are frequently idolized, the book's message encourages children to prioritize love, kindness, and the simple joys of life. This critical thinking skill is essential for young minds as they develop their own beliefs and values.

Furthermore, the story promotes introspection and philosophical inquiry, encouraging children to ponder existential questions. The Little Prince's reflections on life, death, and what it means to be truly happy provide a gentle introduction to these profound topics. This can be particularly beneficial in helping children develop resilience and emotional depth. In an unpredictable world, understanding such concepts can provide comfort and perspective, aiding children in coping with the challenges they face.

In conclusion, "The Little Prince" remains a relevant and vital story for modern children. Its celebration of imagination, emphasis on relationships, critique of adult priorities, and encouragement of philosophical thinking offer essential life lessons. As children grow up in a fast-paced, technology-driven society, the timeless wisdom of "The Little Prince" can help them navigate their world with creativity, empathy, and a sense of wonder. By revisiting this classic, children can learn to cherish the simple and important aspects of life, ensuring that they grow into thoughtful and compassionate individuals.

上面这种事invoke的方法,比较慢,可以用stream方法生成长文本更快:

essay = ""

request = HumanMessage(

content='write an essay on why the little prince is relevant in modern childhood'

)

for chunk in generate.stream({'messages': [request]}):

print(chunk.content, end="")

essay += chunk.content

生成的essay结果类似invoke的生成结果

20241124

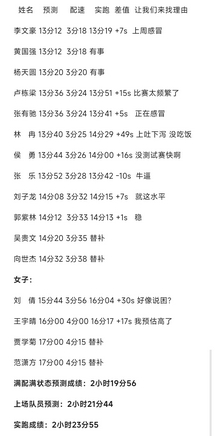

- 今早高百分站赛最后一站——武汉站,之前看华中农大狮山长跑队的B站动态,迪哥说分站赛报名费1000块太坑了,不去参加了,结果是真香了。总成绩2小时23分,比我们快了有将近一刻钟吧,但是他们只能排到第8,相当于人均4000米14分20秒左右的水平。主要是华农女生很强,刘倩(华农大姐大,B站@小爷乐了)跑到16分04,另一个王宇晴也跑到16分17,都是女子前十水平,男生实力相对弱,但贵在均匀,厚度相当高。华农的氛围真心羡慕。

- 最终39所高校晋级总决赛,虽然没有我们啥事,但未来谁知道呢?都不用提老牌强校,就以华北电力、广西民族这两所一南一北的两所高校为例,男生最差都能跑出13分40秒的成绩,而且华电还都是本科文化生上场,最弱的比我们最强的还要快;广西民族大学一所双非,8个男生,1个11分55秒,5个12分台,2个13分台,令人咋舌的水平,只可惜他们女生弱了些(17分台),最终被中山大学反杀。说实话,全国各地,东华西北、川渝两广,到处都是猛人,就长三角这片最为孱弱,肥水沃田果真是养不出高手。

- PS:养老跑,改前掌,膝盖坐久了疼,不跑一点还是不行。

第二步进行反思(Reflect)

reflection_prompt = ChatPromptTemplate.from_messages(

[

(

"system",

"You are a teacher grading an essay submission. Generate critique and recommendations for the user's submission."

" Provide detailed recommendations, including requests for length, depth, style, etc.",

),

MessagesPlaceholder(variable_name="messages"),

]

)

reflection_prompt.pretty_print()

prompt如下:

================================ System Message ================================

You are a teacher grading an essay submission. Generate critique and recommendations for the user's submission. Provide detailed recommendations, including requests for length, depth, style, etc.

============================= Messages Placeholder =============================

{messages}

同理进行invoke:

reflect = reflection_prompt | llm

reflection_prompt.invoke({'messages': [HumanMessage(content=essay)]}).messages

"""

[SystemMessage(content="You are a teacher grading an essay submission. Generate critique and recommendations for the user's submission. Provide detailed recommendations, including requests for length, depth, style, etc.", additional_kwargs={}, response_metadata={}),

HumanMessage(content='Antoine de Saint-Exupéry\'s "The Little Prince" is a timeless classic that continues to hold significant relevance in modern childhood. Although first published in 1943, its themes of innocence, imagination, and the essence of human relationships resonate as deeply today as they did over seventy years ago. The story\'s ability to transcend time and cultural boundaries makes it a valuable tool for imparting important life lessons to children in the contemporary world. This essay will explore three key reasons why "The Little Prince" remains relevant: its emphasis on the value of imagination, its exploration of essential human connections, and its critique of adult perspectives.\n\nFirstly, "The Little Prince" serves as a profound reminder of the value of imagination in childhood. In today\'s digital age, children\'s imaginations are often stifled by screens and structured activities. The Little Prince, with his fantastical journey across planets, encourages children to engage their creativity and explore the world with wonder. This imaginative exploration is crucial for cognitive development, as it fosters problem-solving skills and emotional intelligence. By reading the story, children are inspired to dream, create, and view the world from a perspective that values curiosity over conformity.\n\nSecondly, the book explores the importance of essential human connections, a theme that is increasingly important in today\'s fast-paced society. The Little Prince\'s journey is marked by his encounters with various characters, each representing different aspects of human nature. Through these interactions, Saint-Exupéry emphasizes the importance of relationships, love, and empathy. In a world where digital communication often replaces face-to-face interaction, "The Little Prince" reminds children of the irreplaceable value of genuine human bonds. The story teaches that what truly matters is invisible to the eye, a lesson on prioritizing meaningful connections over superficial ones.\n\nLastly, "The Little Prince" offers a poignant critique of adult perspectives, urging children to question societal norms and values. The story highlights how adults often lose sight of what is truly important in life, becoming consumed by materialism and routine. The Little Prince’s encounters with grown-ups reveal the absurdities of adult priorities, encouraging children to maintain their sense of wonder and questioning. In a world that often pressures children to grow up too quickly, the book serves as a reminder to preserve the innocence and purity of childhood perspectives.\n\nIn conclusion, "The Little Prince" remains profoundly relevant for modern childhood through its celebration of imagination, its emphasis on the importance of human connections, and its critique of adult mindsets. As children navigate the complexities of the modern world, Saint-Exupéry\'s timeless story offers guidance on maintaining a sense of wonder and prioritizing what truly matters in life. "The Little Prince" not only entertains but also educates, making it an invaluable addition to any child\'s literary journey. Through its enduring wisdom, the book continues to touch the hearts and minds of new generations, ensuring its place in the canon of essential childhood literature.', additional_kwargs={}, response_metadata={})]

"""

resp = reflect.invoke({'messages': [HumanMessage(content=essay)]})

print(resp.content)

生成的内容(对essay的评价):

Your essay provides a thoughtful and engaging analysis of Antoine de Saint-Exupéry's "The Little Prince," highlighting its enduring relevance and appeal to modern readers, particularly children. Your focus on the themes of imagination, human connection, and critique of adult perspectives is well-chosen, and you effectively articulate why these themes resonate today. However, there are areas where your essay could be strengthened to provide a more comprehensive and nuanced exploration.

### Critique and Recommendations:

1. **Depth of Analysis:**

- While you touch on the themes effectively, consider delving deeper into specific instances from the text to illustrate your points. For example, when discussing the value of imagination, you could analyze particular episodes, such as the Little Prince's encounter with the fox, to show how these moments encapsulate the theme.

- Explore the philosophical underpinnings of the novel. For instance, how does Saint-Exupéry’s personal history as a pilot and his philosophical views inform the narrative and its themes?

2. **Cultural and Historical Context:**

- Including a brief discussion of the historical and cultural context of when the book was written could enrich your analysis. Consider how the events of World War II, during which the book was written, might have influenced its themes of connection and innocence.

- Discuss how the book has been received in various cultures and how its translation and adaptation into different media have helped maintain its relevance.

3. **Modern Relevance:**

- While you mention the digital age, it would be beneficial to explore how "The Little Prince" contrasts with current trends in children's media and literature. How does it offer an alternative to digital narratives?

- Consider discussing the educational implications of the book in contemporary settings, such as its use in classrooms or therapeutic contexts.

4. **Structure and Flow:**

- Your essay is well-structured, but consider adding transitional sentences at the beginning and end of each paragraph to enhance the flow between sections.

- The conclusion reiterates your main points effectively, but it could be strengthened by suggesting specific ways parents or educators can incorporate the lessons of "The Little Prince" into children's lives today.

5. **Length and Style:**

- The essay is concise, which is a strength, but expanding on the points mentioned above could add depth without sacrificing clarity.

- Maintain the engaging and accessible style, but ensure that any additional analysis remains clear and focused to avoid overwhelming the reader with too much information.

6. **Quotations and References:**

- Integrating direct quotations from the text can add authenticity and depth to your analysis. Consider including a few key quotes that encapsulate the themes you discuss.

- If relevant, reference scholarly analyses of "The Little Prince" to support your arguments and provide additional perspectives.

By addressing these areas, your essay will offer a more comprehensive and nuanced exploration of "The Little Prince," enhancing its appeal and educational value to modern readers. Overall, your essay is a solid foundation that, with further development, can provide deeper insights into the timeless relevance of this classic work.

注意这里的request.type是human。

打印reflection_prompt.invoke({'messages': [request, HumanMessage(content=essay)]}).messages如下:

[SystemMessage(content="You are a teacher grading an essay submission. Generate critique and recommendations for the user's submission. Provide detailed recommendations, including requests for length, depth, style, etc.", additional_kwargs={}, response_metadata={}),

HumanMessage(content='write an essay on why the little prince is relevant in modern childhood', additional_kwargs={}, response_metadata={}),

HumanMessage(content='Antoine de Saint-Exupéry\'s "The Little Prince" is a timeless classic that continues to hold significant relevance in modern childhood. Although first published in 1943, its themes of innocence, imagination, and the essence of human relationships resonate as deeply today as they did over seventy years ago. The story\'s ability to transcend time and cultural boundaries makes it a valuable tool for imparting important life lessons to children in the contemporary world. This essay will explore three key reasons why "The Little Prince" remains relevant: its emphasis on the value of imagination, its exploration of essential human connections, and its critique of adult perspectives.\n\nFirstly, "The Little Prince" serves as a profound reminder of the value of imagination in childhood. In today\'s digital age, children\'s imaginations are often stifled by screens and structured activities. The Little Prince, with his fantastical journey across planets, encourages children to engage their creativity and explore the world with wonder. This imaginative exploration is crucial for cognitive development, as it fosters problem-solving skills and emotional intelligence. By reading the story, children are inspired to dream, create, and view the world from a perspective that values curiosity over conformity.\n\nSecondly, the book explores the importance of essential human connections, a theme that is increasingly important in today\'s fast-paced society. The Little Prince\'s journey is marked by his encounters with various characters, each representing different aspects of human nature. Through these interactions, Saint-Exupéry emphasizes the importance of relationships, love, and empathy. In a world where digital communication often replaces face-to-face interaction, "The Little Prince" reminds children of the irreplaceable value of genuine human bonds. The story teaches that what truly matters is invisible to the eye, a lesson on prioritizing meaningful connections over superficial ones.\n\nLastly, "The Little Prince" offers a poignant critique of adult perspectives, urging children to question societal norms and values. The story highlights how adults often lose sight of what is truly important in life, becoming consumed by materialism and routine. The Little Prince’s encounters with grown-ups reveal the absurdities of adult priorities, encouraging children to maintain their sense of wonder and questioning. In a world that often pressures children to grow up too quickly, the book serves as a reminder to preserve the innocence and purity of childhood perspectives.\n\nIn conclusion, "The Little Prince" remains profoundly relevant for modern childhood through its celebration of imagination, its emphasis on the importance of human connections, and its critique of adult mindsets. As children navigate the complexities of the modern world, Saint-Exupéry\'s timeless story offers guidance on maintaining a sense of wonder and prioritizing what truly matters in life. "The Little Prince" not only entertains but also educates, making it an invaluable addition to any child\'s literary journey. Through its enduring wisdom, the book continues to touch the hearts and minds of new generations, ensuring its place in the canon of essential childhood literature.', additional_kwargs={}, response_metadata={})]

同理可以用stream的方式生成:

reflection = ''

for chunk in reflect.stream({'messages': [request, HumanMessage(content=essay)]}):

print(chunk.content, end="")

reflection += chunk.content

输出结果:

Your essay on the relevance of "The Little Prince" in modern childhood is well-structured and covers three significant themes: the value of imagination, the importance of human connections, and the critique of adult perspectives. Your points are clearly articulated, and you effectively demonstrate how these themes continue to resonate in today's world. However, there are areas where the essay could be further developed to enhance its depth and impact.

### Recommendations:

1. **Length and Depth:**

- **Expand on Examples:** While you touch upon the themes, adding specific examples from the book would strengthen your argument. For instance, discuss the Little Prince's interaction with the fox to illustrate the importance of relationships and how it teaches the lesson that "what is essential is invisible to the eye."

- **Contemporary Connections:** Consider drawing parallels between the book's themes and current issues or trends in childhood development. For instance, you could explore how modern educational practices (like play-based learning) align with the book's emphasis on imagination.

2. **Style and Tone:**

- **Engage with the Audience:** Include rhetorical questions or personal reflections to make the essay more engaging. Encourage readers to reflect on their own experiences with imagination and human connections.

- **Use of Language:** While the language is mostly clear, varying sentence structure can enhance readability. Mix longer, complex sentences with shorter, impactful ones to maintain reader interest.

3. **Additional Themes:**

- **Materialism and Consumerism:** Expand on the critique of adult perspectives by linking it to modern issues like consumerism and the pressure on children to conform to societal expectations.

- **Emotional Intelligence:** Delve deeper into how the story fosters emotional intelligence and empathy, which are crucial skills for children growing up in a diverse and globalized world.

4. **Conclusion:**

- **Call to Action:** Strengthen the conclusion by suggesting practical ways parents or educators can incorporate the lessons of "The Little Prince" into children's lives, such as through discussions or creative activities inspired by the book.

- **Broader Implications:** Reflect on the broader implications of maintaining these childhood values into adulthood, ensuring that the timeless wisdom of the book continues to influence future generations.

By incorporating these recommendations, your essay will not only provide a comprehensive analysis of "The Little Prince" but also effectively communicate its enduring relevance to modern childhood. This approach will offer a richer, more nuanced perspective that resonates with both young readers and those guiding them.

第三步就是repeat上面的操作

for chunk in generate.stream(

{"messages": [request, AIMessage(content=essay), HumanMessage(content=reflection)]}

):

print(chunk.content, end="")

这里的reflection就是上面的essay评价,request还是HumanMessage(content='write an essay on why the little prince is relevant in modern childhood', additional_kwargs={}, response_metadata={})

输出结果:

Antoine de Saint-Exupéry's "The Little Prince" is a timeless narrative that maintains its profound relevance in modern childhood. Despite being over seventy years old, the book's themes of imagination, the essence of human connections, and its critique of adult perspectives continue to resonate deeply with today's readers. As children grow up in an increasingly fast-paced, digital world, "The Little Prince" offers invaluable lessons that nurture their development. This essay will delve into specific examples from the book to explore its relevance, draw contemporary connections, and suggest practical ways to incorporate its lessons into children's lives.

Firstly, "The Little Prince" emphasizes the value of imagination, which is essential for children's cognitive and emotional development. In a world where screens often dominate children's attention, the book encourages imaginative exploration through its fantastical narrative. The Little Prince’s journey across different planets, each with its own unique inhabitants, serves as an invitation for children to dream and create. For example, the Little Prince's interaction with the rose on his home planet illustrates the depth of imagination required to appreciate beauty and uniqueness. Play-based learning, a modern educational practice that aligns with this theme, supports children's creativity and problem-solving skills. By fostering an environment where imagination is valued, children can learn to approach challenges with curiosity and innovation.

Secondly, the book poignantly explores the importance of human connections, a theme increasingly crucial in today's digital society. The Little Prince's encounter with the fox is a pivotal moment that underscores the significance of relationships. Through the fox, the Little Prince learns that "what is essential is invisible to the eye," highlighting the value of love, trust, and empathy. In an era where digital communication often overshadows face-to-face interactions, these lessons remind children of the irreplaceable value of genuine human bonds. Encouraging children to build meaningful relationships through shared experiences and empathy fosters emotional intelligence, a critical skill in our diverse and globalized world.

Moreover, "The Little Prince" offers a critique of adult perspectives, urging children to question societal norms and values. The story reveals how adults often become consumed by materialism and lose sight of what truly matters. For instance, the Little Prince's visit to the businessman’s planet, where the man is obsessed with counting stars as his possessions, serves as a satire of adult priorities. This critique is particularly relevant today, as children face pressures to conform to societal expectations from a young age. By encouraging children to preserve their sense of wonder and questioning, the book advocates for a world where inner values take precedence over materialistic pursuits.

In conclusion, "The Little Prince" remains profoundly relevant for modern childhood through its celebration of imagination, its emphasis on essential human connections, and its critique of adult mindsets. To incorporate these lessons into children's lives, parents and educators can engage children in discussions about the book's themes, encouraging them to reflect on their own experiences. Creative activities inspired by the story, such as drawing or storytelling, can also help children internalize its messages. By maintaining the timeless wisdom of the book, we can ensure that future generations grow up with the values of imagination, empathy, and introspection. Through its enduring insights, "The Little Prince" continues to touch the hearts and minds of new readers, making it an essential part of any child's literary journey.

第四步我们构建langgraph

from typing import Annotated, List, Sequence

from langgraph.graph import END, StateGraph, START

from langgraph.graph.message import add_messages

from langgraph.checkpoint.memory import MemorySaver

from typing_extensions import TypedDict

class State(TypedDict):

messages: Annotated[list, add_messages]

async def generation_node(state: State) -> State:

print('generation node', [msg.type for msg in state['messages']])

return {"messages": [await generate.ainvoke(state["messages"])]}

async def reflection_node(state: State) -> State:

print('reflection node raw', [msg.type for msg in state['messages']])

# Other messages we need to adjust

cls_map = {"ai": HumanMessage, "human": AIMessage}

# First message is the original user request. We hold it the same for all nodes

translated = [state["messages"][0]] + [

cls_map[msg.type](content=msg.content) for msg in state["messages"][1:]

]

print('reflection node processed', [msg.type for msg in translated])

res = await reflect.ainvoke(translated)

# We treat the output of this as human feedback for the generator

return {"messages": [HumanMessage(content=res.content)]}

- messages

- round 1

- generate

- input: [

human] - output: [

human,ai]

- input: [

- reflect

- input: [

human,ai] -> [human,human] - output: [

human,ai,human]- 问题,回答,反思

- input: [

- generate

- round 2

- generate

- input: [

human,ai,human] - output: [

human,ai,human,ai]- 问题,回答,反思,改进后的回答

- input: [

- reflect

- input: [

human,ai,human,ai] => [human,human,ai,human] - output: [

human,ai,human,ai,human]

- input: [

- generate

- round 3

- generate

- input: [

human,ai,human,ai,human] - output: [

human,ai,human,ai,human,ai]

- input: [

- reflect

- input: [

human,ai,human,ai,human,ai] => [human,human,ai,human,ai,human] - output: [

human,ai,human,ai,human,ai,human]

- input: [

- generate

- round4

- generate

- input: [

human,ai,human,ai,human,ai,human] - output: [

human,ai,human,ai,human,ai,human,ai]

- input: [

- generate

- round 1

builder = StateGraph(State)

builder.add_node("generate", generation_node)

builder.add_node("reflect", reflection_node)

builder.add_edge(START, "generate")

def should_continue(state: State):

if len(state["messages"]) > 6:

# End after 3 iterations

return END

return "reflect"

builder.add_conditional_edges("generate", should_continue)

builder.add_edge("reflect", "generate")

memory = MemorySaver()

graph = builder.compile(checkpointer=memory)

from IPython.display import Image, display

try:

display(Image(graph.get_graph().draw_mermaid_png()))

except Exception:

pass

config = {"configurable": {"thread_id": "1"}}

async for event in graph.astream(

{

"messages": [

HumanMessage(

content="Generate an essay on the topicality of The Little Prince and its message in modern life"

)

],

},

config,

):

print(event)

print("---")

这样就会输出多轮的左右互搏结果👆

resp = await graph.ainvoke({

"messages": [

HumanMessage(

content="Generate an essay on the topicality of The Little Prince and its message in modern life"

)

],

},

config,

)

# generation node ['human', 'ai', 'human', 'ai', 'human', 'ai', 'human', 'ai', 'human']

for msg in resp['messages']:

print(msg.type)

"""

human

ai

human

ai

human

ai

human

ai

human

ai

"""

即验证了左右互搏的过程

20241125

华农高百的成绩(华农vlog),看起来如果他们全主力很有机会跑进总决赛(武大居然也没能进总决赛),有点可惜,2~8名咬得很紧,很难想象一年前他们的水平还跟我们差不多。值得注意的是,倩姐赛前测试能跑到15’44"(10月底校运会3000米倩姐只跑了12分06秒,这么看肯定是放海了),算上其他九分站赛,能跑进16分的女生也是屈指可数。

- 倩姐半马PB131,万米41分台,但是女生速度能力较于耐力要差不少,比如有些女跑者万米跑不进40分钟,都能成功全马破三,换算到4000米能干到15分44秒确实很惊艳👍

亦童、王京、张甜这周后三天要综合考,wyl那边破事放下,抱了一周佛脚,不过现在真的越来越水了,三门只用选两门考,而且课程成绩在前10%还能免考,真过分了,但他们外校过来的大部分都没怎么学过运筹优化,加上还非得考计量就很迷。我前年考完出来第一时间把题目记下来,未雨绸缪,其实这两年根本没什么人记题目,老师也不让外传。差不多得了,也不至于不及格。

晚饭后,风雨渐起,寒潮来了,慢跑了半个小时,遇到王长清,带他450跑了会儿,他3K就不行了,慢慢来吧小家伙,男生跑进5分配还是不难的。现在就是养老模式,一点不跑也不太好,那就带一些人慢慢练起来吧。前天我倒是看到何伟杰在跑,她也是挺奇怪,高百之后就退群,有些事也真对付不来。

PS:月跑量170K,均配4’24",上半月100K能有4’13"的均配,下半旬开摆。这个月还是凑个200K吧,之后每天就养老跑个5K,有人陪就多跑些,真不想再练了。

拓印键盘脚本的方法,因为有很多特殊键(非字母按键),可以在pynput.keyboard.Key下找到:

>>> from pynput import keyboard

>>> dir(keyboard.Key)

['__class__', '__doc__', '__members__', '__module__', 'alt', 'alt_gr', 'alt_l', 'alt_r', 'backspace', 'caps_lock', 'cmd', 'cmd_r', 'ctrl', 'ctrl_l', 'ctrl_r', 'delete', 'down', 'end', 'enter', 'esc', 'f1', 'f10', 'f11', 'f12', 'f13', 'f14', 'f15', 'f16', 'f17', 'f18', 'f19', 'f2', 'f20', 'f21', 'f22', 'f23', 'f24', 'f3', 'f4', 'f5', 'f6', 'f7', 'f8', 'f9', 'home', 'insert', 'left', 'media_next', 'media_play_pause', 'media_previous', 'media_volume_down', 'media_volume_mute', 'media_volume_up', 'menu', 'num_lock', 'page_down', 'page_up', 'pause', 'print_screen', 'right', 'scroll_lock', 'shift', 'shift_r', 'space', 'tab', 'up']

可以用keyboard.KeyCode来确认是否属于非字母键,下面是一个监听组合键的方法:

from pynput import keyboard

def on_press(key):

if isinstance(key, keyboard.KeyCode):

# 检查是否同时按下了Ctrl和Shift键

if key.char == 'a' and key.ctrl and key.shift:

print("Ctrl+Shift+A 被按下")

def on_release(key):

pass

with keyboard.Listener(on_press=on_press, on_release=on_release) as listener:

listener.join()

类似之前的鼠标拓印,键盘的具体拓印和自动化操作脚本:

# Operate manually on keyboard

def rubbing_keyboard(rubbing_path = "./keyboard.log"):

def _on_press(key):

logging.info(f"press {key}")

def _on_release(key):

logging.info(f"release {key}")

logger = initialize_logger(rubbing_path, 'w')

with keyboard.Listener(on_press=_on_press, on_release=_on_release) as listener:

listener.join()

terminate_logger(logger)

# Simulate the keyboard action by rubbing

def printing_keyboard(rubbing_path = "./keyboard.log"):

with open(rubbing_path, 'r', encoding="utf8") as f:

lines = f.read().splitlines()

keyboard_controller = keyboard.Controller()

for line in lines:

asctime, filename, levelname, message = line.split('|')

asctime, filename, levelname, message = asctime.strip(), filename.strip(), levelname.strip(), message.strip()

if message.startswith("press"):

key_string = message[6: ]

if key_string.startswith("Key"):

keyboard_controller.press(eval(f"keyboard.{key_string}"))

else:

keyboard_controller.press(eval(key_string))

elif message.startswith("release"):

key_string = message[8: ]

if key_string.startswith("Key"):

keyboard_controller.release(eval(f"keyboard.{key_string}"))

else:

keyboard_controller.release(eval(key_string))

else:

assert False, f"Unknown message: {message}"

time.sleep(.001)

也可以同时监听键盘和鼠标:

def rubbing_mouse_and_keyboard(rubbing_path = "./mouse_keyboard.log"):

def _on_move(x, y):

logging.info(f"move to ({x}, {y})")

def _on_click(x, y, button, pressed):

logging.info(f'{"press" if pressed else "release"} {button} at ({x}, {y})')

def _on_scroll(x, y, dx, dy):

logging.info(f"scroll at ({x}, {y}) by [{dx}, {dy}]")

def _on_press(key):

logging.info(f"press {key}")

def _on_release(key):

logging.info(f"release {key}")

logger = initialize_logger(rubbing_path, 'w')

mouse_listener = mouse.Listener(on_move=_on_move, on_click=_on_click, on_scroll=_on_scroll)

mouse_listener.start()

keyboard_listener = keyboard.Listener(on_press=_on_press, on_release=_on_release)

keyboard_listener.start()

mouse_listener.join()

keyboard_listener.join()

terminate_logger(logger)

注意必须按照start + join的多进程写法,如果还是用with ... as listener: ...join()的方法,只能监听最靠前的一个listener,改名字也不行,必须有start

20241126

寒潮降临,这波还挺有武德,半夜来半夜走,就是昨晚回去淋了一路,而且还是大顶风,冻死。

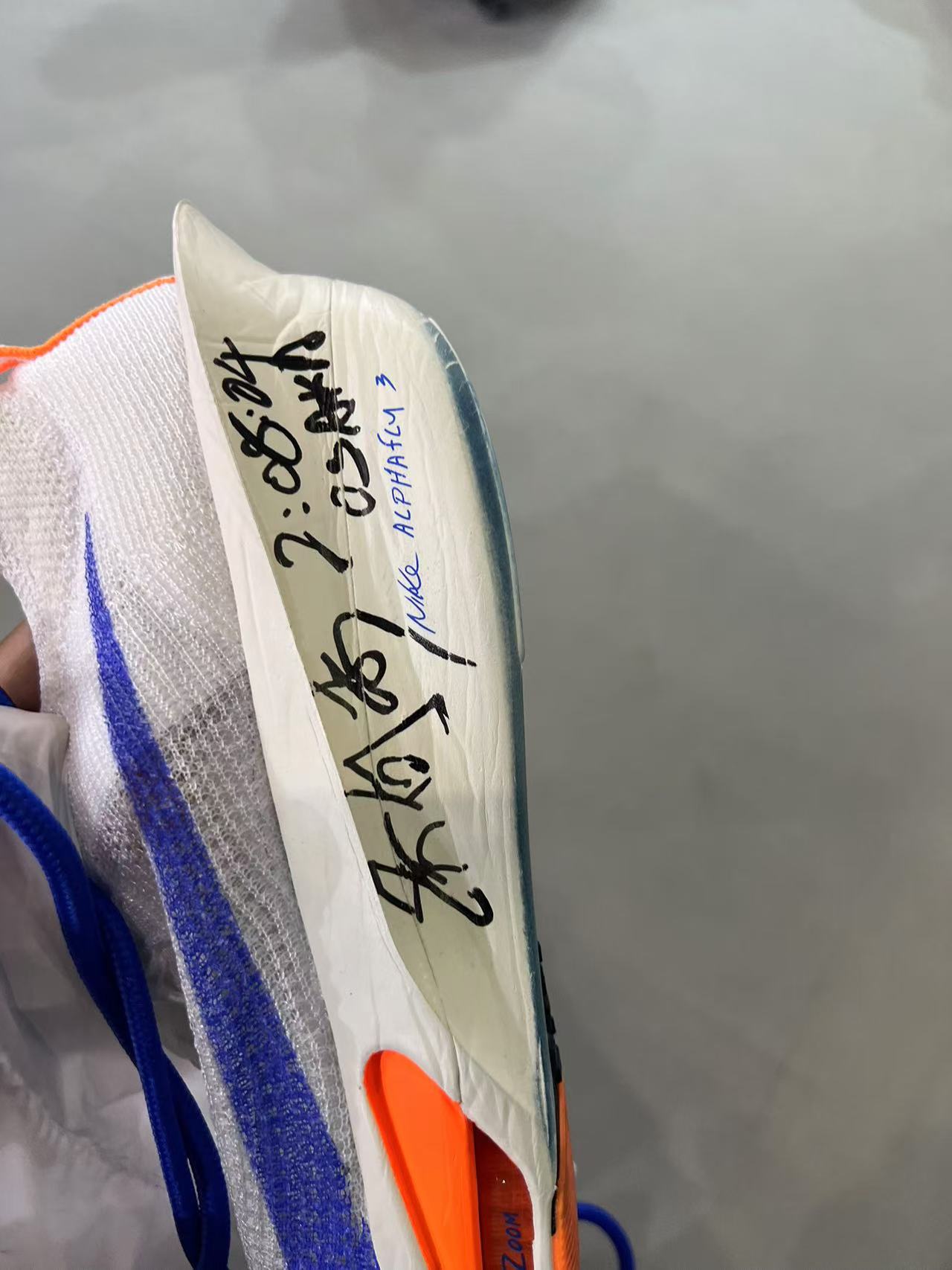

AK上马D区,PB很难,但他还是会去拼240,今年过去他就30岁,说起来AK生日也是在双十二,跑进240也是生日礼物了。而且去年嘉伟上马也是D区,枪声305,净成绩259,首马破三,含金量可见一斑。

赞助名额都在D区,D区才是大佬云集的地方,水平不比A区差,去年上马被诟病很多,就是因为分区不合理,而且,两万多人的规模就一枪出发,D区的人疯狂往前面挤,堵成麻瓜。

养老第四天,445跑了10K,改前掌跑,跟韬哥一起,左膝感觉好多了。状态基本回满,但也不太想再用力了,每天溜达一会儿很舒服,这才是初衷。上半年嘉伟锡马跑伤后,说好想跑一场不看成绩的比赛,韬哥也说想毕业前跑一次半马,他最近基本上天天下班回来跑五六公里,对于一个专项400和800的人来说,跑个半马也不算太难其实,明年上半年找个容易中签的一起呗。

PS:难得东哥晚上也在操场,在练往返跑。

repeat操作

在w轴上repeat:

repeat(ims[0], 'h w c -> h (repeat w) c', repeat=3)

像 rearrange 一样,repeat 同样对轴的顺序敏感。你可以通过改变括号内的轴的顺序来将一个像素重复三次,而不是将图片整体重复三次:

repeat(ims[0], 'h w c -> h (w repeat) c', repeat=3)

当然也可以在纵向上将一个像素重复三次:

repeat(ims[0], 'h w c -> (h repeat) w c', repeat=3)

同时在 w 和 h 轴的方向上重复:

repeat(ims[0], 'h w c -> (2 h) (2 w) c')

同样,通过调整顺序,可以将一个像素在 h 和 w 的方向上分别重复两次,这有点像 2×2 池化的逆操作。实际上 reduce 和 repeat 可以互相视为逆操作。

repeat(ims[0], 'h w c -> (h 2) (w 2) c')

在一个新的轴上重复:

print(ims[0].shape) # (96, 96, 3)

repeat(ims[0], 'h w c -> h new_axis w c', new_axis=5).shape # (96, 5, 96, 3)

新的张量是原先的 (96, 96, 3) 张量在第二个轴上重复了 5 次得到的。

更多的花里胡哨的操作

https://einops.rocks/1-einops-basics/#fancy-examples-in-random-order

# repeat along a new axis. New axis can be placed anywhere

repeat(ims[0], "h w c -> h new_axis w c", new_axis=5).shape

# interweaving along vertical for couples of images

rearrange(ims, "(b1 b2) h w c -> (h b1) (b2 w) c", b1=2)

# interweaving lines for couples of images

# exercise: achieve the same result without einops in your favourite framework

reduce(ims, "(b1 b2) h w c -> h (b2 w) c", "max", b1=2)

# color can be also composed into dimension

# ... while image is downsampled

reduce(ims, "b (h 2) (w 2) c -> (c h) (b w)", "mean")

# disproportionate resize

reduce(ims, "b (h 4) (w 3) c -> (h) (b w)", "mean")

# spilt each image in two halves, compute mean of the two

reduce(ims, "b (h1 h2) w c -> h2 (b w)", "mean", h1=2)

# split in small patches and transpose each patch

rearrange(ims, "b (h1 h2) (w1 w2) c -> (h1 w2) (b w1 h2) c", h2=8, w2=8)

# stop me someone!

rearrange(ims, "b (h1 h2 h3) (w1 w2 w3) c -> (h1 w2 h3) (b w1 h2 w3) c", h2=2, w2=2, w3=2, h3=2)

# stop me someone!

rearrange(ims, "b (h1 h2 h3) (w1 w2 w3) c -> (h1 w2 h3) (b w1 h2 w3) c", h2=2, w2=2, w3=2, h3=2)

rearrange(ims, "(b1 b2) (h1 h2) (w1 w2) c -> (h1 b1 h2) (w1 b2 w2) c", h1=3, w1=3, b2=3)

# patterns can be arbitrarily complicated

reduce(ims, "(b1 b2) (h1 h2 h3) (w1 w2 w3) c -> (h1 w1 h3) (b1 w2 h2 w3 b2) c", "mean", h2=2, w1=2, w3=2, h3=2, b2=2)

# subtract background in each image individually and normalize

# pay attention to () - this is composition of 0 axis, a dummy axis with 1 element.

im2 = reduce(ims, "b h w c -> b () () c", "max") - ims

im2 /= reduce(im2, "b h w c -> b () () c", "max")

rearrange(im2, "b h w c -> h (b w) c")

这个是变成黑白图👆,下面则是打马赛克:

# pixelate: first downscale by averaging, then upscale back using the same pattern

averaged = reduce(ims, "b (h h2) (w w2) c -> b h w c", "mean", h2=6, w2=8)

repeat(averaged, "b h w c -> (h h2) (b w w2) c", h2=6, w2=8)

翻转+旋转:

rearrange(ims, "b h w c -> w (b h) c")

# let's bring color dimension as part of horizontal axis

# at the same time horizontal axis is downsampled by 2x

reduce(ims, "b (h h2) (w w2) c -> (h w2) (b w c)", "mean", h2=3, w2=3)

rearrange不改变张量中元素的总个数。reduce在保持基本重排语法不变的同时引入了缩减操作(mean, min, max, sum, prod)repeat包括了重复和平铺操作- composition 和 decomposition 是

einops的基石。它们能够也应该被联合起来使用。

20241127

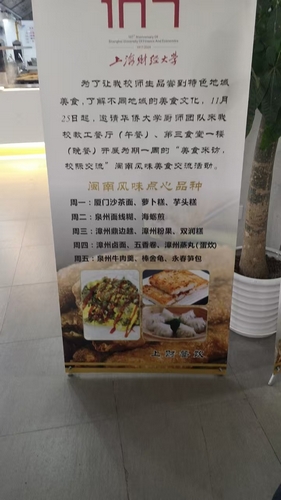

最近新食堂一楼晚上天天人山人海,原来是有大厨莅临,今晚的漳州鼎边趟,不知道为什么里面放了一堆花甲。

亦童准备了大半个月,结果今早高统准备的都没考,跟我说题目跟往年完全不一样,上来前两题都不会,直接就蒙了。说实话对比数院和统院的综合考,我们往年确实太简单了,应该给他们加点难度。

晚饭后慢跑半个小时消食,有一两个男生跟了我不到2K,没有回头看,提到415哥几个还是不太跟得住。另外,有一个这么冷的天还穿半弹的女跑者,大概是410-415在跑2K的间歇,我估摸不可能是学生,问了一下果然是外面的人,毕竟没见过这么强的.

PS:今年高百总决赛有11张外卡,也就是说如果没报满,我们还是有机会去玩一玩的,当然去了也是纯找虐,甚至会被关门,要知道10人×16KM的接力,关门时间只给了11个小时,意味着平均每个人只有66分钟,均配是4’07",这还包含了两个女生,基本上是必被关门。其实到最后还是拼女生,16KM他们男选手基本上也就是55-60分钟这个区间,女生差距就很大了,4分半已经不算差了,但有的甚至能4分以内跑完16KM,去年清华的女选手甚至跑进了1个小时…

-

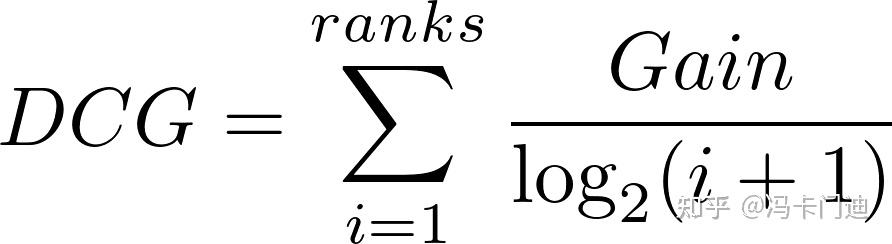

信息量: I s = log 2 1 p ( s ) I_s=\log_2\frac1{p(s)} Is=log2p(s)1

-

熵:不确定性的度量

- 信息量的期望: ∑ s p ( s ) log 2 1 p ( s ) \sum_s p(s)\log_2 \frac{1}{p(s)} ∑sp(s)log2p(s)1

-

互信息(mutual information)

- 互信息的定义及其与熵/条件熵的关系

- 引入/给定 X X X, Y Y Y 不确定性的减少;

- 引入/给定 Y Y Y, X X X 不确定性的减少;

I ( X , Y ) = ∑ x ∈ X , y ∈ Y P X , Y ( x , y ) log P X , Y ( x , y ) P X ( x ) P Y ( y ) = H ( Y ) − H ( Y ∣ X ) = H ( X ) − H ( X ∣ Y ) \begin{split} I(X,Y)&=\sum_{x\in X,y\in Y} P_{X,Y}(x,y)\log \frac{P_{X,Y}(x,y)}{P_X(x)P_Y(y)}\\ &=H(Y)-H(Y|X)\\ &=H(X)-H(X|Y) \end{split} I(X,Y)=x∈X,y∈Y∑PX,Y(x,y)logPX(x)PY(y)PX,Y(x,y)=H(Y)−H(Y∣X)=H(X)−H(X∣Y)

- 互信息的定义及其与熵/条件熵的关系

条件熵 => 熵的降低/减少

- 天气分布( D D D),一个月内下雨/不下雨的天数均为 15 天,也就是概率为 50%

import numpy as np

-(0.5*np.log2(0.5) + 0.5*np.log2(0.5)) # 1.0

Entropy ( D ) = − ( p ( r ) log p ( r ) + p ( s ) log p ( s ) ) = − ( 0.5 log 0.5 + 0.5 log 0.5 ) = 1 b i t \begin{split} \text{Entropy}(D)&=-(p(r)\log p(r)+p(s)\log p(s))\\ &=-(0.5\log 0.5 + 0.5\log 0.5)\\ &=1bit \end{split} Entropy(D)=−(p(r)logp(r)+p(s)logp(s))=−(0.5log0.5+0.5log0.5)=1bit

这表明在没有任何其他信息的情况下,预测某天的天气(下雨或晴朗)的不确定性为1比特。现在,假设我们提供了一个上下文:如果天气预报说"今天空气湿度很高"。根据过去的经验,我们知道在空气湿度高的日子里,下雨的概率是0.75,不下雨的的概率是0.25。现在我们计算给定这个上下文后的条件熵:

Entropy ( D ∣ context ) = − ( 0.75 log 0.75 + 0.25 log 0.25 ) \text{Entropy}(D|\text{context})=-(0.75\log 0.75+0.25\log 0.25) Entropy(D∣context)=−(0.75log0.75+0.25log0.25)

-(0.75*np.log2(0.75) + 0.25*np.log2(0.25)) #

- probability vs. likelihood

- 概率:P(数据 | 参数)

- 在已知模型参数的情况下,某个特定结果或事件发生的可能性。

- 已知一枚硬币是公平的(正反面概率都是50%),那么抛出正面的概率是0.5。

- 似然:L(参数 | 数据)

- 在观察到特定数据的情况下,模型参数取特定值的支持程度。

- 观察到连续10次抛硬币都是正面,我们想知道这枚硬币是偏向正面的可能性有多大。

- 概率:P(数据 | 参数)

- 以LLM为例

- 训练阶段(似然):

- 在训练GPT模型时,模型通过调整内部参数,使得训练数据的似然最大化。这意味着模型会“学习”如何生成与训练数据分布相似的文本。

- 生成阶段(概率):

- 当模型生成文本时,它使用训练好的参数,基于当前的输入(上下文),计算下一个词的概率分布,并根据这些概率进行采样,从而生成连贯的文本。

- 训练阶段(似然):

from scipy.stats import norm

# Define mean and standard deviation

mean = 32

std_dev = 2.5

# Calculate the probability of the range 32 to 34

# Pr(weight between 32 and 34 grams|mean = 32 and std = 2.5)

probability = norm.cdf(34, mean, std_dev) - norm.cdf(32, mean, std_dev)

f'{probability:.2f}'

# # Pr(weight > 34 grams|mean = 32 and std = 2.5)

probability = 1 - norm.cdf(34, mean, std_dev)

f'{probability:.2f}'

# L(mean=32 and std=2.5 | weight equals 34 grams)

likelihood = norm.pdf(34, mean, std_dev)

f'{likelihood:.2f}'

# L(mean=32 and std=2.5 | weight equals 34 grams)

likelihood = norm.pdf(34, 34, std_dev)

f'{likelihood:.2f}'

带阴影的绘图:

import numpy as np

import matplotlib.pyplot as plt

# Define the range for visualization

x = np.linspace(mean - 4 * std_dev, mean + 4 * std_dev, 500)

y = norm.pdf(x, mean, std_dev)

# Plot the Gaussian curve

plt.figure(figsize=(10, 6))

plt.plot(x, y, label="Gaussian Distribution (Mean=32, Std Dev=2.5)", lw=2)

# Highlight the area for 24 to 32

x_fill = np.linspace(32, 34, 500)

y_fill = norm.pdf(x_fill, mean, std_dev)

plt.fill_between(x_fill, y_fill, color="skyblue", alpha=0.5, label="P(32 ≤ X ≤ 34)")

# Mark the likelihood at x = 34

plt.scatter([34], [norm.pdf(34, mean, std_dev)], color="red", label="Likelihood at X=34")

plt.annotate(

"Likelihood at X=34",

xy=(34, norm.pdf(34, mean, std_dev)),

xytext=(34.5, norm.pdf(34, mean, std_dev) + 0.02),

arrowprops=dict(facecolor='black', arrowstyle="->"),

fontsize=10

)

# Add labels and legend

plt.title("Gaussian Distribution with Mean=32 and Std Dev=2.5", fontsize=14)

plt.xlabel("X Value", fontsize=12)

plt.ylabel("Probability Density", fontsize=12)

plt.legend(fontsize=10)

plt.grid(alpha=0.3)

20241128

LXY最近一点没跑,原来是吃坏了。

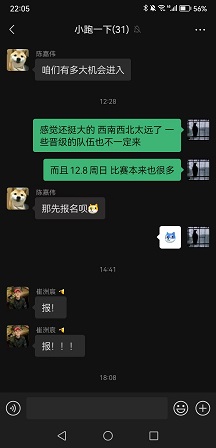

总决赛给了外卡,现在真的是有机会参加总决赛了。

可是16KM×10人,关门时间只给了11小时,人均4’07"的配速,还要算上两个女生。

有能力跑到3’50"以内配速的只有嘉伟、小崔和我。其他人长距离想跑进4分配都够呛,几乎必然被关门。

但也有比我们水平更差的,我知道肯定不是那些强校的对手的。

而且还缺两个女生,DGL肯定是来不了的,而且16KM对女生实在是太长了。

其实很想去,对吧?晚上九点,认真跑了一会儿,是首马十天之后第一次认真跑,身上一点伤痛都没有了,这是最完好的状态。

PS:果然还是不太甘心,带兄弟们再冲一次吧。

MLE

θ

=

a

r

g

m

a

x

θ

p

θ

(

x

)

=

a

r

g

m

a

x

θ

log

p

θ

(

x

)

\theta = \underset{\theta}{\mathrm{argmax}}\ p_{\theta}(x) = \underset{\theta}{\mathrm{argmax}}\ \log p_{\theta}(x)

θ=θargmax pθ(x)=θargmax logpθ(x)

-

训练集 X = { x 1 , x 2 , ⋯ , x N } X=\left\{x_1,x_2,\cdots, x_N\right\} X={x1,x2,⋯,xN},则 marginal log likelihood( log p θ ( X ) \log p_\theta(X) logpθ(X))

log p θ ( X ) = log ∏ i = 1 N p θ ( x i ) = ∑ i = 1 N log p θ ( x i ) = ∑ i = 1 N log ∫ p θ ( x i , z i ) d z = ∑ i = 1 N log ∫ p θ ( x i ∣ z i ) p θ ( z i ) d z \begin{split} \log p_{\theta}(X) &= \log \prod_{i=1}^{N} p_{\theta}(x_i) \\ &= \sum_{i=1}^{N} \log p_{\theta}(x_{i}) \\ &= \sum_{i=1}^{N} \log \int p_{\theta}(x_i, z_i)dz \\ &= \sum_{i=1}^{N} \log \int p_{\theta}(x_i \lvert z_i)p_{\theta}(z_i)dz \end{split} logpθ(X)=logi=1∏Npθ(xi)=i=1∑Nlogpθ(xi)=i=1∑Nlog∫pθ(xi,zi)dz=i=1∑Nlog∫pθ(xi∣zi)pθ(zi)dz

- z z z 的维度,决定了最后有几重积分;

MLE估计参数 μ , σ \mu, \sigma μ,σ

- 假设观测数据来自正态分布

N

(

μ

,

σ

2

)

\mathcal N(\mu,\sigma^2)

N(μ,σ2),MLE 的目标是找到均值

μ

\mu

μ 和标准差

σ

\sigma

σ 的估计值,使得对数似然函数达到最大值。

ℓ ( μ , σ ; X ) = ∑ i = 1 n log f ( x i ; μ , σ ) \ell(\mu, \sigma; X) = \sum_{i=1}^n \log f(x_i; \mu, \sigma) ℓ(μ,σ;X)=i=1∑nlogf(xi;μ,σ) - 其中,正态分布的概率密度函数为:

f ( x ; μ , σ ) = 1 2 π σ exp ( − ( x − μ ) 2 2 σ 2 ) . f(x; \mu, \sigma) = \frac{1}{\sqrt{2\pi}\sigma} \exp\left(-\frac{(x-\mu)^2}{2\sigma^2}\right). f(x;μ,σ)=2πσ1exp(−2σ2(x−μ)2). - 将其代入对数似然函数,得到:

ℓ ( μ , σ ; X ) = ∑ i = 1 n [ − log ( 2 π σ ) − ( x i − μ ) 2 2 σ 2 ] . \ell(\mu, \sigma; X) = \sum_{i=1}^n \left[ -\log(\sqrt{2\pi}\sigma) - \frac{(x_i - \mu)^2}{2\sigma^2} \right]. ℓ(μ,σ;X)=i=1∑n[−log(2πσ)−2σ2(xi−μ)2].

import numpy as np

from scipy.optimize import minimize

# 生成正态分布的样本数据

np.random.seed(0)

true_mu, true_sigma = 0, 0.1 # 真实的均值和标准差

samples = np.random.normal(true_mu, true_sigma, 1000)

# 定义对数似然函数

def log_likelihood(params, data):

mu, sigma = params

return -np.sum(np.log(np.sqrt(2 * np.pi * sigma**2)) + ((data - mu)**2 / (2 * sigma**2)))

# 定义初始参数估计

initial_params = [0, 1] # 初始猜测的均值和标准差

# 使用梯度下降法找到最大化对数似然函数的参数值

result = minimize(lambda params: -log_likelihood(params, samples), initial_params, method='BFGS')

estimated_mu, estimated_sigma = result.x

result.x

语言模型:

− log P -\log P −logP

- 训练损失的下降表示模型在逐步最大化似然,即模型参数在调整以更好地解释训练数据。

- 交叉熵损失等价于负对数似然(神经网络相同于一个概率分布),最小化损失即最大化似然。

import torch

import torch.nn as nn

import torch.optim as optim

import matplotlib.pyplot as plt

import numpy as np

corpus = [

"hello how are you",

"i am fine thank you",

"how about you",

"i am doing well",

"thank you very much"

]

word_list = " ".join(corpus).split()

vocab = list(set(word_list))

word2idx = {w: idx for idx, w in enumerate(vocab)}

idx2word = {idx: w for idx, w in enumerate(vocab)}

vocab_size = len(vocab)

vocab_size, word2idx

输出结果:

(13,

{'you': 0,

'very': 1,

'thank': 2,

'fine': 3,

'hello': 4,

'am': 5,

'well': 6,

'are': 7,

'how': 8,

'doing': 9,

'much': 10,

'about': 11,

'i': 12})

def make_dataset(corpus):

input_data = []

target_data = []

for sentence in corpus:

words = sentence.split()

for i in range(len(words)-1):

input_data.append(word2idx[words[i]])

target_data.append(word2idx[words[i+1]])

return input_data, target_data

inputs, targets = make_dataset(corpus)

inputs, targets

# ([4, 8, 7, 12, 5, 3, 2, 8, 11, 12, 5, 9, 2, 0, 1],

# [8, 7, 0, 5, 3, 2, 0, 11, 0, 5, 9, 6, 0, 1, 10])

inputs = torch.LongTensor(inputs)

targets = torch.LongTensor(targets)

class LanguageModel(nn.Module):

def __init__(self, vocab_size, embedding_dim=10):

super(LanguageModel, self).__init__()

self.embed = nn.Embedding(vocab_size, embedding_dim)

self.fc = nn.Linear(embedding_dim, vocab_size)

def forward(self, x):

x = self.embed(x) # [batch_size, embedding_dim]

out = self.fc(x) # [batch_size, vocab_size]

return out

model = LanguageModel(vocab_size)

- 上下文长度:在这个示例中,模型仅基于当前词预测下一个词,因此它实际上是一个二元模型(Bigram Model)。也就是说,它只考虑一个词的上下文来进行预测。

- 无记忆机制:与循环神经网络(RNN)或Transformer等更复杂的模型不同,前馈神经网络没有内部状态或记忆机制,无法捕捉长距离的依赖关系。

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.1)

losses = []

# 训练模型

for epoch in range(100):

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

losses.append(loss.item())

if (epoch+1) % 20 == 0:

print(f"Epoch [{epoch+1}/100], Loss: {loss.item():.4f}")

"""

Epoch [20/100], Loss: 1.7597

Epoch [40/100], Loss: 1.2261

Epoch [60/100], Loss: 0.9018

Epoch [80/100], Loss: 0.6894

Epoch [100/100], Loss: 0.5475

"""

np.log(vocab_size) #

训练损失绘图:

plt.plot(range(len(losses)), losses)

plt.xlabel("Epoch")

plt.ylabel("Loss")

plt.title("Training Loss over Epochs (Negative Log-Likelihood)")

def generate_text(model, start_word, idx2word, word2idx, max_len=5):

model.eval()

words = [start_word]

input_word = torch.LongTensor([word2idx[start_word]])

with torch.no_grad():

for _ in range(max_len):

output = model(input_word)

# 计算概率分布

probabilities = torch.softmax(output, dim=1)

# 可视化概率分布

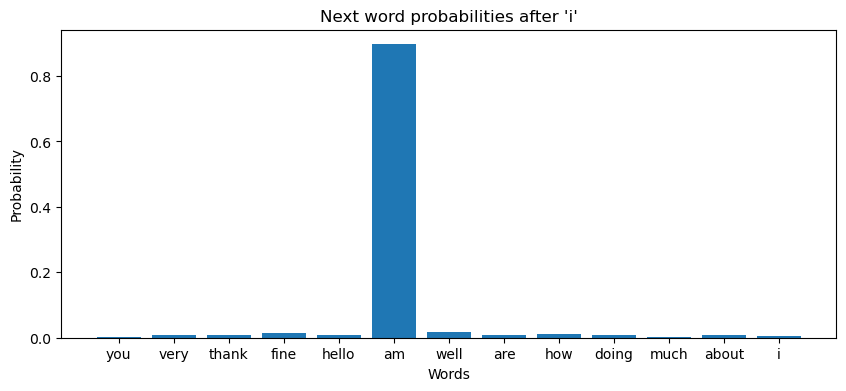

probs = probabilities.squeeze().cpu().numpy()

plt.figure(figsize=(10,4))

plt.bar([idx2word[i] for i in range(vocab_size)], probs)

plt.xlabel("Words")

plt.ylabel("Probability")

plt.title(f"Next word probabilities after '{words[-1]}'")

plt.show()

# 采样下一个词

predicted_idx = torch.multinomial(probabilities, 1).item()

predicted_word = idx2word[predicted_idx]

words.append(predicted_word)

input_word = torch.LongTensor([predicted_idx])

return ' '.join(words)

start_word = 'i'

generated_sentence = generate_text(model, start_word, idx2word, word2idx)

generated_sentence # 'i am fine you thank you'

20241129

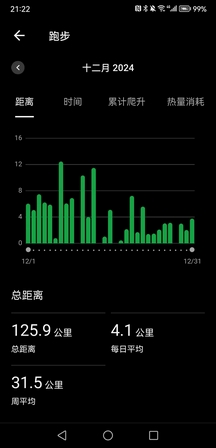

没拿到外卡,已经结束咧!貌似是个拼手速的活,xs。终于可以安心养老了。

晚上下会慢跑5K,月跑凑到200K,月均配4’26",over

西交利物浦跟宁波诺丁汉,这俩发动钞能力拿到外卡就算了,特么南通大学上海站第28名咋也能拿外卡;反观东华上海站第7差10秒没能跑进前6晋级,结果都没拿到外卡,第9华政也给拿到了,换我准得气死不成。

PS:LXY傍晚47分多跑了个10K,一上来就这么用力。

LLM面试题记录

目前主流的LLMs开源模型体系有哪些(Prefix Decoder,Causal Decoder,Encoder-Decoder的区别是什么)

- 在与训练语言模型时代,自然语言处理领域广泛采用了预训练+微调的范式,并诞生了以BERT为代表的Encoder-only架构,以GPT为代表的Decoder-only架构,以T5为代表的Encoder-Decoder架构的大规模预训练语言模型

- 随着GPT系列模型的成功发展,当前自然语言处理领域走向了生成式LLM的道路,Decoder-only架构已成主流,进一步地,Decoder-only架构可以细分为因果解码器(Causal Decoder)和前缀解码器(Prefix Decoder)。学术界提到解码器架构时,通常指因果解码器

下图对三种解码器架构进行对比:

Encoder-Decoder

- Encoder-Decoder架构即原始Transformer的架构,机器翻译

- 编码器端:双向自注意力机制对输入信息编码处理

- 解码器端:交叉注意力与掩码自注意力机制,进而通过自回归方式生成

- 目前只有FLAN-T5等少数LLM是基于Encoder-Decoder搭建

Causal-Decoder

- 主流框架(GPT系列),因果语言模型,包括LLaMa也是

- 使用单向注意力掩码,以确保每个输入token只能注意到过去的token以及本身

- 输入和输出的token通过Decoder以相同方式进行处理

- 在图中,灰色代表两个token互相之间看不到,否则就可以看到,例如Survey可以看到前面的A,但看不到后面的of,Causal Decoder的Sequence Mask矩阵是一种典型的下三角矩阵

- 代表模型:GPT系列,LLaMa(Meta)

Prefix-Decoder

- 又称为非因果解码器架构,对掩码机制修改

- 前缀解码器对于输入(前缀)部分使用双向注意力进行编码,而对于输出部分利用单向掩码注意力,即利用该token本身和前面的token进行自回归预测

- 代表模型:GLM-130B和U-PaLM(Google)

总结:三者区别在于attention mask不同

-

Encoder-Decoder(T5)

- 输入采用双向注意力,对问题编码理解更充分

- 在偏理解的NLP任务上效果好

- 长文本生成效果差,训练效率低

-

Causal Decoder(GPT)

- 自回归LM,预训练和下游应用完全一致,严格遵守只有后面的token才能看到前面token的规则

- 文本生成效果好

- 训练效率高,zero-shot能力更强,具有涌现能力

-

Prefix Decoder(GLM)

- prefix部分的token相互能看到

- 文本生成效果好

LLMs中常用的预训练任务(目标)有哪些?

主要分为三类:

- 语言建模(LM):

- 目标函数:每个token的最大似然

- 本质上,是一种多任务学习过程,因为不同token的预测对应不同的任务(数量、情感等)

- 因此可以潜在地学习到解决不同任务的知识与能力

- 训练效率:Prefix Decoder < Causal Decoder

- Causal Decoder架构会在所有token上计算损失,而Prefix Decoder只在输出上计算损失

- 去噪自编码(Denoising AutoEncoder):

- BERT,T5

- 文本经过一系列随即替换、删除操作,形成损坏的文本,模型需要恢复原文本

- 目标函数就是被损坏的token的最大似然

- 任务设定更为复杂,需要设定token替换策略,替换长度,替换比例,都影响训练效果。目前应用有限,主要是FLAN-T5(不过我记得GLM的预训练任务也是类似的一种创新的任务)

- 混合去噪器(Mixture-of-Denoisers,MoD):统一了DAE和LM

20241130

- 冬日的暖晴,极好的天气,可惜明天这种太阳其实并不太适合跑比赛。

- 又是周六回血,中午鹅汤、三文鱼,晚上骨头汤,可算是吃撑了,最近虽然在养老,其实消耗也不算太少,吃得并没有什么压力。